Tag: H100

超越NVIDIA H100 訓練快40% 推理快50%:Intel Gaudi3憑什麼

4月9日晚間,Intel在美國召開了“Intel Vision 2024”大會,介紹了Intel在AI領域取得的成功,並發布了新一代的雲端AI晶片Gaudi 3及第六代至強(Xeon)可擴展處理器,進一步拓展了Intel的AI產品路線圖。

AI晶片市場的巨大機遇

在生成式AI持續爆發背景之下,市場對於AI晶片的需求正高速增長。根據市場研究機構Gartner最新預測,到2024年AI晶片市場規模將較上一年增長 25.6%,達到671億美元,預計到2027年,AI晶片市場規模預計將是2023年規模的兩倍以上,達到1194億美元。

Intel也表示,到2030年,半導體市場規模將達1萬億美元,人工智慧是主要推動力。創新技術正在以前所未有的速度發展,每家公司都在加速成為AI公司,這一切都需要半導體技術提供支持。從PC到數據中心再到邊緣,Intel正在讓AI走進千行百業。

在邊緣AI市場,Intel已經發布了涵蓋Intel酷睿Ultra、Intel酷睿、Intel凌動處理器和Intel銳炫顯卡系列產品在內的全新邊緣晶片,主要面向零售、工業製造和醫療等關鍵領域。

Intel邊緣AI產品組合內的所有新品將於本季度上市,並將在今年年內獲得Intel剛剛發布的Intel Tiber邊緣解決方案平台的支持,以簡化企業軟體和服務的部署,包括生成式AI。

對於去年推出的面向AI PC產品的Intel酷睿Ultra處理器,憑借強大的AI內核,為生產力、安全性和內容創作提供了全新能力,並為企業煥新其PC設備提供了巨大動力。Intel預計將於2024年出貨4000萬台AI PC,以及超過230種的設計,覆蓋輕薄PC和遊戲掌機設備。

同時,Intel透露將於2024年推出的下一代Intel酷睿Ultra客戶端處理器家族(代號Lunar Lake),將具備超過100 TOPS平台算力,以及在神經網絡處理單元(NPU)上帶來超過46 TOPS的算力,從而為下一代AI PC提供強大支持。

在面向雲端的數據中心市場,Intel在2022年就推出了AI加速晶片Gaudi 2,在去年年底還推出了集成了AI內核的代號為“Emerald Rapids”的面向數據中心的第五代 Xeon處理器。

Intel公司執行長帕特·基辛格表示:“創新技術正在以前所未有的速度發展,每家公司都在加速成為AI公司,這一切都需要半導體技術提供支持。從PC到數據中心再到邊緣,Intel正在讓AI走進千行百業。Intel最新的Gaudi、至強和酷睿平台將提供靈活的、可定製化的解決方案,滿足客戶和合作夥伴不斷變化的需求,把握住未來的巨大機遇。”

Gaudi 3:BF16性能提升4倍,支持1800億參數大模型

而在雲端AI加速晶片市場,Intel早在2019年12月就斥資20億美元收購Habana Labs(其於2019 年 7 月推出了 Gaudi 1 加速器),雖然當時英偉達在AI晶片市場的體量還很小,但是在AI晶片的技術積累上,英偉達更為深厚。因此,我們可以看到,當2022年Gaudi 2...

你見過晶圓大小的晶片嘛 這家AI獨角獸推新品對標英偉達H100

財聯社3月14日訊(編輯 周子意)當晶片製造商都在試圖將晶片往小了設計時,而這家公司卻反其道而行之。

半導體初創公司Cerebras Systems公司周三(3月13日)推出了一款新的晶片WSE-3,而它的尺寸卻類似晶圓大小,或者說比一本書還要大,單體面積達到約462.25平方厘米。它是目前最大GPU面積的56倍。

據悉,該款晶片將4萬億個電晶體組織在90萬個核心中。

該晶片針對人工智慧訓練的工作負載進行了優化。Cerebras公司聲稱,配備了2048個WSE-3晶片的伺服器集群可以在一天內訓練出市場上最先進的開源語言模型之一Llama 2 70B。

替代英偉達

Cerebras是一家美國人工智慧晶片的獨角獸企業,它背後的投資團隊也都實力夠硬。最新一筆融資是在2021年由Alpha Wave Venture和阿布達比增長基金領投,融資金額2.5億美元,其他的投資人士包括:OpenAI創始人山姆·奧特曼、AMD前首席技術官Fred Weber等。

2021年,Cerebras公司首次亮相了WSE-2晶片,集成了1.2萬億個電晶體、40萬個核心。在同行都在將晶圓分割成數百顆獨立晶片之時,Cerebras公司則是選擇將整個晶圓做成一顆晶片。

而最新發布的WSE-3則是從WSE-2改進而來的。它較WES-2又增加了1.4萬億個電晶體,並擁有90萬個計算核心、44GB的板載SRAM內存。強化部分是通過從7納米製造工藝更新到5納米節點所實現的。

據該公司稱,WSE-3在人工智慧工作負載方面的性能是其前身的兩倍,它的峰值速度可以達到每秒125千萬億次計算。

Cerebras還將WSE-3定位為比英偉達顯卡更為高效的替代品。根據Cerebras官網的數據,該晶片4萬億個電晶體數完全碾壓了英偉達H100 GPU的800億個;核處理器數是單個英偉達H100 GPU的52倍;片上存儲量是H100的880倍。

WSE-3晶片為Cerebras公司的CS-3超級計算機提供動力,CS-3可用於訓練具有多達24萬億個參數的人工智慧模型,對比由WSE-2和其他常規人工智慧處理器驅動的超級計算機,這一數據是個重大飛躍。

加速數據傳輸

雖說將晶圓大小的晶片和單個英偉達H100 GPU相比較並不公平,不過若從數據傳輸速度的角度來看,不將晶圓切割成單獨的晶片確實有它的優勢。

根據Cerebras公司的說法,使用單一的大型處理器可以提高人工智慧訓練工作流程的效率。當WSE-3上的4萬億個電晶體在晶圓上互連時,將會大大加快生成式人工智慧的處理時間。

人工智慧模型就是相對簡單的代碼片段的集合,這些代碼片段被稱為人工神經元。這些神經元被重新組織成集合(稱為層)。

當人工智慧模型接收到一個新任務時,它的每一層都會執行任務的一部分,然後將其結果與其他層生成的數據結合起來。

由於神經網絡太大,無法在單個GPU上運行,因此,這些層需要分布在數百個以上的GPU上,通過頻繁地交換數據來協調它們的工作。

基於神經網絡架構的具體特性,只有獲得前一層的全部或部分激活數據,才能在開始分析數據,並提供給下一層。也就意味著,如果這兩層的數據運行在不同的GPU上,信息在它們之間傳輸可能需要很長時間。晶片之間的物理距離越大,數據從一個GPU轉移到另一個GPU所需的時間就越長,這會減慢處理速度。

而Cerebras的WSE-3有望縮短這一處理時間。如果一個人工智慧模型的所有層都在一個處理器上運行,那麼數據只需要從晶片的一個角落傳輸到另一個角落,而不是在兩個顯卡之間傳輸。減少數據必須覆蓋的距離可以減少傳輸時間,從而加快處理速度。

該公司指出,在如今的伺服器集群中,數以萬計的GPU被用來處理一個問題,而若是將晶片數量減少50倍以上,就可以降低互連成本以及功效,同時或許也可以解決消耗大量電力的問題。

Cerebras聯合創始人兼CEO Andrew Feldman稱,“當我們八年前開始這一旅程時,每個人都說晶圓級處理器是白日夢…WSE-3是世界上最快的人工智慧晶片,專為最新的尖端人工智慧工作而打造。”

對於新推出地WSE-3晶片,分析公司Intersect360 Research執行長Addison Snell認為,Cerebras的WSE-3人工智慧晶片和CS-3系統可以使部分高性能計算用戶受益。

他指出,“該晶片在相同的成本和功率下將性能提高了一倍。”

不過,Tirias Research創始人Jim McGregor則較為現實地指出,盡管這家初創公司增長迅速,並且有能力提高其平台的可擴展性,但與占主導地位的人工智慧供應商英偉達相比,它仍然是一家規模較小的公司。

他還指出,Cerebras專注於人工智慧的一個方面,那就是訓練,不過訓練只是大型語言模型市場的一個利基市場。而英偉達提供了許多其他方面產品。

來源:快科技

AI晶片供應似有緩和跡象:英偉達H100正被拋出 租用更容易

財聯社2月27日訊(編輯 周子意)越來越多的證據表明,人工智慧晶片的供應緊張問題正有所緩和,一些購買了大量英偉達H100 80GB處理器的公司現在正試圖轉售這些處理器。

目前,據悉用於人工智慧(AI)和高性能計算(HPC)應用的英偉達H100 GPU的交付周期已從8-11個月大幅縮短至3-4個月。

據報導,一些公司正在轉售他們的H100 GPU或減少訂單,因為這些晶片的稀缺性開始下降,並且維護這些尚未使用庫存的成本也很高。

此類情形與一年前相比出現重大轉變,當時獲得英偉達的Hopper GPU是一個重大挑戰。

目前人工智慧處理器供應短缺的緩解還表現在,從AWS、谷歌雲和微軟Azure等雲服務提供商租用英偉達的H100 GPU變得更加容易了。

例如,AWS推出了一項新服務,允許客戶安排更短時間的GPU租賃,解決了之前晶片可用性的問題,這導致獲得人工智慧晶片的等待時間在減少。

盡管晶片可得性有所提高,交貨時間也大大縮短,人工智慧晶片的需求仍然遠遠超過供應。

特別是那些自己開發並培訓大型語言模型的公司仍然面臨供應問題,很大程度上是因為他們需要的GPU數量過於龐大。這些公司在獲得所需處理器或容量方面仍面臨著幾個月的延遲。

也正因如此,英偉達H100和其他處理器的價格並沒有下降,該公司也繼續享有高利潤率。

不過,隨著諸多英偉達處理器的替代品接連問世,例如AMD和AWS的處理器,該市場可能會迎來更加平衡的局面。

還有一點原因是,各公司對人工智慧處理器的支出也變得更加謹慎了。

無論如何,就目前而言,市場對人工智慧晶片的需求依然強勁,並且隨著大型語言模型越來越大,對計算性能的需求也越來越高。

來源:快科技

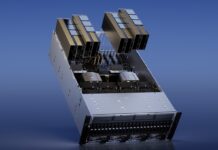

英偉達首次公開目前最快AI超算:搭載4608個H100 GPU

快科技2月18日消息,近日,英偉達首次向外界公布了其最新的面向企業的AI超級計算機Eos,同時也是英偉達目前速度最快的AI超級計算機。

據介紹,Eos共配備了4608個英偉達H100 GPU,同時還配備了1152個英特爾Xeon Platinum 8480C處理器(每個CPU有56個內核)。

Eos還採用了英偉達Mellanox Quantum-2 InfiniBand技術,數據傳輸速度高達400 Gb/,對訓練大型AI模型和系統擴展至關重要。

英偉達公布數據顯示,在最新的全球Top500超級計算機當中,Eos位居全球第九,其峰值性能更是達到了188.65 Peta FLOPS。

而且Eos不僅供英偉達自身使用,其構架也為其他想打造面向企業的超級計算機的公司提供樣本。

英偉達表示,Eos整合了其在AI領域的專業技術和經驗,是先前DGX超級計算機知識的結晶,可以幫助企業處理最具挑戰性的項目,並實現AI目標。

來源:快科技

AMD MI300X AI加速卡價格超10萬元 NVIDIA至少四倍之

快科技2月4日消息,AI/HPC應用對於加速卡的需求空前高漲,不但NVIDIA A/H系列賣到天價和脫銷,AMD Instinct系列也搶到了不少甜頭。

雖然他們從來不公布產品價格,部分是因為根據行情、客戶、規模等因素差異極大,但仍然可以發現蛛絲馬跡。

微軟是AMD MI300X加速卡的頭號客戶,有估計認為微軟購買的單價是1萬美元左右(約合人民幣7.2萬元),而其他客戶可能要1.5萬美元左右(約合人民幣10.8萬元)。

NVIDIA H100 80GB PCIe經常會賣到3-4萬美元乃至更貴,H100 80GB SXM樣式的必然更貴。

NVIDIA還有更高級、更先進的H200 141GB、H100NVL 188GB,但從內存容量上看它們更應該是AMD MI300X 192GB的競爭對手,價格更要上天了。

NVIDIA已經壟斷了AI加速卡超過80%的市場,AMD雖然無力追趕之,但依然能賺得盆滿缽滿。

AMD自己估計旗下數據中心GPU業務的年收入可超過35億美元,而第三方機構認為AMD太保守了,今年至少能入帳50億美元以上,明年更有望達到80億美元左右。

來源:快科技

Meta豪購35萬塊NVIDIA最強GPU H100:還在買AMD

快科技1月20日消息,NVIDIA AI GPU無疑是當下的硬通貨,從科技巨頭到小型企業都在搶。

Meta(Facebook) CEO扎克伯格近日就透露,為了訓練下一代大語言模型Llama 3,Meta正在建造龐大的計算平台,包括將在今年底前購買多達35萬塊NVIDIA H100 GPU。

屆時,再加上其他GPU,Meta擁有的總算力將相當於幾乎60萬塊H100!

根據市調機構Omdia的數據,Meta 2023年買了多達15萬塊NVIDIA GPU,能與之媲美的只有微軟,而亞馬遜、甲骨文、谷歌、騰訊等都只拿到了5萬塊左右。

SemiAccurate的首席分析師Dylan Patel指出,2024年第一季度,H100、H200、GH100、GH200、H20等基於最新Hopper架構的GPU出貨量有望達到77.3萬塊,第二季度增至81.1萬塊。

而在2023年第二季度,Hopper家族GPU只出貨了大約30萬塊。

另外值得一提的是,Meta也在購買AMD最新的Instinct MI300系列GPU,但具體數量不詳。

微軟也是AMD Instinct的大客戶。

來源:快科技

今年英偉達H100 GPU都流向了哪:微軟和Meta是最大兩個買家

財聯社12月6日訊(編輯 周子意)H100 GPU被認為是科技行業的“新黃金”,因為它是為生成式人工智慧提供算力的首選。

今年英偉達大賣的H100 GPU都流向了哪些公司?下面這張圖清晰羅列了英偉達今年最大的客戶。

根據市場研究公司Omdia Research的最新報告,Meta和微軟兩家公司以15萬塊H100 GPU的購買量並列位居第一。

微軟如此大的訂購量並不意外,因為該公司需要為其不斷增長的人工智慧產品、以及現有的人工智慧助手Copilot(原來的Bing Chat)提供算力。

而Meta公司在人工智慧領域也有著野心。前幾個月曾有報導稱,Meta公司正在持續采購AI晶片並創建數據中心,旨在開發一個能與ChatGPT一樣強大的聊天機器人。

據悉,Meta正在開發新的大型語言模型,其功能有望比今年7月份推出的Llama 2模型強大數倍,並且目標要在明年開始訓練新模型。

不過,其他公司與Meta、微軟之間的購買量差距略顯懸殊。

谷歌、亞馬遜、甲骨文以及騰訊以5萬塊H100 GPU的購買量共同位居第三;雲服務提供商CoreWeave公司的預估購買量為4萬塊H100;百度和阿里巴巴分別購買了3萬和2.5萬塊H100;字節跳動和雲服務供應商Lambda Labs以2萬塊H100的購買量緊隨其後;特斯拉則購買了1.5萬塊H100。

大多流向了雲供應商

Omdia Research的報告還顯示,英偉達將大多數的GPU伺服器都供應給了大型雲服務提供商。這或許也意味著英偉達正在向雲服務靠攏。

值得一提的是,在英偉達H100前十二大客戶中,只有CoreWeave和Lambda Labs兩家是初創公司,但他們與英偉達頗有淵源。

早在今年H100晶片首推之際,英偉達就選擇了CoreWeave和Lambda作為首批使用該晶片的公司。而且它們的融資過程中都可以發現英偉達的投資身影:今年4月英偉達參與了CoreWeave 2.21億美元B輪融資;今年7月英偉達向Lambda Labs投資3億美元。

目前,CoreWeave估值約為20億美元,而Lambda的估值也將超過10億美元。

此前有分析師指出,英偉達將其GPU出售給這些雲初創公司,是為了將GPU的目標客戶群擴大,而不再僅限於亞馬遜、微軟、谷歌等雲巨頭。

未來展望

此外,Omdia近期公布的新數據顯示,晶片製造巨頭英偉達在第三季度出貨了近50萬塊H100和A100 GPU。此前的財報顯示,該季度英偉達數據中心的收入為145億美元,幾乎是去年同期的四倍。

該分析公司還預計,到2023年第四季度,英偉H100和A100 GPU的銷量將超過50萬塊。

不過,幾乎所有大量購買英偉達H100 GPU的公司自身也在開發用於AI、HPC和視頻工作負載的定製晶片。因此,隨著時間的推移,隨著英偉達的客戶轉向自己的晶片,他們對英偉達硬體的購買量可能會下降。

來源:快科技

英偉達:正為中國等出口受限地區研究解決方案

快科技11月22日消息,在英偉達第三季度業績會上,英偉達財務長表示,目前正在為出口受限地區研究解決方案,現在說美國政府是否會發放許可證還為時過早。

其還表示:“出口管制將對我們的中國業務產生負面影響,從長遠來看,我們也無法清楚地了解這種影響的嚴重程度。”

中國市場對於AI晶片的強勁需求,英偉達自然不想放棄,因此才會開發出針對中國等受限地區市場的H100改款晶片,使其能夠符合美國的相關規定。

據英偉達發布的最新財報數據顯示,其三季度共營收181.2億美元(約合1294億元人民幣),同比增長了206%。

數據中心營收145.14億美元(約合1036億元人民幣),同比增長了279%,其中大約20%的收入來自中國市場。

雖然這一收入和增速都遠超出外界預期,但英偉達已經開始擔心並給出警告了,其表示四季度在中國和其他受美國政府10月新出口限制影響的地區,英偉達的銷售料將大幅下滑。

來源:快科技

美國對中東禁售NVIDIA H100/A100加速卡:怕轉賣給中國

美國已經針對中國全面禁止銷售NVIDIA A100、H100等加速計算卡,但這還沒完,中東地區也給禁售了。

NVIDIA在一份聲明中披露,上個季度,美國政府發出通知,部分客戶和地區購買A100、H100等產品需要額外的許可協議,包括中東地區的一些國家。

不過,NVIDIA並未透露具體涉及哪些國家。

近些年,沙烏地阿拉伯、阿聯都在大力強化AI,並且購買了大量的NVIDIA產品,同時兩個國家與中國關系越來越密切。

美國政府的擔心有兩點,一是這些國家購買NVIDIA H100、A100產品後,可能會轉賣給中國,二是中國企業會在海外訓練自己的AI模型。

NVIDIA強調,雖然有新的禁令,但不會對其收入產生明顯影響,同時也在積極與美國政府溝通,希望解決此問題。

此前,NVIDIA曾公開表示,美國將升級對中國AI的監管措施,而新的禁令限制一旦實施,將導致NVIDIA失去在全球最大市場之一競爭和領先的機會。

來源:快科技

美國進一步限制高性能計算GPU出口:英偉達向中東出售A100/H100需額外許可

去年英偉達為了繞開相關的出口限制,推出了A800系列計算卡,專供中國市場使用。與原有的A100系列計算卡相比,A800系列的規格基本相同,比較大的區別在於NVLink互連總線的連接速率,前者為600 GB/s,後者限制在了400 GB/s。隨後在今年又推出了H800系列計算卡,以滿足出口管制的要求。

據相關媒體報導,英偉達在本周公開的一份監管文件里表示,在2024財年第二季度里收到了官方發出的通知,針對某些地區的客戶(包括中東在內)出售A100和H100計算卡,需要額外的許可要求。英偉達重申了目前已在中國銷售不受約束的替代產品,包括A800和H800計算卡。

雖然英偉達已在監管文件里披露了新的限制,不過並沒有說明具體哪些國家和地區會受到影響。近年來,沙烏地阿拉伯和阿聯一直在加強其人工智慧方面的實力,大量購入英偉達的計算卡,成為了重要的買家,新的措施多少對其都會有所影響。更為重要的是,這種做法是為了避免出售中東地區的A100和H100計算卡最後流入到中國市場。

英偉達表示,新的限制措施不會對其收入產生重大影響,目前正在嘗試通過合作的方式解決相關的問題。 ...

毛利率超90% NVIDIA H100 AI加速卡成本3千美元 賣3.5萬美元

NVIDIA AI加速卡無疑是當下最為火爆的產品,妥妥的一卡難求。有分析認為,H100的全球需求量多達43.2萬塊,但交付周期長達3-6個月。

價格更是一路走高,H100目前已經賣到3.5萬美元左右,而且很多時候是有錢也買不到。

微博網友“飯統戴老闆”分析了一下H100的物料硬體成本,並結合相關數據資料,提出了一些有趣的觀點。

H100的物料成本(BOM)包括核心邏輯晶片、HBM內存晶片、CoWoS封裝三大部分,還有PCB電路板、其他元器件等。

H100核心邏輯晶片的面積為814平方毫米,採用台積電4N工藝製造(5nm+),該節點下一塊300mm晶圓的報價為1.34萬美元,面積大約70695平方毫米,理論上能切割80多顆H100,再結合良率、損耗,就算65顆好了,單顆價格200美元左右。

HBM3內存晶片來自韓國SK海力士,一共六顆,單顆容量16GB,而每GB價格大約15美元,合計1500美元左右——是的,比核心晶片貴多了。

CoWoS封裝來自台積電技術,成本不詳,但台積電財報稱CoWoS工藝的營收占比為7%,客戶只有NVIDIA、AMD,分析師Robert Castellano據此推算製造一顆H100需要723美元左右。

三者合計約2500美元(台積電拿走約1000美元),再加上其他物料合計在3000美元左右。

也就是說,H100的毛利率超過了90%!

正是在H100、A100、A800等加速卡產品的帶動下,NVIDIA今年二季度的毛利率已經達到了恐怖的70%。

當然,這只是純硬體成本,而比硬體更珍貴的是軟體,是生態,這才是NVIDIA真正無敵的地方,這才是無論Intel還是AMD都難以企及的地方。

人人都知道CUDA的強大與好用,而這正是NVIDIA幾十年如一日砸下數百億研發資金的成果。目前,NVIDIA在全球有超過2萬名軟硬體工程師。

刨除各種成本,NVIDIA的淨利率依然有30-40%左右,這就是本事!

來源:快科技

英偉達顯卡利潤夸張:H100能狂賺1000% 消息稱明年出貨至少增加2倍

快科技8月26日消息,據三名接近英偉達的人士透露,英偉達計劃將其頂級H100人工智慧處理器的產量至少提高兩倍。

按照英偉達人士的說法,H100的2024年預計出貨量在150萬至200萬顆之間,相較於今年預計的50萬出貨量,這是一個巨大的增幅。

如此熱銷的場面,其背後的利潤也是非常壯觀。

據投行瑞傑金融(Raymond James)估計,每枚英偉達H100晶片的製造成本為3,320美元,而給客戶的售價卻高達25000至30000美元。

知名科技媒體Tom‘s Hardware稱,這份報告意味著對英偉達公司來說,H100晶片的成本利潤率高達1000%,即十倍。

此外,據匿名評論平台Glassdoor的數據,英偉達電子硬體工程師的平均年薪約為20.2萬美元,而開發H100等晶片很可能需要數千位這樣薪資水平的專業人員。

據悉,百度、字節跳動、騰訊和阿里巴巴等網際網路巨頭在爭相購買英偉達的高性能晶片,訂單總和價值高達50億美元,而沙特和阿聯被曝正在“瘋狂下單”英偉達的AI晶片。

來源:快科技

英偉達計劃提高2024年數據中心GPU產量:GH100將是今年的3到4倍,可達200萬顆

近日,英偉達公布了2024財年第二財季的財報,得益於過去幾個月的高性能計算(HPC)和人工智慧(AI)的高需求,季度營收首次超過100億美元,達到了135.07億美元。其中數據中心業務營收達到了103.2億美元,遠遠超過了遊戲業務的24.9億美元,以往齊頭並進的兩大支柱業務,現在兩者之間的營收差距已拉開了數倍。

據相關媒體報導,英偉達計劃提高2024年數據中心GPU的產量,以滿足市場對A100、H100和其他計算CPU/GPU的強勁需求,這意味著可能會有難以置信的高收入。有知情人士透露,英偉達打算將GH100的產量從今年的50萬顆提高到150萬至200萬顆。

需要用到GH100晶片的產品包括H100計算卡和GH200 Grace Hopper等,這些高端產品想提高供應量並不是一件容易的事,涉及到供應鏈的每一個環節,比如英偉達和台積電最近一段時間就為CoWoS封裝產能而煩惱。何況GH100本來就是設計非常復雜的晶片,想大規模製造相當困難。如果想大幅度提升產量,需要突破幾個瓶頸。

首先,要保證GH100的產量,英偉達需要台積電增加定製4N工藝的產能。據粗略統計,目前每塊300mm晶圓最多可以生產65顆GH100晶片。如果英偉達想將產量提高到200萬顆,那麼需要約3.1萬塊晶圓,對於台積電每月15萬塊5nm製程節點的產能來說是可行的。

其次,英偉達依賴於台積電的CoWoS封裝,目前的產能是遠遠不夠的,這也是為什麼英偉達考慮讓三星分擔部分封裝訂單的原因之一。

再次,GH100需要HBM2E、HBM3和HBM3E,英偉達需要獲得足夠數量的HBM,可能需要從三星、SK海力士和美光同時采購。

最後,英偉達的合作夥伴能夠將基於GH100晶片打造產品裝入到伺服器,不但考驗合作夥伴的輸出,而且市場要一直保證足夠的需求量。

如果所有條件都成立,那麼明年英偉達將獲得更加巨額的利潤 ...

H100顯卡被指賺了10倍利潤 NV工程師年薪147萬也是成本

快科技8月21日消息,作為目前最受歡迎的AI顯卡供應商,NVIDIA今年贏麻了,旗下的AI顯卡供不應求,其中H100售價25萬元以上,利潤極為豐厚。

此前有人算了H100的賺錢能力,生產製造成本只有3320美元,實際的售價在2.5萬到3萬美元之間,賺的利潤最高接近10倍。

這個說法公開之後,不少人難免覺得NVIDIA太能賺錢了,甚至覺得太黑了,利潤率這麼高還讓供應跟不上,但是這樣的計算成本並不准,甚至誤導性很大。

這就跟每年都有人計算蘋果的iPhone新機物料成本一樣,當然蘋果一般也就是100%的利潤率而已,比不上NVIDIA顯卡8倍、10倍的利潤率。

對H100這樣的晶片來說,更大的成本還是多年的研發投入,這要比物料成本高得多,NVIDIA的硬體工程師年薪平均20.2萬美元,折合人民幣超過147萬元,這也是成本之一。

H100這樣的大型晶片,具體需要多少工程師不確定,但數千工程師三五年時間還是需要的,當代高性能晶片,包括CPU及GPU,研發投入都是10億美元起步的,光是先進工藝設計到流片的費用就價值不菲。

來源:快科技

英偉達預計2023年H100 GPU出貨量將達55萬顆,或帶來超過250億美元的收入

英偉達在去年的GTC 2022上發布了新一代基於Hopper架構的H100,擁有800億個電晶體,為CoWoS 2.5D晶圓級封裝,單晶片設計,採用了台積電(TSMC)為英偉達量身定製的4N工藝製造,用於新一代加速計算平台。過去幾個月里,以ChatGPT為首的人工智慧(AI)工具在全球范圍內掀起了一股熱潮,對英偉達H100這樣的數據中心GPU的需求大幅度提高。

英偉達可以說是最近人工智慧浪潮里的大贏家,H100已成為了「金礦」,在2023年出貨量實現了爆炸性的增長。據相關媒體報導,市場對H100的需求已延伸到全球更多地方,中東的土豪們也加入到遊戲中,比如沙烏地阿拉伯政府計劃將未來收入的來源從傳統的石油資源更多地轉向蓬勃發展的新興技術,為此加大了對人工智慧技術的投資,開始大手筆購入H100,以趕上人工智慧領域的發展。

根據統計,2023年H100 GPU的出貨量將達到55萬顆,不包括不同地區的報價差異,將會帶來220億美元的收入。如果考慮定價的波動,以及不同地區和不同版本之間的價格差值,比如專供中國市場的H800,那麼實際收入可能會超過250億美元。當然,還要考慮到台積電的產能是否足夠應對需求。

英偉達正在與台積電一起推進H100的生產,考慮到2019年至2022年之間英偉達利用加密貨幣熱潮時的舉動,相信在巨大的利益面前,英偉達會集中資源投入到AI GPU的生產上,解決供應鏈上遇到的各種瓶頸,以求獲得最大的收益。 ...

AI熱潮立大功:NVIDIA H100計算卡將出貨超55萬塊

快科技8月16日消息,近日,根據Tomshardware報導消息,NVIDIA今年年內計劃售出超過55萬塊H100計算卡。

這無疑與當下的AI大模型訓練熱潮,以及隨之而來的,對算力的龐大要求有關。

而NVIDIA CEO黃仁勛在本月初SIGGRAPH大會上的演講,也證明了這一點。

在會上,黃仁勛表示,“未來 LLM(大型語言模型)將處於幾乎所有事物的前沿,‘人類’是新的程式語言。”

因此,他在2018年就決定,將公司的一切押到AI之上。

現如今,黃仁勛的這一決定無疑在商業層面獲得了巨大成功,NVIDIA已經幾乎成為了AI大模型訓練中無法繞過的一環。

不過,NVIDIA的一家獨大,對於整個行業,以及其他廠商來說,或許並非一件好事。

來源:快科技

售價25萬起步 NVIDIA AI顯卡H100賣瘋了:今年將出貨55萬塊

快科技8月16日消息,今年AI火爆最大贏家就是NVIDIA了,他們的AI顯卡供不應求,除了中國、美國兩大市場搶購之外,沙特、阿聯等海灣國家也要下單搶購了,訂單都已經排到2024年。

NVIDIA目前在售的AI加速卡有多款,性能最強的自然是去年推出的H100,售價25萬元起步,也是目前搶購的重點。

據Tomshardware網站報導,NVIDIA今年內計劃出售超過55萬塊H100加速卡,其中大部分是出貨給美國公司,不過這場說法還沒有被得到NVIDIA證實。

實際上H100系列有至少3個型號——H100 SXM、H100 PCIe及H100 NVL,25萬元的價格其實最基礎版本的售價,現在由於缺貨等原因,真實售價可能更夸張,翻倍到50萬元的說法都有。

即便是以最基礎的價格來算,NVIDIA的H100訂單也價值價值1375億元以上,足夠NVIDIA業績漲上天。

來源:快科技

企業抵押大量NVIDIA H100 AI加速卡:貸款165億元

在這個AI爆火的時代,NVIDIA A100/H100系列加速卡成了香餑餑,價格也被炒得一高再高,有時候十幾萬才能買一塊。

GPU加速雲服務商CoreWeave近日做出驚人之舉,利用手中的NVIDIA H100加速卡作為抵押,拿到了23億美元的債務融資,約合人民幣165億元。

CoreWeave已經采購了大量的NVIDIA H100加速卡和HGX H100超級計算機平台,具體多少不得而知,但他們依然覺得不夠用,還需要更多來建設新的數據中心,又缺錢買不起了,就想到了拿這個“硬通貨”去做抵押。

投資機構對於NVIDIA H100的價值也相當信賴,磁星資本、黑石集團領銜了這一輪投資,貝萊德集團(BlackRock)、太平洋投資管理(PIMCO)、凱雷集團(Carlyle)、Coatue、DigitalBridge等也都參與其中。

在此之前,CoreWeave曾融資4.21億美元,估值超過20億美元。

來源:快科技

英偉達正在准備更大容量的H100計算卡:配備94GB和64GB顯存

英偉達在去年的GTC 2022上發布了新一代基於Hopper架構的H100,用於下一代加速計算平台。其擁有800億個電晶體,為CoWoS 2.5D晶圓級封裝,單晶片設計,採用了台積電(TSMC)為英偉達量身定製的4N工藝製造。

目前英偉達提供了數種不同的H100計算卡,分別為H100 PCIe、H100 SXM和H100 NVL(雙GPU版本)。其中普通的H100配備了80GB的HBM2E,PCIe和SXM5版本都有,H100 NVL則有著188GB的HBM3,對應每個GPU為94GB。近日更新的PCI ID列表顯示,英偉達很快會為H100帶來94GB和64GB的SXM版本,其中前者還會有針對中國市場的版本,型號為H800L 94GB。

64GB很好理解,但是94GB並不是尋常的數字,與H100 NVL的情況類似,英偉達並沒有解釋這種容量具體如何配置的。去年還有報導稱,英偉達還准備了一款120GB的PCIe版本,不過至今還沒有得到官方的確認,有可能只是在實驗室測試的工程樣品,最終不會出現在任何市場。

完整的GH100晶片配置了8組GPC、72組TPC、144組SM、共18432個FP32CUDA核心,採用了第四代Tensor Core,共576個,並配有60MB的L2緩存。不過實際產品中沒有全部打開,其中SXM5版本中啟用了132組SM,共16896個FP32 CUDA核心,528個Tensor Core以及50MB的L2緩存,而PCIe 5.0版本則啟用了114組SM,FP32 CUDA核心數量只有14592個。暫時不清楚擁有更大顯存的H100的核心規格,估計會延續現有的配置。 ...

英偉達AI GPU需求激增:價格上漲40%,供應短缺延續至今年12月

過去幾個月來,隨著ChatGPT這樣的人工智慧工具在全球范圍內掀起了一股熱潮,越來越多的科技公司投身到相關的研發中,多模態大規模語言模型需要大量的計算來支撐,而英偉達的GPU成為了搶購的對象,包括A100和H100計算卡都是熱門的選擇,以至於供應可能無法及時跟上。

十多年前,英偉達就開始押注人工智慧是下一個風口,看起來多年的大量投資終於迎來了高額回報。據Digitimes報導,近期英偉達AI GPU的訂單增加,這也提升了台積電的晶圓開工率。

A100和H100的晶片都是由台積電負責代工,前者為7nm工藝,後者使用了名為4N的定製5nm工藝,盡管英偉達一直在盡力滿足需求,但人工智慧的浪潮對需求造成的影響是巨大的。為了繞過管制,英偉達還專門針對中國市場提供了A800和H800兩款產品,定價高出原建議零售價40%。即便如此,在大量的訂單面前,交貨周期也開始受到了影響,而英偉達希望先滿足非中國地區的需求。

目前交貨周期已從過往的3個月延長到了6個月,某些情況下可能要等待更長的時間,部分新的訂單估計要到今年12月才能完成,這意味著等待時間將超過6個月。市場對高性能計算的需求,一定程度上也擾亂了遊戲晶片的供應,因為英偉達打算將更多資源分配到人工智慧的需求上。 ...

NVIDIA特供中國顯卡 騰訊確認用上H800 售價或超20萬元一塊

快科技4月14消息,騰訊雲發布面向大模型訓練的新一代HCC高性能計算集群,採用最新一代騰訊雲星星海自研伺服器,搭載了NVIDIA H800 Tensor Core GPU,並提供業界目前最高的3.2T超高互聯帶寬。

這也意味著騰訊已經用上了NVIDIA為中國市場特供的H800加速卡。

NVIDIA當前最強的加速卡是A100及H100,但去年受到了限制,為此NVIDIA推出了替代型號專供中國市場,A100的替代型號是A800,在已有A100的基礎上將NVLink高速互連總線的帶寬從600GB/降低到400GB/,其他完全不變。

H100的替代型號是H800,具體的規格不確定,應該是跟A800一樣閹割帶寬,不過H100 SXM版的帶寬也就是3.35T,騰訊H800提到是3.2T,下降的並不明顯,除非是H100 NVLink版,後者的帶寬高達7.8T。

至於價格,騰訊沒有提及H800的采購價,不過H100的價格大約是25萬元,此前A800特供版價格是標準版A100的8成價格,因此H800實際價格也不會便宜,20萬元或者更高水平。

來源:快科技

性能暴漲4.5倍 NVIDIA H100計算卡強勢壟斷AI:對手?不存在

AI世界如今最大的贏家是誰?

毫無疑問是黃仁勛的NVIDIA,布局早,技術強,根本找不到對手,“躺著”就可以掙大錢了。

現在,NVIDIA又公布了最新一代Hopper H100計算卡在MLPerf AI測試中創造的新紀錄。

Hopper H100早在2022年3月就發布了,GH100 GPU核心,台積電4nm工藝,800億電晶體,814平方毫米麵積。

它集成18432個CUDA核心、576個Tensor核心、60MB二級緩存,搭配6144-bit位寬的六顆HBM3/HBM2e高帶寬記憶體,支持第四代NVLink、PCIe 5.0總線。

相比於ChatGPT等目前普遍使用的A100,H100的理論性能提升了足足6倍。

不過直到最近,H100才開始大規模量產,微軟、Google、甲骨文等雲計算服務已開始批量部署。

MLPerf Inference是測試AI推理性能的行業通行標準,最新版本v3.0,也是這個工具誕生以來的第七個大版本更新。

對比半年前的2.1版本,NVIDIA H100的性能在不同測試項目中提升了7-54%不等,其中進步最大的是RetinaNet全卷積神經網絡測試,3D U-Net醫療成像網絡測試也能提升31%。

對比A100,跨代提升更是驚人,無延遲離線測試的變化幅度少則1.8倍,多則可達4.5倍,延遲伺服器測試少則超過1.7倍,多則也能接近4倍。

其中,DLRM、BERT訓練模型的提升最為顯著。

NVIDIA還頗為羞辱性地列上了Intel最新數據中心處理器旗艦至強鉑金8480+的成績,雖然有56個核心,但畢竟術業有專攻,讓通用處理器跑AI訓練實在有點為難,可憐的分數不值一提,BERT 99.9%甚至都無法運行,而這正是NVIDIA H100的最強項。

此外,NVIDIA還第一次公布了L4 GPU的性能。

它基於最新的Ada架構,只有Tensor張量核心,支持FP8浮點計算,主要用於AI推理,也支持AI視頻編碼加速。

對比上代T4,L4的性能可加速2.2-3.1倍之多,最關鍵的是它功耗只有72W,再加上單槽半高造型設計,可謂小巧彪悍。

幾乎所有的大型雲服務供應商都部署了T4,升級到L4隻是時間問題,Google就已經開始內測。

來源:快科技

英偉達將推出H800系列計算卡:限制互連速率,新款中國市場特供產品

基於Ampere架構的A100系列計算卡在過去近三年里,被眾多高性能計算集群(HPC)所採用,英偉達在去年推出了新一代基於Hopper架構的H100系列計算卡,進一步提高了算力,這些GPU大量用於人工智慧和深度學習任務。

由於眾所周知的原因,英偉達為了繞開去年施加的相關出口限制,推出了A800系列計算卡,專供中國市場使用。與原有的A100系列計算卡相比,A800系列的規格基本相同,比較大的區別在於NVLink互連總線的連接速率,前者為600 GB/s,後者限制在了400 GB/s。

據相關媒體報導,英偉達今年採用了相同的方法,將普通H100 PCIe型號的互連速率減掉大概一半左右,推出了H800系列計算卡,以供中國市場。相比於正常的H100產品,由於被限制導致輸出減慢,在某些大型模型訓練里的延遲會增加,降低了工作負荷。

有媒體聯系英偉達了解情況,詢問H100和H800之間的區別,不過英偉達沒有給出正面回應,解釋其中的差別,僅表示H800系列計算卡完全符合出口管製法規。

完整的GH100晶片配置了8組GPC、72組TPC、144組SM、共18432個FP32 CUDA核心。其採用了第四代Tensor Core,共576個,並配有60MB的L2緩存。有不過實際產品中沒有全部打開,其中SXM5版本中啟用了132組SM,共16896個FP32 CUDA核心,528個Tensor Core以及50MB的L2緩存,而PCIe 5.0版本則啟用了114組SM,FP32 CUDA核心數量只有14592個。此外,前者的TDP達到了700W,後者則為350W。

此外,H100支持英偉達第四代NVLink接口,可提供高達900 GB/s的帶寬。同時H100是第一款支持PCIe 5.0標準的GPU,也是第一款採用HBM3的GPU,最多支持六顆HBM3,帶寬為3TB/s,是A100採用HBM2E的1.5倍,默認顯存容量為80GB。 ...

NVIDIA突然復活SLI 但不是你想的那樣

RTX 40系列發布之後,黃仁勛曾經親口確認,

不過現在,NVIDIA又以另一種方式復活了它,這就是最新發布的

NVIDIA一年前就發布了Hopper架構的新一代計算卡H100,具備三個NVLink總線,可以組建多卡互連。

H100 NVL則不太一樣,單卡集成兩顆H100 GPU,彼此通過NVLink互連,一致對外。

這顯然是給那些不支持SXM的伺服器准備的,適合大規模AI推理訓練。

它的規格基本就是H100 SXM版本翻一番甚至還多:33792個CUDA核心、1056個Tensor核心、188GB HBM3高帶寬記憶體、7.8TB/帶寬、700-800W功耗。

性能也是直接翻倍,Tensor加持之下FP64 134萬億次、TF32 1979萬億次、BF16/FP16 3958萬億次、FP8/INT8 7916萬億次。

H100 NVL一塊卡需要占用兩個插槽,每個伺服器節點可以配備2塊或者4塊,也就是最多八顆GPU。

那規格,那性能,還有那價格,多美麗。

單系統四卡八GPU

來源:快科技

英偉達推出H100 NVL:雙GPU的AI加速器,針對大語言模型訓練設計

英偉達宣布,針對大型語言模型訓練(LLM)設計,推出全新的H100 NVL計算加速卡。其搭載了兩個基於Hopper架構的H100晶片,頂部配備了三個NVLink連接器,在伺服器里使用了兩個相鄰的PCIe全長插槽。

英偉達去年就推出了H100,擁有800億個電晶體,相比上一代的A100,有著六倍的性能提升以及兩倍的MMA改進。其採用了CoWoS 2.5D晶圓級封裝,單晶片設計,以台積電(TSMC)為英偉達量身定製的4N工藝製造。這次雙GPU版本除了更高的計算性能,更大的顯存容量也是其優勢之一,提供了188GB的HBM3顯存。

H100 NVL計算加速卡的FP64計算性能為134 teraFLOPS,TF32計算性能為1979 teraFLOPS,FP8計算性能為7916 teraFLOPS,INT8計算性能為7916 teraFLOPS,是H100 SXM的兩倍。其具有完整的6144位顯存接口(每個HBM3堆棧為1024位),顯存速率可達5.1Gbps,意味著最大吞吐量為7.8GB/s,是H100 SM3的兩倍多。由於大型語言模型訓練需要更大的緩沖區和更高的帶寬,所以更大的顯存肯定會對運算有所影響。

據了解,H100 NVL計算加速卡的功耗略高於H100 PCIe(350W)的兩倍或以上,在700W至800W之間。英偉達計劃在今年下半年推出H100 NVL計算加速卡,不過暫時沒有進一步提供任何的細節。 ...

188GB顯存 800W功耗 NVIDIA發布H100 NVL加速卡:ChatGPT提速2倍

ChatGPT作為當下最火爆的AI應用,之所以能達到如此“聰明”的程度,背後離不開海量的訓練,離不開強大的算力,使用的是NVIDIA A100加速計算卡。

GTC 2023春季技術大會上,NVIDIA又發布了頂級的H100 NVL,它是已有H100系列的特殊加強版,專為大型語言模型(LLM)進行優化,是部署ChatGPT等應用的理想平台。

H100 NVL單卡具備多達94GB HBM3高帶寬顯存(記憶體),照此容量看顯然是開啟了完整的6144-bit位寬,並啟用了全部六顆,等效頻率按照5.1GHz計算的話,帶寬就是恐怖的3.9GB/。

但也有個問題,六顆HBM3顯存總容量應該是96GB,但是這里少了2GB,官方沒有解釋,猜測還是出於良品率考慮,屏蔽了少數存儲單元。

相比之下,H100 PCIe/XM版本都只開啟了5120-bit位寬,六個顯存位只使用五個,容量均為80GB,區別在於一個是HBM2e 2TB/帶寬,一個是HBM3 3.35TB/帶寬。

H100 NVL還可以雙卡組成一個計算節點,彼此通過PCIe 5.0總線互連,總顯存容量就是188GB,總顯存帶寬7.8TB/,NVLink帶寬600GB/,總功耗可達700-800W。

計算性能相當於H100 SXM的整整兩倍,意味著也開啟了全部16896個CUDA核心、528個Tensor核心,其中FP64雙精度浮點性能64TFlops,FP32單精度浮點性能134TFlops。

再加上Transformer引擎加速的輔佐,在數據中心規模,H100 NVL與上一代A100相比,GPT-3上的推理性能提高了多達12倍。

H100 NVL將在今年下半年開始出貨,價格……盡情想像去吧。

值得一提的是,NVIDIA還同時推出了其他兩套推理平台:

NVIDIA L4:

適用於AI視頻,性能比CPU高出120倍,能效提高99,提供強大的的視頻解碼和轉碼能力、視頻流式傳輸、增強現實、生成式AI視頻等。

NVIDIA L40:

適用於圖像生成,針對圖形以及AI支持的2D、視頻和3D圖像生成進行了優化,與上一代產品相比,Stable Diffusion推理性能提高7倍,Omniverse性能提高12倍。

順帶一提,適用於圖形推薦模型、矢量資料庫、圖神經網絡,通過NVLink-C2C 900GB/帶寬連接CPU和GPU,數據傳輸和查詢速度比PCIe 5.0快了7倍。

來源:快科技

老黃良心 NVIDIA第二次為中國特供加速卡H800:BAT三巨頭都用上了

2022年8月,美政府對NVIDIA A100、H100兩款計算加速卡實施禁令,不得銷售給中國企業,黃仁勛隨後表態會推出替代版本。

很快,NVIDIA就拿出了,在已有A100的基礎上將NVLink高速互連總線的帶寬從600GB/降低到400GB/,其他完全不變。

如此一來,A800的大規模擴展互連將受到限制,但是單卡性能沒有損失。

昨晚的GTC 2023春季圖形大會上,NVIDIA又確認為中國市場開發了第二個特供版H800,基於已有的H100調整而來,符合美政府的規定。

NVIDIA沒有透露H800的具體變化,媒體稱和A800類似,將晶片間互連帶寬縮減了一半,如果用於AI訓練會消耗更長的時間。

媒體稱,阿里巴巴、百度、騰訊BAT三巨頭都已經用上了H800加速卡。

H100加速卡採用全新的Hopper架構,GH100 GPU核心,台積電4nm製造工藝、CoWoS 2.5D封裝技術,集成800億個電晶體,核心面積814平方毫米。

它擁有18432個CUDA核心、576個Tensor核心、60MB二級緩存,可搭配6144-bit位寬的六顆HBM3/HBM2e,總容量80GB,支持PCIe 5.0、第四代NVLink總線。

兩種樣式,其中SXM版本15872個CUDA核心、528個Tensor核心,顯存帶寬3.35TB/,NVLink帶寬900GB/,PCIe 5.0帶寬128GB/,熱設計功耗最高700W。

PCIe 5.0版本14952個CUDA核心、456個Tensor核心,顯存帶寬2TB/,NVLink帶寬600GB/,PCIe 5.0帶寬128GB/,熱設計功耗300-350W。

目前尚不清楚中國特供的H800是哪種樣式,猜測很可能是PCIe,那麼NVLink互連帶寬就只有300GB/,PCIe 5.0則應該不會縮水。

A800規格表

H100規格表:精簡一下帶寬就是H800

H100加速卡

來源:快科技

700W功耗性能猛獸 售價超24萬元 NVIDIA稱H100顯卡全面投產

最近幾個月來以ChatGPT為代表的AI大火,也導致了訓練AI用的NVIDIA加速顯卡備受追捧,黃仁勛也多次推薦大家購買A100顯卡,不過這並不是NVIDIA最新最強的AI卡,去年發布的H100才是性能猛獸。

至於黃仁勛為何不重點推H100加速卡,主要是這款顯卡之前產量不多,但在日前的GTC 2023大會上,黃仁勛宣布H100已經全面投產,並部署在多家客戶的雲計算服務中,包括微軟的Azure、Google、甲骨文等客戶數據中心。

H100加速卡與2022年3月份的GTC大會上發布,採用Hopper架構,GH100大核心,台積電4nm製造工藝、CoWoS 2.5D封裝技術,集成800億個電晶體,核心面積814平方毫米。

它擁有18432個CUDA核心、576個Tensor核心、60MB二級緩存,支持6144-bit位寬的六顆HBM3/HBM2e,支持PCIe 5.0,支持第四代NVLink總線。

H100計算卡有SXM、PCIe 5.0兩種樣式,其中SXM版本15872個CUDA核心、528個Tensor核心,PCIe 5.0版本14952個CUDA核心、456個Tensor核心,功耗最高達700W。

性能方面,FP64/FP32 60TFlops(每秒60萬億次),FP16 2000TFlops(每秒2000萬億次),TF32 1000TFlops(每秒1000萬億次),都三倍於A100,FP8 4000TFlops(每秒4000萬億次),六倍於A100。

售價方面,H100的官方建議價一直沒公布,但日本市場之前預售的價格是475萬日元,約合人民幣24.2萬元,比A100的價格至少翻倍了。

來源:快科技

80GB都不夠了 NVIDIA H100計算卡要上120GB HBM2e顯存

你的顯卡顯存有多大?想沒想過顯存超過100GB是什麼概念?

NVIDIA上一代加速計算卡A100首發40GB HBM2顯存,

,其中PCIe5.0形態的還是HBM2e,SXM5形態的則是最新標準HBM3。

根據最新曝料,NVIDIA正在准備120GB HBM2e顯存版的H100計算卡,PCIe形態,顯存帶寬還是高達3TB/。

GH100核心採用台積電4nm工藝製造,集成800億個電晶體,核心面積814平方毫米,內部集成了多達18432個CUDA核心、576個Tensor核心、60MB二級緩存,分為144個SM單元,另有12個512-bit顯存控制器,總位寬6144-bit。

H100 SXM版本只開放15872個CUDA核心、528個Tensor核心,PCIe版本更是只有14952個CUDA核心、456個Tensor核心,功耗卻最高達700W。

曝料稱,新的H100 120GB PCIe將開啟16896個CUDA核心,距離滿血更近了一步。

另外,曝料中還提到了一款代號ADLCE的工程樣卡,顯然是RTX 40 Ada Lovelace的縮寫,應該對應RTX 4090,不過功耗限制在了350W。

來源:快科技

發布半年了 NVIDIA最強顯卡H100終於上市:24萬一塊買不買?

在昨晚的GTC 2022大會(上下半年各一次),NVIDIA不僅發布了RTX 4080/4090系列顯卡,還宣布了一件事,那就是3月份發布的計算卡H100終於開始出貨,也是10月份開始上市。

H100加速卡今年3月份的GTC大會上發布,距今剛好半年了,採用Hopper架構,GH100大核心,台積電4nm製造工藝、CoWoS 2.5D封裝技術,集成800億個電晶體,核心面積814平方毫米。

它擁有18432個CUDA核心、576個Tensor核心、60MB二級緩存,支持6144-bit位寬的六顆HBM3/HBM2e,支持PCIe 5.0,支持第四代NVLink總線。

H100計算卡有SXM、PCIe 5.0兩種樣式,其中SXM版本15872個CUDA核心、528個Tensor核心,PCIe 5.0版本14952個CUDA核心、456個Tensor核心,功耗最高達700W。

H100的價格沒有官方消息,不過之前日本市場有過預售,PCIe版本的都要475多萬日元,人民幣要24萬元以上了,SXM版價格應該會更貴。

根據NVIDIA的說法,H100加速卡10月份上市,其中亞馬遜、Google及微軟三大雲服務供應商會率先實用,還有就是科研機構及高校,洛斯阿拉莫斯國家實驗室和瑞士國家超級計算中心、日本築波大學也會采購。

來源:快科技

NVIDIA 4nm GPU性能首秀:4.5倍提升

9月9日,MLCommons社區發布了最新的MLPerf 2.1基準測試結果,新一輪基準測試擁有近5300個性能結果和2400個功耗測量結果,分別比上一輪提升了1.37倍和1.09倍,MLPerf的適用范圍進一步擴大。

阿里巴巴、華碩、Azure、壁仞科技、戴爾、富士通、技嘉、H3C、HPE、浪潮、Intel、Krai、聯想、Moffett、Nettrix、Neural Magic、NVIDIA、OctoML、高通、SAPEON 和 Supermicro 均是本輪測試的貢獻者。

其中,NVIDIA表現依然亮眼,首次攜H100參加MLPerf測試,並在所有工作負載中刷新世界紀錄。

H100打破世界記錄,較A100性能提升4.5倍

,與兩年前推出的NVIDIA Ampere架構相比,實現了數量級的性能飛躍。

黃仁勛曾在 GTC 2022 上表示,20個H100 GPU便可以承托相當於全球網際網路的流量,能夠幫助客戶推出先進的推薦系統及實時運行數據推理的大型語言模型。

令一眾AI從業者期待的H100原本定於2022年第三季度正式發貨,目前處於接受預定狀態,用戶的真實使用情況和H100的實際性能尚不可知,因此可以通過最新一輪的MLPerf測試得分提前感受H100的性能。

在本輪測試中,對比Intel Sapphire Rapids、Qualcomm Cloud AI 100、Biren BR104、SAPEON X220-enterprise,NVIDIA H100不僅提交了數據中心所有六個神經網絡模型的測試成績,且在單個伺服器和離線場景中均展現出吞吐量和速度方面的領先優勢。

以NVIDIA A100相比,H100在MLPerf模型規模最大且對性能要求最高的模型之一——用於自然語言處理的BERT模型中表現出4.5倍的性能提升,在其他五個模型中也都有1至3倍的性能提升。

H100之所以能夠在BERT模型上表現初出色,主要歸功於其Transformer Engine。

其他同樣提交了成績的產品中,只有Biren BR104在離線場景中的ResNet50和BERT-Large模型下,相比NVIDIA A100有一倍多的性能提升,其他提交成績的產品均未在性能上超越A100。

而在數據中心和邊緣計算類別的場景中,A100 GPU的測試成績依然不俗,得益於NVIDIA...

700W功耗撐不住了 NVIDIA計算卡第一次上液冷:節能30%

對於下一代顯卡,AMD、NVIDIA在台北電腦展期間都三緘其口,絲毫沒有提及。AMD只講處理器,NVIDIA則只說數據中心GPU、CPU。

NVIDIA宣布,Ampere架構的計算卡A100、桌面超算HGX A100,Hopper架構的計算卡H100、桌面超算HGX H100,將在該系列中首次引入液冷散熱,從而提高散熱效率、降低能耗、節省空間和成本。

NVIDIA表示,它們都採用了直接晶片(Direct-to-Chip)冷卻技術。

HGX A100、HGX H100系統採用的都是SXM樣式計算卡,在機架內直接整合液冷散熱系統,取代傳統的系統風冷散熱,體積更加緊湊,前者現已出貨,後者今年第四季度。

A100 PCIe(80GB)、H100 PCIe獨立計算卡則有些類似桌面液冷顯卡,整合水冷頭,不過接口放置在尾部,以便對接液冷系統,前者今年第三季度出貨,後者明年初。

數據中心服務商Equinix正在實驗室中測試自己的首款液冷GPU方案,結果發現,採用液冷技術的數據中心工作負載可與風冷設施持平,同時消耗的能源減少了約30%。

同時,液冷版的A100/H100 PCIe只需占用一個插槽位,相比傳統兩個插槽位的風冷版,可以節省最多66%的機架空間。

NVIDIA估計,液冷數據中心的PUE(電源使用效率)可能達到1.15,遠低於風冷的PUE 1.6。

採用台積電4nm工藝製造、CoWoS 2.5D晶圓級封裝,集成800億個電晶體、18432個CUDA核心、576個Tensor核心、60MB二級緩存,可搭配6144-bit HBM2e/HBM3高帶寬記憶體。

H100計算卡支持SXM、PCIe 5.0兩種形態,其中後者功耗高達史無前例的700W,相比A100多了整整300W。

SXM5版本只開啟15872個CUDA核心、528個Tensor核心、50MB二級緩存。

PCIe 5.0版本則只有14952個CUDA核心、456個Tensor核心。

來源:快科技

NVIDIA H100 SXM實物曝光:核心面積814mm²,80GB HBM3顯存

在GTC 2022上,英偉達發布了新一代基於Hopper架構的H100,用於下一代加速計算平台。其擁有800億個電晶體,為CoWoS 2.5D晶圓級封裝,單晶片設計,採用了台積電(TSMC)為英偉達量身定製的4nm工藝製造。

近日,ServeTheHome發布了NVIDIA H100 SXM的實物近照,可以看到SXM外形的新設計,PCB型號為PG520。據了解,搭載的GH100晶片面積大概為814 mm²,位於正中間,周圍排列了六顆HBM3顯存,容量為80GB。與上一代的A100相比,H100的連接布局也發生了變化,變得更短一些。NVIDIA H100 SXM的TDP高達700W,相比基於 Ampere和Volta架構的同類產品要高出250W到300W,不過H100的PCIe版則只有350W。

完整的GH100晶片配置了8組GPC、72組TPC、144組SM、共18432個FP32 CUDA核心。其採用了第四代Tensor Core,共576個,並配有60MB的L2緩存。有不過實際產品中沒有全部打開,其中SXM版本中啟用了132組SM,共16896個FP32 CUDA核心,528個Tensor Core以及50MB的L2緩存,而PCIe 5.0版本則啟用了114組SM,FP32 CUDA核心數量只有14592個。此外,GH100支持英偉達第四代NVLink接口,可提供高達900 GB/s的帶寬。同時GH100是第一款支持PCIe 5.0標準的GPU,也是第一款採用HBM3的GPU,最多支持六顆HBM3,帶寬為3TB/s,是A100採用HBM2E的1.5倍。

近期日本地區有零售商已列出了NVIDIA H100 PCIe,顯示價格為4745950日元(約合36567.5美元/人民幣241471.3元)。由於NVIDIA H100 SXM規格更高,擁有更多CUDA核心,價格有可能會更貴。 ...

24.2萬元 NVIDIA 4nm H100計算卡第一次露出真容:80GB顯存

3月底的GTC 2022大會上,NVIDIA正式發布了

一個半月過去了,我們終於看到了這款新卡的真容。

依然是傳統的SXM樣式規格,但整體布局相比上代Ampere A100有了很大變化,而正中間自然就是GH100核心,旁邊圍繞著六顆HBM3記憶體/顯存,總容量達80GB。

GH100核心採用台積電4nm製造工藝、CoWoS 2.5D封裝技術,集成800億個電晶體,核心面積814平方毫米。

它擁有18432個CUDA核心、576個Tensor核心、60MB二級緩存,支持6144-bit位寬的六顆HBM3/HBM2e,支持PCIe 5.0,支持第四代NVLink總線。

H100計算卡有SXM、PCIe 5.0兩種樣式,其中SXM版本15872個CUDA核心、528個Tensor核心,PCIe 5.0版本14952個CUDA核心、456個Tensor核心,功耗最高達700W。

上市時間未定,不過日本最近開啟了PCIe版本的預售,價格高達4745950日元,約合人民幣24.2萬元。

SXM版本的或許會更貴。

來源:快科技

英偉達H100計算卡登陸日本市場,約合人民幣24萬元

在GTC 2022上,英偉達發布了新一代基於Hopper架構的H100,用於下一代加速計算平台。NVIDIA H100擁有800億個電晶體,為CoWoS 2.5D晶圓級封裝,單晶片設計,採用了台積電(TSMC)的4nm工藝製造,而且是為英偉達量身定製的版本。

英偉達表示,預計今年第三季度開始供貨,不過並沒有給出H100計算卡的價格。近期日本地區有零售商已列出了H100,顯示價格為4745950日元(約合36567.5美元/人民幣241471.3元)。改價格包含了運費和稅費,若僅計算卡本身是4313000日元(約合33231.7美元/人民幣219443.1元)。

H100分別有SXM和PCIe兩種外形,以支持不同的伺服器設計要求,此次日本零售商放出的是基於PCIe的版本。

完整的GH100晶片配置了8組GPC、72組TPC、144組SM、共18432個FP32 CUDA核心。其採用了第四代Tensor Core,共576個,並配有60MB的L2緩存。有不過實際產品中沒有全部打開,其中SXM5版本中啟用了132組SM,共16896個FP32 CUDA核心,528個Tensor Core以及50MB的L2緩存,而PCIe 5.0版本則啟用了114組SM,FP32 CUDA核心數量只有14592個。此外,前者的TDP達到了700W,後者則為350W。

此外,H100支持英偉達第四代NVLink接口,可提供高達900 GB/s的帶寬。同時H100是第一款支持PCIe 5.0標準的GPU,也是第一款採用HBM3的GPU,最多支持六顆HBM3,帶寬為3TB/s,是A100採用HBM2E的1.5倍,默認顯存容量為80GB。 ...

配備80GB顯存 NVIDIA H100 Hopper加速計算卡上市:價格超24萬元

今天,Videocardz報導稱,日本一零售商以4745950日元(約合人民幣24.16萬元)的價格,掛出了NVIDIA最新的H100 Hopper加速計算卡。

這款加速卡是NVDIA首款採用採用台積電4nm製程工藝的GPU,它採用CoWoS 2.5D晶圓級封裝,單晶片設計,集成高達800億個電晶體。

完整版有8組GPC(圖形處理器集群)、72組TPC(紋理處理器集群)、144組SM(流式多處理器單元),而每組SM有128個FP32 CUDA核心,總計18432個。

此外,它還有著高達80GB的HBM2e顯存,擁有2TB/的帶寬,並是第一款採用PCIe Express 5.0的NVIDIA卡。

根據此前消息,這款H100 Hopper預計要在今年的下半年才會正式上市。

來源:快科技

700W功耗+800億電晶體 NVIDIA的H100核心定製4nm工藝:更省電

,這是一款專為AI及HPC高性能計算而生的超級GPU,擁有1.8萬個CUDA核心,功耗飆升到700W。

H100的生產也是極為復雜的,它沒有使用傳聞的台積電5nm,而是定製版的台積電4nm工藝,名字為4N,而台積電的4nm官方命名是N4,集成了超過800億電晶體,核心面積高達814mm2,作為對比的話,上代的A100核心是台積電7nm工藝,542億電晶體,核心面積826mm2。

由此可見,在面積幾乎相同的情況下,H100核心的電晶體密度提升了48%左右,不過比台積電官方宣稱的密度提升80%要少。

NVIDIA上次使用台積電定製工藝還要追溯到12nm圖靈時代,這次則是4nm工藝定製版,但是跟之前一樣,NVIDIA並沒有明確給出定製版4N工藝跟台積電N4工藝區別有多少。

目前所知的差異主要是能效,4N工藝重點優化了省電,雖然SXM版H100最高功耗有700W,但是PCIe 5.0版的功耗是350W,相比目前的A100核心的400W還低了,但性能提升是數倍的,可見能效之高。

來源:快科技

97%遊戲性能沒了 NVIDIA閹割H100 GPU圖形功能:1.8萬核心砍到512核心

昨晚的GTC 2022大會上,,也是萬眾期待的Hopper新架構,跳過5nm直接上了台積電4nm工藝,800億電晶體,功耗最高可達700W,各方面性能很好很強大。

完整版有8組GPC(圖形處理器集群)、72組TPC(紋理處理器集群)、144組SM(流式多處理器單元),而每組SM有128個FP32 CUDA核心,總計18432個。

相比目前的Ampere GPU架構的1萬個CUDA核心,Hoper的1.8萬CUDA核心提升很大,但是大家不要期待H100的遊戲性能了,因為NVIDIA這次一刀砍到底,閹割得非常厲害。

從NVIDIA的白皮書中可以確認,H100砍掉了大量GPU相關功能,不論是PCIe 5.0版還是SMX版的H100核心中,只有2組TPC單元才可以支持圖形運算,包括矢量、幾何及像素渲染。

2組TPC單元也就是4組SM單元,總計512個CUDA核心是可以跑遊戲的,相比完整的1.8萬核心來說微不足道,性能只相當於完整版H100核心的1/36,也就3%左右,97%的遊戲性能沒了。

NVIDIA解釋說H100是專為AI、HPC及數據分析而生的,並不是為了遊戲而設計的。

考慮到H100在AI、HPC等性能上的提升,NVIDIA閹割大量遊戲功能以便減少設計難度也是可以理解的,畢竟加速卡也不會用來玩遊戲。

針對遊戲玩家的是Ada Lovelace架構,此前爆料也是最多18432個流處理器,但是它會大量閹割計算單元,保留完整的圖形及光追單元,跟H100的設計理念反過來。

來源:快科技

英偉達發布Hopper架構H100:800億個電晶體、80GB的HBM3、TDP為700W

在GTC 2022上,英偉達發布了新一代基於Hopper架構的H100,用於下一代加速計算平台。正如英偉達所言,這是專門為超級計算機設計的GPU,專注於AI性能,通過架構更新和工藝提升,使其性能和效率提高到新的水平。

NVIDIA H100擁有800億個電晶體,相比上一代的A100,有著六倍的性能提升以及兩倍的MMA改進。該款GPU為CoWoS 2.5D晶圓級封裝,單晶片設計,採用了台積電(TSMC)的4nm工藝製造,不過是為英偉達量身定製的版本,與一般的N4工藝有所差別。

英偉達沒有公布H100的核心數量和頻率。據了解,完整的GH100晶片配置了8組GPC、72組TPC、144組SM、共18432個FP32 CUDA核心。其採用了第四代Tensor Core,共576個,並配有60MB的L2緩存。有不過實際產品中沒有全部打開,其中SXM5版本中啟用了128組SM,共15872個FP32 CUDA核心,528個Tensor Core以及50MB的L2緩存,而PCIe 5.0版本雖然也啟用了128組SM,但FP32 CUDA核心只有14952個。此外,前者的TDP達到了700W,後者則為350W。

英偉達表示H100的FP64/FP32運算性能為60 TFlops,FP16運算性能為2000 TFlops,TF32運算性能為1000 TFlops,均是A100的三倍。此外英偉達在Hopper架構上改進了對FP8運算的支持,使其運算性能達到了4000 TFlops,是A100六倍。由於缺乏原生FP8,不得不依賴於FP16,英偉達通過新的轉換器引擎,將根據工作負載在FP8和FP16之間自動切換。

據英偉達介紹,H100支持英偉達第四代NVLink接口,可提供高達900 GB/s的帶寬。同時H100還支持不使用NVLink接口的系統,以PCIe 5.0代替,帶寬為128 GB/s。英偉達表示,H100是第一款支持PCIe 5.0標準的GPU,也是第一款採用HBM3的GPU,最多支持六顆HBM3,帶寬為3TB/s,是A100採用HBM2E的1.5倍,默認顯存容量為80GB。

英偉達還添加了旨在加速動態編程的新DPX指令,以幫助更廣泛的算法,包括路線優化和基因組學。英偉達表示這些算法的性能比其上一代GPU快了七倍,比基於CPU的算法快了四十倍。Hopper架構還對安全性做了改進,多實例GPU(MIG)現在允許在單個H100 GPU上運行七個安全租戶。

與A100一樣,英偉達會將新款的H100添加到DGX H100機架式伺服器。每個DGX H100系統包含8塊H100,共640GB的HBM3顯存,可提供32 PFlops的AI計算性能,以及480 TFlops的FP64運算性能。系統中的每個GPU都通過第四代NVLink連接,帶寬是上一代的1.5倍,加上全新的VNLink Swtich互連系統,可連接32個DGX...

玩水冷不麻煩,海盜船新款一體式水冷散熱器上市

<p雖然水冷散熱在效能上有一定優勢,不過水冷平台搭建的繁瑣讓很多玩家望而卻步。因此,一體式水冷散熱器的誕生為這些玩家帶了福音。日前,海盜船H80和H100兩款一體式水冷散熱器正式上市,玩家們的選擇又增多了。

<p海盜船水冷散熱器H100採用了一體式設計,水冷頭與水泵渾然一體,配置了尺寸為240mm的雙風扇熱排,在安裝大大簡化的同時效能並不遜色於傳統的水冷系統。

<p海盜船H80同樣採用了一體式設計,水冷頭和水泵同樣整合在一起,不過熱排更換為120mm,前後各配置了1把12cm的散熱風扇,同樣具有效能好、安裝方便的優點。

<p目前這兩款產品已經正式上市,其中海盜船H100的報價為119美元,H80的則為109美元,詳情可瀏覽海盜船官方網站。 ...