Tag: Instinct

AMD今年或帶來Instinct MI350系列:升級至4nm工藝,採用HBM3E

前一段時間,美國政府修訂了最新的管制條例,針對人工智慧(AI)和高性能計算(HPC)為主要用途的晶片,4月4日開始實施的APP禁令進一步加強管控的力度,採取了更為嚴格的控制措施。

出口管制的型號不僅有英偉達和AMD之前大量的數據中心產品,比如NVIDIA A100/H100/A800/H800/L40/L40S/RTX 4090和AMD Instinct MI250/300系列,還包括NVIDIA H200/B100/B200/GB200和AMD Instinct MI350系列等下一代產品。

據TrendForce報導,Instinct MI350系列是AMD計劃在今年下半年推出的產品,屬於Instinct MI300系列的升級版本。其採用了台積電(TSMC)的4nm工藝製造,以提供更強的性能並降低功耗,同時搭配的顯存也由HBM3變成了HBM3E,速度提升了50%。據推測,AMD可能會採用12層堆疊的HBM3E,提高帶寬的同時加大容量。

在2023年12月6日主題為「Advancing AI」的活動中,AMD發布了Instinct MI300系列,首批提供了兩款產品,分別是Instinct MI300A(CPU+GPU)和Instinct MI300X(純GPU)。從過去這段時間來看,Instinct MI300系列的銷售相當不錯,AMD執行長蘇姿豐博士表示,2024年AMD的AI晶片銷售額預計將達到35億美元,高於之前20億美元的預期。

早在一個多月以前,就有報導稱,AMD將更新Instinct MI300系列,加入HBM3E。雖然Instinct MI350系列改用了價格更高的HBM3E,但是仍比英偉達產品的定價要更低,成本上依然有優勢。 ...

Instinct MI388X出現在AMD官方文件,稱被禁止在中國銷售

近日,AMD向美國證券交易委員會(SEC)提交了一份冗長的監管文件,指出受制於2023年10月美國政府工業和安全局修訂的出口管制政策,包括Instinct MI250系列、Instinct MI300X和Instinct MI300A,以及Versal VC2802和VE2802兩款FPGA產品,都不能出口中國客戶。

AMD在這些文件里還提到了一款未知的產品,型號為Instinct MI388X,但是沒有透露具體的規格。從型號上看,這是一款針對人工智慧(AI)和高性能計算(HPC)的產品,但是不確定是定位更為高端的型號,還是特定用戶定製的半定製產品。

由於AMD的文件是在2024年1月31日提交的,所以裡面沒有提到3月才被曝光的Instinct MI309。目前還不清楚Instinct MI309到底是APU還是GPU,或者是具體分為Instinct MI309A和Instinct MI309X。傳聞美國商務部認為AMD准備的Instinct MI309,性能也過於強大。AMD有可能繼續降低性能,或者最後選擇放棄。

上周AMD在北京舉辦了AI PC創新峰會,AMD董事會主席及執行長Lisa Su博士攜AMD高級副總裁、大中華區總裁潘曉明,AMD高級副總裁、GPU技術與工程研發王啟尚與AMD高級副總裁、計算與圖形總經理Jack Huynh登台發表演講。從AMD的重視程度來看,不會輕易放棄利潤豐厚的中國人工智慧市場。 ...

三星已獲得AMD驗證,將向Instinct MI300系列供應HBM3

2024年高帶寬存儲器(HBM)市場仍然以HBM3為主流,不過英偉達即將到來的H200和B100將更新至HBM3E。由於人工智慧(AI)需求高漲,導致英偉達及其他供應商的相關晶片供應一直處於緊張的狀態,除了CoWoS封裝是產能的瓶頸外,HBM也逐漸成為供應上的制約點。相比於普通的DRAM,HBM生產周期更長,從投片產出到完成封裝需要兩個季度以上。

TrendForce資深研究副總吳雅婷表示,SK海力士是HBM3最主要的供應商,但是供應量不足以應付整個人工智慧市場的需求。在2023年末,三星採用1Z nm工藝的產品加入了到英偉達的供應鏈,盡管比重很小,但卻是三星在HBM3的首個訂單。

三星是AMD長期以來的最重要的策略供應夥伴,2024年第一季度里,其HBM3也通過了Instinct MI300系列的驗證,其中包括了8層堆疊和12層堆疊的產品。到下一個季度,三星將逐步放大供應量,希望能以此趕上SK海力士。

到了下半年,市場焦點將逐漸從HBM3轉到HBM3E,而且供應量也將慢慢增大,成為HBM市場的主流產品。SK海力士和美光都已經通過了英偉達的驗證工作,計劃2024年第二季度末用於H200。三星至今仍未通過英偉達的驗證,預計最快在2024年第一季度末完成相關工作,第二季度開始供貨。

隨著三星與美光加大出貨HBM產品,意味著終於可以改變SK海力士一家獨大的市場局面。 ...

AMD將於2025年發布Instinct MI400,同時MI300系列也有更新計劃

AMD在2023年12月6日舉辦了主題為「Advancing AI」的活動,推出了新一代針對數據中心的Instinct MI300系列計算卡。從過去這段時間的情況來看,Instinct MI300系列的銷售相當不錯,AMD執行長蘇姿豐博士表示,2024年AMD的AI晶片銷售額預計將達到35億美元,高於之前20億美元的預期。

近日有網友透露,AMD將於2025年發布Instinct MI400,同時InstinctMI300系列也有更新計劃,將配備HBM3E。AMD似乎已經准備好在接下來的一段時間內,以人工智慧(AI)為重點推出新產品。

暫時還不清楚Instinct MI400的具體細節,有可能沿用Instinct MI300系列的設計思路,意思是包含CPU+GPU和純GPU等組合,同時還會有不同的規格可選,讓數據中心的配置更加靈活。

目前Instinct MI300X,共配備192GB的HBM3,提供了5.3TB/s的內存帶寬,而新版InstinctMI300系列標志著AMD緊隨潮流,向新標准過渡。HBM3E是HBM3的擴展(Extended)版本,屬於第五代HBM類產品,速度相比HBM3提升了50%。雖然新版InstinctMI300系列改用了價格更高的HBM3E,但是仍比英偉達產品的定價要更低,成本上依然有優勢,這也是近期AMD人工智慧產品熱銷的原因之一。

雖然AMD還沒有在人工智慧市場取得成功,但是未來的前景是光明的。 ...

微軟是AMD Instinct MI300X的最大買家,定價或僅為H100的四分之一

AMD在2023年12月6日舉辦了主題為「Advancing AI」的活動,推出了新一代針對數據中心的Instinct MI300系列計算卡。其中Instinct MI300X為純GPU設計,採用了CDNA 3架構,可為HPC和AI工作負載提供突破性的性能。

據Seeking Alpha報導,根據花旗集團的分析報告,顯示微軟的數據中心部門是Instinct MI300X的最大買家,已開始為GPT-4這類大型語言模型(LLM)工作。此前AMD執行長蘇姿豐博士表示,AMD在2024年AI晶片的銷售額預計將達到35億美元,高於之前20億美元的預期。

雖然AMD沒有公開Instinct MI300X的定價,不過有知情人士透露,每塊計算卡的售價為1.5萬美元,相比於英偉達的產品是比較實惠的。目前H100 PCIe 80GB HBM2E版本在市場上的售價大概為3萬美元到4萬美元,甚至更高一些,而性能更強的H100 SXM5 80GB HBM3版本的定價則更高。花旗集團的分析師表示,Instinct MI300X的定價或僅為後者的四分之一。此前AMD執行長蘇姿豐博士表示,AMD在2024年AI晶片的銷售額預計將達到35億美元,高於之前20億美元的預期。

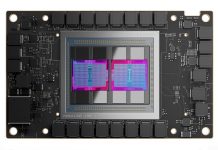

Instinct MI300X採用了小晶片設計,混用5nm和6nm工藝,電晶體數量達到了1530億個。其使用了第四代Infinity Fabric解決方案,共有28個模塊晶片,其中包括8個HBM和4個計算晶片,而每個計算晶片擁有2個基於CDNA 3架構的GCD,共80個計算單元,意味著有320個計算單元和20480個流處理器。出於良品率的考慮,AMD削減了部分計算單元,實際使用數量為304個計算單元和19456個流處理器。此外,HBM3容量達到192GB,提供了5.3TB/s的內存帶寬和896GB/s的Infinity Fabric帶寬。 ...

Instinct MI300X成功引起市場關注,AMD新產品讓競爭對手「頭疼」

AMD在2023年12月6日舉辦了主題為「Advancing AI」的活動,推出了新一代針對數據中心的Instinct MI300系列計算卡。首批提供了兩款產品,分別是Instinct MI300A(CPU+GPU)和Instinct MI300X(純GPU),結合了最新的CDNA 3架構和Zen 4架構,可為HPC和AI工作負載提供突破性的性能。

近日有AMD的客戶確認,已經收到了Instinct MI300X,並開始為企業運行大型語言模型(LLM),進行相關的驗證工作。據Wccftech報導,AMD這次的新款GPU成功引起了市場的關注,在計算加速卡領域似乎要強勢回歸,競爭對手的客戶里,不少都對Instinct MI300X產生了興趣。

Instinct MI300X巨大的性能提升是一方面,另外AMD選擇的新品發布時間十分完美,恰逢英偉達被海量積壓訂單困擾,阻礙了新客戶的增長,也給了AMD更多的機會。人工智慧市場預計在未來幾年內迅速增長,市場規模到2027年將增至4000億美元,AMD執行長蘇姿豐將其歸為科技行業下一個大事件,正在為這一巨大增長做好准備。

Instinct MI300X採用了小晶片設計,混用5nm和6nm工藝,電晶體數量達到了1530億個。其使用了第四代Infinity Fabric解決方案,共有28個模塊晶片,其中包括8個HBM和4個計算晶片,而每個計算晶片擁有2個基於CDNA 3架構的GCD,共80個計算單元,也就是320個計算單元和20480個流處理器。出於良品率的考慮,AMD削減了部分計算單元,實際使用數量為304個計算單元和19456個流處理器。此外,HBM3容量達到192GB,提供了5.3TB/s的內存帶寬和896GB/s的Infinity Fabric帶寬。 ...

英偉達數據中心GPU最強競爭對手出貨,AMD客戶接收首批Instinct MI300X

近日LaminiAI執行長Sharon Zhou表示,AMD已經出貨用於人工智慧(AI)和高性能計算(HPC)的Instinct MI300X計算卡。據了解,LaminiAI得到了多台裝載Instinct MI300X的機器,每台配有8塊Instinct MI300X計算卡。這意味著,Instinct MI300X開始為企業運行大型語言模型(LLM)。

AMD開始出貨Instinct MI300系列已經有一段時間了,預計新產品可能成為其歷史上銷售最快的產品,目前已達到10億美元。對於AMD來說,這是一個重要的里程碑,將向英偉達主導的人工智慧晶片領域發起挑戰。首批Instinct MI300系列提供了兩款產品,分別是Instinct MI300A(CPU+GPU)和Instinct MI300X(純GPU)。

Instinct MI300X採用了小晶片設計,混用5nm和6nm工藝,電晶體數量達到了1530億個。其使用了第四代Infinity Fabric解決方案,共有28個模塊晶片,其中包括8個HBM和4個計算晶片,而每個計算晶片擁有2個基於CDNA 3架構的GCD,共80個計算單元,意味著有320個計算單元和20480個流處理器。出於良品率的考慮,AMD削減了部分計算單元,實際使用數量為304個計算單元和19456個流處理器。此外,HBM3容量達到192GB,提供了5.3TB/s的內存帶寬和896GB/s的Infinity Fabric帶寬。Instinct MI300A則是一款APU設計。其擁有24個基於Zen 4架構的內核,另外減少了1個計算晶片,使得計算單元數量也減至228個,對應14592個流處理器。

目前已經有不少大型雲端伺服器運營商采購Instinct MI300系列產品,有消息稱,今年預計出貨量為30萬至40萬,其中最大的客戶是谷歌和微軟,不過LaminiAI是首家確認已在使用Instinct MI300X計算卡的公司。 ...

AMD Instinct MI300A收獲新訂單:德國「Hunter」和「Herder」超算系統

AMD在2023年12月6日舉辦了主題為「Advancing AI」的活動,推出了新一代針對數據中心的Instinct MI300系列計算卡。首批提供了兩款產品,分別是Instinct MI300A(CPU+GPU)和Instinct MI300X(純GPU),結合了最新的CDNA 3架構和Zen 4架構,可為HPC和AI工作負載提供突破性的性能。

近日德國斯圖加特高性能計算中心(HLRS)發出公告,表示已經與HPE達成協議,基於Instinct MI300A打造兩台新的超級計算機,分別名為「Hunter」和「Herder」,將極大地擴展德國的高性能計算(HPC)能力。在第一階段,「Hunter」作為過渡超算系統在2025年開始運行,到了2027年的第二階段,再安裝「Herder」,這是一台擁有每秒百億億級(ExaFLOP)運算能力的超算系統。

官方表示,「Hunter」和「Herder」將為研究人員提供世界一流的仿真、人工智慧(AI)和高性能數據分析(HPDA)基礎設施,為計算工程和應用科學領域的前沿學術和工業研究提供動力。據了解,整個項目將耗資1.15億歐元。

Instinct MI300A是一款APU,採用了小晶片設計,混用5nm和6nm工藝製造,使用了第四代Infinity Fabric解決方案。其擁有24個基於Zen 4架構的內核,3個計算晶片,每個計算晶片擁有2個基於CDNA 3架構的GCD,計算單元數量為228個,對應14592個流處理器,配有128GB的HBM3,提供了5.3TB/s的內存帶寬。 ...

AMD推出Instinct MI300系列計算卡,提供數據中心AI解決方案組合

AMD在太平洋標准時間2023年12月6日早上10點(12月7日凌晨2點)舉辦了主題為「Advancing AI」的活動,推出了新一代針對數據中心的Instinct MI300系列計算卡。AMD表示,新產品具有業界領先的生成式AI內存帶寬,在大型語言模型(LLM)訓練和推理方面具有領先性能,結合了最新的CDNA 3架構和Zen 4架構,可為HPC和AI工作負載提供突破性的性能。

首批Instinct MI300系列提供了兩款產品,分別是Instinct MI300A(CPU+GPU)和Instinct MI300X(純GPU)。

Instinct MI300X採用了小晶片設計,混用5nm和6nm工藝,電晶體數量達到了1530億個。其使用了第四代Infinity Fabric解決方案,共有28個模塊晶片,其中包括8個HBM和4個計算晶片,而每個計算晶片擁有2個基於CDNA 3架構的GCD,共80個計算單元,意味著有320個計算單元和20480個流處理器。出於良品率的考慮,AMD削減了部分計算單元,實際使用數量為304個計算單元和19456個流處理器。此外,HBM3容量達到192GB,提供了5.3TB/s的內存帶寬和896GB/s的Infinity Fabric帶寬。

在此次大會上,AMD還宣布Instinct MI300A已進入量產階段,這是一款APU設計。其擁有24個基於Zen 4架構的內核,另外減少了1個計算晶片,使得計算單元數量也減至228個,對應14592個流處理器。

有消息稱,預計明年Instinct MI300系列的出貨量為30萬至40萬,其中最大的客戶是谷歌和微軟。 ...

微軟雲計算服務將率先採用Instinct MI300X,將用於生成式AI領域

微軟與AMD宣布,微軟的雲計算服務將率先採用Instinct MI300X計算卡,配合第四代EPYC伺服器處理器打造了全新Azure雲端虛擬機。這些新實例將用在雲計算和生成式人工智慧領域,並進行了相關的優化,提供更強的性能、更新的服務和額外的計算能力。

Azure ND MI300x v5虛擬機將是第一個採用Instinct MI300X計算卡的雲端平台,CDNA 3架構GPU帶來了巨大的性能飛躍,192GB的超大顯存容量能夠加速高性能計算(HPC)和人工智慧(AI)工作負載。微軟與AMD還展示了如何通過AMD的產品組合,在雲端和生成式AI、加密運算、雲計算以及更智能、更智能的個人電腦領域實現了新的服務和計算能力。

根據之前AMD的官方介紹,Instinct MI300X屬於純GPU設計,採用5nm工藝製造,具有8個XCD(最多304個CU / CDNA 3架構)和8個HBM3堆棧(共192GB),是數據中心使用的傳統加速器。

微軟表示,除了Instinct MI300X計算卡,第四代EPYC伺服器處理器還會為通用、內存密集型和計算優化的虛擬機提供動力。這些新的虛擬機不僅提供了具有競爭力的價格,而且還提供了20%的標准性能提升和兩倍於面向計算的虛擬機的性能提升。 ...

AMD將舉辦主題為「Advancing AI」的活動:或正式發布Instinct MI300系列

AMD宣布,將於太平洋標准時間2023年12月6日早上10點(12月7日凌晨2點)舉辦主題為「Advancing AI」的活動,據推測,AMD會在這次活動上正式發布Instinct MI300系列產品,這與以往其數據中心產品的發布時間相一致。

AMD早在今年6月就表示,計劃在第三季度向合作夥伴提供Instinct MI300系列產品,其中Instinct MI300A在第二季度會提供樣品。值得關注的是,AMD遊戲營銷高級總監Sasa Marinkovic也在自己的社交媒體帳戶上分享了這次活動的信息,表明Ryzen AI生態系統及其增強功能可能會更新。

根據現有的資料,Instinct MI300系列產品可能包括:

Instinct MI300A(CPU+GPU)- 6個XCD(最多228個CU / CDNA 3架構),3個CCD(最多24個核心 / Zen 4架構),8個HBM3堆棧(共128GB)

Instinct MI300X(純GPU)- 8個XCD(最多304個CU / CDNA 3架構),0個CCD(最多0個核心 / Zen 4架構),8個HBM3堆棧(共192GB)

Instinct...

AMD對Instinct MI300系列寄予厚望,或成為其最快達10億美元銷售額的產品

多年來,AMD一直試圖從英偉達手中搶奪數據中心GPU市場,不過並沒有取得太大的戰果,這很大程度上是因為軟體支持方面的問題,難以突破英偉達構建的生態體系。隨著人工智慧(AI)需求的爆發,加上AMD的重視並加大了投入,近期局面似乎出現了改變,或許很快會迎來突破性的產品。

據TomsHardware報導,AMD執行長蘇姿豐博士在與分析師和投資者的收益電話會議上表示,預計第四季度數據中心GPU的收入將達到約4億美元,隨著出貨量的提升帶動銷售額增加,到2024年將超過20億美元。這意味著,已開始發貨的Instinct MI300系列將成為AMD歷史上最快達10億美元銷售額的產品。

相比於以往的產品,Instinct MI300系列的定位更加精準,不僅能提供超級計算機和數據中心所需的解決方案,還能解決雲服務提供商進行人工智慧訓練和推理的問題,加上不同的搭配選擇,使其在性能和軟體功能上更具競爭力。

根據現有的資料,Instinct MI300系列產品可能包括:

Instinct MI300A(CPU+GPU)- 6個XCD(最多228個CU / CDNA 3架構),3個CCD(最多24個核心 / Zen 4架構),8個HBM3堆棧(共128GB)

Instinct MI300X(純GPU)- 8個XCD(最多304個CU / CDNA 3架構),0個CCD(最多0個核心 / Zen 4架構),8個HBM3堆棧(共192GB)

Instinct MI300C(純CPU)- 0個XCD(最多0個CU / CDNA...

AMD收到新的AI晶片訂單:甲骨文將購入Instinct MI300X計算卡

此前有報導稱,AMD的AI(人工智慧)晶片在2024年至2025年的出貨量會快速增長,同時也會帶動收入的增加。2024年AMD的AI晶片(以Instinct MI300A為主)出貨量大概是英偉達的10%左右,其中最大的客戶是微軟,占比超過了50%,其次是亞馬遜,另外Meta和谷歌正在測試AMD提供的樣品。到了2025年,AMD的AI晶片出貨量將增至英偉達的30%甚至更多。

據Wccftech報導,雲計算巨頭之一的甲骨文(Oracle)已經訂購了AMD的Instinct MI300X,不過暫時還不清楚具體的數量和訂單的價格等細節,這些計算卡預計會在明年年中啟用。根據之前AMD的官方介紹,Instinct MI300X屬於純GPU設計,具有8個XCD(最多304個CU / CDNA 3架構)和8個HBM3堆棧(共192GB),是數據中心使用的傳統加速器。

過往甲骨文是英偉達AI最大的客戶之一,現在選擇購入AMD的同類晶片,或許會打破目前市場的競爭格局。有消息稱,甲骨文打算改用「雙源」的采購方式,意思是同時從英偉達和AMD購買AI晶片,而且在明年會優先考慮AMD的產品,原因是英偉達因市場的巨大需求沒有達到甲骨文預定的采購目標。

除了甲骨文之外,傳聞IBM也有意訂購AMD的Xilinx FPGA AI解決方案,以擴展其NeuReality的AI基礎設施。

AMD執行長蘇姿豐博士在今年7月接受相關媒體采訪時表示,未來10年人工智慧(AI)將呈指數級增長,預計3到5年內相關產品的市場規模可能會達到1500億美元,而AMD已經將AI作為分配資源和投資的首要領域,將來所有產品都將內置AI技術。 ...

2024年將是AMD在AI領域重要的一年,有望獲得微軟等企業的訂單

此前AMD執行長蘇姿豐博士在接受相關媒體采訪時表示,未來10年人工智慧(AI)將呈指數級增長,預計3到5年內相關產品的市場規模可能會達到1500億美元,而AMD已經將AI作為分配資源和投資的首要領域,將來所有產品都將內置AI技術。

據Wccftech報導,有分析師預測,AMD的AI業務在接下來的幾年裡可能會有較大的發展,預計AMD的AI晶片在2024年至2025年的出貨量會快速增長,同時也會帶動收入的增加。

通常在談及AI晶片的時候,大家首先會想到英偉達。由於過去十幾年裡的大量投資,加上豐富的軟體資源,為AI打造的生態系統形成了巨大的優勢。不過隨著AMD對AI業務的重視和投入,情況可能很快會發生變化。最近AMD還收購了Mipsology和Nod.ai兩間AI軟體公司,以增強AI產品實力。如果AMD想在AI領域趕上英偉達,接下來還有許多工作要完成,可能要花上好幾年的時間。

調查顯示,2024年AMD的AI晶片(以Instinct MI300A為主)出貨量大概是英偉達的10%左右,其中最大的客戶是微軟,占比超過了50%,其次是亞馬遜,另外Meta和谷歌正在測試AMD提供的樣品。到了2025年,AMD的AI晶片出貨量將增至英偉達的30%甚至更多。

根據之前AMD的官方介紹,Instinct MI300A屬於CPU+GPU的組合,具有6個XCD(最多228個CU / CDNA 3架構)、3個CCD(最多24個核心 / Zen 4架構)和8個HBM3堆棧(共128GB),看來這種APU設計還是很符合客戶的需求。在2023年第二季度的財報會議上,蘇姿豐博士還確認了下一代的Instinct MI400系列已在開發當中。 ...

傳三星與AMD達成協議,將為Instinct MI300系列提供HBM3和封裝技術

此前有報導稱,由於A100和H100數據中心GPU的需求大幅度提高,而負責製造及封裝的台積電(TSMC)產能有限,英偉達與三星進行談判,或許要分擔部分的工作量。三星的目標不僅僅是封裝訂單,還想借機拿下部分HBM3訂單,而之前都是SK海力士負責的。AMD新一代Instinct MI300系列產品也即將發貨,同樣需要HBM3和2.5D封裝,這意味著產能方面會更加緊張。

據Hangyunk報導,AMD已經與三星達成協議,後者將負責為Instinct MI300系列提供HBM3和封裝技術。鑒於台積電的封裝產能被英偉達大批量訂單占據,這讓AMD新產品陷入非常不利的局面,如果想進一步開拓人工智慧市場,急需其他合作夥伴分擔工作量,這也給了三星切入的機會。

目前三星已通過了HBM3的決定性質量測試,為與AMD之間的合作打下了基礎。隨著拿下AMD Instinct MI300系列產品的訂單,有機構預計明年三星將獲得HBM市場50%的份額。三星也向英偉達提出了新的方案,而現階段「雙源」戰略對後者可能更為有利,可以最大限度地提高產能,不過英偉達還需要顧及與台積電之間的關系。

根據現有的資料,Instinct MI300系列產品可能包括:

Instinct MI300A(CPU+GPU)- 6個XCD(最多228個CU / CDNA 3架構),3個CCD(最多24個核心 / Zen 4架構),8個HBM3堆棧(共128GB)

Instinct MI300X(純GPU)- 8個XCD(最多304個CU / CDNA 3架構),0個CCD(最多0個核心 / Zen 4架構),8個HBM3堆棧(共192GB)

Instinct MI300C(純CPU)- 0個XCD(最多0個CU...

CEO證實Instinct MI400系列開發中:或基於CDNA 4架構,AMD軟體也會有變化

AMD最近發布了新一代Instinct MI300系列計算加速卡,既有CPU+GPU的Instinct MI300A(Zen 4+CDNA 3),也有純GPU的Instinct MI300X(CDNA 3),搭配大容量HBM3,可滿足需要大量內存容量和帶寬的大型語言模型(LLM)的需求。

與以往不同,Instinct MI300系列主要優點之一是其多功能性,這是利用模塊堆疊技術實現的,APU和GPU共享了架構,將不同內核的模塊封裝在一起,高性能計算(HPC)和人工智慧(AI)工作負載都受益於統一的內存架構。雖然Instinct MI300系列還沒有完全鋪開,但在近期的2023年第二季度的財報會議上,AMD執行長蘇姿豐博士證實了下一代的Instinct MI400系列已在開發當中,不過暫時沒有提供具體的細節。

從這些工作負載和我們正在進行的投資來看,不僅是現在,還有下一代Instinct MI400系列等,我們絕對相信我們擁有一個非常有競爭力和能力的硬體路線圖。 我認為,坦率地說,關於AMD的討論一直都是關於軟體路線圖的,而我們確實在軟體方面看到了一些變化。Instinct MI400系列屬於AMD第五代Instinct產品,面向高端數據中心,可能基於CDNA 4架構,並引入新的XSwitch互連技術。相信在硬體設計上,AMD會遵循之前Instinct產品所設定的路徑,更讓人好奇的是,蘇姿豐博士提到AMD在軟體方面的改變。相比於競爭對手英偉達,AMD在軟體堆棧上有較大的差距,讓Instinct產品在競爭上一直處於下風,對銷售有很大的影響。 ...

AMD Instinct MI300系列分為三種版本,純CPU型號在Linux補丁出現

AMD新一代Instinct MI300系列計算加速卡即將上市,在之前的官方介紹中可以了解到,至少有兩款產品可以選擇,分別是Instinct MI300A(CPU+GPU)和Instinct MI300X(純GPU)。

據Coelacanth Dream報導,近期曝光的Linux補丁中還出現了名為「Instinct MI300C」的新款產品。據了解,這是Instinct MI300系列裡的純CPU版本,相當於搭配了HBM3的EPYC Genoa處理器,配備了96個Zen 4架構核心及128GB的HBM3。由於AMD還沒有公開這款產品,暫時還不清楚其定位,競爭對手應該是英特爾代號Sapphire Rapids-HBM的Xeon Max,其中包含了64GB的HBM2e。

根據現有的資料,Instinct MI300系列產品可能包括:

Instinct MI300A(CPU+GPU)- 6個XCD(最多228個CU / CDNA 3架構),3個CCD(最多24個核心 / Zen 4架構),8個HBM3堆棧(共128GB)

Instinct MI300X(純GPU)- 8個XCD(最多304個CU / CDNA...

台積電為AMD Instinct MI300系列准備更先進的設備,CoWoS封裝產能或翻倍

台積電(TSMC)在近期的財報電話會議上表示,為了滿足對人工智慧(AI)和高性能計算(HPC)的晶片需求,最近為CoWoS封裝訂購了額外的設備。或許是近期人工智慧熱潮推高了銷售預期,無論台積電還是AMD,似乎對即將到來的Instinct MI300系列GPU/APU的需求十分樂觀。

據DigiTimes報導,隨著Instinct MI300系列的量產,CoWoS封裝產能短缺的狀況可能會加劇。有業內人士表示,台積電預計AMD新款數據中心產品對CoWoS封裝的需求會達到英偉達的一半,顯然這是一個相當樂觀的預期。要知道英偉達圍繞CUDA核心構建的軟體堆棧在人工智慧和高性能計算占據了主導地位,經過十幾年的苦心經營,目前擁有超過90%的計算加速卡市場。

除了英偉達和AMD,亞馬遜、博通和賽靈思等企業也陸續在其數據中心產品中採用CoWoS封裝,這也促使台積電為滿足生產需要盡快向CoWoS封裝下單訂購新設備。據了解,這類生產工具的交付時間不到6個月,台積電應該可以趕在年底前進一步提高產能。有消息稱,台積電計劃2023年底前將現有的CoWoS封裝產能從每月8000片提高到11000片,到2024年底時再進一步提高到14500片至16600片,這意味著至明年年底,CoWoS封裝產能有可能會提升一倍。

有分析師認為,台積電和AMD對於市場的需求過於樂觀,除非有突破性的進展,否則很難實現既定的目標。 ...

AMD或跟隨英偉達及英特爾的做法,開發專供中國市場銷售的AI GPU產品

AMD剛剛公布了2023年第二季度財報,取得了超出市場預期的成績。隨後的財報電話會議上,AMD執行長蘇姿豐博士不但確認了接下來Radeon遊戲顯卡的更新計劃,而且還強調了加速人工智慧(AI)工作負載的數據中心產品線的重要性。事實上在更早之前,蘇姿豐博士就曾表示,人工智慧帶來了巨大的增長機遇,預計未來10年人工智慧將呈指數級增長。

僅僅一個季度內,AMD的人工智慧業務收入就增長了七倍多,在現今市場不景氣的大環境裡顯得難能可貴。同時也給了AMD更大的壓力,要求他們必須盡快開發出合適的晶片,並克服量產和銷售的障礙,滿足客戶群體不斷增長的性能需求。要知道競爭對手英偉達,旗下的AI GPU乘著人工智慧的東風,成為了當下半導體市場上最大的亮點,也讓英偉達的營收實現了逆勢增長。

蘇姿豐博士重申,中國市場對於AMD的重要性,在其投資組合中也是如此,考慮Instinct系列產品銷售市場時也同樣會顧及到。AMD計劃像英偉達及英特爾那樣,通過定製產品繞開相關的出口限制,尋找機會向中國客戶提供對應的人工智慧解決方案,接下來將朝著這個方向努力。

此前英偉達通過限制NVLink互連總線的連接速率,限制在400 GB/s,先後推出了A800系列和H800系列計算卡,率先帶來了中國市場特供產品。英特爾今年也調整了MAX系列GPU產品線,取消了原有的MAX 1350,然後新增了一款名為MAX 1450的產品,通過削減I/O帶寬滿足出口管製法規的要求,以迎合「不同市場」的需要。 ...

AMD執行長稱未來10年AI將呈指數級增長,3到5年內市場規模達到1500億美元

近日,AMD執行長蘇姿豐博士正在台灣與主要行業領導者討論下一代晶片和新興的人工智慧(AI)市場計劃,期間再次強調了人工智慧帶來的巨大增長機遇,這股浪潮已經席捲了世界。

在接受相關媒體采訪時,蘇姿豐博士預計未來10年人工智慧將呈指數級增長,3到5年內相關產品的市場規模可能會達到1500億美元,而AMD已經將人工智慧作為分配資源和投資的首要領域。

業界認為蘇姿豐博士在此次訪問期間可能會與台積電(TSMC)就3nm晶片的生產達成協議,用於下一代晶片上,同時會為基於CDNA 3架構的Instinct MI300/MI300X安排產能,這是AMD在人工智慧市場的優先戰略之一。蘇姿豐博士強調,製造Instinct MI300/MI300X晶片是一個艱難的過程,需要與各種供應鏈合作夥伴合作,這也是此次訪問形成的議題之一。

蘇姿豐博士表示,人工智慧的增長不會很快停止,未來5到10年將看到重大發展,而AMD將來所有產品都將內置人工智慧技術,尤其是GPU,因為生成式人工智慧是非常受歡迎的新興市場。蘇姿豐博士還強調了ROCm內部為支持各種大型語言模型所做的工作,並且隨著客戶積極的響應,會盡快提供進一步的更新。 ...

El Capitan超算開始裝入AMD Instinct MI300 APU,計劃2024年全面上線

美國勞倫斯利弗莫爾國家實驗室(LLNL)宣布,ExaFLOP級的El Capitan超級計算機正在安裝組件,計劃在2024年全面上線。El Capitan超級計算機將會有多個節點,每個節點都會配備多塊Instinct MI300 APU,將安裝在新款SH5插座(LGA 6096)上。為了確保軟硬體運作正常,El Capitan大概在一年前已經進行了第一階段的安裝工作。

與Frontier和Aurora一樣,El Capitan基於惠普的Shasta超級計算機架構,因此由惠普企業(HP Enterprise)負責製造,採用了Slingshot-11互連,將每個HPE Cray XE機架連接在一起。據了解,El Capitan大概在2024年中旬完工時,其FP 64峰值計算性能達到了2 ExaFLOP,將成為世界上最快的超級計算機,是以往Sierra的10倍,後者從2018年開始運行,採用了IBM的Power9 CPU和英偉達的Volta架構GPU。

El Capitan是首次採用APU作為超算系統的核心,將為AMD未來Exascale APU模式的發展鋪平了道路。Instinct MI300 APU將採用5nm工藝製造,有24個Zen 4架構內核的CPU模塊,以及CDNA 3架構的GPU模塊,搭配了128GB的HBM3,同時還配備下一代Infinity Cache,並使用第四代Infinity架構,支持CXL 3.0生態系統。

AMD已經對Instinct MI300進行了幾個月的內部測試,看起來准備向主要客戶交付,預計會在2023年末上市。...

AMD Instinct MI450將採用全新XSwitch互連結構,與NVLink競爭

AMD在去年更新了GPU的RDNA/CDNA系列架構路線圖,其中已確認Instinct MI300系列會提供多種規格,其中一款是APU,將Zen 4架構和CDNA 3架構的模塊以及HBM記憶體堆棧封裝在一起。美國勞倫斯利弗莫爾國家實驗室(LLNL)的El Capitan超級計算機計劃在2023年末部署,將使用Instinct MI300 APU。

從現階段的情況來看,超級計算機使用的晶片將包含CPU和GPU部分是未來的發展趨勢,像英偉達也推出了Grace Hopper,使用了NVLink-C2C將Arm架構CPU和Hopper架構GPU結合在一起。據Wccftech報導,一份泄露的AMD內部郵件顯示,AMD正在制定其數據中心APU系列計劃,推動下一代晶片的研發,以取代Instinct MI300系列。

該份電子郵件包含了三個有關這款晶片的信息,分別是Weisshorn、Instinct MI450和XSwitch。據推測,Weisshorn應該是AMD內部對代號「Venice」的Zen 6架構EPYC系列CPU的稱呼。XSwitch則是一種互連結構,應該是AMD對英偉達NVLink的回應,將會在Instinct MI400系列上引入。

從過往了解到的信息來看,基於Zen 6架構的CPU預計在2025年至2026年推出,而Instinct MI400系列估計時間上差不多,也在2025年左右。Instinct MI400系列估計和Instinct MI300系列一樣,提供多種規格,比如配備不同的HBM類顯存堆棧,加上晶片採用3D晶片堆疊技術,不同的模塊採用不同的工藝製造,然後結合在一起。 ...

Atos基於AMD Genoa EPYC和Instinct MI300打造新超算,採用直接浸沒式散熱

Atos宣布,將基於AMD Genoa EPYC伺服器處理器和Instinct MI300 APU加速卡打造新的BullSequana XH3000平台,為馬克斯·普朗克科學促進協會(Max Planck Society)建造和安裝一台新的高性能超級計算機,這是一家位於德國慕尼黑的領先科學技術研究機構。

這份訂單總價超過2000萬歐元,將由馬克斯·普朗克計算和數據設施(MPCDF)負責操作,為馬克斯·普朗克科學促進協會的研究提供高性能計算(HPC)的能力,包括天體物理學、生命科學研究、材料研究、等離子體物理學和人工智慧等。

由於該系統採用了直接浸沒式的液冷散熱方式,可以在沒有風扇的情況下運行,顯著提高了能源效率。據了解,其電力使用效率(PUE)值低於1.05(1是理想指),遠遠低於其他高性能計算系統的平均水平。

這台高性能超級計算機將採用AMD代號Genoa的EPYC伺服器處理器,且首次在Atos系統里搭載了AMD面向數據中心的下一代APU加速卡Instinct MI300。該系統由10個BullSequana XH3000機架組成,共有768個處理器節點和192個加速器節點,並與IBM SpectrumScale存儲解決方案相補充。其中處理器節點將於2023年第三季度交付,加速器節點預計會在2024年上半年全面安裝。 ...

AMD確認代號Bergamo的EPYC將於2023H1推出,Instinct MI300要等到2023H2

AMD去年憑借基於Zen 4架構、代號Genoa的第四代EPYC伺服器處理器,領先英特爾代號Sapphire Rapids的第四代至強可擴展處理器幾個月進入2023年。AMD今年計劃推出四款全新的數據中心產品,包括Genoa-X、Bergamo、Siena和Instinct MI300。

AMD在2022年第四季度財報電話會議上,再次確認了基於Zen 4c架構、代號Bergamo的EPYC伺服器處理器將會在2023年上半年推出,不過Instinct MI300要等到2023年下半年。

Bergamo針對計算密集應用進行了優化,刪除了某些不需要的功能並提高了密度,最多擁有128個核心,競爭對手除了英特爾的同類產品,還有各種針對雲服務的Arm處理器。相比於普通的EPYC伺服器處理器,Bergamo有著更高的電源效率和每插槽性能,並與Genoa/Genoa-X採用相同的插座,也會支持PCIe 5.0、DDR5和CXL 1.1。

Instinct MI300是AMD面向數據中心的下一代APU加速卡產品,採用了Chiplet設計,擁有13個小晶片,通過3D堆疊的方式,包括了24個Zen 4架構CPU內核、基於CDNA 3架構的GPU模塊、以及128GB的HBM3顯存,共1460億個電晶體。其中的小晶片以5nm和6nm工藝製造,其中5nm的有9塊,6nm的有4塊。據推測,Instinct MI300的9個計算模塊里,有3個屬於CPU,6個屬於GPU。這是AMD迄今為止最大的晶片,超過了英特爾1000億個電晶體的Ponte Vecchio。

AMD在CES 2023上並沒有透露太多Instinct MI300的細節,只是簡單地與Instinct MI250X做了部分性能比較,AI性能是後者的8倍,每瓦性能則是後者的5倍。美國勞倫斯利弗莫爾國家實驗室(LLNL)的ExaFLOP級El Capitan超級計算機計劃在2023年末部署,將會採用Instinct MI300。 ...

AMD Instinct MI300 APU將用於El Capitan超算,計算性能達到2ExaFLOP

此前AMD更新了GPU的RDNA/CDNA系列架構路線圖,其中已確認Instinct MI300系列會提供多種規格,其中一款是APU,將Zen 4架構和CDNA 3架構的模塊以及HBM記憶體堆棧封裝在一起。據HPC Wire報導,在橡樹嶺國家實驗室(ORNL)舉行的第79屆HPC用戶論壇上,勞倫斯利弗莫爾國家實驗室(LLNL)的高性能計算副主任Terri Quinn透露,ExaFLOP級的El Capitan超級計算機計劃在2023年末部署,將使用Instinct MI300 APU。

El Capitan超級計算機將會有多個節點,每個節點都會配備多塊Instinct MI300 APU。之前有傳言稱,Instinct MI300 APU將安裝在新款SH5插座(LGA 6096)上。據悉,El Capitan超級計算機的FP 64峰值計算性能達到了2 ExaFLOP,意味著其性能將是Sierra的10倍,後者從2018年開始運行,採用了IBM的Power9 CPU和英偉達的Volta架構GPU。

據了解,El Capitan超級計算機將由HPE設計,採用了Slingshot-11互連,將每個HPE Cray XE機架連接在一起。首次採用APU作為超算系統的核心,將為AMD未來Exascale APU模式的發展鋪平了道路。Instinct MI300...

AMD Instinct MI300系列將會有APU版:將Zen 4架構與CDNA 3架構的模塊整合

此前有報導指出,Instinct MI300系列GPU可能會提供多種規格,配備的HBM3顯存堆棧可能分別會從兩個到八個。這款基於CDNA 3架構的產品會採用3D晶片堆疊技術,在小晶片的下方會有一個帶I/O接口的基礎模塊,而每個基礎模塊可以連接兩個HBM3顯存堆棧,採用6nm工藝製造,而計算模塊則採用5nm工藝製造。

近日AdoredTV泄露了一張AMD的PPT,據稱來自AMD內部的Instinct MI300系列計劃演示文稿,證實了Instinct MI300系列除了作為GPU出現,也可以是APU,將Zen 4架構和CDNA 3架構的模塊封裝在一起。

這個消息也不太讓人驚訝,畢竟過往就有報導稱,AMD還有一款稱為「SH5」的新伺服器插座,搭載的晶片可能會將CPU模塊與GPU模塊及記憶體一起封裝,稱為Exascale APU模式。

從過往曝光的Instinct MI300系列結構來看,其配備了至少六個HBM記憶體堆棧。無論是GPU版還是APU版,封裝後的大小應該是一樣的。AMD曾發表過一篇論文,名為「百億億次計算APU的設計與分析」,里面就討論了一種高性能的晶片設計,里面會包含CPU晶片、GPU晶片和HBM記憶體堆棧。 ...

AMD Instinct MI300或採用3D晶片堆疊:8個計算模塊,支持PCIe 5.0和HBM3

AMD去年推出了基於CDNA 2架構的Instinct MI200系列計算卡,這是第一款採用MCM多晶片封裝的GPU,是首款百億億級的GPU加速器。事實上,在Instinct MI200系列還沒有發布之前,就已經傳出了Instinct MI300系列的消息了,近期還出現在了Linux修正檔里。

據VideoCardz報導,Instinct MI300系列GPU可能會提供多種規格,配備的HBM3顯存堆棧可能分別會從兩個到八個。值得注意的是,Instinct MI300系列GPU可能會採用3D晶片堆疊,在小晶片的下方會有一個帶I/O接口的基礎模塊。據稱,每個基礎模塊可以連接兩個HBM3顯存堆棧,採用6nm工藝製造,而計算模塊則採用5nm工藝製造。

集成了計算模塊和基礎模塊的單一小晶片的尺寸大概在110mm² 左右,擁有四個小晶片的頂級型號的中介層將有約20000個信號引腳,相比M1 Ultra多出了一倍。功耗方面,一個小晶片大概是150W,最高端的型號的功耗將達到600W左右,與目前OAM規格的Instinct MI250X的560W相近。 ...

AMD推出Instinct MI210加速器,PCIe擴展卡外形提供Exascale級技術

AMD Instinct 200系列加速器又添新陣容,今天AMD宣布正式發布AMD Instinct生態系統,其中包括全新AMD Instinct MI210加速器,AMD Instinct MI210加速器屬於AMD Instinct 200系列中較入門的規格,所以這次可以做到PCIe擴展卡的外形。

AMD Instinct MI210加速器基於AMD CDNA 2架構,具有104個計算單元,共有6656個流處理器,配備64GB的HBM2e

ECC

顯存,顯存帶寬可達1.6 TB/sec。AMD Instinct MI210加速器的FP64 | FP32 Vector峰值性能可達22.6 TF,FP64 | FP32 Matrix峰值性能可達45.3...

Instinct MI300系列或首次出現在Linux修正檔,AMD下一代怪獸級計算卡

AMD在去年年末,推出了基於CDNA 2架構的Instinct MI200系列計算卡,這是第一款採用MCM多晶片封裝的GPU,是首款百億億級的GPU加速器。在Instinct MI200系列還沒有發布之前,其實已經有報導指出,Instinct MI300系列已經在路上了。

近日有網友指出,最新的Linux修正檔里包含了一個AMD未發布的產品,名為GFX940,支持所有針對數據中心的功能,與Instinct MI200系列GPU的型號(GFX90a)非常相似。盡管型號上相似,但與代號Aldebaran的CDNA 2架構GPU相比存在一些差異,推測很可能是下一代基於CDNA 3架構的Instinct MI300系列。

傳聞Instinct MI300系列GPU會有四個計算模塊(GCD),如果按照Instinct MI200系列GPU的規模計算,將會有440個CU,28160個內核,並沿用MCM封裝技術。據稱CDNA 3架構並不是從CDNA 2架構遷移後做細微的修正,而是修改過的新架構,GPU最終布局與RDNA 3架構類似,但是會針對HPC細分市場做優化。 ...

AMD Instinct MI210計算卡現身,將用於芬蘭的LUMI超級計算機

在2020年10月末,HPE(惠普企業)宣布贏得了一份價值1.6億美元的訂單,將在芬蘭打造一台名為LUMI的超級計算機,以支持十個歐洲國家的科研工作。LUMI是基於AMD EPYC處理器和Instinct計算卡打造,的理論峰值將超過此前位居世界第一的Fugaku超算系統,達到了0.55 ExaFLOPS。

近日,一位參與LUMI的超級計算機建造工作的工程師發了一條推文,表示AMD已開始出貨用於高性能計算(HPC)的Instinct MI210計算卡。要知道AMD至今都沒有正式確認這款產品,也沒有透露具體的參數規格。

據這位來自芬蘭CSC–IT科學中心的工程師透露,Instinct MI210計算卡為PCIe擴展卡形態,採用CDNA 2架構,擁有104個CU,即6656個流處理器,配備了64GB的HBM2e顯存。Instinct MI210計算卡看起來與AMD之前發布的Instinct MI250X並不相同,並沒有採用MCM多晶片封裝,應該只有一個計算模塊晶片。

由於缺乏具體數據的支撐,現在無法完全確定Instinct MI210計算卡的性能。如果參考此前同為CDNA 2架構的Instinct MI250/MI250X計算卡,Instinct MI210應該強於AMD以前的Instinct MI100,很可能也強於英偉達A100 PCIe計算卡。或許AMD會在LUMI超級計算機項目正式完成後,公布Instinct MI210計算卡的相關數據。

按照LUMI超級計算機的時間表,2021年第四季度內將完成第二階段的建造計劃。 ...

AMD公布Instinct MI250X與NVIDIA A100對比測試數據,有絕對性能優勢

幾天前,AMD宣布推出基於CDNA 2架構的Instinct MI200系列計算卡,這是第一款採用MCM多晶片封裝的GPU,是首款百億億級的GPU加速器。更出人意料的是,AMD現在還公布了與競爭對手英偉達A100計算卡之間的對比測試數據。雖然硬體公司在一些活動上展示性能優勢的PPT並不少見,但官網上公開詳實的實際對比測試數據卻不多,這說明了AMD對自己的這款產品在性能方面非常有信心。

AMD Instinct MI200系列計算卡搭載了代號Aldebaran的GPU,擁有580億個電晶體,採用台積電6nm工藝製造,搭配了128GB的HBM2e顯存(總帶寬3.2 TB/s),TDP為560W。該系列有Instinct MI250和Instinct MI250X兩款產品,分別有208個CU(13312個流處理器)和220個CU(14080個流處理器)。

其GPU中的小晶片輔以XGMI內部互聯設計,均具有VCN 2.6控制器,還使用了2.5D Elevated Fanout Bridge(EFB)封裝技術。此外,GPU里的兩個小晶片通過AMD Infinity Fabric技術連接,提供高達100 GB/s的雙向帶寬。這屬於第三代nfinity Fabric技術,可管理多達8條Infinity Fabric鏈路,將Instinct MI200系列計算卡和第三代EPYC處理器相連,實現CPU和GPU記憶體一致性,最大限度提高系統吞吐量。對比上一代基於CDNA架構的Instinct MI100,基於CDNA 2架構的Instinct MI200系列計算卡在性能上提升幅度非常大。

顯然,AMD Instinct MI200系列計算卡是主要針對HPC和AI工作負載設計的。AMD官方公布的對比測試里,涉及了處理代數、物理學、宇宙學、分子動力學和粒子相互作用等項目,許多是被廣泛使用並具有行業認可的測試,例如LAMMPS和OpenMM。

不過值得留意的是,AMD缺乏關於AI基準測試的項目。在紙面上,AMD Instinct...

AMD發布Instinct MI200系列計算卡,CDNA 2架構登場

AMD宣布推出基於CDNA 2架構的Instinct MI200系列計算卡,這是第一款採用MCM多晶片封裝的GPU,是首款百億億級的GPU加速器,其中AMD Instinct MI250X是世界上最快的高性能計算機(HPC)和人工智慧(AI)加速卡。

AMD Instinct MI250X搭載了代號Aldebaran的GPU,擁有580億個電晶體,採用台積電6nm工藝製造,搭配了128GB的HBM2e顯存(總帶寬3.2 TB/s),共有220個CU(14080個流處理器),TDP為560W。GPU中的小晶片輔以XGMI內部互聯設計,均具有VCN 2.6控制器。通過2.5D Elevated Fanout Bridge(EFB)封裝技術,讓GPU的核心數量達到了上一代的1.8倍,記憶體帶寬也達到了2.7倍。

GPU里的兩個小晶片通過AMD Infinity Fabric技術連接,提供高達100 GB/s的雙向帶寬。這屬於第三代nfinity Fabric技術,可管理多達8條Infinity Fabric鏈路,將Instinct MI200系列計算卡和第三代EPYC處理器相連,實現CPU和GPU記憶體一致性,最大限度提高系統吞吐量。AMD表示,新架構的GPU可加速FP64和FP32矩陣運算,FP64理論峰值性能最高可達上一代的4倍。

Instinct MI200系列計算卡有三種配置,分別是OAM規格的Instinct MI250(208個CU)和Instinct MI250X(220個CU),以及雙槽PCIe規格的Instinct MI210。首批應用Instinct MI200系列計算卡的超級計算機有三台,分別是美國的Frontier、歐盟的pre-exascale LUMI、以及澳大利亞的Setonix。2022年第一季度的企業市場中,將會有OEM和ODM合作夥伴採用Instinct...

AMD執行長為新一代伺服器產品預熱,還與騰訊合作推出一系列產品

AMD執行長蘇姿豐博士將在即將到來的「AMD Accelerated Data Center Premier」活動中展示新款的EPYC處理器和Instinct計算卡,預計亮相的是代號為Milan-X、基於Zen 3架構和配備3D垂直緩存(3D V-Cache)技術的EPYC處理器,以及基於CDNA 2架構的Instinct MI200系列計算卡,將用於新一代伺服器平台。

近日,蘇姿豐博士在其推特帳戶上做了預熱。代號Aldebaran的CDNA 2架構是首款採用MCM封裝技術的GPU,將採用7nm工藝製造,其中Instinct MI250X會配備110個CU和128GB的HBM2E顯存。新一代產品還會採用下一代Infinity Fabric總線技術,以及支持第三代AMD Infinity架構,允許多達8路的同款GPU連接擴展到Exascale。有消息指,該款GPU還會有採用OAM規格,與目前的Instinct系列產品的PCI-Express規格並不一樣。

此外,在近期舉行的騰訊數字生態大會上,騰訊公開了三款名為是紫霄、滄海和玄靈的晶片,以應對AI、視頻和網絡處理三個不同方向的需要。除此以外,騰訊還與AMD合作,共同發布了全新的騰訊雲星星海炙熱火系異構伺服器AG251,以及星星海智慧木系GA01 GPU卡。據稱,騰訊的星星海將按照「金、木、水、火、土」元素劃分為五個系列,提供對應的產品。

騰訊和AMD這款合作的星星海智慧木系GA01 GPU卡,根據AMD官方的介紹,搭載的就是最新發布的Radeon Pro V620。AMD表示,該GPU可以同時向多個用戶提供高效、低延遲的內容流,重新定義雲遊戲。 ...

AMD將於11月8日舉辦HPC新品發布會,或涉及X3D封裝的EPYC處理器

AMD宣布將於2021年11月8日,美國東部時間上午11點,舉辦加速數據中心新品發布會,展示即將推出的EPYC系列處理器,以及Instinct系列計算卡。AMD執行長蘇姿豐博士、數據中心和嵌入式解決方案業務部高級副總裁兼總經理Forrest Norrod、以及伺服器業務部高級副總裁兼總經理Dan McNamara將在這次虛擬活動中發表演講。

據推特用戶@ExecuFix透露,這次活動上AMD可能會展示代號「Milan-X」的EPYC系列處理器,也就是採用3D垂直緩存(3D V-Cache)技術的產品。之前曝光的旗艦級新品EPYC 7773X處理器,擁有64核心和128線程,L3緩存除了本身的256MB以外,還有堆疊的512MB,總容量達到了768MB,TDP為280W,價格高達10746.99美元。

此外,還可能會有代號「Trento」的EPYC處理器,據稱這是代號「Milan」的EPYC處理器的修改版,針對HPC做了優化,將會應用於Frontier超級計算機。至於Instinct系列計算卡應該也沒什麼懸念,將搭載代號Aldebaran的CDNA 2架構GPU,這是AMD第一個基於多晶片模塊設計(MCM封裝)的產品,比英特爾Xe HPC架構的Ponte Vecchio和英偉達Hopper架構的GH100更早到來。

AMD的這次活動在英偉達GTC 2021前一天舉行,會在其官方上進行直播活動,結束後可以也可以看重播。 ...

傳AMD Instinct MI250X計算卡FP64性能大幅度提高,仍採用7nm工藝

早在今年5月份摩根大通舉行的第49屆全球技術、媒體和通信大會上,AMD執行長蘇姿豐博士已確認,已確認代號Aldebaran的CDNA 2架構GPU將會在年內推出。AMD為美國能源部的橡樹嶺國家實驗室(ORNL)打造的百億億級超級計算機Frontier,就會使用這款Instinct計算卡。

近日,推特用戶@ExecuFix透露,基於CDNA 2架構的新款GPU將採用7nm工藝製造,而且傳聞中的Instinct MI200系列計算卡會有兩款產品,分別是Instinct MI250和Instinct MI250X。其中Instinct MI250X將會配備110個CU和128GB的HBM2E顯存,頻率為1.7 GHz,TDP為500W。由於這款GPU會採用MCM封裝技術,不確定110個CU是指單個計算模塊,還是兩個計算模塊的總和。新一代產品還會採用下一代Infinity Fabric總線技術,以及支持第三代AMD Infinity架構,允許多達8路的同款GPU連接擴展到Exascale。

此外還提供了部分數據,Instinct MI250X計算卡的單精度(FP32)/雙精度(FP64)計算性能為47.9 TFLOPs,半精度(FP16/BF16)計算性能為383 TFLOPs,其中FP64計算性能是Instinct MI100計算卡的4.16倍。作為參照,英偉達A100 80GB版的FP64、FP32和FP16計算性能分別為19.5 TFLOPs、156 TFLOPs和312 TFLOPs,相信雙方很快又會有新一輪的交鋒。 ...

AMD Instinct MI300計算卡或會有Exascale APU模式,將CPU和記憶體一起封裝

AMD在下一代桌面平台和伺服器平台將分別採用AM5(LGA 1718)和SP5(LGA 6096)插座,雖然距離新款Zen 4架構處理器的發布還有好一段時間,但基本沒有太多疑問,甚至有CPU散熱器廠商已做好了配套的產品。不過近期推特用戶@ExecuFix發現,AMD還有一款稱為「SH5」的新伺服器插座,其CPUID為0xA80F00,代號為「MI300」。

這樣的名字讓人很容易聯想到Instinct MI系列產品,這是AMD的計算卡產品線。據了解,AMD基於CDNA 2架構GPU(代號Aldebaran)的計算卡是Instinct MI200,要到今年年末才會推出,而Instinct MI300計算卡應該是CDNA 3架構的產品,至少在這基礎上再晚一年。此前的消息指,其GPU仍然會沿用MCM封裝技術,集成的計算模塊將由兩個提高到四個。

ExecutableFix指出,使用SH5插座的產品很可能還包含Zen 4架構CPU。如果將時間再拉回到大約兩年前,推特用戶@KOMACHI_ENSAKA曾發現「MI200」的BIG APU模式。據VideoCardz報導,此前AMD曾發表一篇論文,名為「百億億次計算APU的設計與分析」,里面就討論了一種高性能的晶片設計,里面會包含CPU晶片、GPU晶片和HBM記憶體堆棧。

這可能意味著,所謂的「MI300」不但不再局限於PCIe擴展卡的形式,而且可能將CPU模塊與GPU模塊及記憶體一起封裝。比如在搭建超級計算機的時候,每個節點不再單獨安裝CPU和GPU甚至記憶體,直接用SH5插座的「MI300」代替。 ...

AMD Instinct MI300仍將採用MCM封裝技術,或具有4個計算模塊

此前Coelacanth's Dream通過Github上提交的信息,根據代碼推算出代號Aldebaran的CDNA 2架構GPU可能的配置規格。結合更早之前的信息,Instinct MI200計算卡每個計算模塊的CU數量應該是128個,其中會開啟110個,再通過MCM(Multi-Chip-Module)封裝技術,那麼一塊Instinct MI200計算卡將配置220個CU。當然,也有可能採用全新的架構設計,每個計算模塊的開啟的CU數量為55個,整塊計算卡配置110個CU。

無論如何,根據AMD執行長蘇姿豐博士在今年5月份摩根大通舉行的第49屆全球技術、媒體和通信大會上的發言,基於CDNA 2架構的新產品會在今年內推出。除了MCM封裝技術,新一代產品還會採用下一代Infinity Fabric總線技術,以及支持第三代AMD Infinity架構,允許多達8路的同款GPU連接擴展到Exascale。

Instinct MI200計算卡尚未露面,但Instinct MI300計算卡已經在路上。據推特用戶@Kepler_L2透露,Instinct MI300計算卡GPU的規模將在Instinct MI200計算卡基礎上翻倍。AMD仍然會沿用MCM封裝技術,並會集成更多的計算模塊,CDNA 3架構的GPU或許會有四個計算模塊。暫時還不清楚Instinct MI300計算卡的GPU代號,應該也會採用巨型星球的名字。 ...

AMD Instinct MI200計算卡或會配置220個CU,將用於美國新一代超算

在今年5月份摩根大通舉行的第49屆全球技術、媒體和通信大會上,AMD執行長蘇姿豐博士已確認,已確認代號Aldebaran的CDNA 2架構GPU將會在年內推出。據Coelacanth's Dream報導,近期Github上提交的信息泄露了CDNA 2架構GPU可能的配置規格。

代碼里列出了GFX906_60、GFX908_120和GFX90A_110,這應該是AMD Instinct系列計算卡的產品線。其中GFX906_60和GFX908_120對應的應該是Instinct MI60和Instinct MI100兩款產品,尾部的數字標示的是GPU提供的CU數量。此前傳言CDNA 2架構GPU的內部代號為GFX90A,所以代碼里GFX90A_110對應的就是CDNA 2架構的晶片,提供了110個CU。由於新一代產品會採用MCM(Multi-Chip-Module)封裝技術,Instinct MI200計算卡將會有兩個「計算單元」,完整解決方案會提供220個CU。

這些代碼里標示的CU數量不代表GPU的完整配置,為了有更好的良品率,以確保供應數量,AMD會禁用部分的CU。據了解,Instinct MI200計算卡每個「計算單元」的CU數量應該是128個。假設Instinct MI200計算卡配置了220個CU,核心頻率為1500 MHz,那麼單精度計算性能就為42.2 TFLOPS,是目前Instinct MI100計算卡的1.82倍。傳聞Instinct MI200計算卡增加了對全速率FP64計算能力支持,對應的性能可能是Instinct MI100計算卡的兩到四倍,這意味著在一些HPC工作負載中會有更好的表現。

除了MCM封裝技術,新一代產品還會採用下一代Infinity Fabric總線技術,以及支持第三代AMD Infinity架構,允許多達8路的同款GPU連接擴展到Exascale。Instinct MI200計算卡將會用於美國新一代超級計算機,比如橡樹嶺國家實驗室的Frontier,以及勞倫斯利弗莫爾國家實驗室的El Capitan。 ...

AMD Instinct MI200將會配備256個CU和128GB HBM2e

AMD執行長蘇姿豐博士在上個月摩根大通舉辦的第49屆全球技術、媒體和通信大會上,已確認代號為Aldebaran的CDNA 2架構GPU將會在年內推出。這款很可能名為Instinct MI200的計算卡,是專門為計算密集型和HPC工作負載而設計。

今年即將交付的美國能源部Frontier E級超級計算機將會使用這款計算卡,傳聞Instinct MI200計算卡擁有128GB的HBM2e顯存。此前通過AMD64 EDAC驅動的Linux更新修正檔,已確認Instinct MI200計算卡會採用MCM(Multi-Chip-Module)封裝技術,在單晶片封裝里使用了兩顆計算晶片,並通過下一代Infinity Fabric總線技術互連。

近日,推特用戶@Locuza_介紹了相關的細節,Instinct MI200計算卡的每個計算晶片支持全速率FP64/FP32和第二代矩陣引擎(用於矩陣乘法的硬體,加速DNN構建、訓練和AI推理),擁有128個CU即8192個流處理器,那麼一張計算卡就有256個CU即16384個流處理器。不過Instinct MI200計算卡會將部分CU屏蔽,實際上只會用到224個CU即14336個流處理器,數量相比完整核心少了14%左右。

同時每個計算晶片都會支持VCN 2.6和SDMA(系統直接記憶體訪問),配備獨立的PCIe接口和XGMI,並配置了4096位的HBM2e顯存接口,對應64GB顯存。假設AMD使用SK海力士速率為3.6Gbps的最新款HBM2e顆粒,將為GPU提供3.64 TB/s的帶寬。由於使用的是帶ECC的顯存,因此部分帶寬和容量會被用於糾錯,實際容量並沒有128 GB那麼多。 ...

AMD確認搭載CDNA 2架構GPU會有兩個晶片,基本確認採用MCM封裝

在此前摩根大通舉行的第49屆全球技術、媒體和通信大會上,AMD執行長蘇姿豐博士簡要地提到了CDNA 2架構及其產品,表示會在年內推出。據之前的傳言,CDNA 2架構GPU的代號為Aldebaran,搭載該GPU的產品很可能是傳聞已久的Instinct MI200計算卡,專門為計算密集型和HPC工作負載而設計。

在最近的Linux內核更新中,AMD工程師確認即將到來的CDNA 2架構GPU將會有兩個晶片。很早就有消息指,CDNA 2架構GPU將採用MCM(Multi-Chip-Module)封裝技術和下一代Infinity Fabric總線技術。其競爭對手,英偉達Hopper架構以及英特爾Xe-HP架構的GPU,大機率都會採用MCM封裝技術。

據VideoCardz報導,代號為Aldebaran的GPU有兩個計算晶片,在Linux更新中被稱為die 0和die 1,而AMD工程部門表示只有主晶片會處理電源的數據,不會通過副晶片去設置,這也最終證實了會有兩個晶片。這意味著主晶片會調節整個計算部分的功耗和相關限制,暫時不清楚顯存是否也是由這個晶片調控,或者加入新的I/O模塊去調節。

代號Aldebaran的GPU如何利用MCM封裝技術目前也不清楚,但肯定和以往有很大的不同。雙晶片配置會需要一個互聯晶片,這也會增加封裝的尺寸,AMD可能會在全面邁向多計算晶片前做不同的嘗試。事實上AMD從來沒有公開確認過CDNA 2架構GPU會採用MCM封裝技術,然而會通過很多側面介紹和稱呼以表明其技術特徵。

AMD Instinct MI200計算卡預計會在今年第四季度推出,可能會採用5nm工藝製造。 ...