“天空為什麼是藍的?螢火蟲為什麼可以發光?為什麼雙眼總是一起轉動?”面對小朋友的十萬個為什麼,父母、老師總會藉助儲備的知識,或者查閱書籍解答疑問。

但隨著內容的爆發性增長,想要得到一個問題精準的答案難度越來越大。

早年使用網上購物平台的用戶,需要一步步根據商品的分類搜索,才能在海量的商品中找到適合自己的商品。

2022年的雙十一,普通的消費者不僅可以輕輕松松就篩選出自己想要的商品,還會收到非常符合自己喜好的商品、直播的推薦。

這背後隱藏了推薦系統的變遷,在小朋友問父母問題的場景里,父母其實就充當的是小朋友的推薦系統,但普通人的知識儲備畢竟有限。網際網路時代,有了搜尋引擎,但還不足夠。

再後來,AI技術的興起,幫助了推薦系統大步前進,無論是購物平台的商品推薦,直播平台的主播推薦,還是視頻平台的視頻內容推薦,越來越多的人開始感嘆,AI更懂自己。

AI推薦系統,也默默成為了網際網路公司業務中重要的組成部分。數據顯示,在一些全球大型在線網站上,即使推薦內容的相關性僅提高 1%,其銷量也會增加數十億,AI推薦系統無疑是藏在眾多網際網路應用背後的高價值系統。

不過,高價值的AI推薦系統目前還有被少數公司負擔得起,如何才能實現AI推薦系統的普及?我們又合適才能擁有完美的AI推薦系統呢?

推薦系統背後的算力演進

推薦系統並不新鮮,網際網路公司們為了能夠提升業績和客戶滿意度,十多年前就開始了推薦系統的研究與應用,早年間他們採用傳統的方法,比如協同過濾等,CPU也足以滿足那時推薦系統的需求。

但隨著推薦系統應用需求和算法的演進,系統越來越復雜,需要更加強大的底層算力作為支撐,推薦系統的開發者發現一個問題,通信節點間的性能遇到了瓶頸。

也就是說,在伺服器達到一定的規模之後,繼續增加伺服器的數量已經很難提升推薦系統的效果。

這就促使推薦系統的推動者們尋找更強大且更合適的算力支撐。當然,這個過程中還有一個重要的推動力——AI。在推薦系統中引入AI之後,能夠增加推薦系統的效果,但與此同時也讓推薦系統變得越來越復雜。

一個典型的推薦系統,包含了召回、過濾等過程,AI的引入,需要使用越來越多的數據進行訓練,以達到預期的效果。

“推薦系統中引入深度學習之後,大家還是會習慣性先用CPU,但後來發現在深度學習的算法里多加幾層神經網絡可能就算不動了。”

NVIDIA亞太區開發與技術部總經理李曦鵬在2022雲棲大會期間對雷峰網說,“GPU此時有明顯的優勢,GPU的算力遠高於CPU,同時GPU的帶寬比CPU高非常多,我們的Hopper架構GPU的帶寬已經達到3TB / s。”

但要加速推薦系統,不止是從CPU遷移到GPU這麼簡單。

GPU如何加速AI推薦系統?

推薦系統中AI的引入,讓推薦系統變得更加復雜的同時,對算力的需求也呈現出指數級的上升。

在推薦系統中,有大量的嵌入表(Embedding),包含各種推薦系統所需的特徵,比如性別、年齡等等,嵌入表被用於將輸入數據中的離散特徵映射到向量,以便下游的神經網絡進行處理,大小可以達到TB級。

嵌入表通常是記憶體帶寬和容量密集型,對於計算的需求不大,需要很大的內容容量和帶寬進行快速讀取,這對於CPU而言是一個明顯的挑戰。

此時,採用GPU有兩個顯著的優勢,李曦鵬說:“一個是GPU的記憶體帶寬遠高於普通伺服器,另一個是遷移之後將原來節點上的通信從原來CPU和GPU的PCIe通信,變成了GPU和GPU之間的NVLink通信,速度提升幾倍。”

接下來,就需要用AI模型進行計算,此時可能是計算密集也可能是記憶體帶寬密集。更麻煩的是,由於模型越來越大,超出了GPU板載的存儲容量,沒辦法存儲完整的模型,需要把它分塊,嵌入表就需要做模型並行,而DNN部分需要數據並行。在這個過程中,從模型並行到數據並行,需要做非常多數據交換,成了大量計算節點間密集的通信。

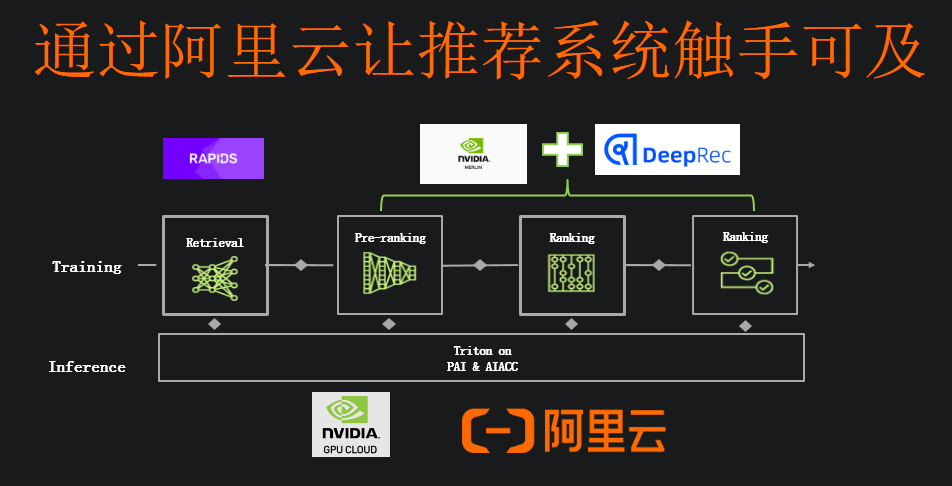

“推薦系統需要的不僅僅是GPU,而是加速計算。”李曦鵬指出,“加速計算不是一個簡單的晶片或者硬體,而是一個包含硬體、軟體以及上層應用的一整套解決方案。”

比如英偉達為推薦系統推出的NVIDIA Merlin。在預處理方面,NVIDIA Merlin NVTabular可以實現加速。

針對嵌入表,Merlin Distributed-Embeddings可以方便TensorFlow 2 用戶用短短幾行代碼輕松完成大規模的推薦模型訓練。並且,NVIDIA Merlin Distributed-Embeddings 的性能表現也十分突出,DGX-A100上的Merlin Distributed-Embeddings 方案比僅使用 CPU 的解決方案實現了驚人的683倍加速。

NVIDIA Merlin還有HugeCTR的開源框架,目標是優化 NVIDIA GPU 上的大規模推薦。

也就是說,NVIDIA Merlin是一個針對推薦系統,近似於一個端到端的解決方案。

即便如此,推薦系統的普及依舊面臨著巨大的挑戰。

普及推薦系統的兩大挑戰

推薦系統作為高價值的AI系統,普及面臨的兩大挑戰就是差異化以及高門檻。

“我們充分理解,由於業務的不同於推薦系統有很大的差異,我們會盡量把NVIDIA Merlin的功能進行模塊化,客戶可以根據需求選擇不同的模塊,使用的模塊越多,效果也會更好。”李曦鵬說,“我們通過Merlin的模塊化解決問題的同時,也通過和像阿里雲這樣的雲計算服務商合作推動推薦系統的普及。”

不同的推薦系統使用的算法並不相同,雖然如今AI大模型的應用越來越廣泛,並且大模型在美國人工智慧學術界將其稱為基礎模型(Foundation Model),但這並不意味著所有推薦系統都需要使用大模型。

李曦鵬的觀點是,大模型提供一個更大的嘗試空間,其表徵能力也更強,所以主流公司的模型越來越大,但主流公司也會有一些小的業務,或許也會有一些小的模型。如今主流的公司已經過渡到了GPU方案,比較重點的業務是全GPU的解決方案。所以,在算法上,即便主流公司也有階梯。

“先進模型對於中小企業來說收益可能沒那麼大,因為他們的業務體量沒那麼大,而通過雲計算的方式,以及GPU的解決方案,可以幫他們降低門檻和成本。”李曦鵬進一步表示。

差異化需求之外,推薦系統普及的另一大挑戰就是高門檻。

“網際網路巨頭有成百上千人的團隊在做推薦系統,中小企業很難投入這麼多。

但通過我們和阿里雲這樣有能力的雲服務提供商合作,給中小公司開放一些更高級的API,有一些預定義的模型能夠實現不錯的推薦系統,投入一兩個數據科學家,這將有利於推薦系統的普及。”李曦鵬說。

推薦系統的普及,將能夠代表加速計算巨大的想像空間。

10年100倍,加速計算價值千億的巨大空間

過去幾十年間,得益於摩爾定律,算力在持續增長。但如今摩爾定律已經放緩,從最初每年1.5倍性能的提升,下降到如今每年1.1-1.2倍的提升。摩爾定律帶來的算力提升已經難以滿足包括推薦系統在內應用對算力指數級的性能增長需求。

“接下來的十年,所有的計算任務都將被加速。我們已經加速了世界上5%的計算任務——價值百億美金。加速計算會降低計算任務的成本,提高能源利用率,給工業界帶來更多的能力做更多的事情。”英偉達CEO黃仁勛在今年十月時表示。

僅看推薦系統,Mordor Intelligence 發布的數據指出,推薦系統整體市場將從2020 年僅為 21.2 億美元提升至2026年的 151.3 億美元。加速計算顯然具有數千億的市場空間,但要加速如此之大的市場,需要性能的持續提升。

加速計算的目標是保持每年1.6-1.7倍的性能增長,5年可以實現10倍的性能提升,10年就可以實現100倍的提升,這與摩爾定律10年可以實現的4倍性能提升形成了顯著的差異。

前面已經提到,加速計算不止是從硬體的層面實現性能的提升,更加強調從硬體到軟體再到應用的加速,實現性能的飛躍。

實際上,加速計算的價值已經在AI應用中體現出來,以前訓練一個AI模型,周期以周來計算,調整模型訓練至少又得等一周,而現在,即便模型越來越大,訓練一個模型的時間也只需要幾分鍾了。

“幾年前難以訓練的大模型,早已成為了過去式。更多更大規模的工作負載等著去加速。”李曦鵬對於加速計算能夠實現目標也十分有信心。雷峰網

雙11紅包活動推薦:

來源:快科技