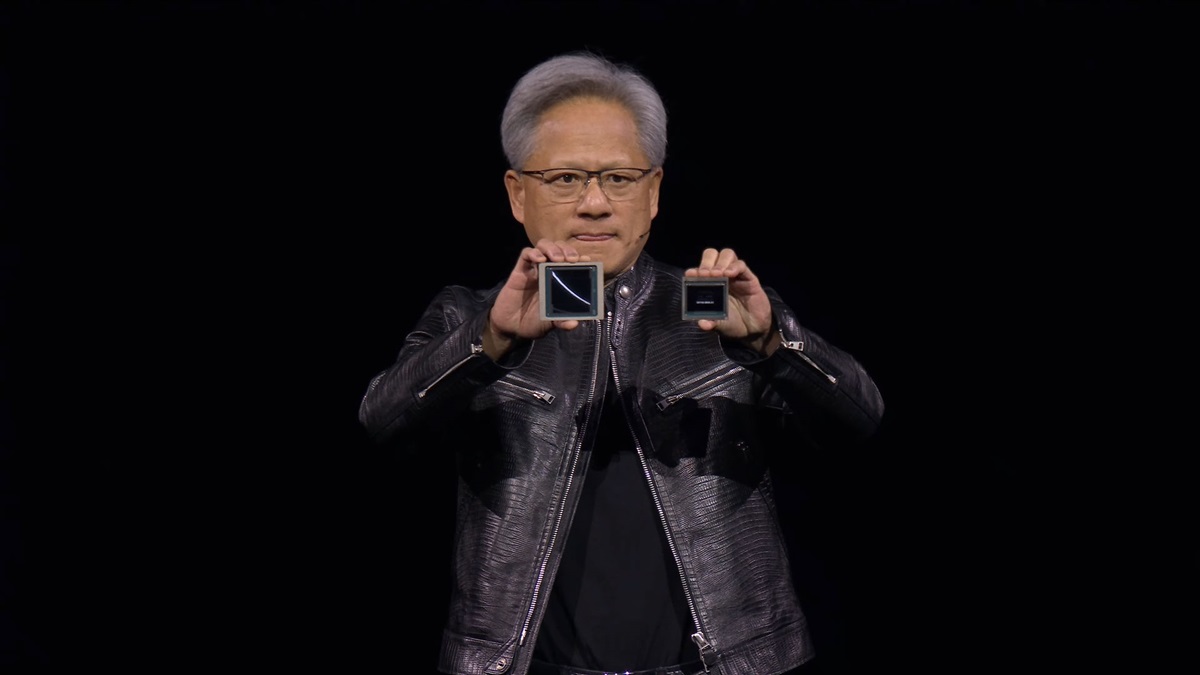

在美國加州聖何塞會議中心舉行的GTC 2024大會上,英偉達創始人兼CEO黃仁勛英偉達創始人兼CEO黃仁勛帶來了Blackwell架構GPU,包括用於取代H100/H200的B200 GPU,另外還有與Grace CPU相結合的GB200。

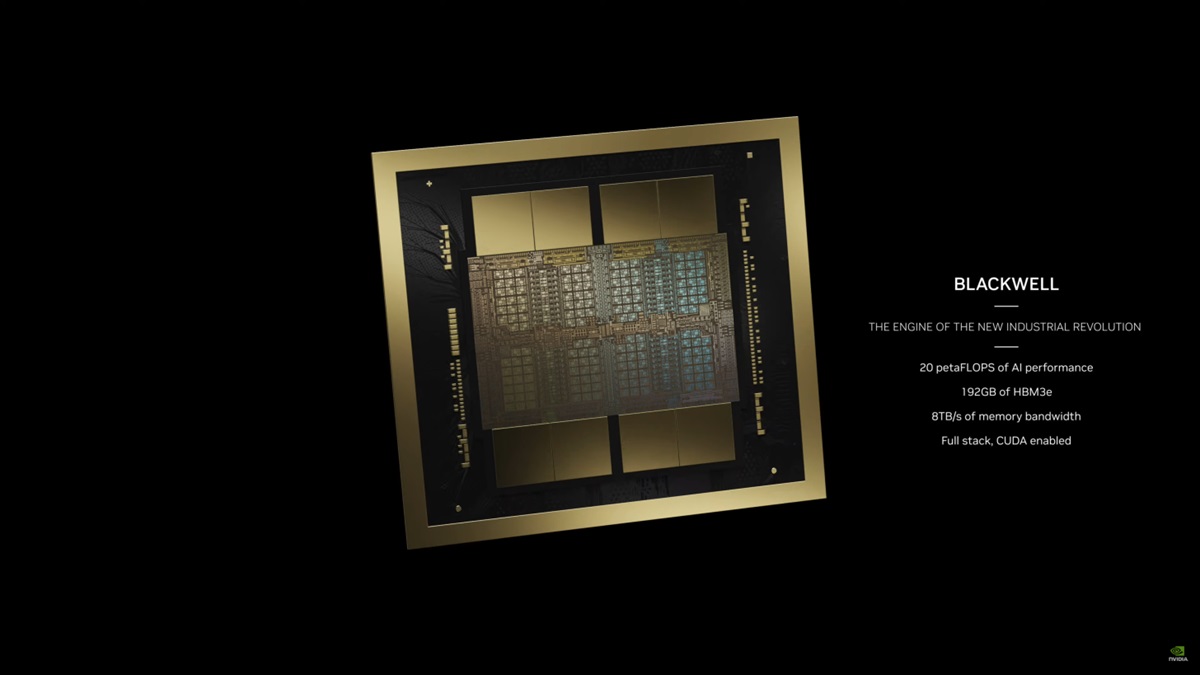

B200採用了台積電(TSMC)改進的4NP定製工藝製造,整合了兩個獨立製造的Die,共有2080億個電晶體,將使用新的NVLink 5.0技術來連接兩塊晶片。其擁有160組SM,對應20480個核心,搭配的使192GB的HBM3E,提供了高達8TB/s的帶寬,功耗達到了700W。B200單個GPU提供了20 petaflops的AI性能,大概五倍於H100的4 petaflops。由於引入了第二代Transformer引擎,將有助於自動將模型轉換為適當的格式以達到最佳性能。此外,Blackwell架構GPU還支持新的FP6格式,這是一種介於FP4和FP8兩者之間的解決方案。

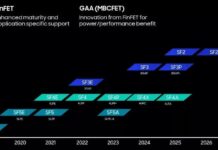

暫時還不清楚台積電4NP工藝的細節,但密度方面應該不會有明顯的提升,而之前的H100基本上已經是一個完整的掩模版,晶片尺寸為814mm2,而理論最大值為858mm2。為此B200使用了兩個全尺寸掩模版製造的晶片,每個對應四個HBM3E堆棧,每個堆棧的接口為1024-bit、容量為24GB、帶寬為1TB/s。相比之下,每個H100晶片對應六個HBM3接口,意味著B200每個晶片可以減少記憶體控制器所需要的晶片面積,從而將更多的電晶體用於計算單元。此外,用於兩個晶片互連的NV-HBI接口也會占用一些空間。

英偉達的Superchip被設計為人工智慧(AI)和高性能計算(HPC)工作負載的典型平台,這次將Blackwell架構GPU與Grace CPU結合推出了GB200 Grace Blackwell Superchip。其配備了兩個B200 GPU和一個Grace CPU,後者配有72核心的Arm Neoverse V2內核,可配置TDP高達2700W。新平台提供了40 PetaFlops的計算性能 (INT8),並擁有864GB的龐大記憶體池,HBM3E具有16TB/s的記憶體帶寬,晶片之間通過3.6TB/s帶寬的NVLink進行互連。

英偉達還帶來了全新的GB200 NVL72計算平台,這是一個全機架解決方案,有18個1U伺服器。其提供的FP8性能為720 petaflops,FP4計算性能為1440 petaflops,可處理多達27萬億個AI LLM參數模型。每台伺服器里帶有兩個GB200 Grace Blackwell Superchip,合計共有36個Grace CPU和72個Blackwell GPU。這些計算節點帶有1.7TB的HBM3E記憶體、32TB/s的記憶體帶寬,並且全部採用液冷MGX封裝。

每個機架內還有ConnectX-800G Infiniband SuperNIC,以及一個用於網絡內計算的Bluefield-3 DPU(80GB/s記憶體帶寬)。另外還會有最新的NVLINK交換機,具有8個接口,速率為1.8TB/s,總帶寬高達14.4TB/s。英偉達還推出了新款NVLink Switch晶片,擁有500億個電晶體,採用了台積電4NP工藝製造,提供了7.2TB/s帶寬,用於不同節點之間的通信互連。

英偉達通過八個GB200 NVL72計算平台,組成了新的DGX SuperPOD,合計共有288個Grace CPU和576個B200 GPU。這本身就是一台AI超級計算機,具有240TB記憶體,提供了11.5 exaflops的FP4計算能力。

英偉達通過發布Blackwell架構GPU,再次鞏固了自身在人工智慧市場的主導地位,開創了AI計算的新時代。Dell、思科、HPE、聯想、Supermicro、Aivres、華擎、華碩、Eviden、富士康、技嘉、英業達、和碩、雲達、緯創、Wiwynn和ZT Systems等OEM廠商也將在未來提供各自的解決方案。

來源:超能網