Tag: 人工智慧

AMD官宣重磅發布會 事關AI的未來

AMD官方宣布,將於2023年12月7日2點,舉辦主題為“Advancing AI”的新品發布會。

AMD表示,屆時將會展示AMD與合作夥伴如何驅動AI的未來。

看起來,這次活動的主角應該是Instinct MI300系列加速器,此前已經多次亮相,並一開始初步部署,但很多規格一直保密未公開,是時候展示完全體了。

其中,MI300X是傳統風格的純GPU加速卡,擁有史無前例的530億個電晶體,配備多達192GB HBM3內存,已於第三季度出樣。

它寄託了AMD極大的期望,將與NVIDIA、Intel正面對抗爭奪AI市場,還有望成為AMD歷史上以最快速度達到1億美元銷售額的產品。

MI300X還有個衍生版本MI300A,同樣屬於重磅級產品,是全球首款面向HPC、AI的APU融合加速卡。

它集成24個Zen4 CPU核心和數量不明的CDNA3 GPU核心,總計1460億個電晶體,還有128GB HBM3,Socket獨立封裝,已經供貨客戶。

有趣的是,AMD遊戲營銷高級總監Sasa Marinhovic也高調預告了此次活動,看起來消費級的銳龍AI引擎也會有新動向,主打端側AI,與雲端的Instinct雙管齊下。

當然,這次活動不會有常規消費級產品的更新,那要等到明年初的CES 2024。

PS:這次大會,文Q會繼續在現場給大家帶來一手報導!

來源:快科技

AMD戰略「放棄」遊戲卡 MI300X AI加速卡最快速度賺到1億美元

如今無論是NVIDIA還是AMD,都不約而同地降低了遊戲顯卡的優先級,將更多精力投入AI加速計算卡。

無它,皆為利往。

AMD在發布第三季度財報後就明確表示,Instinct MI300X加速卡有望成為AMD歷史上以最快速度達到1億美元銷售額的產品。

NVIDIA目前在AI加速卡市場上處於近乎壟斷地位,畢竟硬體強大,軟體生態也好用,但受制於有限的產能、高昂的價格,不少客戶開始尋找替代方案,Intel、AMD都是可選項,尤其是AMD Instinct系列硬體越來越強大,開發平台也逐漸成熟起來。

MI300X是純GPU加速卡,擁有史無前例的額530億個電晶體,配備多達192GB HBM3內存,已於第三季度出樣,寄託了AMD極大的期望。

它還有個衍生版本MI300A,是全球首款面向HPC、AI的APU融合加速卡,集成24個Zen4 CPU核心和數量不明的CDNA3 GPU核心,總計1460億個電晶體,還有128GB HBM3,Socket獨立封裝,已經供貨客戶。

與NVIDIA類似的是,AMD也把GPU產能優先分配給了Instinct系列。

至於遊戲卡,RX 7900 XTX可能會是很長一段時間AMD的卡皇,或許有升級版RX 7950系列,但是下一代RX 8000系列將不會有旗艦卡。

AMD CEO蘇姿豐表示,數據中心GPU將在2023年第四季度給AMD帶來約4億美元的收入,2024年隨著大量產品鋪貨,收入將超過20億美元。

這得賣多少遊戲卡才能賺到啊!

來源:快科技

NVIDIA AI加速卡漲到43萬元 還得等1年 韓國Google被嚇跑

NVIDIA AI GPU無疑是當下的搶手貨,但一方面產能嚴重不足,另一方面價格不斷飆升,讓不少客戶望而卻步。

當然,NVIDIA並不是唯一的選擇,Intel、AMD也都有類似的方案。韓國頭號搜尋引擎Naver最近就轉投了Intel。

Naver原本使用NVIDIA GPU來訓練自己的Place AI地圖平台,但是NVIDIA AI加速器的價格已經翻番漲到8000萬韓元,折合人民幣超過43萬元,而且交貨周期長達52周,也就是現在下單一年後才能拿到貨。

無奈之下,Naver改而使用Intel Sapphire Rapids五代至強處理器進行相關工作。

經過一個月的測試,Naver對效果非常滿意,而且可以隨時交貨,價格也合理。

目前,NVIDIA AI加速器的產能瓶頸主要在於台積電封裝。

為了解決這個問題,台積電已經宣布將投資28.9億美元(約合人民幣210億元),擴建封裝生產線,同時對於封裝設備的采購訂單也增加了30%。

來源:快科技

Intel加速開啟AI PC新時代 100+夥伴、300+功能惠及上億PC

Intel將在12月14日正式發布代號Meteor Lake的全新一代酷睿Ultra處理器,正式開啟AI PC的新時代。

現在,Intel面向全球正式啟動了“AI PC加速計劃”,以鼓勵AI應用的創新,加速AI在消費級客戶端市場上的落地和普及,預計到2025年將惠及上億台PC。

在以ChatGPT為代表的全新體驗模式的推動下,生成式AI(AIGC)正在顛覆無數用戶的工作、生活、娛樂體驗。

AI、ML算法增強的軟體功能越來越豐富、強大,讓藝術創作、音樂製作、分享知識、智慧辦公都變得與以往截然不同。

擁有廣泛群眾基礎、豐富應用場景的PC,無疑是AIGC的最佳載體,也將成為PC產業的轉折點。

作為PC行業領頭羊的Intel,更是當仁不讓地將AI融入旗下每一款產品,構建了CPU、GPU、NPU聯合組成的PC AI加速架構和豐富的開發工具,並聯合整個行業優化AI軟體的功能、效率和能效。

尤其是酷睿Ultra,首次集成獨立的NPU AI硬體單元,可以從CPU、GPU接手持續的、低負載的AI工作,通過專門功能硬體高效運行,而且功耗極低。

NPU還可以和CPU、GPU配合,各自承擔不同的任務,綜合起來大大節省所需時間和功耗,效率可以做到CPU的多達5倍、GPU的接近2倍。

Intel AI PC加速計劃,旨在聯合獨立硬體供應商(IHV)、獨立軟體供應商(ISV),並充分利用Intel在AI工具鏈、協作共創、硬體、設計資源、技術經驗、共同推廣的市場機會等資源,充分發揮酷睿Ultra處理器的硬體和技術優勢,最大化釋放AI、ML應用的性能,讓AI PC真正惠及用戶、提升體驗。

Intel認為,軟體領導力是AI PC體驗的關鍵,Intel也將憑借自己在PC產業的獨特地位,引領產業向前,推動豐富的AI PC應用案例和體驗。

AI PC加速計劃將根據ISV的需求、核心開發工具、OpenVINO等SDK開發工具包,以及市場機會等,提供大量工程人才,幫助合作夥伴進行軟體的優化和調優工作,充分調動AI潛力。

目前,Intel AI PC計劃的ISV合作夥伴已經超過100家,包括:

Adobe、Audacity、BlackMagic(DaVinci Resolves)、BufferZone、CyberLink、DeepRender、Fortemedia、MAGIX、Rewind AI、Skylum、Topaz、VideoCom、Webex、Wondershare Filmora、XSplit、Zoom等等。

同時,已開發的AI加速功能更是超過了300項,涉及在音頻效果、視頻協作、內容創建、遊戲、安全、直播等諸多方面。

此前在9月底的技術創新大會上,Intel曾公開介紹了多項AI PC用戶案例,多家創新公司正在打造新的應用模式,尤其是無需網絡和雲端,離線本地化的AI體驗,擁有廣闊的應用前景

其中,Audacity展示了基於AI PC的音頻編輯創作加速,無論人聲分離,還是音頻混剪,都可以獲得極大的性能提升。

Rewind則展示了利用AI PC,在沒有網絡連接和雲側AI支持的情況下,在本地離線運行人機對話、問答檢索、視頻內容搜索、內容要點提煉等工作。

其他合作方面,Bufferzone是一款安全沙盒工具,通過Intel NPU直接運行深度學習,有助於更好地抵禦釣魚詐騙等惡意攻擊,減少隱私方面的擔憂,還能節省雲側AI的花費。

思科在視頻會議軟體Webex中使用Intel NPU單元和OpenVINO工具包,可提供全新媒體AI功能,提升響應能力,提高能效。

Deep Render利用酷睿Ultra,將視頻壓縮率提高了5倍多。

MAGIX正在與Intel團隊一同探索酷睿Ultra NPU的特性,優化視頻編輯工作流的能效,有助於延長筆記本續航。

XSplit正在將Intel...

AI PC:千載難逢的行業救星 Intel預計明年可達數千萬台

NVIDIA CEO黃仁勛已經被尊為“AI教父”,生成式AI(AIGC)顛覆了無數人的工作、生活體驗,但老黃的眼光和境界並不只是為了多賣幾塊GPU,他對於行業變革有著高瞻遠矚的認知,尤其是AI對於PC產業的意義。

很多人可能沒注意到,黃仁勛今年5月份參加台大畢業典禮的時候,曾在演講中說過這麼一句話:

“PC行業正迎來一次重生的機遇。在未來10年,新的AI PC將取代傳統PC,市場價值可達上萬億美元。”

正所謂英雄所見略同,Intel、AMD都在全力打造AI PC,Intel CEO帕特·基辛格就直言:“我們相信,AI PC是未來數年PC市場的關鍵轉折點,我們的每一款產品都會集成AI。”

他預計到2024年,市場上將有數千萬台支持AI的新型PC。

因此,最激動的還是PC廠商們,都在Intel的領導下積極行動起來,聯想、惠普、戴爾、宏碁等等紛紛打造自己的AI PC筆記本,並設計了各種各樣的AI應用軟體,讓用戶在日常工作、生活中感受AI帶來的變革。

惠普CEO Loures激動地表示:“我在(PC)這個行業打拚了幾十年,從未見過如此機遇。AI可以真正推動創新,滿足客戶新的需求。”

聯想楊元慶則認為:“明年,我們將會看到離線也能玩得轉的AI PC,未來將會一代一代進化,越來越聰明,更好地理解用戶,成為人們真正的可攜式伴侶。”

日前的Intel技術創新大會上,宏碁營運長高樹國就公開介紹了搭載酷睿Ultra處理器的宏碁AI筆記本,還與Intel合作通過OpenVINO工具包共同開發了一套宏碁AI庫,充分釋放平台特性,優化AI體驗。

整個PC行業如此在意AI,一方面是AIGC確實可以完全顛覆用戶體驗,尤其未來完全可以在本地離線享受各種AIGC應用。

目前,AIGC雖然可以在任何PC乃至手機上體驗,但嚴重依賴網絡和雲,依賴大規模模型訓練,而在未來,對於AI推理的算力需求將大大超過AI訓練,預計占比將達到60%,而PC正是最適合的載體。

另一方面,PC行業經歷這麼多年的發展,尤其是在當前的大環境下,正陷入非常低迷的狀態,迫切需要一劑強心劑,AI的爆發可謂恰逢其時。

最近,權威市調機構IDC、Gartner都給出了2023年第三季度全球PC市場報告,出貨量連續8個季度同比下滑,市場依然很低迷。

IDC給出的季度出貨數據是6820萬台,同比減少7.6%,螺旋式下降。

Gartner的統計數字更是只有6430萬台,同比減少多達9%。

在全球經濟環境、市場和用戶需求難以在短期內顯著改善的情況下,AI作為一個顯著的創新點,就成了刺激市場的最佳引爆點,同時它對於強大算力的需求,更是刺激了整個產業繼續加快創新速度,從而行成良性循環。

比如說Intel即將推出的代號Meteor Lake的第一代酷睿Ultra處理器,就集成了獨立的NPU AI硬體引擎,可以在本地高效執行AIGC負載,還能與CPU、GPU聯合加速,迅速得到了廣泛的生態應用支持,可謂一呼百應。

可以說,AI PC類似於Wi-Fi出現時迅馳PC的歷史轉折點,有望成為終端、邊緣計算、雲技術的混合體,滿足新的AIGC工作負載和應用的需求,從根本上改變、重塑和重構PC體驗,釋放人們的生產力和創造力。

來源:快科技

AI太火 NVIDIA躺贏 下一代GPU提前半年問世

據曝料,NVIDIA下一代Blackwell B100 GPU原計劃在2024年第四季度發布,但眼下AI需求實在是太火爆了,發布時間提前到了第二季度。

Blackwell架構將通吃高性能計算、遊戲,前者核心編號B100,後者核心編號B20x系列,當然遊戲卡不會著急,肯定要等到2025年。

還有報導稱,B100計算卡將會獨家採用韓國SK海力士的下一代HBM3e高帶寬內存。

NVIDIA已經在8月份拿到SK海力士HBM3e的早期樣品,預計明年初獲得正式版本,進行最終的質量測試。

目前,NVIDIA已經占據AI GPU市場多達90%的份額,A100、H100都是一卡難求,產能極為緊張。

來源:快科技

讓一台普通PC歡快地跑起AIGC:Intel做到了

很多人都在歡呼AI時代的到來,但其實AI這個概念早在20世紀50年代就誕生了,而且一直都在高速發展和演化,並不是什麼新鮮事物。

只不過,幾十年來,AI一直都基本停留在專業領域或者特定行業,距離普通用戶比較遙遠,一般人很難真切感受到AI的力量。

ChatGPT最大的功勞,恰恰是將AI——確切地說是生成式 AI(AIGC)——帶到了普通人的生活中。

有了ChatGPT和類似的應用,任何人只需一部普通的電腦或者手機,就能感受到AI給我們工作生活、娛樂休閒所帶來的種種便利——一問一答就能獲得自己想要的問題答案、幾分鍾就能完成一份漂亮的PPT……

另一方面,雖然這個時候幾乎人人都在談論AI,從跨國大企業到初創小公司似乎一夜之間都在完全圍著AI做事,但是正如巴菲特的那句名言:“只有退潮了,才知道誰在裸泳。”也只有經歷最初的喧囂,才能看出誰才是認真做AI,誰才真正有實力做好AI。

近日,Intel舉辦了一場年度技術創新大會,AI自然是關鍵詞中的關鍵詞,“AI Everywhere”不僅體現在整個大會上,也體現在Intel的全線產品和解決方案中,這個話題我們之前也從不同角度探討過很多次。

當然,作為軟硬體實力都在這個星球上屬於頂級行列的Intel,自然也是最有資格談論AI的巨頭之一。

正如剛才所說,AI無處不在,從產品到技術再到應用都有截然不同的豐富場景,普通用戶能夠最直接感受到的當屬AIGC,包括文生文、文生圖、圖生圖、文生視頻、圖生視頻等等。

而要想實現足夠實用的AIGC,從算力強大的硬體到參數豐富的大模型,從精確合理的算法到高效便捷的應用,缺一不可。

我們知道,在過去,AIGC更多在雲側伺服器上,雖然性能、模型、算法都不是問題,但一則需要大量的資金投入,二則存在延遲、隱私等方面的不足。

因此,AIGC正越來越多地下沉到終端側,讓普通的PC電腦、智慧型手機也能跑AIGC,甚至可以離線執行。

Intel中國技術部總經理高宇先生在接受采訪時就表示,關於終端側運行AIGC的研究已經取得了豐碩的成果,比如最新的13代酷睿電腦,經國有化已經可以流暢運行70億到180億參數的大模型,尤其是70億到130億參數的運行效果相當好。

當然這些現在還處於起步階段,目前的優化主要針對CPU處理器,下一步會充分發揮GPU核顯的性能潛力,而代號Meteor Lake的下一代酷睿Ultra除了有更強的CPU、GPU算力,還會首次集成NPU單元,一個專用的AI加速器,峰值算力超過11TOPS,三者結合可以達到更好的效果。

對於PC端側運行AIGC應用的具體落地實現,高宇舉了個例子,Intel正在打造的一個開源框架BigDL-LLM,專門針對Intel硬體的低比特量化設計,支持INT3、INT4、INT5、INT8等各種低比特數據精度,性能更好,內存占用更少。

基於這個框架,使用i9-12900K處理器,只開啟4個核心來運行ChatGLM2 60億參數模型,生成效果就是相當迅速的,而打開全部8個P核、8個E核,效果更是堪稱飛快,輸出性能達到了每個Token 47毫秒左右,已經不弱於很多雲側計算。

之所以對比兩種情況,因為有時候需要將全部算力投入AI模型的運算,而有時候可能還得兼顧其他任務。

可以看出,無論哪種情況,Intel PC側都已經可以很好地完成相應的AI工作,提供令人滿意的算力和效率。

此外,在LLaMA2 130億參數大語言模型、StarCoder 155億參數代碼大模型上,Intel酷睿處理器也都能獲得良好的運行速度。

換到Arc GPU顯卡上,Intel硬體跑端側AI同樣神速,甚至更快,無論是ChatGLM2 60億參數,還是LLaMA2 130億參數、StarCoder 155億參數,都是如此,ChatGLM2模型中甚至可以縮短到20毫秒以下。

當然,以上說的大模型可能距離普通人還有些遠,而任何一項技術要想大范圍普及,關鍵還是顛覆用戶的切身工作、生活、娛樂體驗,AI當然也不例外。

在高宇看來,基於以上大模型,AI在端側的典型應用還是相當豐富的,而且會越來越多,有時候效果會更勝於運行在雲側。

比如超級個人助手,通過低比特量化,在PC側可以獲得更好的效果。

比如文檔處理,包括中心思想提煉、語法錯誤糾正等等,PC側不僅可以很好地運行,還有利於保護個人隱私和數據安全。

再比如如今大火的Stable Diffusion和衍生模型的文生圖、文生視頻應用,PC側的算力也是足夠的。

使用Arc A730M這樣的筆記本獨立顯卡,就可以在幾秒鍾內完成高質量的文生圖、圖生圖、圖像風格轉換等,從而極大地節省工作量,將更多精力放在創意上。

這足以證明,一台普通的筆記本在端側運行大模型,使用普通獨顯甚至集顯,依然可以獲得足夠快的響應速度和良好的體驗,當然這也得益於Intel的專項優化。

當然,歸根到底,AIGC應用在PC端側的普及,離不開足夠多、足夠好用的生態軟體。

這樣的軟體,一方面可以來自各種商業軟體,他們本身就可以集成中小尺寸大語言模型,提供各種AIGC內容,一些創作軟體甚至可以集成Stable Diffusion。

另一方面可以來自各家PC OEM品牌廠商,在自己的電腦中集成專門開發、優化的AIGC軟體,預裝提供給用戶,讓AIGC真正可用。

當然,端側運行AIGC也不是萬能的,一是算力不像雲端那麼強大,二是內存有限。

目前主流內存容量還是16GB,哪怕明後年普及32GB,可以承受的模型參數量也是有限的(130億以下),這就需要進行低比特處理,比如FP16轉成INT4,還好在大語言模型中的問題回答質量只會有個位數的稍許下降,而在Diffusion模型中參數又不是很大,可以繼續跑FP16精度。

事實上,AI研究雖然已經取得相當豐富的成果,未來必然影響每個行業、每個人,但AI依然處在早期階段,廣泛的AI工作負載涉及到不同的模型規模、模型類型、整體基礎架構的復雜性,還要面臨雲側、端側、混合等不同環境的適應性,這些都要持續探索和優化。

相信隨著像Intel這樣有實力的大企業不但在AI應用上取得突破,尤其是將越來越多的AIGC應用帶到端側,讓越來越多的人感受到AI的魅力,它必然會更加廣泛、細致地深入我們的工作和生活,成為人們日常不可或缺的一部分,甚至在不知不覺中享受AI帶來的便利。

這,才是技術造福人類的本源。

(圖源:Pixabay)

來源:快科技

微軟全新人工智慧Copilot加持 Win11 23H2將於9月26日正式發布

快科技9月22日消息,微軟在昨天舉行秋季發布會,除了帶來新的Surface硬體外,重頭戲還有Win11 23H2。

在發布會上微軟宣布將於本月26日發布Windows 11的下一個大更新23H2,據介紹本次系統更新將會有超過150項新功能,包括新的人工智慧驅動的Windows Copilot功能、重新設計的文件資源管理器、針對手寫筆用戶的新Ink Anywhere功能、對畫圖應用的重大改進、原生RAR和7-zip文件支持、新的音量混合器等等。

做為本次更新的重頭戲,Copilot將集成在整個Windows作業系統中。因此Copilot不僅可以控制電腦設置、啟動應用程式或者提問問題等,還能使系統自帶軟體得到AI加持。微軟高管也是現場演示了如何通過Copilot使用日歷中的數據、Outlook中的內容編寫簡訊等功能。

此次發布的新功能Ink Anywhere也很有意思,這個功能支持用手寫筆直接書寫數學算式,然後把問題交給Copilot來解答。這就意味著不用再到處搜索數學符號怎麼打了,直接交給強大的Copilot就可以了。

微軟針對文件資源管理器也進行了重構優化,更新後的用戶界麵包括兩項,分別是帶有大文件縮略圖的現代主頁界面和可以顯示最近文件及收藏文件的輪播界面,這些改進使的文件資源管理器與Windows 11的整體設計風格更加適配。

這次更新還添加了原生RAR和7-zip支持,這意味著不需要下載第三方軟體就可以打開tar、7-zip、rar、gz等文件了。不僅如此,微軟還計劃著明年能夠支持直接創建這些文件。

此次更新還將推出全新的Windows音量混合器,控制起來更加方便快捷,可以直接從任務欄切換輸出並控制軟體音量。

對於遊戲用戶而言還有一個十分實用的新功能:原生RGB燈光控制,微軟稱之為動態照明。對於滑鼠、鍵盤、顯示器、機箱風扇或任何其他具有可控RGB照明的東西,Windows都能夠在沒有第三方應用程式的情況下控制RGB燈效。

此次的Windows 11 23H2大更新版本,帶來的新功能還有很多,感興趣的小夥伴可以等到26號的去更新體驗一下。

來源:快科技

「飢渴」的AI時代:AMD Instinct加速器面前是一條「星光大道」

AI時代最根本的是什麼?是算力。

隨著AI模型、訓練數據規模的不斷膨脹,對於算力的渴求也是空前高漲,沒有盡頭。

強大的AI算力可以來自CPU,可以來自GPU,可以來自FPGA,可以來自ASIC,各有各的優勢,其中的王者毋庸置疑就是GPU加速器。

如今的AI GPU加速器市場,呈現著明顯的“一家獨大、兩家追趕”的態勢:NVIDIA有著無可比擬的市場地位,尤其是軟體生態遙遙領先;AMD、Intel都有各自的獨特方案,也都有了不俗的成果。

NVIDIA的大家都比較熟了,Intel的才剛剛起步,今天我們重點聊聊AMD Instinct系列加速器,看看它能不能真正挑戰NVIDIA。

畢竟,任何市場領域一家獨大,都不是什麼好事兒,都需要你來我往的競爭,才是對用戶利益、對行業發展最為有利的。

AMD Instinct很多人可能不太熟悉,但其實歷史也很優秀了,可以追溯到2017年。

不過那時候,它還叫Radeon Instinct,基礎架構也是和Radeon遊戲顯卡通用的,包括Polaris、GCN、Vega,一直到2020年的RDNA都用過。

這麼做的好處是開發成本低、推進速度快,但缺點也很明顯,就是在計算方面缺乏針對性和高效率。

2020年誕生的Instinct MI100,成為這條產品線的一個轉折點,因為它首次採用了專門設計的CNDA計算架構,和RDNA圖形架構徹底分道揚鑣,同時去掉了名字中的Radeon字樣,踏上了新的征程。

2021年的Instinct MI200系列又達到了全新的高度,這是AMD第一款ExaScale百億億次計算性能級別的加速器產品,號稱在同類產品中擁有世界上最快的HPC性能、AI性能。

它升級到了第二代CDNA 2架構,首創MCM多芯整合封裝,擁有Infinity Fabric高速互連通道、矩陣核心、128GB HBM2e高帶寬內存等等,性能異常強大,浮點性能約48萬億次每秒。

該系列包括MI250X、MI250、MI210三款型號,在諸多高性能計算、機器學習、人工智慧、超級計算機中都有普遍應用。

尤其是頂級滿血的MI250X戰績彪炳,目前公開性能世界第一、已經三連冠的超算“Frontier”,就是基於它打造的,最大性能高達119.4億億次浮點每秒,是第二名的多達2.7倍,峰值性能更是168億億次浮點每秒,是第二名的3倍還多!

第三名的“LUMI”同樣是採用了MI250X,最大性能30.9億億次浮點每秒,峰值性能42.9億億次浮點每秒,相當於第二名的七八成。

值得一提的是,韓國電信運營商Kt還使用AMD Instinct平台運行了該國第一個大語言模型,支持110億參數。

最新一代的Instinct MI300系列再次實現跨越,並開辟了全新的方向,有了兩款不同的產品。

其中,MI300A是全球首款面向HPC、AI的APU加速器,基於AMD的成熟經驗,開創了CPU、GPU合體加速的先河。

它採用了先進的Chiplet芯粒設計,一共有多達13顆小晶片,其中計算部分9顆,都是5nm工藝製造,基底和擴展部分4顆,都是6nm工藝製造,集成多達1460億個電晶體。

CPU部分為Zen 4架構,三組CCD共24個核心,GPU為最新的CDNA3架構,還有128GB大容量的HBM3高帶寬內存,可以為CPU、GPU所共享。

MI300A使用了標準的Socket獨立封裝,因此不再需要單獨的CPU處理器,自己就能組建一整套加速平台,大大簡化系統設計。

MI300X則是純GPU加速器,相當於把MI300A里的CPU模塊也替換成GPU,同時將HBM3內存容量增加到史無前例的192GB,帶寬達到驚人的5.2TB/。

整體集成的電晶體數量,也達到了同樣史無前例的1530億個。

作為對比,NVIDIA最新的H100加速器也只有800億個電晶體,只有MI300X的一半多點,不在一個層級上。

為方便客戶部署,AMD全新設計了Instinct平台,基於行業標準的OCP計算標准,單系統可集成最多八塊OAM形態的MI300X,HBM3內存總容量達1.5TB。

Instinct MI300系列也已經開始投入商用,比如美國勞倫斯利弗莫爾實驗室的新一代超級計算機EI Capitan,已開始安裝MI300A加速器,搭檔第四代AMD EPYC處理器。

它將在明年上線,預計性能超過200億億次浮點計算每秒,也就是可以超越當今第一的Frontier。

MI300X的強勁性能和超高能效,使之可以輕松應對當今AI對強算力的需求,搞定各種幾百上千億參數的大語言模型,Falcon、GPT-3、PaLM 2、PaLM等等都不在話下。

甚至,MI300X單卡就能運行800億參數的大語言模型,尤其是得益於超大容量的HBM3內存,大模型可以完全在HBM3內存中運行,無需動用系統內存,從而省去數據傳輸與拷貝,大大降低延遲、提升性能。

相比於 NVIDIA 80GB HBM內存加速器,運行同樣參數規模模型,MI300X所需要的GPU數量也更少,自然成本更低。

更關鍵的是,NVIDIA H100/A100加速器過於火爆,價格一路飆升,比如應用最多的H100目前已經要到4.5萬美元一塊,相當於30多萬人民幣,新一代的A100也需要十幾萬。

甚至,就算你捨得花錢,也不一定買到。負責代工的台積電也承認,H100/A100的緊缺狀況還要持續大約一年半之久。

相比之下,AMD的一貫優良傳統恰恰就是高性價比,正好可以給客戶提供更豐富的選擇空間,而不是吊在一棵樹上。

當然了,作為AI加速器,不但需要硬體設計強大,更需要足夠高效的開發平台、足夠優化的軟體和應用適配,才能徹底釋放潛力。

NVIDIA在這方面無疑做得相當透徹,這也是其贏得開發者和市場的一大關鍵。

AMD ROCm開發平台同樣歷史悠久,只是在技術特性、生態適配上一直有待進一步拓展,而今在AI的驅動下正在努力追趕。

比如新一代ROCm 5.x版本,針對HPC、AI做了全方位優化,支持各種流行的AI模型、框架和算法,諸如PyTorch、TensorFlow、ONNX、OpenXLA、Triton、DeepSpeed……方便開發者根據自己的實際需要選擇,靈活滿足不同場景。

值得一提的是,現在部署MI210,AMD還會提供軟體層面的搭建支持,讓客戶的安裝、使用更加簡單、省心。

說到這里順帶一提,除了高性能計算GPU方面,AMD還正在不斷釋放消費級遊戲GPU的AI潛力,比如大火的文生圖應用Stable Diffusion,已經可以在Windows系統下跑在AMD...

Intel AI軟硬秀肌肉:酷睿Ultra發布時間官宣 明年更有288核心

快科技現場報導:2023年9月20日凌晨,Intel在美國加州聖何塞舉辦第三屆Intel on技術創新大會,上演了一場AI的盛宴。

通過一系列創新的技術和產品,從雲端到網絡,從邊緣計算到消費者客戶端,Intel AI正無處不在,為各種各樣的工作負載、應用場景提供加速。

Intel CEO帕特·基辛格在開幕主題演中表示:“AI代表著新時代的到來,讓所有人迎來更美好的未來。對開發者而言,這將帶來巨大的社會和商業機遇,以創造更多可能,為世界上的重大挑戰打造解決方案,並造福地球上每一個人。”

基辛格特別強調了AI對於“芯經濟”(Siliconomy)的強力推動——芯經濟由Silicon(矽)、Economy(經濟)兩個詞組合而成,代表在晶片和軟體推動下不斷增長的經濟形態。

半導體正是維系和促進現代經濟發展的核心源動力,而更充足、更強大、更具性價比的處理能力,是經濟增長的關鍵組成。

數據顯示,全球晶片產業價值已經達到5740億美元,而由此驅動的技術經濟(Tech Economy)價值約有8萬億美元,也就是晶片產業可以給經濟發展帶來多達14倍的成效。

在這個無處不AI的時代,要想把AI真正落到實處,強大的硬體算力、豐富的開發工具這兩只手都必須足夠強有力,而這種軟硬兼施的實力,正是Intel的看家本領。

硬體方面,從通用CPU處理器,到GPU加速器,到集成NPU單元,再到AI加速器,Intel都在全范圍擁抱AI。

代號Meteor Lake的第一代酷睿Ultra處理器,將於12月14日正式發布,首次集成NPU神經網絡單元,拉開AI PC時代的大幕,通過雲與PC的協作,從根本上改變、重塑和重構PC體驗。

酷睿Ultra還是Intel首次採用Foveros封裝技術、Chiplet芯粒設計的消費級處理器,還會首次採用Intel 4製造工藝,並集成獨顯性能的銳炫核顯。

大會現場,Intel展示了全新AI PC的眾多使用場景。

比如正在視頻會議中的時候,如果有人來訪,酷睿Ultra PC就會智能提醒你。

在你起身離開電腦、與客人說話的時候,PC會自動將兩個場景分開,視頻會議中的參會者聽不到你和客人的對話,客人也聽不到視頻會議的內容,互不打擾。

當你回到視頻會議中,PC就會自動提煉你離開時的會議內容,甚至幫你翻譯不同的語言。

所以,摸魚終極神器?

比如非常流行的AI對話與輔助工具,在酷睿Ultra PC上既可以通過GPT聯網運行,也可以通過Intel OpenVINO離線運行。

在離線狀態下,無論是幫你回答日常問題,還是提煉工作內容,包括撰寫郵件,都不在話下。

創業公司Rewind甚至可以幫你在視頻中搜索過往內容。

事實上,不少AI創業公司已經在使用酷睿Ultra加速自己的業務。

比如Deep Render,開發了全球首個實時神經視頻壓縮技術,可以利用AI加速,獲得同等碼率下更清晰的視頻畫質。

宏碁也展示了一款基於酷睿Ultra處理器的筆記本,在輕薄的身材下就可以輕松完成各種AI任務。

宏碁COO高樹國表示,宏碁與Intel團隊合作,通過OpenVINO工具包,共同開發了一套宏碁AI庫,可以充分釋放酷睿Ultra平台的性能潛力。

Intel還大方地公布了酷睿處理器後續路線圖,明年將會看到下一代Arrow Lake,升級為Intel 20A製造工藝,並現場展示了一批測試晶片。

這將是Intel首個應用PowerVia背面供電技術、RibbonFET全環繞柵極電晶體的製程節點,意義重大,將按計劃在2024年做好投產准備。

再往後的Lunar Lake繼續使用Intel 20A工藝,預計重點升級架構。Intel甚至全球首次現場展示了Lunar Lake的實際運行,表明進展相當順利。

繼續往後是Panther Lake,製造工藝繼續升級為Intel 18A,將在2024年拿到實驗室樣片,2025年推向市場。

在伺服器和數據中心端,12月14日將會正式發布代號Emerald Rapids的第五代可擴展至強,也就是和酷睿Ultra同一天。

Emerald Rapids可以視為現有第四代Sapphire Rapids的一個升級版本,平台兼容,Chiplet設計由四晶片簡化為雙晶片,但增加到最多64核心128線程,在同樣的功耗水平下提供更高的性能和存儲速度。

2024年上半年,Intel將推出全部採用E核能效核的Sierra Forest,此前披露最多144核心144線程,現在又宣布,Sierra...

AI浪潮中 CPU能做些什麼?AMD EPYC全面開花給出完美答案

這是一個無AI不歡的時代,而日益高漲的算力需求,對各類硬體提出了越來越苛刻的要求,也使得天生具備超強並行計算能力的GPU加速器大放異彩,仿佛成為聖物一般的存在,人們甚至不惜花三十多萬元去搶一塊卡。

但是同時,CPU處理器的光芒卻被完全掩蓋,甚至出現了“GPU可以徹底取代CPU”這樣令人哭笑不得的言論。

事實上,在AI的硬體世界裡,CPU、GPU、FPGA、ASIC都是重要的成員,各有各的特點和優劣,無所謂誰比誰好,只能說需要在最合適的地方使用最合適的硬體,彼此之間也可以有機配合,達到效率的最優化。

其中,CPU的計算性能不是最強的,在處理特定負載時甚至可能是最弱的,但作為計算機行業一直以來的中樞,它有著不可替代的地位,不但扮演著核心指揮官的角色,還在不斷跟隨時代的變化而不斷演進,有著無可比擬的靈活性、適應性。

舉個例子,業內一度普遍認為,生成式AI和大語言模型(LLM)只適合在高性能GPU上運行,但事實上在CPU上同樣有著極高的效率,特別是配合特定加速器,效率與規模不受限制,從而提供極具競爭力的不同選擇。

近些年,在伺服器與數據中心領域,CPU持續快速疊代、升級,無論是AMD EPYC還是Intel至強,每一代都是舊貌換新顏,如今更成為AI浪潮的堅定基石。

尤其是AMD EPYC,2017年誕生重返高性能計算市場以來,憑借優秀的Zen系列架構,性能越來越強,能效越來越高,能力越來越豐富:高性能計算、邊緣計算、人工智慧、雲服務、5G與通信基礎設施、虛擬化……幾乎無所不能。

回想2017年之前,整個數據中心市場被Intel至強完全壟斷,客戶沒有任何選擇空間,Intel提供什麼就只能用什麼,Intel要多錢就只能給多少錢,也難怪AMD EPYC 2017年橫空出世的時候,整個行業的態度幾乎都是“歡迎歸來”。

AMD EPYC也確實沒有令大家失望,經過連續四代的進化,如今擁有業界最高的計算密度、最高的性能、最高的效率,或者直白地說有著最多的核心、最大的緩存、最高的頻率,以及極為豐富的技術特性,更關鍵的是不忘初心,一直堅持極高的性價比,可謂不二之選。

2022年11月11日,一個特殊的日子裡,Genoa EPYC 9004系列正式誕生,而對手規劃的Sapphire Rapids第四代可擴展至強反復跳票接近兩年,不但速度慢得多,性能表現也相去甚遠。

全新的5nm製造工藝、全新的Zen 4架構、Chiplet芯粒布局與最多96核心192線程、最多384MB海量三級緩存、最高4.4GHz加速頻率、12通道DDR5-4800內存(單路最大容量6TB)、128條PCIe 5.0總線、CXL 1.1+高速互連標准、全新升級的加密計算……

這些亮點,每一個單獨拿出來都值得說道半天,EPYC 9004卻把它們一網打盡,而且還有著相當高的能效,即便是旗艦級的96核心型號EPYC 9654熱設計功耗也只有360W,標准風冷散熱即可輕松搞定。

作為對比,Intel Sapphire Rapids四代至強還是Intel 7製造工藝(原名10nm)、最多60核心120線程與112.5MB三級緩存、4.2GHz最高頻率、8通道DDR5內存(單路最大容量4TB)、80條PCIe 5.0……幾乎全面落於下風,只有各種加速器相當惹眼,但也側面反映了CPU本身能力的欠缺。

實際性能方面,按照AMD在今年6月份舉辦的“數據中心與AI技術首映”上給出的數據,EPYC 9654對比至強鉑金8490H,96核心旗艦對比60核心旗艦,雲服務性能領先1.8倍,企業計算性能領先1.7-1.9倍,能效領先1.8倍,AI性能領先1.9倍,性價比領先近乎2.6倍……

四代對四代,AMD EPYC明顯碾壓了Intel至強。

如果到這里結束,AMD EPYC的表現已經近乎完美,但它還有著更高的追求,開始面向不同細分市場延伸、深入,通過不同的設計為不同的負載和場景提供最優化解決方案,第一次全面開花。

具體來說,EPYC 97X4系列(Bergamo)通過更高能效的Zen 4c架構,主打雲原生市場;

EPYC 9084X系列(Genoa-X)通過集成大容量高速3D...

60億參數AI模型測試:Intel 2.4倍領先 唯一可替代NVIDIA

快科技9月12日消息,MLCommons官方公布針對60億參數大語言模型及計算機視覺與自然語言處理模型GPT-J的 MLPerf推理v3.1的性能基準測試結果,Intel CPU處理器、現亮眼,在AI推理方面相當有競爭力。

,Intel Gaudi2 AI加速器在先進的視覺語言模型上,表現完全可以超越NVIDIA H100 股加速器,堪稱可唯一替代NVIDIA H100/A100的可行方案,最新結果再次驗證了這一點。

GPT-J模型上,Intel Gaudi2加速器的GPT-J-99、GPT-J-99.9伺服器查詢和離線樣本的推理性能分別為78.58次/秒、84.08 次/秒。

對比競品,H100相較於Gaudi2隻有1.09 倍(伺服器)、1.28 倍(離線)的性能領先優勢,Gaudi2對比A100的優勢則可達2.4倍(伺服器)、2倍(離線)的性能。

值得一提的是,Gaudi2提交的結果採用FP8數據類型,准確率達到99.9%。

Gaudi2軟體每6-8周就會更新一次,將繼續提升MLPerf基準測試性能,並擴大模型覆蓋范圍。

同時,Intel提交了基於Sapphire Rapids第四代至強可擴展處理器的7個推理基準測試,其中就包括GPT-J模型。

結果顯示,包括視覺、語言處理、語音和音頻翻譯模型,以及更大的DLRM v2深度學習推薦模型、ChatGPT-J模型在內,四代至強在處理通用AI負載時性能非常出色。

截至目前,Intel仍是唯一一家使用行業標準的深度學習生態系統軟體提交公開CPU結果的廠商。

根據最新結果,使用GPT-J對大約1000-1500字新聞稿進行100字總結的任務,四代至強在離線模式下每秒完成兩段,實時伺服器模式下則可完成每秒一段。

此外,Intel首次提交了至強CPU Max處理器的MLPerf測試結果,其集成最多64GB HBM3高帶寬內存,對於GPT-J而言是唯一能夠達到99.9%准確度的CPU,非常適合精度要求極高的應用。

來源:快科技

AI誕生67年後 為什麼看好AMD?EPYC CPU近乎無所不能

前幾年講故事,不帶上XR混合現實、區塊鏈、元宇宙什麼的,你都不好意思和人打招呼。如今,AI也是同樣的待遇。

不過,不像前邊幾個更多是停留在概念性,缺乏群眾基礎,有的甚至隱約有些“詐騙”的味道,AI其實有著悠久的歷史,有著很現實、很廣泛的技術和應用,更有著真正廣闊的未來,就像曾經的科幻正在一步一步走入現實。

2023年3月的Adobe峰會期間,AMD執行長蘇姿豐博士在和Adobe執行長Shantanu Narayen進行對話時,她提出,未來10年,最重要的事情就是AI,它甚至可以主導晶片設計。

其實早在1956年,人工智慧(Artificial Intelligence)的概念就誕生了,算下來已有長達67年的歷史。

不過直到1997年,IBM公司的“深藍”電腦擊敗西洋棋大師卡斯帕羅夫,才讓AI的概念廣為人知,被視為世界三大尖端技術之一(另兩個是空間技術、能源技術),也被認為是21世紀三大尖端技術之一(另兩個是基因工程、納米科學)。

2016-2017年,Google AlphaGo與李世石、柯潔等高手的圍棋大戰,將AI推向了一個新的高度。

2022年11月,OpenAI ChatGPT的誕生,更是讓AI走向了全民化。

自誕生以來,AI的追求始終都是用機器模擬甚至超越人類智能,無論用什麼方法、什麼技術,這一終極目標從未改變。

幸運的是,經過半個多世紀的演進,半導體技術已經達到了空前的高度,無論算力性能還是算法應用,都給了AI無限的可能。

實現這些可能的根基,毫無疑問是強大的硬體,否則一切都是建築在沙丘之上。

能夠運算AI的硬體多種多樣,可以分為兩大類。

一是傳統的是CPU處理器,好處是通用性強,什麼都能做,尤其擅長邏輯控制與串行計算,缺點就是計算能力和針對性不夠強。

二就是加速卡,又分為三類,其中GPU適合大量重復計算;FPGA靈活性好,集成度高,但是算力一般,成本高;ASIC專用性強,但開發周期長,難度極高。

今年6月份的“數據中心與人工智慧技術首映會”上,AMD給出的數據顯示,僅僅是在數據中心, AI加速器的市場價值在2023年就有約300億美元,預計到2027年可超過1500億美元,年復合增長率超過50%,妥妥的藍海。

目前,Intel、AMD、NVIDIA三巨頭都有各自豐富的AI軟硬體解決方案,CPU、GPU可以做,但又各自不同。

Intel CPU歷史悠久,一直有領導地位,但近些年遭遇重大挑戰,GPU則剛剛起步。

NVIDIA GPU執行業牛耳,優勢很大,但是CPU受到極大限制,只能走ARM架構。

AMD則一直是綜合性最強的,以往被戲稱“GPU吊打Intel、CPU吊打NVIDIA”,如今更是在CPU方面各種欺負Intel,GPU也在奮起直追、不斷創新,此外,現在AMD還擁有豐富的FPGA和自適應SoC產品系列供選擇。

更進一步,不僅僅在數據中心,AMD在消費端的AI也嶄露頭角,銳龍7040系列就是全球首款集成獨立AI引擎的處理器,開啟了AI筆記本的時代。

AMD GPU AI加速器就是Instinct系列,經過多年疊代已經發展得極為成熟,在技術上某些方面更是遙遙領先。

比如最新的Instinct MI300A是全球第一款面向HPC、AI的APU加速器,同時集成CDNA 3架構的GPU、Zen 4架構的CPU、128GB HBM3高帶寬內存。MI300X更是整合了史無前例的192GB HBM3內存,電晶體數量多達1530億個,令人嘆為觀止。同時,AMD ROCm開發平台也正進行改革,針對AI進行全方位深度優化。

GPU做AI如此強悍,已經是很多企業、開發者的首選,你也應該聽說過“GPU徹底取代CPU地位”之類的言論,但其實這都是宣傳套路而已,聽聽就行了,切莫認真。

不然的話,NVIDIA為啥還要做個Grace CPU來搭檔自家GPU,還號稱“超級晶片”?

CPU、GPU、FPGA、ASIC無論哪一個,在AI面前都無所謂誰好誰壞,關鍵是在靈活多變的AI需求面前,各自做最適合自己的工作。

打個比方,GPU、FPGA、ASIC就像是具備不同特殊技能的特種兵,在某項工作上可以做得非常好,CPU則像是核心領導,只有在它的協調指揮下,才能形成強大的整體戰鬥力,否則只是一盤散沙而已。

因此,如果非要給大家排個序,CPU反而更有資格排在前列。

這也正是AMD的核心優勢,一方面有著極為完整、久經考驗的完整產品線和綜合平台,另一方面其EPYC CPU處理器近些年更是意氣風發,甚至大有完全不把Intel至強放在眼裡的架勢。

EPYC堪稱AMD歷史上最成功的產品之一,每一代都極為閃耀,甚至可以說是一直遙遙領先。

2017年,隨著基於初代Zen架構、代號Naples的第一代EPYC 7001系列的誕生,AMD終於重返高性能計算市場,得到了整個行業的熱烈歡迎。

第三代Milan EPYC首次延伸除了專門針對高密度計算需求的Milan-X,通過堆疊3D V-Cache緩存,得到了數倍的性能提升,在業內是獨一無二的存在。

最新的第四代Genoa EPYC 9004系列,更是多點開花,從通用計算到高密度計算,從雲服務到邊緣計算,再到AI,幾乎無所不能。

其中,標准版的Genoa升級到先進的5nm工藝、Zen 4架構,憑借成熟的Chiplet布局,做到最多96核心192線程,還有12通道DDR5內存、160條PCIe...

每秒40億億次 俄羅斯最強AI超算上線:中國GPU?

俄羅斯雖然遭到了前所未有的封鎖和限制,但從未放棄。

莫斯科國立大學(MSU)就上線了最新的超級計算機“MSU-270”,AI計算性能高達400PFlops(40億億次浮點計算每秒)。

關於這台超算的配置,MSU披露的很少,只說配備了大約100塊“最新的圖形加速器”,並在供電、散熱、通信方面採用了全新的設計。

俄羅斯並沒有自己的高端計算GPU,大機率來自外部供應,但是NVIDIA、AMD、Intel都不能向俄羅斯出口此類產品,媒體就想到了中國廠商,比如一度號稱比肩NVIDIA的壁仞科技。

在此之前,MSU使用的GPU加速器都來自NVIDIA。

MSU-270 40億億次計算的性能單指AI方向,也就是FP16半精度浮點格式。

目前,俄羅斯最強的通用計算超算最大性能只有21.5PFlops,也就是2.15億億次FP64雙精度浮點計算每秒。

除了AI,MSU-270還可廣泛用於各種科學領域的研究,包括物理學、化學、生物學、心理學、社會學、地質學、醫學等等。

來源:快科技

谷歌發布第五代TPU:AI性能提升2.5倍 省錢50% 還勾搭上了NVIDIA

谷歌在29日舉行的 Cloud Next 2023 大會上,公開了Google Cloud新款自研AI晶片TPU v5e,並推出了搭配英偉達(NVIDIA)H100 GPU的 “A3超級計算機”GA(通用版) ,A3 VM實例將於下個月上線。

谷歌還宣布與AI晶片龍頭英偉達擴大合作夥伴關系。

第五代TPU:訓練性能提高2倍,推理性能提升2.5倍,成本降低50%!

TPU是谷歌專門為機器學習(ML)/深度學習(DL)設計的專用AI加速晶片,比CPU、GPU等通用處理器對於AI計算效率更高。

谷歌第一代 TPU(TPU v1)是 2016 年在 Google I/O 大會上發布的,隨後在2017 年作為 Google Cloud 基礎設施“Cloud TPU”推出,通常使用 FP32...

AMD銳龍開創AI筆記本時代:效果立竿見影

XR混合現實火了一段迅速涼下來,區塊鏈火了一段迅速涼下來,元宇宙火了一段也迅速涼下來。

混合現實、區塊鏈、元宇宙之所以如此“跌宕起伏”,主要是因為它們固然前景美好,但現階段更多停留在美好的概念上,理想豐滿,但現實骨感。

無論是技術角度,還是市場應用角度,它們都還缺乏足夠的根基,並不能真正給人們的日常工作、生活、娛樂帶來顛覆性的體驗,新鮮感一過自然乏人問津。

現在,AI人工智慧大火,甚至更勝以往,它會重蹈覆轍嗎?

答案簡而言之:不會,只是需要時間。

圖源:Pixabay

事實上,任何一項技術的普及,都離不開兩個核心點:一是足夠強大的硬體產品做基礎,二是足夠豐富的生態做支撐。AI當然也是如此。

AI技術其實並不新鮮,早已有之,之所以如今被引爆,正是多年來的行業耕耘到了開花結果的時刻,無論硬體還是生態都頗具雛形,這也是它和混合現實、元宇宙概念最大的不同。

在硬體方面,豐富、強大的AI加速器、CPU處理器、GPU加速器都可以高效率地搞定各種AI推理、訓練負載。

在應用方面,就更加數不勝數了,唯一限制的可能只有我們的想像力。

當然,這並不是說AI已經完美,還需要做的工作太多太多,尤其是和普通消費者關系最密切的日常工作、生活、娛樂,都大有可為,整個行業也都在全力推進AI的普及。

比如說PC,很多人覺得它老了,落後時代了,但在AI時代,老樹也可以開新花,一個全新的“AI PC”時代正在徐徐到來。

作為PC最核心的靈魂,CPU處理器也在積極跟上AI的時代步伐,比如AMD的銳龍7040系列,就是全球首款集成獨立AI引擎的x86處理器,為實時AI體驗提供強大的性能。

多年後回顧歷史,這很可能是標志性的一刻。

我們知道,CPU之所以被叫做“通用處理器”,就在於它強大的適應性,幾乎任何工作都可以勝任。

但畢竟術業有專攻,對於一些特定工作,還是專用硬體更加高效,而將它們集成在處理器內部,就是最為完美的解決方案,兼顧高效、高性能、低成本等優勢。

AMD銳龍7040系列處理器集成了AMD乃至整個x86移動行業迄今最先進的技術,包括4nm製造工藝、Zen 4 CPU架構、RDNA 3 GPU架構,以及全球首發的獨立AI單元——Ryzen AI引擎。

Ryzen AI引擎基於專門設計的XDNA AI架構,由多個獨立的AIE單元組成,還有獨立的內存電壓單元、內存控制器單元、高速互連通道。

它脫離了對雲側算力的依賴,可以直接在本地無延遲、高效率地靈活處理不同的AI神經網絡,包括CNN(卷積神經網絡)、RNN(循環神經網絡)、LSTM(時間遞歸神經網絡)等,並支持INT8、16、32、BF16等各種數據類型,還具備實時多任務能力,可處理最多4條並發空間流。

Ryzen AI引擎的峰值算力可以達到10TOPS(每秒10萬億次計算),可以輕松應對日常的AI推理負載設計,而且能效遠超CPU、GPU。

還有非常關鍵的一點,那就是將AI工作負載從雲端轉移到本地硬體之後,可以大大降低延遲,也不再需要排隊從而加快處理速度,還有助於將敏感數據排除在雲端之外,確保用戶隱私安全。

Ryzen AI引擎的這種高性能、高效率,最終會在視頻協作、內容創作、生產力、遊戲和防護方面,為用戶帶來更豐富的實時AI體驗。

硬體有了,要想充分發揮效力,軟體開發支持更是關鍵。

為了便於開發者以最高效率利用Ryzen AI引擎,AMD提供了獨特的一體化AMD AI堆棧,可以綜合利用CPU處理器、XDNA引擎的算力與能力,支持ONNX、TensorFlow、PyTorch等多種模型,OS系統廠商、OEM廠商、ISV獨立軟體開發商、個人開發者都可以自由使用。

作為整體AI方向的一部分,AMD正在向Windows開發者提供Ryzen AI軟體的早期訪問權限,方便其在銳龍7040系列處理器上運行AI工作負載。

值得一提的是,AMD使用了開源AI框架Vitis AI Execution Provider(EP),它在ONNX Runtime中支持Microsoft Olive,並提供卓越的CPU支持,包括無縫和逐步提升Ryzen AI引擎加速,可以根據工作負載的特性,自動決定是在CPU上還是在Ryzen AI引擎上調度工作負載。

Ryzen AI軟體平台將在今年晚些時候全面推出,為開發人員提供將AI融入現有應用、開發全新AI應用的所需工具,並發布更多的工具鏈、庫、指南,以簡化AI開發。

說一千道一萬,技術最終是要為用戶體驗服務的,只有落地到實際場景中才有價值。

PC平台上的AI還處於初期起步階段,從硬體到技術再到應用都剛邁出第一步,AMD勇敢地走在了最前列。

目前,x86處理器中集成專門AI處理模塊的,只有銳龍7040H/HS系列。基於AMD銳龍7040系列處理器的筆記本產品越來越豐富,遊戲本、輕薄本、設計本、辦公本等等應有盡有,無論你有什麼需求,無論想要超高性能,還是超高性價比,總能找到合適的。

英特爾這邊要等到下一代處理器,也就是第14代酷睿可能才會有類似的設計。

另外,根據目前的信息,下一個版本的Windows(很可能命名為Windows 12)將專注於AI體驗,深度集成人工智慧功能,包括分析當前信息,根據上下文提供APP快速啟動選項,識別圖像中的對象和文本等等。

但此類的AI功能將需要像Ryzen AI這樣的專用硬體支持才能運行。可以說AMD在專用AI引擎這方面的先發優勢,是無法比擬的。

這里我們就以雷蛇的靈刃14來簡單感受一下Ryzen...

Intel跑步進入AI PC時代 13代酷睿支持160億參數大模型、Arc顯卡提速54%

生成式AI(AIGC)無疑是當下最熱門的話題和應用,各家軟硬體廠商都在全力投入。

作為擁有強大硬體、廣泛生態的行業領袖,Intel也正在大力推動PC AIGC應用的落地,從硬體到軟體提供全方位支持。

目前在PC平台上,Intel已發布的12/13代酷睿、Arc A系列顯卡,以及即將發布的下一代酷睿,都能滿足AIGC對於高算力的需求。

再加上軟體生態的構建和模型的優化,AIGC場景在台式機、輕薄本、全能本、遊戲本等設備上都能落地應用,從而大大提高熱門的日常生活、工作效率。

其中,基於OpenVINO PyTorch後端的方案,通過Pytorch API,可以讓社區開源模型很好地運行在Intel客戶端處理器、集成顯卡、獨立顯卡和專用AI引擎之上。

比如說, Stable Diffusion的實現Automatic1111 WebUI,已經能夠通過上述方式,在Intel處理器、顯卡上運行FP16浮點精度的模型,支持文生圖、圖生圖、局部修復等功能。

更進一步地,Intel通過模型優化,降低了模型對硬體資源的需求,進而提升了模型的推理速度,讓社區開源模型能夠很好地運行在PC上。

眼下,Intel 13代酷睿通過XPU加速、low-bit量化,以及其它軟體層面的優化,可以讓最高達160億參數的大語言模型,通過BigDL-LLM框架運行在16GB及以上內存容量的個人電腦上。

已經驗證過的模型包括但不限於:LLAMA/LLAMA2、ChatGLM/ChatGLM2、MPT、Falcon、MOSS、Baichuan、QWen、Dolly、RedPajama、StarCoder、Whisper等,並通過Transformers、LangChain API接口支持Windows、Linux的作業系統。

即將發布的代號Meteor Lake的酷睿Ultra系列,更會成為PC AI歷史上的重要里程碑。

酷睿Ultra它將通過分離式模塊架構,集成名為“VPU”的獨立AI加速單元,為PC用戶提供AI驅動的新功能、新應用,比如Adobe Premiere Pro中的自動重新構圖、場景編輯檢測等等,還有更高效的機器學習加速。

目前,Intel正與PC產業夥伴合作,加速AI加速應用的落地和普及,未來後續基帶產品也會進一步擴展AI能力。

另一方面,Intel Arc銳炫顯卡通過驅動和補丁更新,已經可以較好地支持Stable Diffusion,性能提升效果相當顯著。

Tom's Hardware就分別測試了Arc A770 16GB、Arc A750,使用了Automatic1111 WebUI OpenVINO。

在此之前,Arc A770 16GB、Arc...

AMD研究發現,IT領導者對人工智慧將改變其業務的方式持樂觀態度,並正在加大投資

——近七成IT領導者認為人工智慧技術將提高團隊效率,但52%的人表示其組織還沒有所需的IT基礎設施

2023年8月15日,加州聖克拉拉訊——今天,AMD(納斯達克股票代碼:AMD)發布了一項針對全球IT領導者的新調查結果,該調查發現,四分之三的IT領導者對人工智慧的潛在好處——從提高員工效率到自動化網絡安全解決方案——持樂觀態度,超過三分之二的人正在增加對人工智慧技術的投資。然而,盡管人工智慧為組織提供了提高生產力、效率和安全性的明確機遇,但由於缺乏實施路線圖以及現有硬體和技術組合並未整體就緒,IT領導者並不能確定採用人工智慧的時間表。

AMD委託對美國、英國、德國、法國和日本的2500名IT領導者進行了調查,以了解人工智慧技術如何重塑工作場所,IT領導者如何規劃他們的人工智慧技術和相關的客戶端硬體路線圖,以及他們在採用人工智慧技術時面臨的最大挑戰。盡管在安全性方面存在一些猶豫,並且培訓員工被認為是一項繁重的工作,但很明顯,已經實施人工智慧解決方案的組織正在看到積極的影響,而推遲實施的組織則面臨被甩在後面的風險。在優先部署人工智慧的組織中,90%的組織表示已經看到了工作效率的提高。

AMD商用客戶和工作站高級總監Matthew Unangst表示:「早期採用人工智慧是有好處的。IT領導者看到了人工智慧解決方案的好處,但他們的企業需要制定一個更有針對性的實施計劃,否則就會面臨落後的風險。開放的軟體生態系統和高性能的硬體都至關重要,AMD相信通過利用來自我們全產品陣容的人工智慧IP進行多層面推進,可使我們的合作夥伴和客戶受益匪淺。」

企業人工智慧計算的未來

致力於為IT領導者在實施人工智慧解決方案時擁有最好的計算平台,AMD與開放的行業標准軟體密切合作,專注於在我們的產品組合中開發具有人工智慧功能的尖端解決方案,從雲到邊緣再到端側。

今年,AMD推出了AMD 銳龍7040系列處理器,其中部分型號首次配備了支持Windows Studio Effects的Ryzen AI引擎,以及Ryzen AI開發工具,提供了有別於其它x86處理器的獨特體驗,並為直接在筆記本電腦上實現更強大的AI功能打下了堅實的基礎。

面向移動PC的專用人工智慧引擎是對基於雲的人工智慧的補充,對於在工作場所採用人工智慧應用程式至關重要。它的潛力體現在如下幾方面:

?通過在本地運行人工智慧模型,為員工提供更個性化、更安全的體驗。

?提高筆記本電腦的電源效率,從而提高員工的生產力和連接能力。

?通過使筆記本電腦能夠運行下一代軟體,增加企業運行人工智慧工作負載的總帶寬。

對於那些也想在本地部署的數據中心運行人工智慧工作負載的企業來說,擁有最新的基礎設施至關重要。通過將數據中心升級為新型的AMD EPYC處理器,可以幫助客戶大幅減少所需的機架數量。

為了配合硬體,AMD正通過面向數據中心加速器的AMD ROCm軟體生態系統,將一個開放、就緒、成熟的人工智慧軟體平台推向市場。

查閱完整調查報告以了解更多信息。

來源:快科技

Intel CEO親口承認:NVIDIA確實是AI的王者 遙遙領先

度過了幾個糟糕的季度之後,Intel終於在今年二季度扭虧為盈,淨利潤15億美元。

在接受采訪時,Intel CEO帕特·基辛格認為,最糟糕的時刻已經過去,PC行業正在復蘇,前景向好,Intel也提高了第三季度的預期。

對於當下最火的AI話題,基辛格談到了即將發布的一系列相關產品。

數據中心方面,原定年底發布的第五代可擴展至強Emerald Rapids,將提前到第三季度。

消費級方面,Meteor Lake被視為又一個“迅馳”,將真正開啟AI PC時代,這也是它被叫做酷睿Ultra的重要原因之一。

加速器方面,Intel剛剛在中國發布了特供版Gaudi2,並且已經拿到了下一代Gaudi3的首樣片,計劃2024-2025年發布,帶來2倍性能提升。

而談到AI,就迴避不了NVIDIA,基辛格倒也十分大方地承認了對手的領先。

他說,NVIDIA在AI領域幹得非常漂亮,真的遙遙領先,必須承認他們超級努力,而且非常幸運,在合適的時間、合適的領域取得了突破。

不過基辛格也指出,AI依舊很年輕,還有相當多的機遇,Intel也正在贏得客戶,因為市場也需要不同的解決方案,需要更高的能效、更低的成本、更多的功能。

有意思的是,基辛格再次暗示Intel IFS代工業務可能會為NVIDIA提供服務。

來源:快科技

《原子之心》:蘇聯控制論與人工智慧異想

1953年10月,一位化名為「唯物主義者」的蘇聯批評家,在《控制論為誰服務?》(WhomDoes Cybernetics Serve?)一文中這樣寫道:「生產過程無需工人,只有被計算機的巨大的大腦控制的機器!沒有罷工,更沒有革命起義!機器代替了大腦,沒有人的機器!」

這是上世紀50年代,蘇聯科學界對美國控制論思想的批判中非常流行的觀點。他們認為控制論是「機械主義」的「反動的偽科學」,企圖以智能機器人取代工人。而這在今年年初破圈的電子遊戲《原子之心》(Atomic Heart)中,則成為了架空世界中的蘇聯對外輸出工業力量的主要方式。

人是否會被智能機器所代替?這個經典問題隨著Stable diffusion和ChatGPT等生成式AI,重新回到公共輿論場中。新技術作為一枚棱鏡,總能折射出不同社會文化背景下的觀念光譜。其中的個體不論擔憂抑或激動,皆因身處於浪潮之中。而這浪潮本身,亦將新技術推向它自身未曾設想的方向。

恰如《原子之心》中的大集體神經網絡,也好似它那被浪潮推向歷史塵埃的現實原型「控制論」。

1.《原子之心》:科技加速下的平行蘇聯

2023年2月21日發行的《原子之心》,由俄羅斯遊戲公司Mundfish製作,靠著其獨特的蘇聯美學風格和迥異於歐美主流遊戲大作的氣質,吸引了玩家的目光。

遊戲將諸多蘇聯時期的視覺元素與科幻奇想熔為一爐:雄偉堂皇的史達林主義風格建築和激進大膽的蘇聯先鋒建築、根植民族的現實主義藝術和抽象純粹的構成主義藝術、紅旗招展的集體氛圍和冷峻朋克科技設定;這些都被雜揉在一起,造就了一個架空世界中50年代蘇聯的科技烏托邦-3826號設施。

遊戲的時間線在1936年開始與現實分支。這一年,遊戲中的科學家德米特里·謝切諾夫(原型應為俄國生理、心理學家伊凡·米哈伊洛維奇·謝切諾夫)成功開發了「聚合體」,這既是一種擁有極高效率的能源載體,又是能與有機體神經系統融合的生物化學材料。遊戲中的蘇聯科技水平自此一騎絕塵,機器人技術領先世界。

在遊戲中的第二次世界大戰中,德國納粹使用生化武器造成了「褐色瘟疫」,而蘇軍用量產軍用機器人代替人類士兵投入前線。面對不會感染瘟疫的機器人軍隊,德意聯軍節節敗退,在1943投降,遊戲中的蘇聯提前兩年結束了二戰的歐洲戰場。

戰後蘇聯大力發展神經網絡和機器人科技,並迅速向工業與民用轉化。1946年,蘇聯在3826號設施范圍內啟動了「大集體1.0」神經網絡,這是遊戲中玩家所在時間點1955年的「大集體2.0」的初代版本。1.0版本以人類與機器人的合作為標志,意味機器人性能趕超人類。蘇聯機器人工業由此取代美國馬歇爾計劃,主導了歐洲戰後重建。蘇聯以此為契機向全世界輸出廉價機器人,替代產業工人,造成他國失業,激化社會矛盾。這一設定大體符合前沿技術最先軍用,後轉民用的現實規律,同時也構成了遊戲中最重要的劇情懸念之一。

大集體網絡疊代後的2.0版本,主要標志為在人腦中植入聚合體,人類全體聯網並能以意識直接控制機器人,但這實際上卻是一個植入式的群體腦控開關。遊戲通過技術設定呈現出一個經典的遞歸權力關系:在「掌握技術權力的人-普通人-機器人」的三級關系中,控制者同時也是更大范圍內的被控制者,幾者的身份卻又在戲劇衝突中實現調換與反轉。

而在真實時間線的1946年,邱吉爾3月在美國威斯敏斯特大學發表演說,冷戰的鐵幕就此降下。同一個月,蘇聯最高蘇維埃剛剛通過第四個五年計劃,專注於戰後重建,著力發展重工業。

也是在這個月,第一次梅西控制論會議在美國紐約召開,以諾伯特·維納(NorbertWiener)、馮·諾伊曼(von Neumann)、沃倫·麥卡洛克(Warren McCulloch)等人為主的學者團體,在此奠定了之後的計算機科學神經科學的基礎。

倘若說《原子之心》中將有機體和機器人整合進同一個神經網絡的「大集體」計劃,是一種對神經生理學和信息技術發展的終極想像,那麼它最初的輪廓則是被控制論所勾勒。

控制論,Cybernetics,被維納稱為「在動物和機器中控制和通信的科學」,脫胎於美軍防空火炮控制系統研究。維納和計算機工程師朱利安·畢格羅用電信號循環反饋的理論,在伺服機械(用於高射炮的模擬控制裝置)的功能和飛行員和炮手的有目的的行為之間建立了聯系。控制論在神經生理學層面將有機體和機器等同視之,搭接了「賽博格」奇想最重要的一環鏈條。

隨後,控制論的思想憑借著名的跨學科會議,迅速的推廣到其他生物科學和社會科學,這使其具備了電子工程技術屬性之外的哲學與文化色彩。而控制論語境中對人與機器的類比、協作甚至融合的預言,也鋪陳出後世對於未來技術社會幻想的底色。

控制論如今的面貌似乎是一門關於中央控制與機械自動化的技術。但倘若對控制論的歷史追根溯源,就會發現控制論學者最初的願景是構造具有自組織、自學習能力智能機器,用今天更熟悉的術語就是「計算機和人工智慧」的混合體。這兩個更為人熟知的概念與學科,在上世紀60年代之後,接管了控制論最核心的那部分思想。而控制論只餘下了自動化控制、工程應用的軀殼。

其實更確切地說,這是一個被冷戰造就的歷史誤會。蘇聯官方對控制論的應用仿佛一隻無形的手,捏合出它如今扭曲的面貌,同時也造就了如今人們對智能機器憂心忡忡的一面。

2.技術的雙面鏡,從偽科學到全能工具

媒介文化學家尼爾·波茲曼認為,一切媒介技術自其誕生起就附帶有預料之外的意識形態傾向。不過對於控制論這種較為抽象的技術概念來說,它的傾向更有可能形成於具體情境的應用之中。

在《原子之心》中,對於大集體神經網絡,即原子之心計劃的應用(如何處理接入網絡的眾多集體意識)就存在三種完全不同的立場,我將他們稱為:科技造福派謝切諾夫,希望通過科學技術打造改變人類的生活的烏托邦社會;激進融合派扎哈羅夫,不顧社會倫理消滅人類肉體將精神徹底融入「大集體」;絕對控制派莫洛托夫,代表既得利益者希望在新技術中獲得更高級的控制權以維持現有權力結構。三者都希望依據自己的立場重新塑造大集體網絡的實用場景。

控制論在蘇聯也因為特定時期的官方需求,而呈現出前後完全矛盾的形象,並且最終決定了控制論在美國——其真正發源地的命運。

上世紀40年代末及50年代初維納的《控制論》出版不久,就已經在蘇聯科學家圈子中流傳,主要在蘇聯自動化和遠程控制委員會內部傳閱。維納在書中用神經系統中電信號的循環反饋解釋人類的行為機制,這一後來被廣泛接受的模型,在當時卻被認為相悖於蘇聯生理學界主流的巴甫洛夫反射理論。控制論因此被捲入了荼毒蘇聯生理學和遺傳學界幾十年的「李森科事件」中,成為了權力鬥爭的犧牲品之一。

1950年5月發表於《文學報》的《平常的偽科學》(Normal Pseudo-Science)一文將維納斥為「資本家取代真正的科學家的騙子和蒙昧者」。同時發表的《MARK III,一個計算器》一文中,認為以控制論為代表的美國計算機科學是一場騙局。

這幾篇文章吹響了批判控制論的號角,駁斥的文章紛至沓來。攻擊普遍集中在控制論關於智能機器、人與機器類比的想法,認為維納的控制論是企圖「用機器人取代無產階級先鋒」的「現代奴隸主的科學」。

1954年,批判達到高潮。在當年修訂的《簡明哲學詞典》中,控制論被稱為「反動的偽科學」,徹底被塑造成一個可怕的意識形態敵人。

然而,在這場由神經生理學蔓延至語言學、哲學等學科,關於控制論在生物科學和社會科學層面的批判浪潮之外,蘇聯軍方卻在保密的狀態下加緊研究控制論中與計算機有關的內容,以滿足國防軍事應用的緊迫需求。

1950年,當輿論對控制論的攻擊如火如荼之際。蘇聯政府授權兩個機構BESM(精密機械和計算機技術研究所)和STRELA(機械製造和儀器製造部的特別設計局)設計大型電子計算機,用於核武器和飛彈彈道的數學計算。

軍方和科學家都希望在不受西方意識形態影響的情況下,利用美國的控制論和計算機技術。因此在軍方內部的語境中,控制論中生物科學和社會科學的部分都被小心翼翼的剝除,被修剪為一門關於計算機和通信的應用技術。在1952年譯為俄文的《高速計算設備》一書中,就刪除了所有關於控制論中人和機器類比的內容。

蘇聯控制論在兩個語境中獨立行進的命運線,在1953年赫魯雪夫擔任蘇共第一書記後,迎來了交匯與轉變。赫魯雪夫「解凍」時期的工作重心轉移至經濟政策,意識形態色彩開始淡化,科學界與其他國家的交流增加。與此同時,公共輿論對控制論的批判逐漸降溫。軍方也開始向外披露蘇聯計算機研究的進展。

1955年,蘇聯控制論與計算機先驅安納托利·基托夫(Anatoly Kitov)、數學家阿列克謝·利亞普諾夫(Aleksei Liapounov)和原子能研究所的副所長謝爾蓋·索博列夫(Sergei Sobolev)聯合發表了蘇聯第一篇公開介紹控制論的文章《控制論的基本特徵》(Basic Features of Cybernetics)。這標志著控制論在公共形象的正式轉變,並掀起了之後控制論流行的浪潮。

1960年在莫斯科召開的第一屆控制與自動化大會甚至邀請了維納。維納在隨後的一個月的行程中,在蘇聯和東歐各地都受到了明星般的待遇。

1961年,蘇共第二十二次代表大會通過的新黨綱中提到了「控制論、電子計算機和控制系統」將在生產、研究、計劃和管理中「廣泛應用」。直至1967年,蘇聯控制論委員會已經協調了大約500個機構的控制論研究。自此,控制論在官方語境中正式確立了自己的位置,這個曾經被斥為「美國偽科學」的學科在官方的承認下獲得大力發展。並且帶起了一輪輿論和產業熱潮。

控制論在報紙和流行雜誌中獲得了全新的文化形象:「會思考的機器」,將人從艱苦的、機械的工作中解放出來,專注於思考和創造的「全能魔法工具」。

蘇聯對控制論態度的轉向引起了美國的注意,中央情報局在報告中提及蘇聯正在利用控制論建造能自主學習的計算機,以提醒政府注意電子計算機等信息技術的研發。

冷戰中的美國既希望齊頭並進,全力投入開發阿帕網等軍用信息設施。同時也希望與這門和蘇聯官方有關的學科撇清關系。而1956年出現的人工智慧概念,因為其與控制論共享一部分關於計算機科學和智能模擬的知識,獲得了更多資金與政策支持,並在之後成為我們如今熟知的科技術語概念。

與此同時,發源於美國軍方研究的控制論,在冷戰漩渦和麥卡錫主義的餘波中被打上了意識形態的烙印,在美國成了鮮有問津的冷門研究領域。

3. 科技史另冊,網際網路的一種

如今網際網路去中心化、開放、共享的文化形象,與美國將阿帕網等軍用信息技術授權私人企業進行商業活動,進一步向民用轉化的方式不無關系。這在一定歷史時期內促進了技術的個體賦權,但同時也造成了公共領域中的信息冗餘和資本力量對數據權利的割據攫取。

而蘇聯的軍用計算機網絡向民用的轉化方式則完全不同。計算機網絡如何融入現有的組織體系和權力結構,才是最優先被考量的。

就像遊戲《原子之心》中的莫洛托夫,想從謝切諾夫博士手中奪取大集體網絡的系統後門,獲得比網絡中的其他節點更高的管理權限,從而維護現有的權力結構。他本質上代表了架空蘇聯中的高層意志。

在現實世界的蘇聯上世紀60年代,先後提出建設全國性控制論計算機網絡的基托夫和維克多·格魯什科夫(Victor Glushkov),當然沒有遭遇如此戲劇的橋段,但是與現有官僚機構管理層級的博弈幾乎完全決定了提案的最終命運。在其中也可以見到「智能機器是否會取代人類?」「誰該獲得新技術的掌控權?」的經典命題所起到的關鍵作用。

首先是基托夫的EASU(經濟自動化管理系統)。他在1959年寫給赫魯雪夫的信中提出打造軍民兩用的計算機網絡,利用軍用計算機的閒時算力進行經濟方面的信息運算與管理。

軍方拒絕了這一提案,理由是「低效且不合適」,基托夫也因此暫時被軍隊開除,而他本人認為「當權者擔心由於引入計算機技術,他們中的許多人會被證明是多餘的。」

第二個是計算機科學家格魯什科夫及其領導的控制論研究所提出的OGAS(國家自動化系統),這是一個與軍用計算機網絡分開的全國性計算機網絡,其中包括數萬個地方計算中心;分布在主要城市的30-50個中級計算中心;以及控制整個網絡為政府服務的頂級中心。它們主要安置在各個工廠和經濟部門當中,用以高速的匯總並交流全國經濟數據。

OGAS不只是一個簡單的計算機網絡,這實際上是一個統一的優化規劃和管理制度,其中包含了蘇聯經濟管理機構的全部操作。這是在當時經濟政策下對蘇維埃的政府系統的改革設計,因此在推進中遭遇了極大的官僚阻礙。

EASU和OGAS以及當時一些其他方案都可以視為是蘇聯「經濟控制論」的實踐組成。該理論希望在建立全國性的計算機網絡的同時引入經濟激勵制度,讓經濟在國家計劃的限制下具備自我調節的能力,這基本相當於將權力下放至地方。

這些激進方案,都產生在赫魯雪夫的經濟管理權力區域下放制度實施期間。並隨著1964年赫魯雪夫蘇共中央第一書記職務的解除而逐漸取消。OGAS也被認為不利於信息的集中管理,會動搖現有的組織層級,影響中央統計局的地位。

最終,中央統計局在實際執行中將其簡化為EGSVTs(國家統一計算機網絡),擱置了其中機構改革的部分,只保留了向上匯報數據等等信息通信網絡建設,用於加強基於現有體系的中央管理。

在之後的具體實施中,中央統計局負責發展全國計算機中心網絡,而各部委則被批准建設各自的計算機中心,並在其下屬企業中開發信息管理系統。然而就連這個精簡版信息通信網絡,也由於地區和部門各自為政導致的硬軟體兼容問題,而不了了之。

上世紀60年代中後期,公共輿論和研究機構對控制論的關注到了狂熱的地步,控制論經歷著一場「通貨膨脹」。人們開始不顧控制論的有效范圍,誇大控制論的效用,可卻未見到真正落地應用,大多隻停留在演講和報告中。這時的控制論反倒更像50年代所提及的「偽科學」,真正的控制論學者甚至都唯恐避之而不及。

而控制論的實際應用仍是由官方主導的軍用計算機研究的擴展和延續,其民用化也並不成功。不過蘇聯在這一過程中,因其中心化的管理結構中更早的意識到「數據作為一種權力」。這在如今大數據的信息科學中已幾乎成為公認的觀點。

而這一切都隨著蘇聯的解體消散了,或者更確切的說,像《原子之心》中莫洛托夫的「死亡」一樣,融入了新的集體記憶之中。

留給控制論的卻是中心化、等級制、誇大濫用的刻板印象,這已經與維納在《人有人的用處》中對人類群體和個體的人文關懷南轅北轍。對於當下的我們,這樣一種網絡的體驗似乎也並不陌生。

4.結語

如果說2020年末發布的《電馭叛客2077》刻畫的是賽博文化(cyber culture)的資本主義反烏托邦,那麼今年的《原子之心》則是對蘇聯控制論展開的終極想像。它們是一種技術哲學在不同的地域和文化背景下的雙生子。

人類、賽博格、網絡、黑客(攪局者)、控制、剝削、夜之城(另一種哥譚或紐約)、3826號設施……無論如何,其中都注滿了對於控制論陰暗面的刻板印象,被雜揉進資本主義晚期社會結構和架空蘇聯的權力異想之中。

而作為群體和個體的人,該如何與智能機器共存,從最初到現在,從現實到科幻,從來都不是一個偽命題。雖然控制論的文化形象充滿了歷史誤會,它在技術層面的先鋒面向也早已被新興學科所超越。但是看向起點,我們總能發現一種面對新他者時對人類自身的樂觀與勇氣。

錢學森在將控制論引介到國內時,曾在其出版於1958年的著作《工程控制論》(EngineeringsCybernetics)中文版的序言中這樣寫道:「這樣一個現實已經來到了人類的面前:由電子計算機和機器智能裝備起來的人,已經成為更有作為,更高超的人。」

如今我們與智能機器的交互方式離自然語言越來越近,在這一層面上來說,這些系統也已經逼近了科幻作品中的類人印象。

例如在生成式AI實操中提出的「promting」,實際上就是一種通過自然語言的tag訓練人工智慧數據模型的交互方式。這種依靠信息與數據輸入輸出的反饋循環來探索一個黑箱系統的行為模式,正是最初的控制論學者面對動態系統時的方法。

媒介學家安德魯·皮克林(Andrew Pickering)認為「控制論的全部任務就在於如何弄明白一個無法被人類的設計所征服的世界」,這個世界中充滿了「不斷發展並以不可預測的方式變化的動態系統。」

從前我們識別周遭存在的涌現系統,而如今,我們創造。或許,是時候審視控制論真正的思想遺產了。

參考

Slava Gerovitch(2002), From Newspeak to...

性能暴漲4.5倍 NVIDIA H100計算卡強勢壟斷AI:對手?不存在

AI世界如今最大的贏家是誰?

毫無疑問是黃仁勛的NVIDIA,布局早,技術強,根本找不到對手,“躺著”就可以掙大錢了。

現在,NVIDIA又公布了最新一代Hopper H100計算卡在MLPerf AI測試中創造的新紀錄。

Hopper H100早在2022年3月就發布了,GH100 GPU核心,台積電4nm工藝,800億電晶體,814平方毫米麵積。

它集成18432個CUDA核心、576個Tensor核心、60MB二級緩存,搭配6144-bit位寬的六顆HBM3/HBM2e高帶寬記憶體,支持第四代NVLink、PCIe 5.0總線。

相比於ChatGPT等目前普遍使用的A100,H100的理論性能提升了足足6倍。

不過直到最近,H100才開始大規模量產,微軟、Google、甲骨文等雲計算服務已開始批量部署。

MLPerf Inference是測試AI推理性能的行業通行標準,最新版本v3.0,也是這個工具誕生以來的第七個大版本更新。

對比半年前的2.1版本,NVIDIA H100的性能在不同測試項目中提升了7-54%不等,其中進步最大的是RetinaNet全卷積神經網絡測試,3D U-Net醫療成像網絡測試也能提升31%。

對比A100,跨代提升更是驚人,無延遲離線測試的變化幅度少則1.8倍,多則可達4.5倍,延遲伺服器測試少則超過1.7倍,多則也能接近4倍。

其中,DLRM、BERT訓練模型的提升最為顯著。

NVIDIA還頗為羞辱性地列上了Intel最新數據中心處理器旗艦至強鉑金8480+的成績,雖然有56個核心,但畢竟術業有專攻,讓通用處理器跑AI訓練實在有點為難,可憐的分數不值一提,BERT 99.9%甚至都無法運行,而這正是NVIDIA H100的最強項。

此外,NVIDIA還第一次公布了L4 GPU的性能。

它基於最新的Ada架構,只有Tensor張量核心,支持FP8浮點計算,主要用於AI推理,也支持AI視頻編碼加速。

對比上代T4,L4的性能可加速2.2-3.1倍之多,最關鍵的是它功耗只有72W,再加上單槽半高造型設計,可謂小巧彪悍。

幾乎所有的大型雲服務供應商都部署了T4,升級到L4隻是時間問題,Google就已經開始內測。

來源:快科技

中國為何未研製出ChatGPT?中科院包雲崗:需要優秀技術團隊、雄厚資金

最近幾個月,美國OpenAI公司的ChatGPT爆火,這是一種基於GPT語言模型開發的人工智慧聊天機器人,能夠通過學習和理解人類的語言來進行對話,還能根據聊天的上下文進行互動,真正像人類一樣來聊天交流。

今日,中國科學院計算技術研究所研究員包雲崗對ChatGPT的“污點知識”“ChatGPT有未公開的黑科技?”等問題分享了自己的看法。

對於中國為何未研製出ChatGPT的問題,包雲崗表示,這個問題還可以擴展到為何Stanford、Berkeley、MIT、CMU沒有研製出ChatGPT?為何Google也沒能研製出ChatGPT?

包雲崗認為,這背後有很多原因,如需要有遠見的領導者,需要有優秀的技術團隊,需要有雄厚的資金等等。除了這些要素,有一點在其中起到關鍵作用——OpenAI的機制創新。

據介紹,OpenAI一開始以非盈利機構(NPO)方式,致力於推動AI技術研究和協作,但該模式的自我造血能力始終是一個難題。

包雲崗表示,OpenAI提出了一種創新機制——在傳統NPO模式基礎上增設一種有限盈利模式。這種新模式跟傳統NPO捐贈最大的區別在於,通過有限盈利模式的投入的資金可以轉變為股權,具有保值甚至增值特點,而捐贈則完全讓渡了所有權益。

值得注意的是,清華大學人工智慧國際治理研究院副院長梁正此前談到了中國公司為什麼沒跟上ChatGPT的浪潮,梁正指出,“到現在為止,幾乎沒有中國公司大力投入基礎研究,沒有人做0-1的事情。”

來源:快科技

NVIDIA正在「壟斷」AI 中國廠商怎麼辦?

“為了計算和人類的未來,我捐出世界上第一台 DGX-1 。”

2016 年 8 月,NVIDIA 創始人黃仁勛,帶著一台裝載了 8 塊 P100晶片的超級計算機 DGX-1 ,來到了 OpenAI 的辦公大樓。

在現場人員到齊後,老黃拿出記號筆,在 DGX-1 的機箱上寫下這句話。

與其一同前往的還有特斯拉和 OpenAI 的創始人,埃隆馬斯克。

這次 OpenAI 之行,老黃不為別的,就是為了把這台剛出爐的超算送給 OpenAI ,給他們的人工智慧項目研究加一波速。

這台 DGX-1 價值超過百萬,是...

有了 ChatGPT,人類懶得思考了

隨著 ChatGPT 風靡全球,越來越多人開始將其融入到工作/學習流當中,久而久之人們開始依賴於 AI 的幫助,喪失了原有的一些技能。美利堅大學語言學名譽教授 Naomi S·Baron 就此提出了自己的一些擔憂。

原文標題:How ChatGPT robs students of motivation to write and think for themselves

原文地址:https://theconversation.com/how-chatgpt-robs-students-of-motivation-to-write-and-think-for-themselves-197875

下面是全文編譯,原文地址👆🏻

當 OpenAI 在 2022 年末推出新的人工智慧 ChatGPT...

顯卡漲上去降價別想 NVIDIA炮轟挖礦對社會無益:人工智慧才是未來

加密貨幣的挖礦需求,曾經帶動英偉達GPU晶片銷量的高漲。然而,英偉達首席技術官Michael Kagan卻在最近的采訪中發出不一樣的訊號。

Kagan指出,加密貨幣礦工購買了大量的英偉達硬體,然而加密貨幣不會為社會帶來任何有用的東西,這也是加密市場近來頻頻崩潰的原因。

相較之下,他更青睞人工智慧,因為人工智慧對社會有益。人工智慧允許個人創建定製程序來滿足不同需求。但加密貨幣的高頻交易,事實上對人類沒有任何意義。

他因此建議人們將用於加密貨幣挖礦的處理器晶片用於開發聊天機器人,如ChatGPT,後者能為社會增加更加價值。

加密貨幣狂熱褪去

GPU是開采加密貨幣的絕佳工具。2020年及2021年加密熱期間,“礦工們”狂熱地搶購英偉達的GPU。由於需求走高,GPU的價格那時一直處於上漲的趨勢。

這也幫助推動英偉達GPU業務的穩健增長。但好景不長,隨著加密貨幣價格的快速跳水,礦工經營業務的利潤下降,英偉達GPU業務也隨之放緩。

據Jon Peddie研究公司的報告分析,2022年第三季度中,英偉達、英特爾和AMD共出貨了690萬個獨立GPU,相比2021年同期下降了42%,也創下了自報告統計該數據以來的最低出貨量。

與此同時,英偉達去年第三季度收入同比下降17%,淨利潤更是同比下降72%,其中遊戲顯卡業務和可視化業務收入同比下降超過50%。據英偉達自己的解釋,GPU銷量下降正是其中一個重要的原因。

人工智慧接棒

Kagan指出,對加密貨幣的失敗並不驚訝。他犀利點評:除了投機之外,加密行業還沒有任何真實世界可用的實例。

但人工智慧卻非如此。他指出,自從ChatGPT發布之後,人工智慧一直處於前沿和中心地位,且越來越多的應用場景隨之被不斷開發。

英偉達的執行長黃仁勛也在人工智慧上堅定押寶。他表示,新的聊天機器人,如ChatGPT的出現是人工智慧領域的“iPhone時刻”。他期待著人工智慧的蓬勃,能帶領英偉達再次創造高銷售額、高增長的佳話。

英偉達也確實已經進軍人工智慧領域,其在最近推出了一款基於雲的人工智慧超級計算機,用戶可以通過桌面瀏覽器進行訪問。目前微軟的Azure平台和Google雲等服務都是建立在英偉達的硬體供應之上。

來源:快科技

從今天起忘掉「iPhone 時刻」,ChatGPT 開啟了 AI 的寒武紀大爆發

今天凌晨,OpenAI 發布 ChatGPT Plugins (ChatGPT 插件集),它能將 ChatGPT 連接到第三方應用程式。

這是 AI 的 App Store 時刻,AI 經歷了「iPhone」時刻後,如今也有了應用商店。

這些插件使 ChatGPT 能夠與開發人員定義的 API 進行交互,極大增強 ChatGPT 的功能,適應無數廣泛的場景。

👇️進入下方網站就可以申請進入等候名單,優先體驗 ChatGPT 插件

https://openai.com/waitlist/plugins

AI + App = ∞

ChatGPT...

OpenAI 團隊對話實錄:ChatGPT 很酷,但它還很糟糕

當 OpenAI 在 2022 年 11 月底悄悄推出 ChatGPT 時,這家位於舊金山的人工智慧公司幾乎不抱任何期望。誠然,OpenAI 內部沒有人預料到這將引發一場病毒式的巨大熱潮。

自那時起,該公司一直在瘋狂追趕——並試圖從中獲利。

據 OpenAI 政策部門的 Sandhini Agarwal 說,ChatGPT 最初被視為「研究預覽版」:對兩年前的技術的更加成熟的版本的預告,更重要的是,通過公眾的反饋嘗試糾正其中的一些缺陷。

「我們不想過分宣傳它, 宣稱這是一個重大的根本性進步」,參與了 ChatGPT 研發工作的 OpenAI 研究員 Liam Fedus 說道。

為了深入了解這款聊天機器人——它是如何開發的,OpenAI...

工程師危了 AI已設計100多晶片:生產力提高3倍 功耗降低25%

最近一段時間ChatGPT的火熱讓大家看到了AI人工智慧技術的潛力,很多工作已經可以被AI取代,現在晶片工程師也感覺到危險了,因為AI已經可以設計晶片,效果還很不錯,生產力提升3倍。

這個AI工具是EDA巨頭Synopsys推出的DSO.ai(Design Space Optimization AI,該公司日前表示DSO.ai已經成功為ST意法、SK海力士等客戶設計了超過100款晶片,將這些公司的生產力提高了3倍,設計的晶片功耗降低了25%,同時核心面積更小。

這個DSO.ai主要做了哪些工作?從命名來看,AI工具主要負責晶片的布線規劃,特別是現在流行的多晶片設計,這里面涉及大量的重復性工作,適合AI發揮作用。

晶片設計領域有個PPA的理念,指的是性能Performance、功耗Power及面積Area,性能越強,功耗越低,面積越小是理論上最好的,但這需要均衡三者,非常考驗設計師的能力經驗。

AI工具可以自主探索設計空間以實現最佳PPA方案,解放了很多工程師資源,提高了團隊工作效率,讓工程師可以創造出更有差異化的功能。

AI設計晶片未來肯定會更加流行,對於人們擔心的工作被取代,Synopsys安慰說AI可以把工程師從疊代工作中解放出來,去從事更有創新性的工作,甚至可以緩解人才短缺的問題。

來源:快科技

微軟 ChatGPT 版必應實測來了!真的完爆 Google 嗎?

冰火兩重天,這是兩天內接連開了 AI+搜索新品發布會的微軟、Google 的境遇。

宣布將 AI 集成搜索後,微軟必應的全球下載量激增 10 倍,因為現場演示的效果實在出色。

同樣是在活動上宣布將 AI 功能加入搜索,但 Google 的 Bard 因為演示中提供了錯誤的圖片而遭受質疑,「翻車」的 Google 一夜之間市值蒸發了 1056 億美元(約 7172 億元)。

對比如此強烈,難道微軟的「新必應」表現真的那麼好?

全球只有幾千名用戶可以在台式機上體驗新必應的功能,要想看新必應和 AI 的結合到底如何,還得看國外科技記者們在微軟總部的親身體驗:

和 ChatGPT 做比較

新必應哪些不如傳統搜索

用邪惡角度「突破」新必應

現在在必應中工作的 AI...

重磅!微軟發布 ChatGPT 版搜尋引擎,用上了比 ChatGPT 更強大的技術

ChatGPT 強大嗎?2 個月內累積超過 1 億的用戶覺得它很強,所以他們才會持續不斷和它對話。

但 OpenAI 覺得類似的大型語言模型還能更強。所以它們和微軟一起把這個更強的語言模型放到了搜尋引擎必應里,讓他用對話的方式給用戶解答搜索的難題。

這個模型加入搜索後提供的回答會更有相關性,考慮時效性,注重用戶體驗。可以這麼說,微軟的搜尋引擎必應,現在站在了 ChatGPT 的肩膀上。

必應+ChatGPT:這次徹底疊代搜索

搜索是兩個大公司短兵相接的主戰場。

作為全球最知名的搜尋引擎,Google 龐大的用戶數量和多年搜索服務的經驗都讓他們有底氣不懼怕任何新的搜尋引擎。微軟的必應則多年「活」在 Google 的陰影之下,努力努力再努力,也只做到了全球市場占有率的 3.03%,就這都已經是第二了。

但現在,第二名迎來了新轉機——史上增長最快的消費者應用 ChatGPT 搭上了必應這輛車,說要一起迎接搜索的新時代。

微軟正式發布了自己的「新必應」,一個集成 ChatGPT 的新版搜尋引擎。每個人都可以試用它,但想要自己嘗試個性化搜索只能加入候補名單,之後就是漫長的等待。微軟表示將會緩慢推出新的必應界面,而從昨天 ChatGPT 又卡死能推測出,這個速度可能比想像中更慢。

▲ 甚至體驗該服務也成了促活的手段

之前就有部分用戶不經意間試用到了「新必應」,微軟現場展示的搜尋引擎和之前用戶嘗鮮的產品並無不同。

搜索框更「大」了,你不需要輸入 1-2 個關鍵詞,支持 1000 個字符的拓展搜索框讓你可以更精確地搜索。同時搜索結果頁面,「全部」結果一欄的旁邊也不再是圖片、新聞等項目,而是「Chat」的選項,點擊就能看到「歡迎來到新必應」的簡單介紹。

在微軟的介紹中,「新必應」最值得關注的技術突破就是它運行的是...

我問了國外最火的「網紅」11 個大問題,他說我可以買 100 萬元的耐克鞋

今天的推文有點特別,因為它幾乎不是人寫的。

不是罵我自己,而是對這位最近全網爆火的「網紅」的稱贊。

它就是最近被熱議的人工智慧界新選手——ChatGPT。

這個工具不僅能對話、發代碼、寫劇本,連馬斯克都忍不住感嘆:

ChatGPT 非常好。我們離強大到危險的 AI 不遠了!

▲圖片來自:analyticsindiamag.com

所以 ChatGPT 究竟是何方神聖?

我們對它來了一次瘋狂的現場考試,借我們特別關注的 10 個大公司:優衣庫、耐克、宜家、星巴克、肯德基、戴森、杜蕾斯……來測試 ChatGPT 的信息、邏輯、情感、倫理、創作等多方面能力,看看它到底有多「聰明」。

話不多說,進入正題。

註:以下內容皆為虛構,如有雷同都怪 AI。

第一題:優衣庫/考三觀

第二題:肯德基/考冷靜力

第三題:宜家/考應變力

第四題:Lululemon/考戰鬥力

第五題:任天堂/考創作力

第六題:杜蕾斯/考忍耐力

第七題:耐克/考判斷力

第八題:星巴克/考洞察力

第九題:可口可樂/考分辨力

第十題:戴森/考魄力

第十一題:未來題/考潛力

最後:附加題

註:題圖來自 analyticsinsight.net

來源:愛范兒

IBM AIU晶片揭秘:5nm 32核心、230億個電晶體

今年10月,IBM發布了旗下首款人工智慧計算單元(Artificial Intelligent Unit,AIU)片上系統。

這是一種專用集成電路 (ASIC),旨在更快、更高效地訓練和運行需要大規模並行計算的深度學習模型。

AIU:專為現代AI計算打造

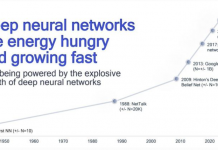

在過去多年來,業界主要是利用CPU、GPU來運行深度學習模型,但是隨著人工智慧模型的數量正呈指數級增長。

同時深度學習模型也越來越龐大,有數十億甚至數萬億的參數,需要的算力也是越來越高,而CPU、GPU這類傳統架構的晶片的AI算力增長已經遇到了瓶頸。

△深度神經網絡對於算力的需求增長迅速

根據 IBM 的說法,深度學習模型傳統上依賴於 CPU 和 GPU 協處理器的組合來訓練和運行模型。

CPU 的靈活性和高精度非常適合通用軟體應用程式,但是,在訓練和運行需要大規模並行 AI 操作的深度學習模型時,CPU卻處於劣勢。

GPU最初是為渲染圖形圖像而開發的,但後來該技術發現了在AI計算中使用的優勢。

但是,CPU和GPU都是在深度學習革命之前設計的,現在他們的效率增長已經落後於深度學習對於算力的指數級增長,業界真正需要的是針對矩陣和向量乘法運算類型進行優化的通用晶片來進行深度學習。

基於此,IBM Research AI Hardware Center在過去五年中一直專注於開發下一代晶片和人工智慧系統,希望以每年將人工智慧硬體效率提高 2.5 倍,並能夠在 2029 年以比 2019 年快1000倍的速度訓練和運行人工智慧模型。

最新AIU晶片則是IBM推出的首款針對現代 AI...

雙十一背後 藏了個價值千億的AI推薦系統

“天空為什麼是藍的?螢火蟲為什麼可以發光?為什麼雙眼總是一起轉動?”面對小朋友的十萬個為什麼,父母、老師總會藉助儲備的知識,或者查閱書籍解答疑問。

但隨著內容的爆發性增長,想要得到一個問題精準的答案難度越來越大。

早年使用網上購物平台的用戶,需要一步步根據商品的分類搜索,才能在海量的商品中找到適合自己的商品。

2022年的雙十一,普通的消費者不僅可以輕輕松松就篩選出自己想要的商品,還會收到非常符合自己喜好的商品、直播的推薦。

這背後隱藏了推薦系統的變遷,在小朋友問父母問題的場景里,父母其實就充當的是小朋友的推薦系統,但普通人的知識儲備畢竟有限。網際網路時代,有了搜尋引擎,但還不足夠。

再後來,AI技術的興起,幫助了推薦系統大步前進,無論是購物平台的商品推薦,直播平台的主播推薦,還是視頻平台的視頻內容推薦,越來越多的人開始感嘆,AI更懂自己。

AI推薦系統,也默默成為了網際網路公司業務中重要的組成部分。數據顯示,在一些全球大型在線網站上,即使推薦內容的相關性僅提高 1%,其銷量也會增加數十億,AI推薦系統無疑是藏在眾多網際網路應用背後的高價值系統。

不過,高價值的AI推薦系統目前還有被少數公司負擔得起,如何才能實現AI推薦系統的普及?我們又合適才能擁有完美的AI推薦系統呢?

推薦系統背後的算力演進

推薦系統並不新鮮,網際網路公司們為了能夠提升業績和客戶滿意度,十多年前就開始了推薦系統的研究與應用,早年間他們採用傳統的方法,比如協同過濾等,CPU也足以滿足那時推薦系統的需求。

但隨著推薦系統應用需求和算法的演進,系統越來越復雜,需要更加強大的底層算力作為支撐,推薦系統的開發者發現一個問題,通信節點間的性能遇到了瓶頸。

也就是說,在伺服器達到一定的規模之後,繼續增加伺服器的數量已經很難提升推薦系統的效果。

這就促使推薦系統的推動者們尋找更強大且更合適的算力支撐。當然,這個過程中還有一個重要的推動力——AI。在推薦系統中引入AI之後,能夠增加推薦系統的效果,但與此同時也讓推薦系統變得越來越復雜。

一個典型的推薦系統,包含了召回、過濾等過程,AI的引入,需要使用越來越多的數據進行訓練,以達到預期的效果。

“推薦系統中引入深度學習之後,大家還是會習慣性先用CPU,但後來發現在深度學習的算法里多加幾層神經網絡可能就算不動了。”

NVIDIA亞太區開發與技術部總經理李曦鵬在2022雲棲大會期間對雷峰網說,“GPU此時有明顯的優勢,GPU的算力遠高於CPU,同時GPU的帶寬比CPU高非常多,我們的Hopper架構GPU的帶寬已經達到3TB / s。”

但要加速推薦系統,不止是從CPU遷移到GPU這麼簡單。

GPU如何加速AI推薦系統?

推薦系統中AI的引入,讓推薦系統變得更加復雜的同時,對算力的需求也呈現出指數級的上升。

在推薦系統中,有大量的嵌入表(Embedding),包含各種推薦系統所需的特徵,比如性別、年齡等等,嵌入表被用於將輸入數據中的離散特徵映射到向量,以便下游的神經網絡進行處理,大小可以達到TB級。

嵌入表通常是記憶體帶寬和容量密集型,對於計算的需求不大,需要很大的內容容量和帶寬進行快速讀取,這對於CPU而言是一個明顯的挑戰。

此時,採用GPU有兩個顯著的優勢,李曦鵬說:“一個是GPU的記憶體帶寬遠高於普通伺服器,另一個是遷移之後將原來節點上的通信從原來CPU和GPU的PCIe通信,變成了GPU和GPU之間的NVLink通信,速度提升幾倍。”

接下來,就需要用AI模型進行計算,此時可能是計算密集也可能是記憶體帶寬密集。更麻煩的是,由於模型越來越大,超出了GPU板載的存儲容量,沒辦法存儲完整的模型,需要把它分塊,嵌入表就需要做模型並行,而DNN部分需要數據並行。在這個過程中,從模型並行到數據並行,需要做非常多數據交換,成了大量計算節點間密集的通信。

“推薦系統需要的不僅僅是GPU,而是加速計算。”李曦鵬指出,“加速計算不是一個簡單的晶片或者硬體,而是一個包含硬體、軟體以及上層應用的一整套解決方案。”

比如英偉達為推薦系統推出的NVIDIA Merlin。在預處理方面,NVIDIA Merlin NVTabular可以實現加速。

針對嵌入表,Merlin Distributed-Embeddings可以方便TensorFlow 2 用戶用短短幾行代碼輕松完成大規模的推薦模型訓練。並且,NVIDIA Merlin Distributed-Embeddings 的性能表現也十分突出,DGX-A100上的Merlin Distributed-Embeddings 方案比僅使用 CPU 的解決方案實現了驚人的683倍加速。

NVIDIA Merlin還有HugeCTR的開源框架,目標是優化 NVIDIA GPU 上的大規模推薦。

也就是說,NVIDIA Merlin是一個針對推薦系統,近似於一個端到端的解決方案。

即便如此,推薦系統的普及依舊面臨著巨大的挑戰。

普及推薦系統的兩大挑戰

推薦系統作為高價值的AI系統,普及面臨的兩大挑戰就是差異化以及高門檻。

“我們充分理解,由於業務的不同於推薦系統有很大的差異,我們會盡量把NVIDIA Merlin的功能進行模塊化,客戶可以根據需求選擇不同的模塊,使用的模塊越多,效果也會更好。”李曦鵬說,“我們通過Merlin的模塊化解決問題的同時,也通過和像阿里雲這樣的雲計算服務商合作推動推薦系統的普及。”

不同的推薦系統使用的算法並不相同,雖然如今AI大模型的應用越來越廣泛,並且大模型在美國人工智慧學術界將其稱為基礎模型(Foundation Model),但這並不意味著所有推薦系統都需要使用大模型。

李曦鵬的觀點是,大模型提供一個更大的嘗試空間,其表徵能力也更強,所以主流公司的模型越來越大,但主流公司也會有一些小的業務,或許也會有一些小的模型。如今主流的公司已經過渡到了GPU方案,比較重點的業務是全GPU的解決方案。所以,在算法上,即便主流公司也有階梯。

“先進模型對於中小企業來說收益可能沒那麼大,因為他們的業務體量沒那麼大,而通過雲計算的方式,以及GPU的解決方案,可以幫他們降低門檻和成本。”李曦鵬進一步表示。

差異化需求之外,推薦系統普及的另一大挑戰就是高門檻。

“網際網路巨頭有成百上千人的團隊在做推薦系統,中小企業很難投入這麼多。

但通過我們和阿里雲這樣有能力的雲服務提供商合作,給中小公司開放一些更高級的API,有一些預定義的模型能夠實現不錯的推薦系統,投入一兩個數據科學家,這將有利於推薦系統的普及。”李曦鵬說。

推薦系統的普及,將能夠代表加速計算巨大的想像空間。

10年100倍,加速計算價值千億的巨大空間

過去幾十年間,得益於摩爾定律,算力在持續增長。但如今摩爾定律已經放緩,從最初每年1.5倍性能的提升,下降到如今每年1.1-1.2倍的提升。摩爾定律帶來的算力提升已經難以滿足包括推薦系統在內應用對算力指數級的性能增長需求。

“接下來的十年,所有的計算任務都將被加速。我們已經加速了世界上5%的計算任務——價值百億美金。加速計算會降低計算任務的成本,提高能源利用率,給工業界帶來更多的能力做更多的事情。”英偉達CEO黃仁勛在今年十月時表示。

僅看推薦系統,Mordor...

史上最強自拍神器正在誕生!秒殺一眾攝影旗艦和 P 圖軟體

自拍後你要花多久才能把圖片修成自己想要的風格?

AI 說你不需要努力,只要給我 5-10 張圖我能給你生成不同類型的自拍。不僅能男變女,還能變風格,變背景,變發際線。

是的,AI 已經能做到這一步了,文末的網址就是幫它做到這一步的大功臣。

自拍再也不用拚命了,AI 都能給你做出來

@郵輪新聞 曾公開指責過一位女士不顧危險只想拍美圖的跨欄自拍行為。這位女士為了拍出一張足夠好看的照片,跨越了郵輪房間的護欄,站在了僅有幾十厘米的窄小露台上淡定自拍。

為了自己的自拍能比別人好看一點,有不少人都曾像這個女士一樣踏足危險區域。只是幾年的技術發展,AI 已經可以來替你完成這些工作了。

AI 能直接幫你脫穎而出,一鍵為你生成風格不同但同樣抓人眼球的照片。

為此,Strmr 也得感謝 Fabian Stelzer。

要不是這個 AI 愛好者在 Twitter 上曬出了自己生成的自拍照,Strmr 的強大功能也不會流傳得那麼廣。酒香也怕巷子深,熱愛分享的 Fabian Stelzer 曬出多風格自拍,急需類似服務的用戶就充滿了熱情。

原因很簡單,AI 產出的自拍質量高,且風格獨特。

Stelzer 上傳了一張自拍照後,Strmr 就根據自拍照為原型進行了多次的定製調整,生成風格完全不相同的照片,背景設置 AI 也能給你安排得明明白白,有的甚至像頂級雜誌的封面圖。

在生成的一些照片案例中,伍德斯托克音樂節生成的照片就很有 1969...

Google 說人類活到 200 歲不是夢,但地球首富想要的是長生不老

9 月 21 日,為期一周的 2022 年全球人工智慧峰會在沙烏地阿拉伯利雅得閉幕,大會的主題是「人工智慧造福人類」。

如何「造福」人類,最引人注目的還是「健康長壽」項目。Insilico Medicine 的創始人 Alex Zhavoronkov,在會上再度燃起人們的希望。該公司試圖將深度學習等新一代人工智慧技術,應用於靶點識別、藥物發現以及抗衰老研究領域。

每次人工智慧峰會都將掀起一波未來主義風潮,而「延年益壽」和「返老還童」的藥物,是其中最值得期待的承諾。至少在十幾年前,Google 旗下的藥物開發 Calico 公司,就告訴人們活到 200 歲不是夢。

AI 制藥,大生意

利用 AI 研發抗衰藥物,主要是想克服過去研發新藥的痛點。

研發新藥,再推向市場是一個復雜且消耗資源的過程。這個過程涉及疾病假說的確認、疾病或病理關鍵靶點的發現和驗證、苗頭化合物(hits)和先導化合物(leads)的篩選測試……動物試驗上活性和安全性的證實、監管機構批准後的臨床試驗等等。

每一個過程,制藥公司都已經反復實踐,依然解決不了生產率低下的問題。新藥研發的失敗率高達 90%。

Insilico 打造了三個 AI 工具:分別是用於靶點發現的 PandaOmics,用於分子生成的 Chemistry42、用於臨床試驗設計和預測的 InClinico。他們的策略是,讓...

老黃亮出「雷神」超級晶片 NVIDIA又領先了幾光年

2022年又是NVIDIA在AI加速計算賽道里飛速狂奔的一年,進一步拉大了與追趕者的差距。

先是今年3月發布了性能有數量級飛躍的Hopper架構GPU H100。今天,NVIDIA CEO黃仁勛在GTC 2022上宣布H100全面量產,但根據美國政府的最新規定,未經許可,NVIDIA不能出口、轉讓H100 GPU在中國市場上使用。

對此,黃仁勛在GTC 2022期間回應,NVIDIA會推出不受限制的替代版本。當然,即便在現在的限制下,NVIDIA廣泛的產品線也能夠滿足客戶的絕大多數的需求。

不過,秋季GTC更值得關注的是史詩級的超級晶片DRIVE Thor(雷神),這款最新的超級計算機將於2025年上市,AI性能高達2000TOPS的DRIVE Thor SoC將可能變革智能汽車行業。

當然,黃仁勛也不忘用超強的AI算力普惠包括醫療和工業在內的邊緣計算領域,推出了基於NVIDIAIGX邊緣AI計算平台及解決方案。

另外,黃仁勛還更新了曾吸引了無數關注的NVIDIAJetson Nano,最新推出的Jetson Orin Nano相比上一代實現了80倍的性能飛躍,價格維持在比較親民的199美元起。

如果說春季GTC 2022的H100 GPU樹立了高性能AI晶片的新標杆,那秋季GTC的無疑會讓自動駕駛晶片和邊緣AI晶片的追趕者們感受到了壓力。

黃仁勛也給遊戲玩家帶來了值得興奮的新一代GeForce RTX 40系列GPU(RTX 40系顯卡GTC「炸場」發布,性能提升70%,價格再創新高)。

看起來,從雲端到邊緣端,從現實世界到元宇宙,NVIDIA都想通過創新保持一騎絕塵。

史詩級汽車SoC平台雷神

大算力汽車晶片已經成為趨勢,但作為領導者,NVIDIA在2022年給出了一個讓人驚艷的產品Thor(雷神)。

全新Thor超級晶片可提供每秒2,000萬億次浮點運算性能,取代了DRIVE發展路線圖中的Atlan,能夠與目前被用於量產汽車、可提供每秒254萬億次浮點運算性能的DRIVE Orin無縫銜接。

對於為什麼用Thor取代Atlan更改發展路線圖,黃仁勛也做出了解釋:“Atlan是已經商用的Orin的下一代產品,是幾年前的項目,但因為出現了令人不可思議的Hopper、AdaGPU和Grace GPU,我們不願意為此再等兩年,於是決定用Thor取代Atlan,並集成了最新的技術,有了Thor超級晶片。”

NVIDIAThor的強大之處在於,一個基於Thor晶片的系統可以完成所有工作的計算機取代目前汽車內的單獨計算機,利用具有廣泛隔離(包括 MIG)的功能安全設計技術來防止單獨的任務相互干擾。

目前,想要實現汽車中的主動安全、停車、駕駛員監測、攝像頭後視鏡、集群和車載信息娛樂系統等功能通常需要不同的計算機提供支持。

NVIDIA正在引領自動駕駛新的未來,也就是由在中央計算機上運行的軟體統一提供支持,並隨著時間的推移不斷改進。

據黃仁勛介紹,基於Thor晶片的系統可以將智能汽車的所有功能都集中在單個AI計算機上,“車載計算資源的集中化可以將成本降低數百美元”。

具體來看,DRIVE Thor平台集Hopper的Transformer Engine、基於Ada的GPU和Grace CPU於一身。

基於新的架構和引擎,Thor晶片具有8位浮點 (FP8)...

Zen4+RDNA3 AMD下一代APU跑起來了:第一次集成AI引擎

AMD 6月份公布的路線圖顯示,,相關技術來自重金收購的賽靈思(Xilinx)。

AMD適應性與嵌入式計算事業部總裁Viector Peng最新披露,具備賽靈思AI加速引擎的下一代消費級銳龍處理器,已經在AMD實驗室內運行起來了!

他沒有透露更多具體細節,但很顯然這指的就是Pheonix Point,按照晶片開發流程周期,說不定能在明年初的CES 2023上正式發布。

AMD AIE引擎將對標Intel 13/14代酷睿里的APU單元,可為特定應用負載進行智能加速。

根據官方信息,Pheonix Point將採用4nm工藝製造,集成Zen4 CPU架構、RDNA3 GPU架構,,面向頂級輕薄筆記本。

非官方曝料顯示,它會有最多8個CPU核心,GPU計算單元超過12個,支持DDR5/LPDDR5記憶體、PCIe 5.0總線,熱設計功耗35-45W。

再往後的Strix Point,將升級更先進工藝,CPU架構升級Zen5,GPU架構升級RNDA3+,將命名為銳龍7045系列。

來源:快科技

Intel 14代酷睿新增VPU單元:AI性能暴漲、功耗更低

Intel不僅是手握高性能x86處理器,今年還殺進了高性能GPU市場,同時還有個殺手鐧,那就是掌握了多種架構的AI晶片,AI能力也是Intel越來越重視的,明年的14代酷睿會新增一個VPU單元,大幅提升AI性能,還能降低功耗。

Intel對酷睿處理器AI的重視已經有幾年時間了,10代酷睿Ice Lake上就增加了AI功能,當時是通過GNA加速器實現的,支持專用的AI指令集,後面的11代、12代酷睿也在不斷強化AI功能。

從今年底的13代酷睿開始,Intel會再次加強AI,會用上自家Movidius AI晶片的能力,而在明年的14代酷睿Meteor Lake上,Intel會首次使用多晶片整合封裝,藉此機會直接增加一個新的功能單元VPU,也就是視覺計算單元。

這個VP基於第三代Movidius VPU,代號Keem Bay,專門針對低功耗場景下的AI加速而設計的,此前Intel數據顯示其性能在3T到7.1TFLOPS之間,是上代的10倍,功耗只有6W左右,能效秒殺NVIDIA、華為海思等AI晶片。

集成VPU之後,不僅AI性能暴漲,它還可以解放GPU,目前很多AI加速工作是通過GPU實現的,在14代酷睿上,圖像識別之類的工作就可以從GPU轉移到VPU中,降低GPU功耗。

來源:快科技

首發「4nm EUV」工藝 Intel 14代酷睿新增AI單元:性能暴漲

Intel今年底將推出13代酷睿Raptor Lake,這是12的酷睿的改進版,升級8P+16E架構,最多24核32線程,其他規劃變化不大,而真正架構大改的是明年的14代酷睿Meteor Lake系列。

14代酷睿將首次引入Intel 4製造工藝,並支持EUV光刻,雖然它就是原來的7nm,但是Intel認為它相當於業界的4nm,並且首次採用多晶片整合封裝,CPU、核顯、輸入輸出等各自獨立,製造工藝也不盡相同。

在14代酷睿的核心單元中,最新的Linux代碼中顯示Intel會加入新的AI單元,命名為VPU,可以進一步加速深度學習、AI人工智慧的性能。

據了解,這個VPU單元的設計來自於Intel的Movidius,後者是Intel 6年前收購的AI公司,當時他們創造的VPU架構是革命性的,只需要1.5W功率就可以實現4TOPS的性能,能效比非常強大。

14代酷睿中的VPU單元具體性能如何還不好說,但是6年多過去了,AI性能只會大幅提升,14代酷睿在AI上的表現毫無疑問會很優秀,性能暴漲是沒跑的。

剩下的就看Intel如何發揮好處理器中的AI性能了,比如之前演示過的XeSS遊戲加速技術,如果14代酷睿的AI單元能跑這個,那麼玩遊戲的性能就有類似DLSS或者FSR 2.0那樣的奇效。

來源:快科技

85萬核心的世界最大AI晶片打破記錄:要”殺死” GPU

以造出世界上最大加速器晶片CS-2 Wafer Scale Engine聞名的公司Cerebras宣布,他們已經在利用「巨芯」進行人工智慧訓練上走出了重要的一步,訓練出了單晶片上全世界最大的NLP(自然語言處理)AI模型。

該模型具有20億個參數,基於CS-2晶片進行訓練。

這塊全世界最大的加速器晶片採用7nm製程工藝,由一整塊方形的晶圓刻蝕而成。

它的大小數百倍於主流晶片,具有15KW的功率,集成了2.6萬億個7nm電晶體,封裝了850000個內核和40GB記憶體。

圖1 CS-2 Wafer Scale Engine晶片

單晶片訓練AI大模型新紀錄

NLP模型的開發是人工智慧中的一個重要領域。利用NLP模型,人工智慧可以「理解」文字含義,並進行相應的動作。OpenAI的DALL.E模型就是一個典型的NLP模型。這個模型可以將使用者的輸入的文字信息轉化為圖片輸出。

比如當使用者輸入「牛油果形狀的扶手椅」後,AI就會自動生成若干與這句話對應的圖像。

圖:AI接收信息後生成的「牛油果形狀扶手椅」圖片

不止於此,該模型還能夠使AI理解物種、幾何、歷史時代等復雜的知識。

但要實現這一切並不容易,NLP模型的傳統開發具有極高的算力成本和技術門檻。

實際上,如果只討論數字,Cerebras開發的這一模型20億的參數量在同行的襯托下,顯得有些平平無奇。

前面提到的DALL.E模型具有120億個參數,而目前最大的模型是DeepMind於去年年底推出的Gopher,具有2800億個參數。

但除去驚人的數字外,Cerebras開發的NLP還有一個巨大的突破:它降低了NLP模型的開發難度。

「巨芯」如何打敗GPU?

按照傳統流程,開發NLP模型需要開發者將巨大的NLP模型切分若干個功能部分,並將他們的工作負載分散到成百上千個圖形處理單元上。

數以千百計的圖形處理單元對廠商來說意味著巨大的成本。

技術上的困難也同樣使廠商們痛苦不堪。

切分模型是一個定製的問題,每個神經網絡、每個GPU的規格、以及將他們連接(或互聯)在一起的網絡都是獨一無二的,並且不能跨系統移植。

廠商必須在第一次訓練前將這些因素統統考慮清楚。

這項工作極其復雜,有時候甚至需要幾個月的時間才能完成。

Cerebras表示,這是NLP模型訓練中「最痛苦的方面之一」,只有極少數公司擁有開發NLP所必要的資源和專業知識。對於人工智慧行業中的其他公司而言,NLP的訓練則太昂貴、太耗時且無法使用。

但如果單個晶片就能夠支持20億個參數的模型,就意味著不需要使用海量的GPU分散訓練模型的工作量。這可以為廠商節省數千個GPU的訓練成本和相關的硬體、擴展要求,同時這也使廠商不必經歷切分模型並將其工作負載分配給數千個GPU的痛苦。

Cerebras也並未僅僅執拗於數字,評價一個模型的好壞,參數的數量並不是唯一標準。

比起希望誕生於「巨芯」上的模型「努力」,Cerebras更希望的是模型「聰明」。

之所以Cerebras能夠在參數量上取得爆炸式增長,是因為利用了權重流技術。這項技術可以將計算和記憶體的占用量解耦,並允許將記憶體擴展到足以存儲AI工作負載中增加的任何數量的參數。

由於這項突破,設置模型的時間從幾個月減少到了幾分鍾,並且開發者在GPT-J和GPT-Neo等型號之間「只需幾次按鍵」就可以完成切換。這讓NLP的開發變得更加簡單。

這使得NLP領域出現了新的變化。

正如Intersect360 Research 首席研究官 Dan Olds 對Cerebras取得成就的評價:「Cerebras 能夠以具有成本效益、易於訪問的方式將大型語言模型帶給大眾,這為人工智慧開辟了一個激動人心的新時代。」

來源:快科技