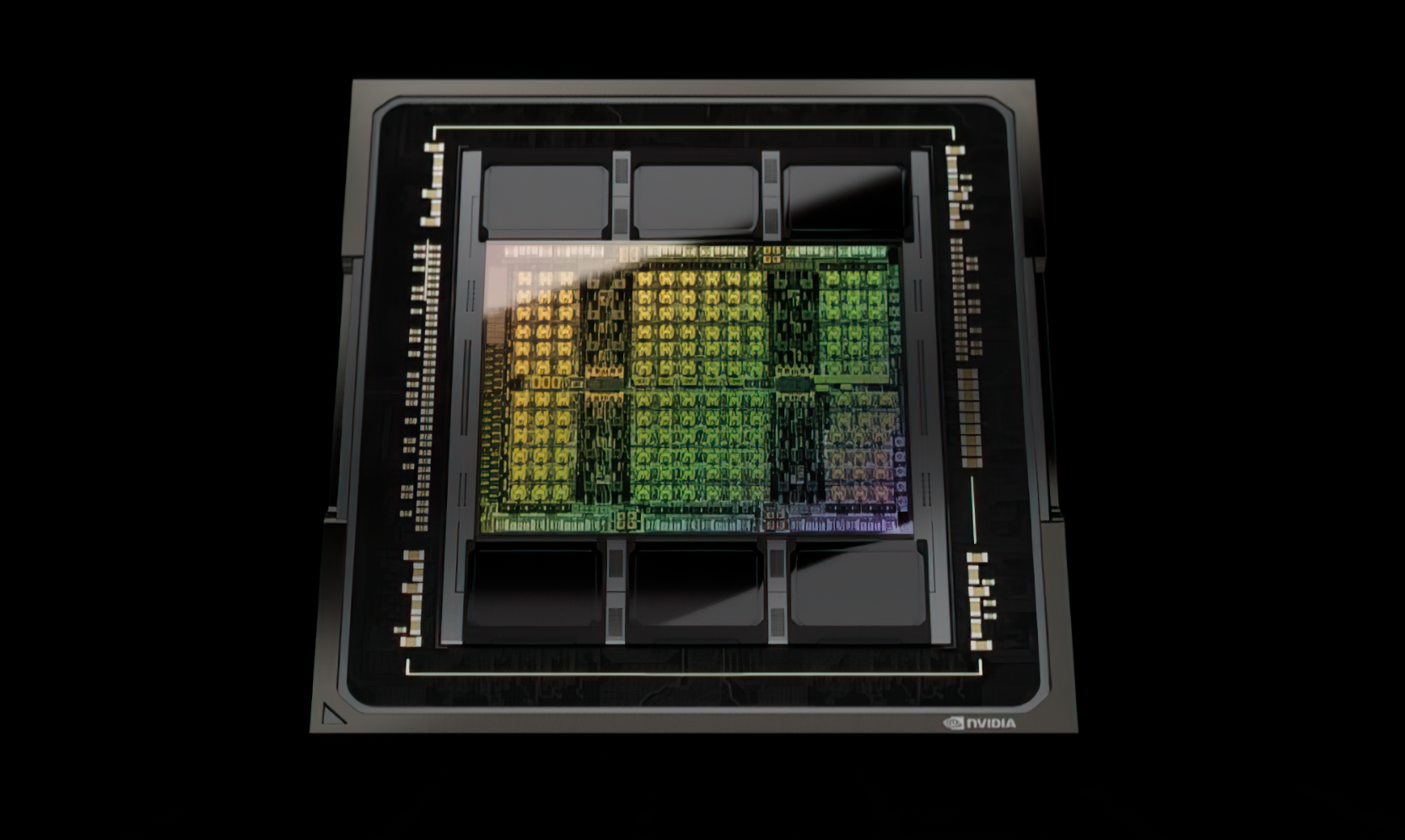

ChatGPT作為當下最火爆的AI應用,之所以能達到如此“聰明”的程度,背後離不開海量的訓練,離不開強大的算力,使用的是NVIDIA A100加速計算卡。

GTC 2023春季技術大會上,NVIDIA又發布了頂級的H100 NVL,它是已有H100系列的特殊加強版,專為大型語言模型(LLM)進行優化,是部署ChatGPT等應用的理想平台。

H100 NVL單卡具備多達94GB HBM3高帶寬顯存(記憶體),照此容量看顯然是開啟了完整的6144-bit位寬,並啟用了全部六顆,等效頻率按照5.1GHz計算的話,帶寬就是恐怖的3.9GB/。

但也有個問題,六顆HBM3顯存總容量應該是96GB,但是這里少了2GB,官方沒有解釋,猜測還是出於良品率考慮,屏蔽了少數存儲單元。

相比之下,H100 PCIe/XM版本都只開啟了5120-bit位寬,六個顯存位只使用五個,容量均為80GB,區別在於一個是HBM2e 2TB/帶寬,一個是HBM3 3.35TB/帶寬。

H100 NVL還可以雙卡組成一個計算節點,彼此通過PCIe 5.0總線互連,總顯存容量就是188GB,總顯存帶寬7.8TB/,NVLink帶寬600GB/,總功耗可達700-800W。

計算性能相當於H100 SXM的整整兩倍,意味著也開啟了全部16896個CUDA核心、528個Tensor核心,其中FP64雙精度浮點性能64TFlops,FP32單精度浮點性能134TFlops。

再加上Transformer引擎加速的輔佐,在數據中心規模,H100 NVL與上一代A100相比,GPT-3上的推理性能提高了多達12倍。

H100 NVL將在今年下半年開始出貨,價格……盡情想像去吧。

值得一提的是,NVIDIA還同時推出了其他兩套推理平台:

NVIDIA L4:

適用於AI視頻,性能比CPU高出120倍,能效提高99,提供強大的的視頻解碼和轉碼能力、視頻流式傳輸、增強現實、生成式AI視頻等。

NVIDIA L40:

適用於圖像生成,針對圖形以及AI支持的2D、視頻和3D圖像生成進行了優化,與上一代產品相比,Stable Diffusion推理性能提高7倍,Omniverse性能提高12倍。

順帶一提,適用於圖形推薦模型、矢量資料庫、圖神經網絡,通過NVLink-C2C 900GB/帶寬連接CPU和GPU,數據傳輸和查詢速度比PCIe 5.0快了7倍。

來源:快科技