CPU TDP功耗升至300W 微軟Google准備把服務器扔到海中

隨着CPU處理器的性能越來越強大,核心越來越多,功耗的負面影響也日趨嚴重了,普通人多的那點電費不算什麼,但是對Google、微軟這樣擁有龐大數據中心的公司來說,功耗增加麻煩大了。

數據中心的一個重要成本就來自於功耗及散熱,功耗高了不僅電費多,而且散熱系統也大筆花錢,風冷已經不行了,很多數據中心開始上水冷、油冷。

但是這還不行,因為功耗、發熱還是太大了,AMD的64核霄龍處理器TDP達到了280W,Intel的10nm IceLake-SP系列也會達到250W-300W的TDP區間,相比以往的100W-200W還是提升了不少。

現在大型數據中心公司已經腦洞大開,甚至考慮把服務器扔到海水中降溫,微軟、Google等公司都在研究這種散熱方式。

事實上,微軟早在2018年就啟動了一個試驗計劃,2018年6月1日,微軟將一個長約12米,直徑接近3米的圓柱形數據中心,沉入蘇格蘭東北部的奧克尼群島海底,這個裝置包裹着864台服務器,可以存儲27.6PB的數據。

運行2年之後,微軟已經在去年6月日將服務器打撈出來了,結果顯示各方面的性能都要比傳統數據中心要好,故障率都只有後者的1/8。

當然,現在這個技術還在研究階段,實驗的服務器還是比較少,大型數據中心的規模要大得多,需要長期的實驗。

作者:憲瑞來源:快科技

全球超算TOP500新榜單 日本蟬聯第一、中國屈居第四

本文經授權轉載,其它媒體轉載請經超能網同意

TOP500官方公布了第56期榜單,日本的Fugaku超算鞏固了在榜單中第一的地位,也反映出榜單上性能增長曲線趨於平緩。雖然有兩個新系統成功進入前十名,但整個榜單錄得的新入榜數量是自1993年該項目開始以來最少的。

在高性能Linpack(HPL)基準里,榜單的入圍門檻上升至1.32 PetaFLOPS,與2020年6月排名中記錄的1.23 PetaFLOPS相比有小幅增長。

Top500的總性能也從6月的2.22 ExaFLOPS增長到最新榜單上的2.43 ExaFLOPS。但每個系統的平均性能幾乎沒有任何增長,從6個月前的145,363個核心增長到當前榜單中的145,465個核心。

不過前十名中也有一些顯著的進展,包括兩個新系統,以及排名第一的Fugaku超級計算機創下的新高。

得益於這段時間內添加的新硬件,Fugaku將其HPL性能增長到442 PetaFLOPS,與該系統在2020年6月首次亮相時的416 PetaFLOPS相比,有小幅增長。

更重要的是,Fugaku將其混合精度HPC-AI基準上的性能提高到2.0 ExaFLOPS,優於其六個月前1.4 ExaFLOPS的記錄。這代表着在任何類型的硬件上,對任何精度的基準測量值首次超過1 ExaFLOPS。

Top500前十名:

1、Fugaku,由富士通建造,安裝在日本神戶的RIKEN計算科學中心(R-CCS)。擁有442 PetaFLOPS的新世界紀錄。這使其領先榜單中排名第二的系統三倍。

2、Summit,是IBM在田納西州橡樹嶺國家實驗室(ORNL)建造的系統,以148.8 PetaFLOPS的性能保持着美國最快的系統。擁有4356個節點,每個節點都容納了兩個22核Power9 CPU和6個NVIDIA Tesla V100 GPU。

3、位於加利福尼亞州勞倫斯-利弗莫爾國家實驗室的系統Sierra,以94.6 PetaFLOPS的HPL排名第三。其架構與Summit非常相似,其4320個節點中的每個節點都配備了兩顆Power9 CPU和四顆NVIDIA Tesla V100 GPU。

4、由中國國家並行計算機工程與技術研究中心(NRCPC)開發並安裝在無錫國家超級計算中心的神威太湖之光位列第四,它完全採用了Sunway SW26010處理器,在HPL上實現了93 PetaFLOPS。

5、Selene,它是NVIDIA公司內部安裝的NVIDIA DGX...

NVIDIA打造英國最強大超級計算機「劍橋1」 解決新冠病毒等醫學難題

日前, NVIDIA官方宣布,正在打造英國最強大的超級計算機,幫助英國醫療健康領域的研究人員藉助AI解決包括COVID-19在內的緊迫的醫學難題。

預計年底前上線的Cambridge-1超級計算機,將採用NVIDIA DGX SuperPOD系統,具備超過400 petaflops AI性能和8 petaflops Linpack性能。

在最新的全球最強超級計算機排名TOP500榜單中,Cambridge-1排名第29位。

同時,該超級計算機也躋身當前Green500榜單中全球最節能的超級計算機前三名。

NVIDIA創始人兼首席執行官黃仁勛在GTC大會主題演講中表示:「為了解決全球醫療健康領域最緊迫的挑戰,我們需要強大的計算資源來將AI加以利用。Cambridge-1超級計算機將成為英國的創新中心,進一步推動英國研究人員在關鍵醫療和新藥研發方面的開創性工作。

NVIDIA早前曾宣布,其將在劍橋創建AI卓越中心的計劃。該中心將配備全新的基於ARM的超級計算機,並作為全英國AI研究人員、科學家和初創公司的合作中心。

隨着該計劃的開展,Cambridge-1將成為該卓越中心的一部分。未來,該中心會擴展更多超級計算機,以支持英國更多的產業。

據悉,Cambridge-1是NVIDIA為外部研究而設計和建造的第一台超級計算機。由80個通過NVIDIA Mellanox InfiniBand網絡連接的NVIDIA DGX A100 系統構建的Cambridge-1,將幫助研究人員和學者解決最具挑戰性的大規模AI訓練、推理和數據科學等工作負載。

模塊化的DGX SuperPOD架構只需要短短數周,就能完成安裝並運行傳統超級計算機需要數年時間才能部署的系統。NVIDIA將針對Cambridge-1投資約4000萬英鎊。

- THE END -

轉載請註明出處:快科技

#NVIDIA#超級計算機

責任主編:朝暉作者:朝暉來源:快科技

IBM量子計算路線圖發布2023年推出1121量子位處理器

2019 年 9 月 18 日,IBM 在紐約舉行了新量子計算中心開幕儀式,並推出全球首台 53 位量子計算機。

2020 年 9 月 15 日,恰好過去一年,IBM 宣布了其量子計算技術路線圖,而這也是其首次公布未來量子計算硬件的規劃。

IBM 表示,正朝着在 2023 年年底前研製出超過 1000 位的量子處理器的目標努力,有朝一日還將推出超過一百萬位的處理器。

量子計算機的核心

1969 年,人類克服了前所未有的技術阻礙,首次登上月球、創造歷史。時至今日,人類卻依舊無法自如地用計算機精確捕捉浩渺宇宙中最為精細的部分。

正如 IBM 所說:

如果把思維局限於我們所知道的計算世界中,建造一個能真正捕捉原子運動的裝置,用以解決我們這個時代最具挑戰性的問題,幾乎是天方夜譚。

但正如登月一般,研究人員的一個宏大目標是:造出一台能夠超越傳統計算機的大型量子計算機。

本質上講,所謂量子計算就是將量子力學和計算理論結合,充分利用量子的疊加、糾纏、干涉等特性,展現出強大的計算能力。

而研製量子計算機,核心就是量子級計算機處理器,它能夠幫助量子計算機進行高速運算、處理量子信息。

具體來講,量子處理器依靠基本粒子的數學運算來擴展計算能力,運行的電路為量子電路,並非數字計算機的邏輯電路。用人造原子的電子量子態來表示數據,被稱為超導跨子量子位(superconducting transmon...

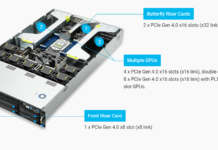

華碩推出7nm 64核服務器 夸張的11路PCIe 4.0、20萬兆網卡

華碩近年來也加強了工作站/服務器業務,日前正式推出了最新一代的2U單插槽GPU服務器ESC4000A-E10,配備了AMD 64核的EPYC 7002系列處理器,最多可支持11路PCIe 4.0。

華碩這個服務器適用於數據中心,適合執行AI、數據分析及HPC運算,因為它同時支持AMD及NVIDIA最新產品,包括EYPC 7002系列CPU及NVIDIA A100加速卡,這兩款都是最新的7nm工藝芯片。

AMD的EPYC 7002系列處理器不僅帶來了最多64核128線程CPU,還帶來了128條PCIe 4.0,而ESC4000A-E10就提供了多達11路PCIe 4.0。

具體來說,前置是PCIe 4.0 x8插槽,後置是2條PCIe 4.0 x16插槽,中間的則是8路單插槽或者4路雙插槽A100加速卡,總計11個插槽。

存儲方面,ESC4000A-E10支持8個熱插拔3.5寸/2.5寸硬盤,其中4個是NVMe的。

網絡方面,ESC4000A-E10還支持OCP 3.0網卡,最高可提供200Gbps網絡速度(20萬兆網速),適合連接多個節點。

作者:憲瑞來源:快科技

208核、6TB記憶體阿里雲發布全球最強雲服務器 挑戰摩爾定律極限

7月15日,阿里雲宣布推出第三代神龍雲服務器。與上一代相比,第三代神龍雲服務器的綜合性能提升高達160%,比目前全球最頂級雲服務器還要快30%以上,整體算力全球最強。

配置上,第三代神龍雲服務器產品家族提供了最多208核、最大6TB記憶體,雲盤IOPS高達100萬、網絡轉發高達2400萬、網絡帶寬高達100G,均為全球最高性能水平。

此外,支持CPU、GPU、NPU、FPGA等多種計算形態,具備3分鍾交付50萬核vCPU的極速擴容能力,是雲原生的最佳載體。

據介紹,基於最新款雲服務器的阿里雲第六代增強型實例,全系搭配ESSD系列雲盤,存儲轉發能力最多提升四倍;支持10Gbps突發內網帶寬,單卷延時大幅下降;性能等級按需配置,在線無損變配;

同時ESSD使用門檻大幅下降50%。Mysql和Redis性能提升超過15%,Nginx性能提升達100%。配合Alibaba Cloud Linux 2 LTS,啟動速度最多提升60%、運行時性能最多提升30%、穩定性最多提升50%。

此外,阿里雲ECS的單實例穩定性從原來的99.95%提升到99.975%,跨AZ多實例穩定性從原來的99.99%提升到99.995%,均為全球最高水準。

阿里雲彈性計算負責人張獻濤表示,傳統服務器主要依賴堆硬件提升性能,而阿里雲自研的神龍架構,基於硬件雲原生理念,創新性打破了虛擬化技術與CPU、記憶體、網卡等硬件的天然鴻溝,可發揮出比傳統物理機更強的性能。

過去十年,阿里雲的存儲性能提升了2000倍,網絡性能提升了500倍,整體算力以平均每12個月翻一番的速度增長,向摩爾定律的極限發起挑戰。

據了解,從最早單一的通用計算,到推出異構計算與高性能計算產品,再到今天的一系列新品,阿里雲彈性計算已覆蓋互聯網、金融、零售等行業近300種場景,支撐了各種流量高峰:如12306的春運搶票、微博熱點的暴漲流量、釘釘2小時擴容10萬台雲服務器等。

「隨着雲計算往縱深方向發展,軟硬一體和雲原生將成為雲計算技術架構的主流。「 張獻濤表示,「未來3-5年內,容器在IT架構里面占比將達到一半以上,雲原生需要我們將虛擬化推向極致,實現更極致的啟動速度、並發能力、部署密度等。」

優惠商品信息>>作者:朝暉來源:快科技

為何全球TOP10超級計算機8台都選英偉達?三大原因

本周,又是一年一度的高性能計算大會ISC。6月23日,又逢超級計算機TOP500榜單更新的時間。根據TOP500剛剛發布的超算TOP500榜單,中國部署了226台位列第一,美國部署了114台名列第二,日本以30台位居第三。

2020年6月更新的TOP500超算系統排名

細看這份最新的榜單,可以發現TOP10的超級計算機中有8台採用了英偉達GPU、InfiniBand網絡技術,或同時採用了兩種技術。TOP500榜單的系統中,有333套(三分之二)採用了英偉達的技術。

TOP500超算系統採用NVIDIA GPU、Mellanox網絡技術,或同時採用了這兩種技術數量

三年前的2017年6月,TOP500榜單使用英偉達和Mellanox(被英偉達以69億美元收購)的系統為203套,不到TOP500個超算系統的一半。為什麼在超算領域英偉達能進展如此迅猛?TOP100超算為何要選英偉達?

高速數據互聯技術普及

英偉達願意以高價收購Mellanox的重要原因是高速數據互聯在大數據時代變得越來越重要,在超算系統里尤為明顯。自2019年11月以來,TOP500榜單上使用HDR InfiniBand的系統數量幾乎增加了一倍。共有141台超級計算機使用了InfiniBand,自2019年6月以來增長了12%。

如今,TOP500榜單上有將近四分之三(74%)的全新InfiniBand系統採用了NVIDIA Mellanox HDR 200G InfiniBand,這是智能高速數據互聯技術迅速普及的一個體現。另外,在TOP500超級計算機中,有305套系統使用了NVIDIA Mellanox InfiniBand和Ethernet網絡(占61%)。

InfiniBand為排名前10的超級計算機中的7台提速

ISC期間,英偉達又宣布推出Mellanox UFM Cyber-AI平台,新的平台運用AI分析技術檢測安全威脅和運行問題並預測網絡故障,能夠大幅減少InfiniBand數據中心的停機時間。

收購Mellanox和智能高速數據互聯迅速普及是讓英偉達的產品在TOP500榜單中比例迅速提升的一個關鍵,但作為超算系統,性能更為關鍵。

超高性能系統像積木一樣搭建

特別是,當下AI和分析已成為科學計算中的新需求,全球各地的研究者都正在使用深度學習和數據分析預測各種最具潛力的領域,進而開展實驗。GTC2020上,英偉達就表示位於美國阿貢國家實驗室的研究者使用24台NVIDIA DGX A100系統組成的集群對數十億種藥物進行掃描,以尋找COVID-19的治療方法。

英偉達最新發布的安培(Ampere)架構GPU A100正是推動超算系統選用英偉達產品的關鍵之一。在一台6U服務器中集成了8顆A100 GPU以及NVIDIA Mellanox HDR InfiniBand網絡技術的NVIDIA DGX A100 AI系統單節點性能達到了創紀錄的5 petaflops。由140台 DGXA100系統組成的新一代DGX SuperPOD的AI算力更是高達700...

NVIDIA宣布50多款安培服務器 史上最大飛躍

NVIDIA今天宣布,NVIDIA與全球領先服務器製造商正在合作打造基於安培架構A100 GPU的高性能服務器,包括各種不同設計和配置,可以應對AI、數據、計算等領域最復雜的挑戰。

迄今為止,A100服務器的數量已經達到50多款,其中30多款在今年夏天上市,另外20多款前年底前推出,品牌包括華碩、Atos、思科、戴爾、富士通、技嘉、惠與(HPE)、浪潮、聯想、OSS(One Stop Systems)、廣達雲達科技(QCT)、超微。

具體包括——

華碩:ESC4000A-E10,單台最多四顆A100

Atos:BullSequana X2415,四顆A10

思科:一體化計算系統服務器、HyperFlex基礎設施系統

戴爾:PowerEdge服務器和方案

富士通:PRIMERGY系列服務器

技嘉:G481-HA0、G492-Z50、G492-Z51支持最多十顆A100,G292-Z40最多八顆

惠與:ProLiant DL380 Gen10服務器、Apollo 6500 Gen10系統

浪潮:NF5468M5、NF468M6、NF5468A5採用PCIe A100,NF5488M5-D、NF5488A5、NF5488M6、NF5688M6使用8路NVLink,NF5888M6使用16路NVLink

聯想:ThinkSystem SR670服務器首發,ThinkSystem、ThinkAgile產品線今秋擴展支持

OSS:4UV Gen 4 PCIe系統最多八顆A100

廣達:52BV-2U、D43KQ-2U、D52G-4U,最多八顆A100

超威:4U A+系統最多八顆A100和另外兩條PCIe 4.0擴展插槽

安培A100服務器

NVIDIA再次強調,作為安培架構的首款產品,A100 GPU的性能是上代伏特架構的最多20倍,這也是NVIDIA歷史上GPU性能最大的一次飛躍。

A100支持多實例GPU技術,可以讓一顆A100 GPU分區成七顆虛擬GPU,滿足不同的計算需求;支持第三代NVLink互連總線,可在一台服務器內部署多顆A100 GPU,構成一個更龐大的GPU;支持結構稀疏性,可讓GPU性能翻番。

安培A100計算卡

視頻會員活動匯總>>作者:上方文Q來源:快科技

NVIDIA 7nm安培首次進駐超算成就歐洲第一 AMD 7nm霄龍作陪

NVIDIA日前正式揭曉了採用7nm工藝的全新一代GPU架構「安培「(Ampere),主打高性能計算,很快就落地開花了。

Atos已經宣布了最新一代超算系統「BullSequana X2415」,首次集成NVIDIA安培架構的A100 GPU,而與之搭檔的是同樣7nm工藝的AMD霄龍處理器。

這套新的服務器基於NVIDIA HGX-A100模塊,每塊主板搭載四顆NVIDIA A100 GPU,通過第三代NVLink總線互連,與之搭配的則是兩顆AMD EPYC霄龍處理器,還有四個NVIDIA Mellanox InfiniBand網絡端口。

AMD霄龍處理器的型號未披露,不出意外應該是定製的高性能版霄龍7H12,64核心128線程,基準頻率提高到2.6GHz,最高加速頻率3.3GHz,三級緩存256MB,熱設計功耗280W。

德國於利希研究中心的JUWELS BullSequana超級計算系統將會率先部署,預計今年夏天就能上線投用,峰值計算能力可達70PFlops,成為歐洲最強的超算。

按照2019年11月的全球超算TOP500榜單,這樣的算力在全世界也能排第五位,而排名第二的美國Sierra超算採用了NVIDIA GV100 GPU。

作者:上方文Q來源:快科技

湖南研發華為鯤鵬CPU服務器下線 最多128核 26路SSD

4月28日,湖南媒體報道,湘江鯤鵬公司研發製造的首台服務器28日在長沙下線,這款服務器基於華為的鯤鵬處理器,2U機架最多128核。

湘江鯤鵬計算產業軟硬件生產線建設項目集研發、生產、銷售為一體,基於華為鯤鵬處理器研發和生產「湘江鯤鵬「自主品牌的服務器、PC機產品。

這條生產線從項目籌建到一期廠房交付共用時120天,從產線安裝到產品下線完成共用時20天,首條生產線投產後,預計三年可產50萬服務器,年產值100億元。

據介紹,「湘江鯤鵬」服務器採用2U雙路機架式產品形態,系統最高能夠提供128核、2.6GHz主頻的計算能力,最多28個NVMeSSD硬盤,具有高性能、低功耗以及靈活的擴展能力等特點。

湘江鯤鵬服務器適合為大數據分析、軟件定義存儲、Web等應用場景的工作負載進行高效加速,能夠滿足數據中心多樣性計算、綠色計算的需求,未來將在多個行業的數字化轉型過程中發揮重要作用。

2019年1月份,華為正式發布了「業內性能最高「的ARM架構服務器處理器「鯤鵬920」,華為自主設計,專為大數據處理、分布式存儲等應用設計,7nm工藝製造,最多64個核心,主頻2.6GHz,支持八通道DDR4記憶體,支持雙10萬兆網口、PCIe 4.0總線、CCIX互連。

華為強調,鯤鵬處理器具有高性能、高帶寬、高集成度、高效能四大特點。

作者:憲瑞來源:快科技

華為連發五款Intel最新平台服務器 性價比大漲42%

除了大力發展自己的鯤鵬、昇騰產業生態,在美國各種限制封殺之下,華為依然堅持與全球夥伴的密切合作,近日就發布了基於Intel最新一代Cascade Lake Refresh至強處理器的服務器產品。

Cascade Lake Refresh雖然只是個升級版,但是核心數更多、緩存容量更大、核心頻率更高、記憶體支持更強,官方稱與早期的Cascade Lake相比性能提升最高可達36%,性價比則增加了42%,而且依然是市面上唯一集成AI加速的主流服務器處理器。

作為Intel的戰略合作夥伴,華為數月前就啟動了FusionServer Pro系列服務器產品進行適配,現已完成主流產品的測試和上市,包括機架服務器1288H V5、2288H V5、2298 V5、5288 V5,高密服務器X6000 V5,刀片服務器E9000等。

華為FusionServer Pro 1288H V5、2288H V5是華為經典的通用型機架服務器,具有強勁性能、靈活配置、智慧節能、智能管理等特點。

2288H V5是一款2U2路機架服務器,可廣泛適用於雲計算虛擬化、數據庫、大數據等負載,提供24條DDR4記憶體插槽、10個PCIe擴展插槽,並可選配28個NVMe SSD、20個3.5寸硬盤或31個2.5寸硬盤的本地存儲資源,此外還集成華為DEMT智能功耗管理、FDM智能故障管理等創新技術,能夠有效降低運營成本、提升投資回報。

華為FusionServer Pro 2298 V5是一款2U2路存儲型機架服務器,混合存儲架構,數據分級存儲,支持24個3.5寸硬盤配置和4個NVMe SSD,適用於熱溫冷數據分級部署、歷史數據歸檔等業務需求,可降低數據存儲成本。

華為強調,未來將攜手Intel,專注客戶的數字化和智能化轉型,為提升數據中心智能化水平提供更加安全可靠的產品與解決方案。

作者:上方文Q來源:快科技

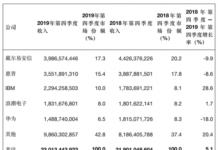

Gartner 2019全年全球服務器出貨量下降3.1% 戴爾第一 華為第四

3月23日,Gartner的最新統計數據顯示,全球服務器市場在2019年第四季度繼續保持增長,其收入和出貨量分別同比增長5.1%和11.7%。與2018年相比,2019年全年的全球服務器出貨量下降3.1%,收入下降2.5%。

在服務器出貨量方面,戴爾易安信在2019年第四季度繼續保持第一位,其市場份額為14.2%。惠普以10.8%的市場份額排在第二位。戴爾易安信和惠普的服務器出貨量均有所下降。聯想增長最為強勁,其2019年第四季度出貨量增長了22.4%。

根據2019年第四季度收入,戴爾易安信排在全球服務器市場的首位。盡管年同比下降了9.9%,但戴爾易安信的市場份額仍達到17.3%。排在第二位的是惠普公司(HPE),其市場份額為15.4%。IBM在本季度增長最為強勁,其增長率達到28.6%。

2019年全年數據方面,全球服務器市場在2019年的出貨量下降了3.1%,收入下降了2.5%。

在供應商表現方面,戴爾易安信的收入和出貨量均位居第一,分別占到20.5%和16.3%的市場份額。惠普公司的收入和出貨量市場份額分別為17.3%和12.3%,排在第二位。浪潮電子是前五名中唯一一家2019年收入和出貨量均實現增長的廠商。

Gartner分析認為,全球服務器市場在2020年的前景依然存在很大的不確定性。新冠病毒疫情所帶來的影響預計將減緩預測的增長。

來源:快科技

服務器市場衰退前的最後一次歡呼

除了幾次超大規模專業服務提供商和雲服務提供商踩剎車以外,對於服務器提供商而言,可能面臨十年來的一次災難。由於冠狀病毒的爆發以及全球各個經濟體的一些結構性問題,我們不再認為經濟不再是只本國的事情,現在可能是幾個季度甚至幾年的高點。

The Next Platform於2015年創建,但我們在系統市場的經驗可以追溯到1987年股市崩盤,崩盤最終導致了1980年代末和1990年代初的衰退,直到互聯網泡沫破滅,才真正得到解決。繁榮的到來,給科技領域以及 「電子商務「等行業注入了很多希望和現金。

當尋找IT的過渡點時,我們認為大蕭條是許多行業發生轉折的時間點。因此,財務分析通常可以追溯到經濟大蕭條時期,因為我們想看看與當時經歷的艱難時期相比現在的情況如何。

根據市場研究機構IDC的數據,距離上一次經濟衰退開始已經過去了十二年時間,2019年第四季度,服務器出貨量增長了14%,達到340萬台,收入增長了7.5%,達到253.5億美元。

收入增長的主要原因是,本季度超大規模專業服務提供商和雲服務提供商在基礎設施方面進行了大量投資,向這些公司提供設備的ODM銷售了105萬台機器,增長達到了驚人的53%,推動收入增長了37.9%,達到64.7億美元。

顯然,超大規模專業服務提供商和雲服務提供商主要購買x86服務器,並且隨着英特爾與AMD之間的競爭日益激烈,超大規模專業服務提供商在處理器上達成了很多交易,其中AMD以高性價比參與競爭,而英特爾則在不斷努力保持產品的競爭力並維持利潤率。

別為英特爾感到難過,即便面臨巨大的競爭壓力,這位芯片巨頭正的數據中心集團的收入創下歷史,營業利潤也非常高。IBM的System z大型機也在本季度出現增長,推動藍色巨人的收入增長了17.6%,僅略低於23億美元。由於在中國x86和Power服務器業務的增長,浪潮的收入增長了12.1%,達到17.4億美元。

其它服務器製造商要麼上升了幾個百分點,要麼下降了幾個百分點。正如我們最近在對Dell和HPE的數據中心業務的分析中所說的那樣,這兩家公司是企業級以及較小的雲的Tier 2、電信公司的服務提供商。戴爾和HPE的會計年度與日歷年度不同,因此IDC為我們調整了他們的應收數據與周期。

IDC估計,在第四季度,戴爾的銷售額為39.9億美元,下降了9.9%,從工廠運到渠道或客戶的服務器為549,488台,下降了5.4%。HPE方面,包括其在中國的H3C合作夥伴的出貨,HPE實現了4.7%的出貨量增長,達到507,228台,獲得了41.4億美元的收入,下降3.4%,但這是HPE在本季度再次進入頂級服務器製造商行列,這距離上一次已經有一段時間了。

聯想的服務器銷售額為14.2億美元,下降了2.6%。華為的銷售額為12.8億美元,增長了1.8%。我們估計思科的銷售額略低於10億美元,增長幅度為6%。

老實說,OEM廠商在2018年第四季度的表現相當不錯,盡管這次ODM的下降幅度非常大。

這是服務器收統計表,根據過去兩年的數據,有些不得不進行估算(以紅色粗體顯示):

下面圖表中顯示的數據可以追溯到大蕭時期:

現在,如果對IDC的這些數字進行一些數學計算,就會發現,如果剔除ODM的影響,它們在2019年第四季度的銷售總額中占25.5%,其餘的服務器市場的收入十分平淡。這好於第二季度的收入下降了8%,第三季度的收入下降了6.6%,但不同是,IBM的System z15銷售增加。

排除這一點,我們再次回到消極的觀點上,包括企業、服務提供商和電信公司的x86服務器。(作為一個集團,英特爾表示,其數據中心集團的電信和服務提供商客戶業務第四季度增長了14%,企業業務下降了7%,這與IDC分析的這一時期的服務器銷售相當。)

可以看到,在很大程度上由於英特爾和AMD在服務器CPU方面的競爭以及DRAM和閃存價格的下降,x86服務器的平均成本一直在下降。

x86服務器平台仍占服務器總出貨量的98%以上,增長了12.9%,達到335萬台(占總出貨量的98.5%),收入為224.4億美元(占總收入的89%)。非X86服務器出貨量增長了17.8%,達到29.1億美元,IBM的System z和Power Systems設備占非X86服務器市場份額的78.8%。

我們已經計算出自從大蕭條以來,近來計算量的增長速度快於價格下降的速度:

如你所見,近年來計算量需求很大,這主要是由於超大規模專業服務提供商和雲計算提供商的技術設施建設。如果出現衰退,那條曲線可以陡峭多少?或許可以找到答案。

IDC並未對冠狀病毒的爆發一窺究竟,這也可以理解,因為服務器供應鏈中斷的影響涉及對各行各業的企業、政府、服務提供商、超大規模專業服務提供商和雲服務提供商。具體的情況還沒人知道。關於全球經濟的的預測誤差都太大了,因為影響經濟趨勢的一些,許多潛在變量正在改變。

老實說,如果我們確實陷入了衰退,那麼毫無疑問,我們構建的平台的某些方面將會改變,這一次又一次地發生。平台過渡不是由衰退引起的,但通常會因衰退而加速,特別是如果公司可以省錢或做他們一直想做的事情,或者更好的是甚至從來沒有想過做的事情。

1970年代中期的經濟衰退持續了一段時間,幫助轉移到了專有的微型計算機,此後徘徊了一段時間,然後在1979年伊朗革命後又出現了一次溫和的衰退。當時,IBM和HP的專有的小型計算機開始興起,因為公司希望將其後台和工廠通過計算機化處理,但他們又買不起大型機。

到了1980年代後期,華爾街的石油價格沖擊和「非理性繁榮」震驚了整個經濟,RISC / Unix也從中受益。

從1995年到2001年的互聯網泡沫期正值Unix革命,然後英特爾硬件以及Linux和Windows Server的興起,在9月11日美國遭受攻擊之後,我們又經歷了一次衰退,這確實使RISC / Unix系統陷入困境,但讓英特爾x86服務器芯片和AMD Opterons在短短幾年內的興起,這些系統一直持續到2009年大衰退開始時,英特爾借鑒AMD,創建了「 Nehalem」 Xeon架構,今天在數據中心中仍使用它。

當最後一次衰退襲來時,VMware提供了一個可靠的企業級服務器虛擬化平台,該平台允許公司通過將物理服務器上的工作負載聚合到物理服務器上的虛擬機上,從而以更高的利用率運行現有設備。

AMD做出了一些架構上的折衷,並且在芯片中也存在一些錯誤,致使服務器製造商沒有耐心等待。它們全都落後於Nehalem,而思科系統盡其所能地融合了計算和網絡功能,並在建立Nutanix(成立於2011年)提供超融合的同時,掀起了整個服務器行業對融合平台的熱潮。

這次,如果經濟衰退能夠過去,AMD、Ampere Computing和Marvell可能是最大的受益者。

來源:快科技

黃仁勛宣布 NVIDIA GPU為ARM超級計算加速

在最新的超級計算大會上,NVIDIA創始人兼CEO黃仁勛宣布了一套用於構建GPU加速ARM服務器的參考設計,從而大大擴展GPU加速對於超級計算機的支持。

ARM架構在智能手機、物聯網設備中隨處可見,早已成為全球最流行的處理器架構,黃仁勛更是預計ARM如今已經覆蓋1000多億台計算設備,未來幾年這個數字將超過1萬億。

NVIDIA GPU加速的ARM服務器參考設計包括硬件和軟件基礎模塊,得到了高性能計算和ARM生態系統主要成員的支持,幾乎所有能在高性能計算中運行的工作都應該能夠在任何CPU上運行,目前已有30個應用已經啟動並開始運行。

比如,多家全球頂尖的超級計算中心已開始測試,包括美國橡樹嶺國家實驗室和桑迪亞國家實驗室、英國布里斯托大學、日本理化學研究所。

同時,NVIDIA正在與ARM、Ampere、富士通、美滿電子、HPE及其旗下Cray等生態夥伴展開合作,許多高性能計算軟件公司已開始使用NVIDIA CUDA-X庫為ARM生態帶來基於GPU的管理和監控工具。

今年早些時候,NVIDIA宣布CUDA-X軟件平台登陸ARM生態。根據此前的承諾,NVIDIA正在提供ARM兼容軟件開發套件的預覽版本,包含NVIDIA CUDA-X庫和加速計算開發工具。

文章糾錯

作者:上方文Q來源:快科技

Cray宣布全新存儲系統 一秒讀寫1.6TB、AMD二代霄龍加持

高性能計算廠商Cray今天發布了全新的高擴展性存儲系統「ClusterStor E1000「,面向下一代超大規模超級計算機、未來大型數據中心,可滿足海量存儲需求。

該系統基於Cray獨家的高度並行內部架構,採用單獨定製的AMD Rome第二代霄龍處理器,利用其豐富的PCIe 4.0高速通道,每一顆可搭配24塊NVMe SSD,也可以根據需要選擇機械盤或者兩種硬盤混合。

然後,這套存儲系統通過Cray 200Gbps Slingshot、Infiniband EDR/HDR、100/200GbE等網絡連接外部HPC高性能計算系統,並使用Cray下一代全局文件存儲系統、數據服務系統進行管理。

ClusterStor E1000入門版提供大約60TB可用存儲空間,吞吐帶寬約30GB/s,最高端版本每個機櫃可以做到16TB/s持續讀寫速度、50000 IOPS隨機讀寫速度,客戶也可以定製多個機櫃獲得更強性能。

該系統將於2020年第一季度開始出貨,美國未來的超大規模超算Aurora、Frontier、EI Captain都會使用它,總存儲空間超過1.3EB,AMD二代霄龍也會參與其中。

另外,美國國家能源研究科學計算中心(NERSC)會賠給一套30PB容量的全閃存系統。

作者:上方文Q來源:快科技

高速互連Gen-Z 1.1標準公布 加入PCIe 5.0

AMD剛剛引領開啟了PCIe 4.0時代,下一代的PCIe 5.0標準就已經開始上路了。

不久前,Intel出貨了支持PCIe 5.0的新款Agilex FPGA,並採用10nm工藝。現在,Gen-Z聯盟又發布了這一高速互連標準的最新1.1版本,也加入了PCIe 5.0。

PCIe 3.0標準還是遙遠的2010年發布的,所以在制定新標準的時候,PCI-SIG組織同步規劃了PCIe 4.0、PCIe 5.0,其中後者已在今年5月底完工,這意味着產業隨時可以利用它打造相關技術和產品了。

Gen-Z其實是一堆行業巨頭不滿意Intel技術壟斷和演進的情況下,合作搞出的新型高速互連標準,AMD、ARM、博通、Cray、戴爾EMC、HPE、華為、IBM、聯想、Mellanox(NVIDIA)、美光、紅帽、三星、希捷、SK海力士、西數、賽靈思等等都在其中。

Gen-Z面向數據中心和服務器市場,是一種以記憶體為中心的總線結構式協議,具備高帶寬、低延遲、先進工作負載、良好兼容性和經濟性等優點。

Gen-Z 1.0標準採用PCIe物理層和修改的IEEE 802.3以太網電氣層標準,但在物理層上只定義了PCIe 4.0,因此每通道速度最快只有25GT/s,要想充分利用標準的全部性能,也必須滿足PHY物理層面的所有規定。

Gen-Z 1.1則引入了PCIe 5.0,每通道速度提高到32GT/s,同時在比較寬松的技術限制下,就可以實現Gen-Z-E-PAM4-50G-Fabric鏈接,原始數據率53.125GT/s,一切都以達到更高的傳輸速度、更低的延遲為目標,畢竟這也是該標準的初衷。

更多技術細節這里就不具體展開了,相信未來也會有越來越多的PCIe 5.0技術和產品迅速出現。

至於說過渡性質比較大的PCIe 4.0是不是就沒價值了,當然也並非如此,畢竟全面商用和普及PCIe 5.0仍需時日,對於很多渴求高帶寬的高性能計算、網絡應用來說,PCIe 4.0已經可以解決燃眉之急,後續過渡到PCIe 5.0也非常方便。

作者:上方文Q來源:快科技

百度發布全球首款支持OAI標準和液冷的AI計算平台

近日,在荷蘭阿姆斯特丹舉行的OCP Regional Summit 2019大會上,百度與浪潮聯合發布了全球首款基於OCP OAI標準(開放加速器基礎設施)和液冷的AI計算新品X-MAN 4.0。

X-MAN 4.0是百度超級AI計算平台X-MAN系列產品的第四代,浪潮作為百度的重要合作夥伴之一,一直參與X-MAN系列產品的研發和生產,並X-MAN 4.0作為其目前在超級AI計平台上的最強有力產品推出。

X-MAN系列,從1.0到4.0

X-MAN系列是百度用於超大規模AI訓練的專用平台,已在百度的數據中心大規模應用。其中,第一代X-MAN 1.0首次實現了AI計算硬件解耦架構;第二代X-MAN 2.0首次將冷板式液冷散熱技術應用到AI計算產品里;第三代X-MAN 3.0則首次提出了模塊化標準化設計的理念。

第四代X-MAN 4.0作為全球首款基於OCPOAI標準(開放加速器基礎設施)和液冷的AI計算新品,平台的單節點能夠支持8個AI加速器。這些加速器之間採用了8port HCM(Hybrid Cube Mesh)的互聯架構,雙向通信帶寬高達56GBps,充分保證AI加速器的性能。

而在單個機櫃層面,X-MAN 4.0最大可支持32個AI加速器構建互聯集群,很好的增強了平台可擴展性。

X-MAN 4.0符合ODCC 3.0整機櫃規范,高度為4SU(182.5mm),寬21英寸(536.0mm),長度850mm,支持風冷、液冷散熱方式,並採用了更高效的48V供電方式。

百度超級AI計算平台X-MAN 4.0

OCP社區與OAI標準

OCP(Open Compute Project)即開放計算項目,它是由Facebook攜英特爾、Rackspace等公司於2011年成立的一個非營利組織,目的是與普通的IT產業共享更高效的服務器和數據中心設計。同時,它也是全球雲計算基礎硬件技術領域覆蓋面最廣、最有影響力的開源組織。

而OAI(Open Archives Initiative)標準是OCP社區里由百度主導並聯合Facebook、Microsoft等針對AI硬件加速模塊和系統設計所制定的標準。該標準用於指導AI硬件加速模塊和系統設計,它集合定義了AI硬件加速模塊本身、主板、互聯拓撲、機箱、供電、散熱以及系統管理等一系列設計規范。

目前,OAI標準也得到了眾多社區成員的支持,包括:Facebook、Microsoft、Google等互聯網企業,Intel、AMD、高通等AI芯片企業,及浪潮、IBM、聯想等系統供應商。

獲得眾多企業成員支持的 OAI標準

打造全球標準,加速AI進程

可以看到,由百度主導的OAI標準定義,在一定程度上推動了AI新硬件技術全球范圍內的創新與進步。

OAI標準的推行,不僅能夠直接使得相關廠商統一AI硬件加速模塊和系統設計,提高多元化AI加速芯片兼容性;而且還有利於促進不同AI加速器技術的開放融合,從而讓AI計算平台設計更加敏捷,產業配套更為簡化。

百度副總裁侯震宇曾表示:「OAI標準將極大提高不同AI硬件加速模塊和系統的互操作性,加速新AI硬件加速模塊的大規模落地應用,全球AI硬件生態系統都會從中受益。「這也代表了百度將自身在AI領域的最佳實踐共享至國際AI社區的初心。

來源:快科技