Tag: A100

美國緊急攔截24顆NVIDIA AI晶片發貨 怕進入中國

快科技2月1日消息,美國商務部針對中國自動駕駛卡車企業圖森科技(TuSimple)發出禁令,不允許其從美國向澳大利亞發貨24顆NVIDIA A100 GPU晶片。

澳大利亞並不在美國的高性能GPU禁運名單之列,但是美國政府擔心,這一批A100晶片最終可能會轉向中國。

圖森科技原本計劃將這批晶片發給位於澳大利亞的子公司,用於改進其半掛車的自動駕駛技術,而且強調不會發往中國。

圖森科技還解釋說,由於各種原因,他們正在減少在美國市場的業務,因此需要把美國子公司的一些資產轉給澳大利亞子公司使用。

對此行為,美國商務部、美國聯邦調查局(FBI)、美國證券交易委員會(SEC)、美國國家安全專家小組集體進行了幾個星期的調查,最終認定其違反出口管制條例,可能會向中國轉移技術,因此不許發貨。

在此之前,美國政府還要求圖森科技將其美國業務與中國業務完全分開。

無奈之下,圖森科技已經決定從納斯達克退市,從而免除未來的披露義務。

PS:美國政府剛剛把長江存儲、曠視科技、禾賽科技等十多家中企加入“中國軍方企業名單”,宣稱這些企業與中國軍方合作……好像美國科技企業跟美國軍方沒有合作似的……

來源:快科技

美國對中東禁售NVIDIA H100/A100加速卡:怕轉賣給中國

美國已經針對中國全面禁止銷售NVIDIA A100、H100等加速計算卡,但這還沒完,中東地區也給禁售了。

NVIDIA在一份聲明中披露,上個季度,美國政府發出通知,部分客戶和地區購買A100、H100等產品需要額外的許可協議,包括中東地區的一些國家。

不過,NVIDIA並未透露具體涉及哪些國家。

近些年,沙烏地阿拉伯、阿聯都在大力強化AI,並且購買了大量的NVIDIA產品,同時兩個國家與中國關系越來越密切。

美國政府的擔心有兩點,一是這些國家購買NVIDIA H100、A100產品後,可能會轉賣給中國,二是中國企業會在海外訓練自己的AI模型。

NVIDIA強調,雖然有新的禁令,但不會對其收入產生明顯影響,同時也在積極與美國政府溝通,希望解決此問題。

此前,NVIDIA曾公開表示,美國將升級對中國AI的監管措施,而新的禁令限制一旦實施,將導致NVIDIA失去在全球最大市場之一競爭和領先的機會。

來源:快科技

美國進一步限制高性能計算GPU出口:英偉達向中東出售A100/H100需額外許可

去年英偉達為了繞開相關的出口限制,推出了A800系列計算卡,專供中國市場使用。與原有的A100系列計算卡相比,A800系列的規格基本相同,比較大的區別在於NVLink互連總線的連接速率,前者為600 GB/s,後者限制在了400 GB/s。隨後在今年又推出了H800系列計算卡,以滿足出口管制的要求。

據相關媒體報導,英偉達在本周公開的一份監管文件里表示,在2024財年第二季度里收到了官方發出的通知,針對某些地區的客戶(包括中東在內)出售A100和H100計算卡,需要額外的許可要求。英偉達重申了目前已在中國銷售不受約束的替代產品,包括A800和H800計算卡。

雖然英偉達已在監管文件里披露了新的限制,不過並沒有說明具體哪些國家和地區會受到影響。近年來,沙烏地阿拉伯和阿聯一直在加強其人工智慧方面的實力,大量購入英偉達的計算卡,成為了重要的買家,新的措施多少對其都會有所影響。更為重要的是,這種做法是為了避免出售中東地區的A100和H100計算卡最後流入到中國市場。

英偉達表示,新的限制措施不會對其收入產生重大影響,目前正在嘗試通過合作的方式解決相關的問題。 ...

英偉達AI GPU需求激增:價格上漲40%,供應短缺延續至今年12月

過去幾個月來,隨著ChatGPT這樣的人工智慧工具在全球范圍內掀起了一股熱潮,越來越多的科技公司投身到相關的研發中,多模態大規模語言模型需要大量的計算來支撐,而英偉達的GPU成為了搶購的對象,包括A100和H100計算卡都是熱門的選擇,以至於供應可能無法及時跟上。

十多年前,英偉達就開始押注人工智慧是下一個風口,看起來多年的大量投資終於迎來了高額回報。據Digitimes報導,近期英偉達AI GPU的訂單增加,這也提升了台積電的晶圓開工率。

A100和H100的晶片都是由台積電負責代工,前者為7nm工藝,後者使用了名為4N的定製5nm工藝,盡管英偉達一直在盡力滿足需求,但人工智慧的浪潮對需求造成的影響是巨大的。為了繞過管制,英偉達還專門針對中國市場提供了A800和H800兩款產品,定價高出原建議零售價40%。即便如此,在大量的訂單面前,交貨周期也開始受到了影響,而英偉達希望先滿足非中國地區的需求。

目前交貨周期已從過往的3個月延長到了6個月,某些情況下可能要等待更長的時間,部分新的訂單估計要到今年12月才能完成,這意味著等待時間將超過6個月。市場對高性能計算的需求,一定程度上也擾亂了遊戲晶片的供應,因為英偉達打算將更多資源分配到人工智慧的需求上。 ...

英偉達推出A800系列計算卡:NVLink帶寬限制在400GB/s,專供中國市場

基於Ampere架構的A100系列計算卡在過去的兩年多里,被眾多高性能計算集群(HPC)所採用,這些GPU大量用於人工智慧和深度學習任務。即便英偉達今年推出了新一代基於Hopper架構的H100系列計算卡,出於種種原因,A100系列計算卡在數據中心仍有屬於自己的市場,一直在出貨。

據相關媒體報導,英偉達推出A800系列計算卡,專供中國市場使用。與原有的A100系列計算卡相比,A800系列的規格基本相同,比較大的區別在於NVLink互連總線的連接速率,前者為600 GB/s,後者限制在了400 GB/s。據了解,英偉達新產品是為了繞開相關的出口限制。

A800系列計算卡分為三個版本以及SXM和PCIe兩種不同形態,分別有40GB PCIe版、80GB PCIe版和80GB SXM版,不過這些計算卡FP64和FP32計算性能是相同的,分別是9.7 TFLOPS和19.5 TFLOPS。其中40GB PCIe版配備了40GB的HBM2顯存,帶寬為1555 GB/s,功耗為250W;80GB PCIe版配備了80GB的HBM2e顯存,帶寬為1935 GB/s,功耗為300W;80GB SXM版配備了80GB的HBM2e顯存,帶寬為2039 GB/s,功耗為400W。

英偉達官方在一份聲明中稱,A800系列計算卡已於2022年第三季度投入生產,作為目前A100系列計算卡的替代品出口到中國市場。由於出口管制的原因,英偉達曾表示可能會導致一個季度里損失約4億美元。 ...

英偉達准備推出水冷版A100計算卡:單槽規格,水管接頭在尾部

英偉達GTC 2020上推出了基於新一代Ampere架構的A100計算卡,其面積高達826mm²的GA100核心採用台積電7nm工藝製造。A100計算卡有兩種不同形態,一種是SXM4版,另一種是通用規格的PCIe版,後者僅限於兩塊GPU通過NVLink互聯。

據VideoCardz報導,英偉達正准備推出水冷版的A100計算卡,大機率是基於去年六月份發布的A100 PCIe版計算卡,配備80GB HBM2e顯存。數據中心GPU改用水冷散熱並不是什麼特別的事情,第三方早已有A100計算卡改水冷的套件,而且應用已十分廣泛,不過這次應該是英偉達自己官方的設計。雖然英偉達已發布了新一代基於Hopper架構的H100計算卡,但A100計算卡仍有不小的市場需求。

從圖片可以看到,水冷版的A100計算卡為單槽規格,水管接頭的位置在板卡的尾部,與8Pin的外接電源接口相連。原版採用的被動散熱設計為雙槽規格,對於一些工作站來說,散熱效果並不理想,且自行更換水冷模塊有一定風險,在部署方面可能又要多一個環節,官方推出水冷版本有利於某些用戶采購。

相比40GB HBM2版本的A100計算卡,80GB HBM2e版本的顯存速率由2.4Gbps提高到了3.2Gbps,顯存帶寬也由1.6TB/s變成了2TB/s,不過其他規格基本保持不變,包括19.5 TFLOPS的單精度性能和9.7 TFLOPS的雙精度性能。根據英偉達的介紹,更大顯存版本的A100計算卡非常適合各種對數據有巨大需求的應用,比如AI訓練、天氣預報和量子化學等領域,英偉達將其稱為全球最快的數據中心GPU。 ...

英偉達下一代GPU被Kestrel超級計算機採用,可能是Hopper架構計算卡

美國國家可再生能源實驗室(NREL)宣布,將打造名為Kestrel的新一代超級計算機。新系統將由惠普企業(HPE)構建,由英特爾Xeon Scalable Sapphire Rapids處理器和英偉達下一代用於HPC的GPU提供支持。

Kestrel超算採用了HPE的Cray Ex架構,可提供約44 FP64 PetaFLOPS的性能。如果以當今的超級計算機作為參照,大概能排在第七位。該系統將從2022年秋開始建造,2023年初完成,主要面向能源使用效率和可再生能源方面的研究。這些科學研究需要更強的性能並不奇怪,不過在CPU和GPU的搭配上,與目前正在構建的許多新款超級計算機有所不同。前者大多傾向於選擇AMD的EPYC系列處理器,後者則是首次現身的「Nvidia A100Next Tensor Core compute GPU」。

英偉達這款GPU很可能就是基於Hopper架構的產品,將採用台積電5nm工藝和CoWoS先進封裝。按照現有的資料,英特爾Sapphire Rapids處理器與英偉達新款計算卡將通過PCIe總線協同工作。由於英特爾的處理器不支持NVLink。英偉達的計算卡應該也不支持CXL協議,如何有效共享記憶體池是一個值得關注的問題。

該系統還將採用了HPE Slingshot,這是一種乙太網架構,針對更大的數據密集型和AI工作負載實現更高的傳輸速度和流量控制。通過使用HPE的Cray ClusterStor E1000連接超過75 PB的並行文件系統,在存儲上進行高速連接,以滿足處理以數據流為中心的復雜工作負載,實現交互式數據分析與可視化。 ...

英偉達發布全新HGX A100系統,以及配備80GB HBM2e顯存的A100 PCIe計算卡

英偉達宣布將通過人工智慧與高性能計算相融合的新技術為HGX AI超級計算平台注入動力,使超算可以為更多行業服務。

為了加快產業AI和HPC時代的到來,英偉達在其HGX平台中添加了三項關鍵技術,分別是NVIDIA A100 80GB PCIe GPU、NVIDIA NDR 400G InfiniBand網絡和NVIDIA Magnum IO GPUDirect Storage軟體。三者相結合,提供卓越的性能,以實現產業HPC的創新,英偉達CEO黃仁勛表示:

「HPC革命始於學術界,並迅速擴展到各行各業。產業各項關鍵趨勢正在推動超指數、超摩爾定律的發展速度,使HPC變成各行業都能使用的工具。NVIDIA的HGX平台為研究人員提供了卓越的高性能計算加速能力,以解決行業面臨的那些最棘手的問題。」

這也正式宣告了英偉達推出採用標準接口的A100 80GB計算卡,除了接口改變以及更低的TDP,這款產品與去年11月發布的SXM4版A100 80GB計算卡有完全相同的功能。更大的顯存容量和帶寬,可以保存更多的數據和更大的神經網絡,從而最大限度地減少節點間通信和能耗。此前英偉達更新的官方文檔中,已經有該款產品的信息。

此外,英偉達這次推出的Magnum IO GPUDirect Storage,與微軟的DirectStorage技術有著相似之處。在消費領域,微軟的技術可以提供對NVMe存儲的快速訪問,以提高某些工作負載的加載效率,英偉達的技術似乎專注於相似的訪問類型。 ...

英偉達將發布配備80GB HBM2e顯存的A100 PCIe版計算卡

在去年5月份,英偉達GTC 2020上推出了基於新一代Ampere架構的A100計算卡,其面積高達826mm2的GA100核心採用台積電7nm工藝製造。A100計算卡有兩種不同形態,一種是SXM4版,另一種是通用規格的PCIe版,後者僅限於兩塊GPU通過NVLink互聯。

在競爭對手AMD發布了基於新一代CDNA架構的Instinct MI100加速卡後,英偉達在去年11月份,推出了配置80GB HBM2e顯存的SXM4版A100計算卡,以更大的顯存容量應對挑戰。這款產品可提供2TB/s的顯存帶寬,高於40GB HBM2版的1.6TB/s。使用的HBM2e是HBM2改進型,頻率為3.2Gbps,而原來A100計算卡採用的HBM2顯存的頻率為2.4Gbps。其他規格基本保持不變,包括19.5 TFLOPS的單精度性能和9.7 TFLOPS的雙精度性能。

近日,英偉達在數據中心的官方文檔中,已悄悄加入了配備80GB HBM2e顯存的A100 PCIe版,這意味著SXM4和PCIe兩種不同形態都將提供40GB HBM2版和80GB HBM2e版。根據英偉達的介紹,A100 80GB版非常適合各種對數據有巨大需求的應用,比如AI訓練、天氣預報和量子化學等領域,英偉達將其稱為全球最快的數據中心GPU。

英偉達官方暫時還沒確認相關情況,不過更新文檔這個舉動,很可能預示著80GB HBM2e顯存的PCIe版A100計算卡即將發布。鑒於40GB HBM2版的A100計算卡的價格約1.5萬美元左右,預計這款配備80GB HBM2e顯存的A100 PCIe版計算卡可能會超過2萬美元。 ...

新加坡超算將橄欖枝拋向AMD和NVIDIA,將有10萬個Zen3內核和352個A100

今日新加坡國家超級電腦中心(NSCC)宣布,預計會在2022年初投入使用的10 PFLOPS超級計算機,將採用AMD Epyc

Milan處理器以及NVIDIA A100 Tensor Core GPU,性能是其前任的八倍。

這台NSCC的超級計算機將採用HPE的液冷Cray EX散熱架構,這也是這類系統在熱帶地區首次部署。這台超算將採用AMD第三代Eypc 7000

Milan處理器,總共擁有約100000個Zen3內核,以及352個NVIDIA A100 Tensor

Core,該系統將由大約900個節點組成,預計可提供10 PFLOPS的原始FP64計算能力,其中352個NVIDIA A100 Tensor

Core就可提供至少6.8 PFLOPS的算力,其餘3.2 PFLOPS就由AMD Epyc提供。同時,這套系統還將配備一個10PB Cray

ClusterStor E1000存儲系統,其讀寫性能將超過300GB/s

這台超算只是NSCC一系列超算計劃中的第一個,它將從即日起到2025年分階段部署,用來拓展與提升新加坡研究社區的高性能計算性能。並通過人工智慧和深度機械學習等工具來優化量子建模和軟體仿真,這套新的超算將會被用作生物醫學、基因組學、疾病、工程和高解析度天氣建模。

NSCC和HPE預計新超算會在2022年初投入使用,這套系統的成本為4000萬新元,約合1.95億人民幣。 ...

英偉達發布A100 80GB HBM2e加速卡,應對AMD威脅

據HOTHAREDWARE報導,英偉達官方發布了基於Ampere架構的A100已經被認為是高性能計算集群(HPC)的首選GPU,但為了鞏固自身在行業之中的位置,特別是競爭對手AMD發布了基於新一代CDNA架構的Instinct MI100加速卡,英偉達推出了搭載80GB HBM2e大容量顯存版的A100。

根據NVIDIA的介紹,A100

80GB版可提供2TB/s的帶寬,高於40GB HBM版的1.6TB/s。英偉達將其稱為全球最快的數據中心GPU,認為其非常適合各種對數據有巨大需求的應用,比如天氣預報和量子化學等。

這一次升級,除了將顯存增大了一倍,也擁有更快的速度。被稱為HBM2e的HBM2改進型,頻率為3.2Gbps,而A100

40GB版的頻率為2.4Gbps,這就是顯存帶寬增加的原因。其他規格基本保持不變,包括19.5 TFLOPS的單精度性能和9.7

TFLOPS的雙精度性能。

"在HPC和AI研究中取得最先進的成果需要建立最大規模的數據模型,但這些模型對記憶體容量和帶寬的要求比以往任何時候都高",英偉達深度學習研究副總裁Bryan Catanzaro,"A100 80GB GPU提供的顯存是半年前剛剛推出的前代產品的兩倍,並突破了每秒2TB的障礙,使研究人員能夠應對世界上最重要的科學和大數據挑戰"。

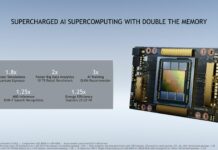

英偉達提供了一些基準測試的數據,最大的提升是以DLRM

Recommender為代表的AI深度學習,提升了3倍,其次是大數據分析,提升了2倍。這些方面提升效果是明顯的,對於需要進一步挖掘性能的客戶來說,這是一次可喜的升級。

升級後的80GB HBM2e版已經出現在NVIDIA新款DGX Station A100里面,它基本上是一個小型數據中心了,裝載了4塊A100 80GB 版加速卡可以提供2.5 PetaFLOPS的性能。

DGX Station A100將在本季度上市。

...

NVIDIA發布PCIe版本的A100加速卡:使用被動散熱,TDP降至250W

從P100時代開始,NVIDIA就會發布兩種不同形態的頂級加速卡,一種形態是NVIDIA自家開發出的SXM,需要配合自家的HGX主板使用,價格較為昂貴,但是可以提高整體的集成度,在一套系統里面集成更多的加速卡。另一種形態就是傳統的Add-in-Card,用的是PCIe的接口。此前NVIDIA已經推出了SMX形態的A100加速卡,基於最新的Ampere架構和GA100核心,現在他們「補充」發布了AIC形態的A100加速卡,採用的是PCIe接口和PCIe 4.0總線,可以裝載到傳統系統中使用。

PCIe形態的A100使用了完全的被動散熱設計,很明顯是要伺服器系統內部的暴力風扇來輔助散熱的,採用被動散熱設計也有利於安排系統內部的風道,達成更為高效的散熱。

除了TDP被限制在250W級別和NVLink連結數量被削減以外,PCIe形態的A100加速卡與SXM4形態在規格上是基本一致的,它能夠提供與SXM4版本相同的峰值性能。但由於它的散熱空間更為有限,NVIDIA將其功耗限制在250W,SXM4版本則為400W,這也就意味著PCIe版本的A100在持續性能輸出上面將不如SXM4版本的,官方給出了90%的相對性能數據,也算不上有太多的損失。

目前已經有非常多的伺服器OEM宣布推出採用A100加速卡的新產品,其中包括Dell、思科、惠普、聯想和華碩等廠商,目前已經有50多種型號,其中有30多種將會在今年夏天就上市,對於各大數據中心來說,這又是一次新的換代。 ...

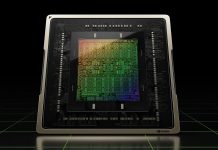

NVIDIA新一代Ampere架構簡單解讀:一次有改良有革命的架構升級

2020年5月14日晚間,NVIDIA的新一代Ampere架構隨最新的計算卡A100正式亮相,這張加速卡上面使用的GA100核心也是目前世界上最大的7nm核心,其面積高達826mm2。那麼這枚核心中包含的Ampere架構與前代相比究竟在哪些地方有不同呢?本文就帶各位一起簡單地看看這個NVIDIA最新一代圖形架構。

首先我們的旅程從整個GA100 GPU開始,下圖是官方提供的GA100 GPU全貌(可以點擊打開原圖)。

分割成了兩組的超大L2緩存和超高顯存帶寬

Ampere架構仍然沿用了成熟的GPC-TPC-SM多級架構,GA100內部包含8組GPC,每組GPC包含8組TPC,每組TPC又包含8組SM。主要的區別點在於,中間的L2緩存不再是統一的一組,而是被分割成了兩組。實際上,GA100的L2緩存相比起前代的GV100要大上近7倍——從原本的6MB直接跳到了40MB。大容量的L2緩存會在一定程度上減輕計算單元對顯存帶寬的依賴,不過為了避免訪問遠端L2緩存時出現延遲過高的問題,它被分成了兩塊,保證延遲不過高。這種大容量特性和分割結構讓GA100的L2緩存帶寬提升了2.3倍,同時硬體的緩存一致性保證應用程式可以自動利用大容量的L2緩存提升性能。

除了容量和結構上的變化,Ampere也在架構上引入了名為計算數據壓縮(Compute Data Compression)的新緩存特性,它可以加速非結構化的稀疏數據和其他可壓縮的數據,使DRAM的讀寫帶寬能夠提升4倍,L2中的讀取帶寬提升4倍,容量提升2倍。同時,針對大容量的L2緩存,Ampere為程式設計師提供了數據駐留控制,允許用戶對緩存數據進行管理,可以手動將一些數據保留在L2中,加速持久化的訪問。

另外在顯存帶寬上面,A100也有突破。它仍然使用了HBM2的顯存,一共五個活動堆棧,每個堆棧中有8片8Gb顯存,最終組成40GB的顯存,運行在1215MHz的頻率上,其顯存帶寬高達1555GB/s,是V100的1.7倍多。另外它具備ECC硬體校驗功能,需要占用額外的顯存,這也就是在架構圖和渲染圖上,GA100均擁有6組HBM2顯存,而只有5組是實際可用的原因了。而且不僅僅是顯存,GPU內部的所有寄存器、L1和L2緩存均支持ECC特性。

新的數據接口

再來看上下的外圍部分,首先比較顯眼的應該是PCI Express 4.0。相信我們的讀者對PCIe 4.0已經很熟悉了,這里也就不講具體的了,只要知道它的帶寬比3.0提升了一倍即可。

在NVIDIA的計算陣列中用的更多的是NVLink這個專門用來讓GPU實現互聯的接口,在Ampere上,NVLink升級到了第三代。第三代NVLink將每個信號對(signal pair)的數據速率提升到了50Gb/s,比前代幾乎提升一倍,單個第三代NVLink在每個方向上面能夠提供25GB/s的帶寬,這與上代類似,但少用了一半的信號對,這也使得GA100上面的NVLink鏈路總數直接擴增了一倍,達到12條,總帶寬達到600GB/s,比GV100提升一倍。

延續Volta的SM設計

看完更新了的數據交換接口,讓我們把這張圖放到放大鏡下面,來看一看Ampere,應該說是GA100的SM單元設計。

GA100的SM單元

如果要搞明白它的變化點,我們還要請出Volta架構和Turing架構的SM單元。

左GA100,右GV100

左GA100,右TU102

可以看到Ampere的SM單元設計保留了從Volta開始的分精度計算思路,將計算核心分成了針對整數計算的INT32單元和針對浮點計算的FP32、FP64單元和針對FP16、INT8等AI計算中常見的數據類型的Tensor Cores。從數量來看,每個SM仍然擁有64個FP32單元、64個INT32單元和32個FP64單元,這與Volta和Turing沒有太大的區別(Turing SM沒有FP64單元)。比較明顯的區別在於,在Ampere SM中,每SM僅包含四個Tensor Core。至於RT Cores?那是遊戲卡才有的,面對純計算用途的GA100自然不需要這玩意兒。

大幅加強的Tensor Cores

是的,Tensor Cores變少了,但是它變強了。在Ampere架構上,Tensor Cores升級到了第三代,這也是Ampere SM中變化最大的地方了。第三代Tensor Cores變得幾乎無所不能,它可以加速幾乎所有的常見數據類型,包括FP16、BF16、TF32、FP64、INT8、INT4和二進位。下面是官方的代際數據類型對比表:

不僅僅是支持的數據類型變多了,它的算力也有很大的提高,現在每個Tensor Cores在每個時鍾內可以執行256次FP16/FP32 FMA操作,在前代,這個數字是64次。也就是提高了足足4倍,於是,就算是每個SM中減少一半的Tensor Cores,它仍然能夠提供兩倍於前代的性能。

另外,為了提高Tensor Cores訓練AI時的效率,NVIDIA新創了一種名為TF32的數據類型,它擁有FP32的范圍和FP16的精度,對於調用Tensor Core的操作,它會自動啟用TF32進行處理。而沒有調用Tensor...

為了避免和特斯拉「撞車」,NVIDIA已經開始雪藏Tesla品牌

前些天NVIDIA在發布最新的計算卡時並沒有將它歸入到自己的加速卡品牌Tesla中,而是直接以A100的型號推出的。NVIDIA似乎有意要放棄使用Tesla這個品牌,而這背後的原因,是和越來越有名的車企特斯拉撞名字了。

NVIDIA已經向德國媒體heise確認了他們放棄了之前的命名方式,原因是他們的Tesla品牌名現在與加利福尼亞電動汽車製造商特斯拉混淆的風險太大了。NVIDIA甚至修改了一些已經發布的產品的名字,比如使用TU104核心的Tesla T4加速卡已經被重命名為NVIDIA T4。在官方語境下,很多原來還帶有Tesla品牌名的產品也不再加上Tesla前綴,比如前代旗艦加速卡Tesla V100已經被直接稱呼為V100。

最早的Tesla加速卡要追溯到G80時代。當時NVIDIA首先在GPU上面採用了更為先進的統一式流處理器設計,並引入了GPGPU通用計算特性,讓顯卡變身成為計算卡,那代架構代號就是Tesla,而同時登場的還有Tesla這個加速卡品牌,一用就是十多年。而特斯拉這家車企在近些年來越來越出名,一樣的品牌名字會帶來混淆,中文環境下還可以用特斯拉和Tesla來區別,而在英文環境下兩個就完全一樣只能靠產品型號來識別講的究竟是汽車還是加速卡。可能這讓NVIDIA感到頭痛,於是,在新產品上面他們開始淡化、雪藏這個品牌,直接以架構首字母+數字的形式來命名加速卡產品,比如A100就是Ampere架構加速卡中的旗艦。 ...