Tag: B100

黃仁勛拋出2700W功耗的真核彈 還有240TB顯存的AI超級計算機

快科技3月19日消息,今天凌晨,黃仁勛正式拿出了新一代Blackwell GPU架構,以及基於此的B100/B200 GPU晶片、GB200超級晶片、DGX超級計算機,再次將“戰術核彈”提升了全新的境界,傲視全球。

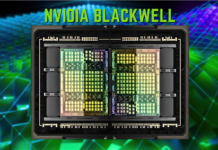

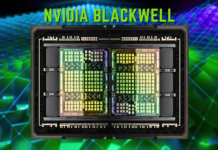

Blackwell B200 GPU首次採用了chiplet晶粒封裝,包含兩顆B100,而B200之間再通過帶寬翻倍達1.8TB/的第五代NVLink 5總線互連,最多可連接576塊。

B100採用專門定製的台積電4NP工藝製造(H100/RTX 40 4N工藝的增強版),已經達到雙倍光刻極限尺寸,彼此通過10TB/帶寬的片間互聯帶寬,連接成一塊統一的B200 GPU。

B100集成多達1040億個電晶體,比上代H100 800億個增加了足足30%,B200整體就是2080億個電晶體。

核心面積未公布,考慮到工藝極限應該不會比814平方毫米的H100大太多。

CUDA核心數量也沒說,但肯定會大大超過H100 16896個,不知道能不能突破2萬個?

每顆B100連接四顆24GB HBM3E顯存/內存,等效頻率8GHz,位寬4096-bit,帶寬達4TB/。

如此一來,B200就有多達192GB HBM3E,總位寬8096-bit,總帶寬8TB/,相比H100分別增加1.4倍、58%、1.4倍。

性能方面,B200新增支持FP4 Tensor數據格式,性能達到9PFlops(每秒9千萬億次),INT/FP8、FP16、TF32 Tensor性能分別達到4.5、2.25、1.1PFlops,分別提升1.2倍、1.3倍、1.3倍,但是FP64 Tensor性能反而下降了40%(依賴GB200),FP32、FP64 Vector性能則未公布。

Blackwell GPU還支持第二代Transformer引擎,支持全新的微張量縮放,在搭配TensorRT-LLM、NeMo Megatron框架中的先進動態范圍管理算法,從而在新型4位浮點AI推理能力下實現算力和模型大小的翻倍。

其他還有RAS可靠性專用引擎、安全AI、解壓縮引擎等。

至於功耗,B100控制在700W,和上代H100完全一致,B200則首次達到了1000W。

NVIDIA宣稱,Blackwell GPU能夠在10萬億參數的大模型上實現AI訓練和實時大語言模型推理。

GB200 Grace Blackwell是繼Grace Hopper之後的新一代超級晶片(Superchip),從單顆GPU+單顆CPU升級為兩顆GPU加一顆CPU,其中GPU部分就是B200,CPU部分不變還是Grace,彼此通過900GB/的帶寬實現超低功耗片間互聯。

在大語言模型推理工作負載方面,GB200超級晶片的性能對比H100提升了多達30倍。

不過代價也很大,GB200的功耗最高可達2700W,可以使用分冷,更推薦使用液冷。

基於GB200超級晶片,NVIDIA打造了新一代的AI超級計算機“DGX SuperPOD”,配備36塊超級晶片,也就是包含36顆Grace...

功耗高達1000W NVIDIA B200 GPU加速器明年到來

根據各方信息和路線圖,NVIDIA預計會在今年第二季度發布Blackwell架構的新一代GPU加速器“B100”,官方稱,是現在H200的兩倍甚至更多。

B100之後,還有更強大的升級版B200,一如現在H100、H200的關系。

戴爾營運長兼副董事長在最近的一次會議中確認了B200的存在,發布時間在明年。

他沒有披露更具體的規格,比如升級之處,但聲稱戴爾有能力搞定單顆GPU 1000W的功耗,甚至不需要液冷,這無疑是在暗示B200的功耗將大幅提高。

相比之下,H100 SMX版本的峰值功耗為700W。

NVIDIA GTC 2024圖形技術大會將於3月18-21日舉行,必然會披露新一代GPU加速器的情況,甚至有可能正式宣布。

來源:快科技

搞定1730億參數大語言模型 NVIDIA下代巨型GPU露出獠牙

快科技11月14日消息,NVIDIA第一次披露了下一代AI/HPC加速器的情況,架構代號Blackwell,核心編號GB200,加速器型號B100。

NVIDIA第一次公開確認,B100將在2024年發布,但未出更具體的時間表。

此前曝料稱,B100原計劃2024年第四季度推出,但因為AI需求太火爆,,現已進入供應鏈認證階段。

NVIDIA表示,B100加速器可以輕松搞定1730億參數的大語言模型,是現在H200的兩倍甚至更多。

雖然這不代表原始計算性能,但也足以令人望而生畏。

同時,B100還將帶來更高級的HBM高帶寬內存規格。

回顧歷史,Pascal P100、Ampere A100、Hopper H100、H200分別首發應用HBM2、HBM2e、HBM3、HBM3e。

接下來的B100肯定趕不上HBM4(規范還沒定呢),但必然會在堆疊容量、帶寬上繼續突破,大大超越現在的4.8TB/。

Blackwell架構同時也會用於圖形工作站和桌面遊戲,傳聞有GB202、GB203、GB205、GB206、GB207等不同核心,但是對於RTX 50系列,NVIDIA始終三緘其口,幾乎肯定到2025年才會發布。

,明年初的CES 2025首發三款型號RTX 4080 SUPER、RTX 4070 Ti SUPER、RTX 4070 SUPER。

來源:快科技

NVIDIA下一代巨型GPU B100快馬加鞭:緯創大戰富士康

AI產業實在太火爆,NVIDIA A100、H100都供不應求,下一代Blackwell B100也加快了速度,原計劃2024年第四季度發布,現在提前到了第二季度。

據報導,NVIDIA B100現在已經進入了供應鏈認證階段,簡單地說就是確定零部件供應商、代工製造商。

在基底供應商,緯創、富士康競爭激烈,結果緯創憑借更高的良品率等優勢,拿下了100%的訂單,至少在初期沒有富士康的份兒了。

但是富士康也並非沒有收獲,北美市場的H100、B100生產訂單已經被富士康包圓,將在美國、墨西哥、台灣等地製造。

另外,SK海力士將會獨家供應B100所需的新一代HBM3e高帶寬內存,而三星的要到明年晚些時候才會量產,能不能拿掉一部分訂單還未可知。

來源:快科技