Tag: 神經網絡

人工神經網絡能否駕馭生物神經元的「濃稠」程度 ?5 到 8 層可能並非極限

雖然我們糊狀的大腦似乎與計算機處理器中的晶片大相逕庭,但科學家對兩者的比較已經有很長的歷史。正如阿蘭·圖靈在 1952 年所說:「我們對大腦像冷粥一樣的稠度不感興趣。」也就是說,媒介並不重要,重要的是計算能力。 如今,最強大的人工智慧系統使用基於深度學習的機器學習方法,該算法通過調整大量的數據隱藏層相互連接的節點來擬合數據,這些節點形成的網絡被稱為深度神經網絡。顧名思義,深度神經網絡的靈感來自於大腦中真實的神經網絡,這些深度神經網絡的節點以真實的神經元為模型。

根據 20 世紀 50 年代神經科學家對神經元的了解,當時一種有影響力的神經元模型被稱為感知器,從那時起,我們對單個神經元計算復雜性的理解逐漸加深,人們了解到生物神經元比人工神經元更復雜,但是復雜的程度是多少?不得而知。

一個生物神經元可以和 5 到 8 層人工神經網絡相匹敵

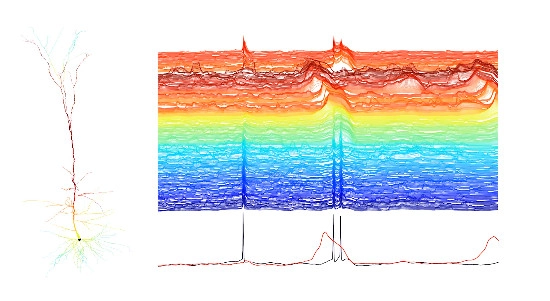

為了找到答案,耶路撒冷希伯來大學的David Beniaguev, Idan Segev和Michael London訓練了一個人工深度神經網絡來模擬生物神經元的計算。該研究表明,「一個深度神經網絡需要 5 到 8 層相互連接的人工神經元來才能表示單個生物神經元的復雜性。」

「我原以為它會更簡單,更小」Beniaguev 如是說。Beniaguev 也沒有預料到這種復雜性,他原來預計三到四層就足以捕獲單元內執行的計算。

在Google旗下的 AI 公司...

英特爾推出NNP-I神經網絡處理器:大改Ice Lake,添加Nervana推理處理引擎

人工智慧是當下最火熱的話題,從手機到超算都在其中增加AI的AI運算能力。英特爾在台北電腦展上推出了全新的Ice

Lake處理器,其中增添的AVX512指令集以增強其AI運算性能。不過英特爾的想法不止於此,根據Tom's

Hardware的報導,英特爾在位於以色列海法的研發中心推出了一款針對推理運算的Nervana神經網絡處理器,簡稱NNP-I。

圖片來自Tom's Hardware

這款處理器與常見的神經網絡處理器不同的是,它將此前發布的Ice

Lake處理器與Nervana神經網絡處理器結合,組成這款NNP-I處理器。但這款處理器與Ice Lake處理器有很大的不同,英特採用了Ice

Lake處理器的基礎設計並做出了修改,將其中的Gen

11核顯及顯示模塊去掉,將其替換成針對推理運算的AI加速器。同時英特爾還在這款處理器上添加了DSP引擎,用於未針對固定功能加速器優化的算法,為其他類型的AI運算提供兼容性。

而CPU部分依舊採用多個英特爾Sunny Cove架構的x86核心,但並不知道其核心數目。英特爾產品工程總經理Oren

Gershon模糊地稱他們移除了一些其他的核心為AI加速器騰出額外的位置,所以這款處理器可能採用了兩個處理器內核。

英特爾提供了包括m.2等幾種形式的加速卡樣式,因此它可以安裝在伺服器主板的標準m.2接口或PCIe擴展卡上。與一些專為AI設計的定製晶片不同,這款產品幾乎兼容所有的現代伺服器,甚至可以根據需要為伺服器添加多個NNP-I模塊。

英特爾也在軟體方面進行了優化,在使用NNP-I加速器時,伺服器可將全部神經網絡推理運算轉移到NNP-I處理器中,並在任務完成時通知伺服器中的Xeon主處理器。而且由於NNP-I處理器擁有完整的I/O模塊(擁有PCH),所以其可以訪問處理所需的數據,而且英特爾稱這並不會受到PCIe

x4帶寬的影響。

由於內部有全新的Sunny

Cove架構的x86內核,所以NNP-I也有AVX512指令集,支持VNNI深度學習指令,所以它技術適用於任何類型的AI負載,英特爾也提供了編譯器,為NNP-I加速器提供定製代碼。如PyTorch及TensorFlow等機器學習框架,NNP-I加速器可以幾乎無改動的運行支持這些框架的代碼。

英特爾Ice

Lake處理器的TDP為28W,而m.2接口有15W的功耗限制,但由於其可以插在PCIe擴展卡上,所以NNP-I加速器可以運行在更高的功耗下,以提供更好的性能。而具體性能方面英特爾並沒有透露,但英特爾已經向早期客戶提供樣品,並在今年晚些時候大批量生產。 ...