四月我們迎來了AI晶片三連發!

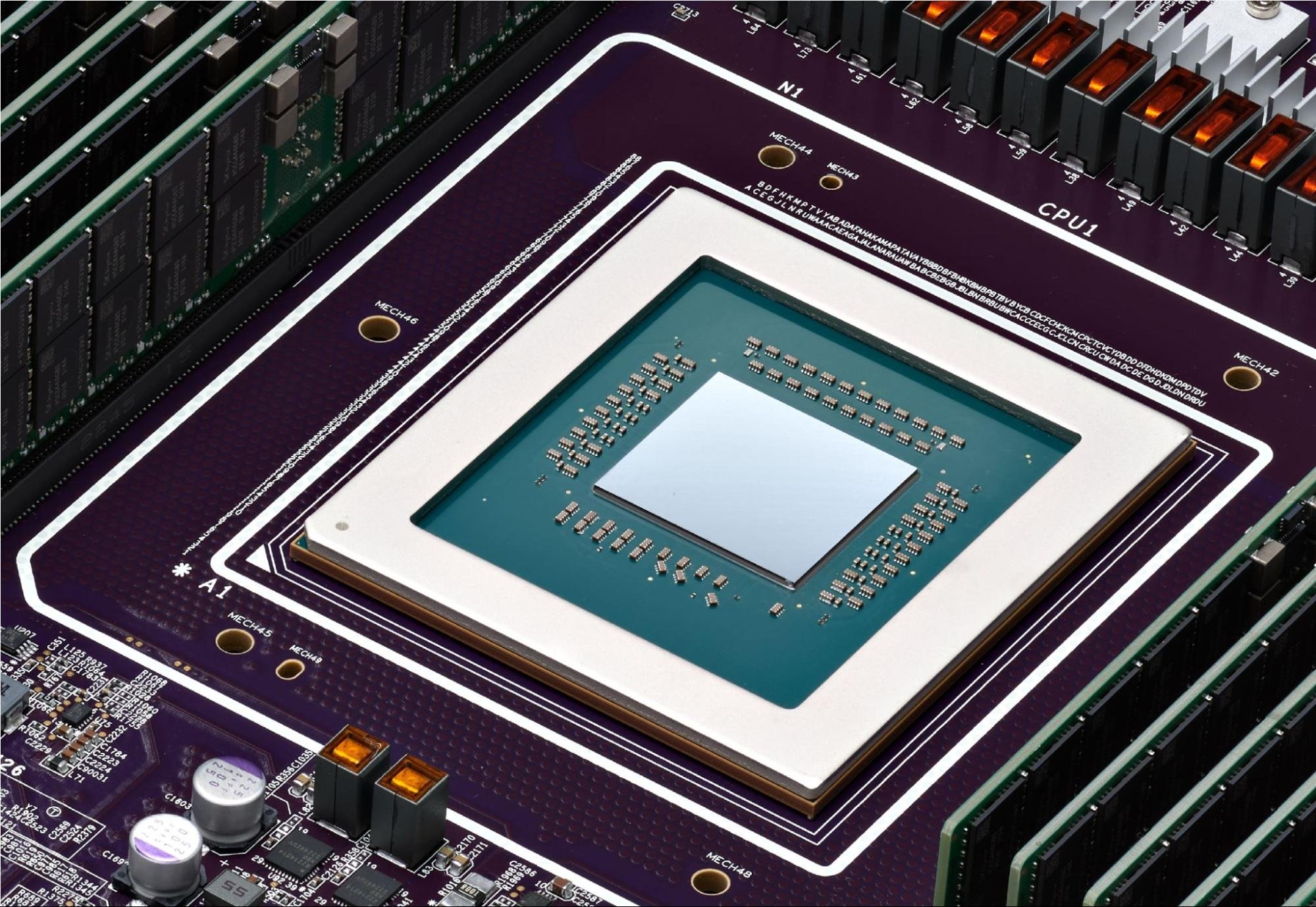

4月9日Intel打頭陣,在Vision 2024活動中,發布了新一代Gaudi 3 AI晶片。同一天,Cloud Next 2024大會上,Google Cloud首度公開專為數據中心設計的首款Arm架構CPU──Google Axion。隔天,4月11日Meta官方發文,展示新款自研AI晶片MTIA。

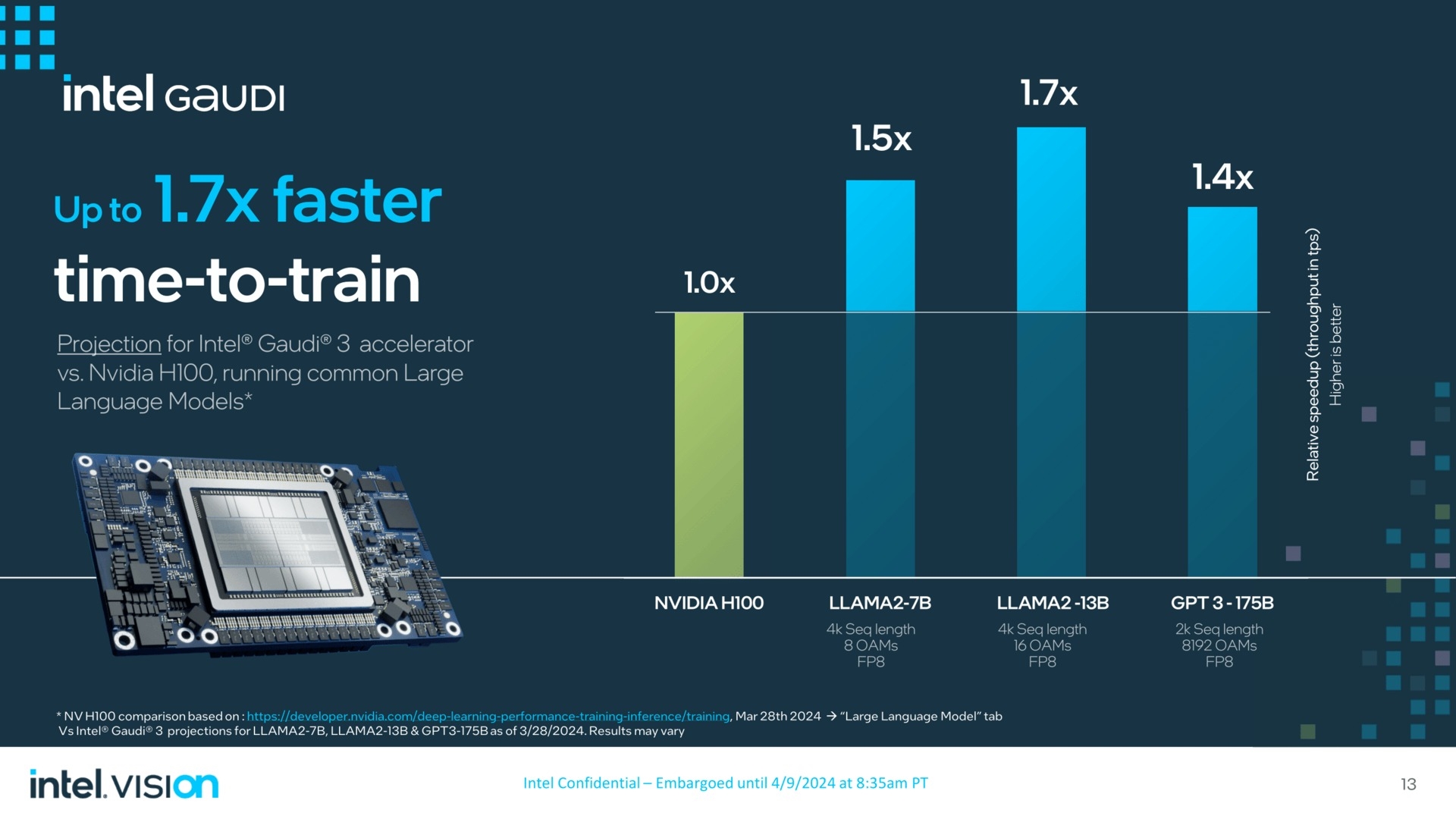

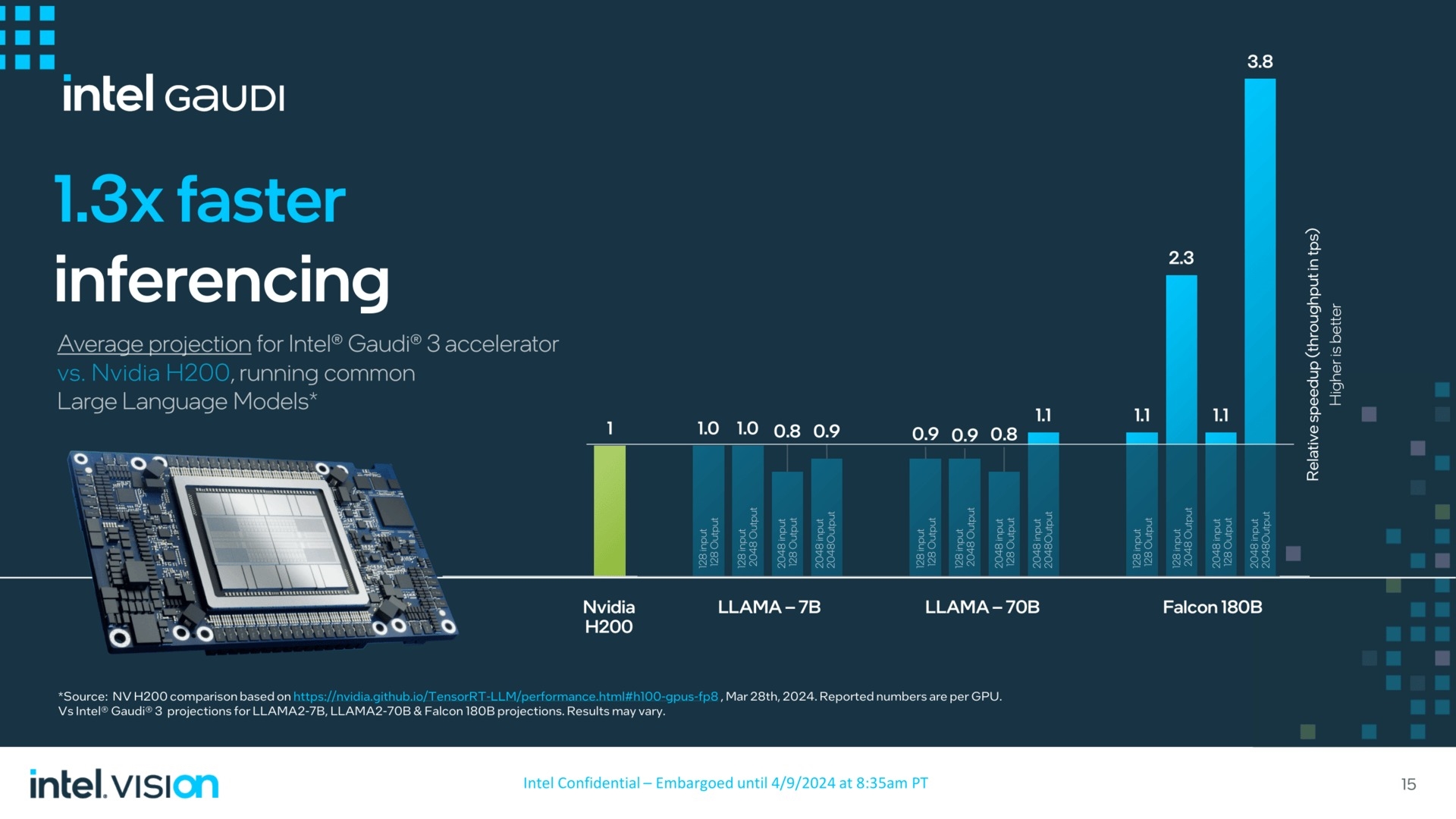

在這三款產品中,Intel新一代Gaudi 3與NVIDIA H100展開直接競爭。在AI模型算力中,Gaudi3 AI晶片的模型訓練速度、推理速度都更出色,分別提升了40%和50%,平均性能提升達到了50%,能效更是提高了40%。更重要的是,Gaudi3 AI晶片的成本比H100更低,妥妥的性能更強,價格更低。

從官方公布的數據來看,Gaudi 3即使是面對NVIDIA的H200 GPU,表現也毫不遜色。在LLAMA-7B以及LLAMA-70B的部分場景與H200基本是伯仲之間,差距基本在10%以內。

Intel在Vision 2024上也同步介紹了這款晶片的生產節點,計劃在今年第三季度向客戶發貨Gaudi 3 AI晶片,包括聯想、惠普、Dell和Supermicro等OEM廠商都會使用這款新品構建系統。

但是Gaudi 3很難撼動NVIDIA在AI新領域的地位,即便加上AMD的Instinct MI300。

美銀分析師Vivek Arya發表研究報告指出,英偉達2024年AI加速器的占有率將超過75%,定製化晶片(如Google TPU、亞馬遜Trainium/Inferentia加速器、微軟Maia)的占有率為10~15%,而剩餘的10~15%才是AMD、英特爾及其他未上市企業的天下。

盡管目前定製化晶片市場占有率不高,但幾乎所有服務商都在加速開發各類晶片晶片產品,Google也不例外。

在9日舉行的Cloud Next 2024大會上,Google Cloud首度公開專為數據中心設計的首款Arm架構CPU──Google Axion,相較目前最新一代的同等x86架構執行個體,效能最高提升50%、能源效率最高提升60%。

Axion CPU正在支持YouTube廣告、Google Earth Engine等多項Google服務。Google Cloud表示,Axion基於開放架構設計,使用Arm技術的客戶可以輕松採用,無需進行應用程式重構。

Google Cloud客戶可在旗下Compute Engine、Kubernetes Engine、Dataproc、Dataflow、Cloud Batch等雲服務中使用Axion CPU。Google Cloud計劃於今年稍晚時間向客戶開放Axion CPU的使用。

此外,Google Cloud還推出了下一代AI加速器TPU v5p。單個TPU v5p Pod包含8,960個晶片,是上代TPU v4 Pod的2倍以上。

TPU v5p主要用於訓練規模最大、要求最高的生成式AI模型。Google Cloud不會對外直接銷售Axion CPU和TPU v5p晶片,而是提供給企業客戶作為雲服務使用。這樣做不僅可以減少對英特爾、NVIDIA等外部供應商的依賴,還能更好地優化硬體以滿足自家業務的特定需求,為客戶提供更具競爭力的雲計算和AI服務。

相比Google在AI算力方面具有的規模,Meta的資源相對較少。不過,Meta在AI領域的投入也可謂闊綽。此前有報導稱,Meta一次性購買了35萬枚NVIDIA H100 GPU,每張售價數萬美元,這極大地提升了其AI算力水平,為Meta在人工通用智能(AGI)領域的研發提供了強大支撐。

Meta計劃將其計算基礎設施升級為“相當於近60萬張H100的算力”。除購買GPU外,自研是另一條路徑。Meta基礎設施副總裁Alexis Bjorlin表示,自研硬體能讓公司控制整個技術棧,從數據中心設計到訓練框架,這種垂直整合是實現AI研究突破的關鍵。

去年五月Meta官宣了第一代AI推理加速器MTIA v1,近期又發布下一代產品。新款MTIA晶片採用5nm工藝,擁有更多的處理核心,功耗也從25W提升到了90W,時鍾頻率也從 800MHz提高到了1.35GHz。

Meta表示目前已經在16個數據中心使用新款MTIA晶片,與MTIA v1相比,整體性能提高了3倍。但Meta表示,這個提升是通過測試兩種晶片的 "四個關鍵模型" 性能表現得出的。

據Meta官方介紹,新一代MTIA的設計理念在於尋求計算、記憶體帶寬和記憶體容量三者之間的理想平衡。這一改進不僅優化了晶片的性能,更使得推理任務的執行變得更為順暢。

科技大廠自研定製化晶片,一方面是可以和自身需求高度匹配,另一方面也是出於安全和經濟性的考慮,拿NVIDIA H100來說,不僅售價不菲,而且還出現了產能的問題,而AI的發展有高度依賴算力支持。

所以科技巨頭內部開發晶片的運動正在增長。Meta正加入亞馬遜AWS、微軟和谷歌母公司Alphabet的行列,試圖擺脫這種昂貴的依賴。

然而,這並未對行業對NVIDIA AI加速器的巨大需求產生顯著影響。在AI熱潮下,NVIDIA成為世界第三大科技公司,僅次於微軟和蘋果公司。

其在2024財年的數據中心運營商銷售額總計475億美元,高於前一年的150億美元。分析師預測,這一數字在2025財年將進一步翻倍,來數年內這一地位可能還會進一步鞏固。

AI轉變PC處理器升級重點

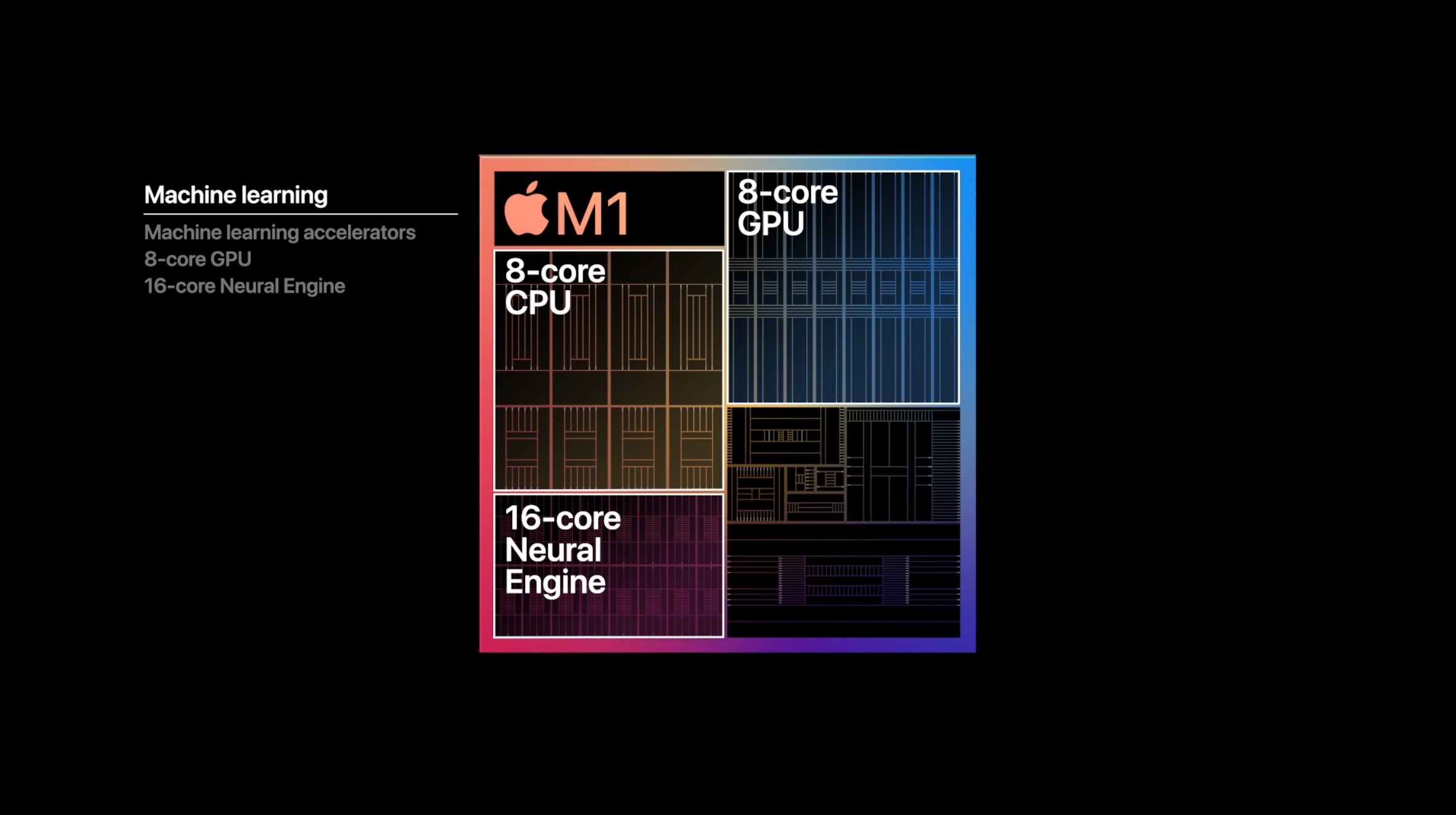

AI技術的蓬勃發展不僅改變了伺服器端晶片的走向,也正在深刻影響個人電腦(PC)處理器的發展。自蘋果M系列晶片率先集成神經網絡處理單元(NPU)以來,其他廠商也紛紛跟進。

AMD從銳龍7000系列筆記本處理器中開始加入NPU。而英特爾則在推出"AI PC"的概念時,明確將NPU作為硬性指標之一。

NPU是專門針對人工智慧和機器學習場景進行優化設計的處理器。相比通用的CPU和GPU,NPU在硬體結構上做了針對性優化,專注於高效執行神經網絡推理等AI相關計算任務。

過去幾十年里,PC處理器的發展一直圍繞CPU性能提升為主。但在AI時代,各類AI技術的爆發性增長,迫使晶片廠商不得不在AI能力上下大力氣。微軟推出的Windows Copilot等AI功能,對PC晶片的AI性能提出了更高要求。

為滿足這一需求,AMD計劃在即將推出的Strix Point APU上大幅增強NPU性能,甚至犧牲了部分CPU和GPU緩存空間。英特爾在Arrow Lake、Lunar Lake和Panther Lake等新一代晶片中也投入了大量資源,致力於提升NPU算力,分別達到約35 TOPS、105 TOPS和140 TOPS。

可以看出,AI PC正成為晶片廠商新的競爭焦點。NPU正從輔助性能向核心功能轉變,未來可能成為PC處理器升級的重點,取代傳統CPU和GPU性能的優先地位。這一趨勢反映了AI正深刻改變著PC生態的技術架構。

SoC是大勢所趨

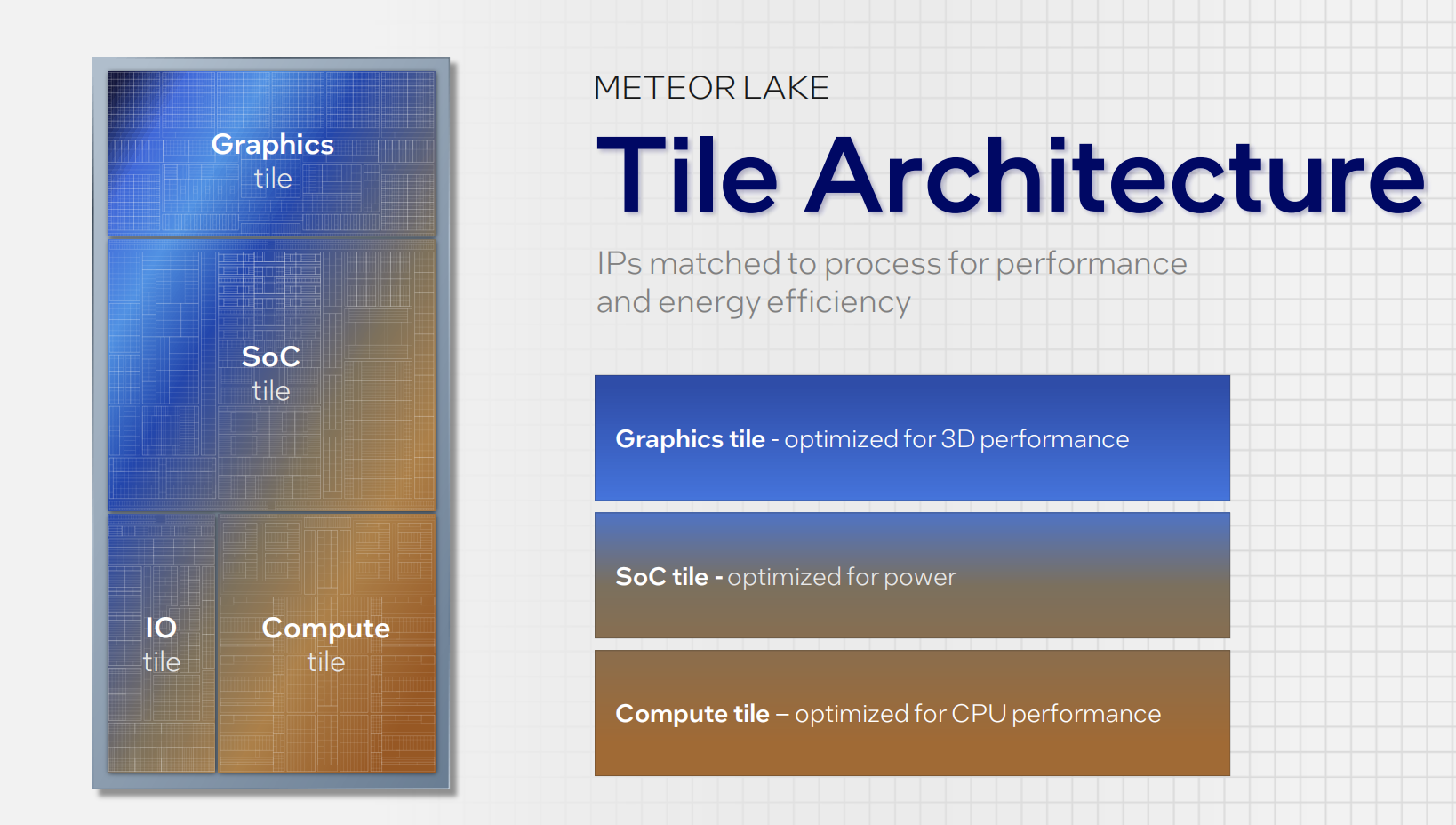

NPU的加入也在影響晶片設計製造方式,SoC(System-on-Chip)在手機行業中已經變得非常普遍,現在,這種集成設計的理念也開始滲透到個人電腦晶片的設計中,

SoC設計的優勢在於可以將CPU、GPU、NPU等各種功能單元集成在一個晶片上,使記憶體和處理器能夠更加緊密地集成,從而提高數據傳輸速度和整體系統性能。這正如蘋果M系列晶片所展現的優勢:通過緊密集成記憶體,可以顯著提升記憶體帶寬。

Intel的Core Ultra和AMD的Ryzen 8000系列處理器都採用了SoC設計,充分證明了這一趨勢。這些新一代處理器集成了CPU、GPU、NPU等多種功能單元,並且多數與板載記憶體直接連接,進一步提升了系統性能。

不過,對於桌面PC來說,SoC設計還存在一些局限性。台式機處理器往往需要更強的升級性,而SoC結構不利於後續的硬體升級。因此,Intel和AMD在筆記本晶片上採用了SoC和傳統處理器+晶片組的雙線並進策略,以兼顧不同市場需求。

來源:快科技