2012年,深度學習算法在圖像分類競賽中展現出的顯著性能提升引發了新一輪的AI熱潮。

2015年,深度學習算法對芯片的快速增長需求引發了AI芯片創業熱潮。

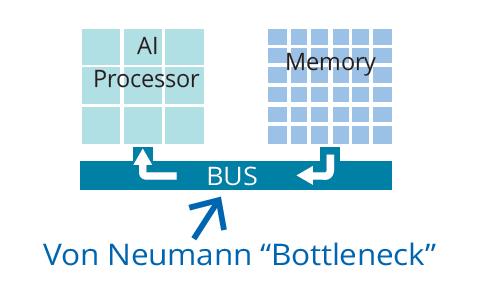

不過,擁抱AI芯片的設計者們很快發現,使用經典馮諾依曼計算架構的AI芯片即使在運算單元算力大幅提升,但存儲器性能提升速度較慢的情況下,兩者的性能差距越來越明顯,而深度學習算法帶來的數據搬運消耗的能量是計算消耗能量的幾十倍甚至幾百倍,「記憶體牆「的問題越來越顯著。

因此,依靠軟件算法以及雲端強大計算能力的人工智能雖然取得了較大的成功,可以勝任多種特定的智能處理任務,但是面臨功耗、速度、成本等諸多挑戰,離智能萬物互聯時代還有巨大差距。

AI芯片的核心技術之一就是解決「記憶體牆」挑戰,可以在存儲器內直接做計算的存內計算(In-Memory Computing)技術在沉寂了近30年後,AI熱潮下近年來成為焦點。無論是頂級學術會議,還是巨頭公司都在尋找能夠用存內計算打破AI芯片「記憶體牆「的最佳技術方案。

那麼,誰會是最終的破局者?

存內計算最適合AI?

存內計算被不少業內人士認為是最適合AI的芯片架構,廣受學術界和產業界的青睞。

2018年,國際頂級學術會議-IEEE國際固態電路會議(ISSCC)有一個專門的議程討論存內計算。2019年和2020年關於存內運算的論文更是大爆發,ISSCC2020與存內計算相關的論文數量上升到了7篇。同時,2019年電子器件領域頂級會議IEDM有三個專門的議程共二十餘篇存內計算相關的論文。

除了學術界,產業界也越來越多的玩家布局該技術。IBM基於其獨特的相變存內計算已經有了數年的技術積累;台積電正大力推進基於ReRAM的存內計算方案;英特爾、博世、美光、Lam Research、應用材料、微軟、亞馬遜、軟銀則投資了基於NOR Flash的存內計算芯片。

其實,利用存儲器做計算在很早以前就有人研究,上世紀90年代就有學者發表過相關論文。但沒有人真正實現產業落地,究其原因,一方面是設計挑戰比較大,更為關鍵的是沒有殺手級應用。隨着深度學習的大規模爆發,存內計算技術才開始產業化落地。

存內計算的產業化落地歷程,與知存科技創始人的求學創業經歷關系密切。

2011年,郭昕婕本科畢業於北大信息科學技術學院微電子專業,本科畢業之後郭昕婕開始了美國加州大學聖塔芭芭拉分校(UCSB)的博士學業,她的導師Dmitri B.Strukov教授是存內計算領域的學術大牛,2008年在惠普完成了憶阻器的首次制備,2010年加入了美國加州大學聖塔芭芭拉分校。郭昕婕也成為了Dmitri B.Strukov教授的第一批博士生,開始了基於NOR FLASH存內計算芯片的研究。

Dmitri B. Strukov告訴她,FLASH已經商用幾十年,技術成熟,成本很低,是最接近產業化的方向,但缺點同樣是因為FLASH研究起步較早,學術界對FLASH存內計算的研究期望較高,發表文章不易。2013年,隨着深度學習的研究熱潮席捲學術界,在導師的支持下,郭昕婕開始嘗試基於NOR FLASH存內計算的芯片研發。

耗時4年,歷經6次流片,郭昕婕終於在2016年研發出全球第一個3層神經網絡的浮柵存內計算深度學習芯片,首次驗證了基於浮柵晶體管的存內計算在深度學習應用中的效用。僅一年後,她就進一步攻下7層神經網絡的浮柵存內計算深度學習芯片。

也是在2016年,郭昕婕的大學同學,也是她丈夫的王紹迪,同樣看到了存內計算芯片在AI中的應用價值,選擇和郭昕婕繼續在博士後階段從事存內計算的研究工作。2017年,美國開始大力資助存內計算技術的研發,王紹迪和其導師的項目也獲得了600萬美金的資助。郭昕婕夫婦認為時機成熟,毅然選擇回國創業,並獲得了啟迪之星、兆易創新等關聯人的投資支持。

2017年10月,知存科技在北京成立,由於積累了豐富的經驗,知存科技在成立後的10個月內就首次流片。同時加上存內計算技術逐漸獲得認可,知存科技的發展也在逐步加快,並於2018年12月獲得獲訊飛領投的天使+輪融資,2019年8月又獲得中芯聚源領投的近億元A輪融資。

測試晶圓圖 來源:知存科技

王紹迪對存內計算技術在AI中的應用充滿信心,他接受雷鋒網采訪時表示:「AI算法的參數越多,存內計算的優勢越大。因為存內計算是在存儲器中儲存了一個操作數,輸入另一個操作數後就可以得到運算結果。所以參數越多,節省的數據搬運就越多,優勢也就越明顯。存內計算可以看作是一個大的錘子,AI算法是釘子,早期落地的算法是小釘子,隨着時間推演,釘子會越來越大越來越多。」

知存科技CEO王紹迪

知存科技的方案是從底層重新設計存儲器,利用NOR FLASH存儲單元的物理特性,對存儲陣列進行改造,重新設計外圍電路使其能夠容納更多的數據,同時將算子也存儲到存儲器當中,使得每個單元都能進行模擬運算並且能直接輸出運算結果,以達到存內計算的目的。

由此看來,存內計算是破解「記憶體牆「瓶頸的好方法,但為什麼在多種存內計算的技術路徑中,知存科技選擇的是NOR FLASH?

為什麼選擇NOR-FLASH?

其實,能做存內計算的存儲器並不多,除了FLASH,還有億阻器、相變存儲器、鐵電存儲器、自旋存儲器、SRAM等,但各有各的優缺點。

綜合來看,NOR FLASH是目前最適合產業化的方向,眾多巨頭投資的美國初創公司Mythic採用的也正是NOR FLASH。至於為什麼用NOR FLASH做存內計算被業界看好,王紹迪表示:「單獨從器件特性看,NOR FLASH的優勢不僅體現在功耗和成熟度等方面,高精度也是很大的優勢。目前主要的問題是沒有28nm以下的NOR FLASH工藝,但是基於當前工藝的NOR FLASH存內計算相比傳統方案的優勢已經足夠高了。」

使用NOR FLASH單元可以完成8bit權重存儲和8bit * 8bit的模擬矩陣乘加運算。單一NOR FLASH陣列可並行完成200萬次矩陣乘加法運算,計算吞吐量相比DRAM和SRAM等存儲器帶寬高出100-1000倍。

知存科技存算一體芯片技術

「相比使用數字電路計算,使用NOR FLASH進行存內計算減少了數據搬運消耗的能量,再加上NOR FLASH進行乘加法運算功耗也很低,這樣就會帶來百倍甚至千倍的功耗降低。「王紹迪表示。

當然,考慮到外圍電路的功耗,NOR FLASH存內計算最終能夠實現的功耗降低在幾十倍到上百倍之間。不同的算法和應用能夠實現的提升也不同。

王紹迪介紹,目前來看NOR FLASH存內計算技術可以在單芯片中支持到300M左右的深度學習權重參數,不需要額外的記憶體就可以進行計算。目前智能語音模型的大小通常在幾百K到幾兆的大小,端側的圖像推理模型大小通常在幾兆到幾十兆之間,因此NOR FLASH存內計算芯片可以滿足大部分AI場景的需求。

存內計算可以支持的模型精度可以達到現在主流的8比特。王紹迪說,8比特可以覆蓋大部分的深度學習應用,即便有些極限場景需要更高的16比特,我們也有解決方案在研發。我們希望未來存內計算能夠覆蓋60%-70%的AI應用。

需要指出的是,知存科技的技術水平領先業界3-4年。郭昕婕博士在2012、2013年就開始研究基於NORFLASH的存內計算技術,其他公司基本到2018年才開始研發投入。作為一項新興前沿技術,研發存內計算需要大量的技術積累,存在許多坑需要一步一步去踩,即便其他公司投入大量資源,在不出現技術泄露的情況下,至少也得三四年左右的時間才能達到知科技存目前的成績。

這其中的設計挑戰,包含了控制電路、模擬電路、編程技術、可靠性設計、架構設計等。模擬設計就是其中非常大的挑戰,由於FLASH進行的是模擬計算,但算法都是基於數字電路開發,這就對模擬運算增加了很多苛刻的要求。

王紹迪說:「雖然理論上存內計算芯片在功能上無需完全匹配現有的芯片,但目前業界的AI算法都是基於現有芯片架構開發的,因此知存科技的產品必須去適應這些商用算法,並且要做到高精度,這經歷了一次次地流片迭代,這些經歷和技術積累也成為了知存科技的優勢。」

「在迭代的過程中,我們需要去解決工藝、溫度、編程、噪聲等帶來的誤差,同時還要解決一些模擬運算遇到的問題,解決問題的過程也是一個創新的過程。正如魏少軍教授所說:產品創新是芯片設計企業的永恆話題。「他進一步表示。

而這也解釋了知存科技選擇NOR FLASH的原因,從零開始設計NOR FLASH存內計算芯片需要非常長的時間,NOR FLASH之所以能比NAND FLASH進度更快,是因為NOR-FLASH已經有一套成熟的方案,可以基於已有的方案進行優化,更快推出產品。

誰是破局者?

經歷了多次流片和技術迭代之後,知存科技上月底發布了兩款智能語音芯片MemCore001/MemCore001P,支持智能語音識別、語音降噪、聲紋識別等多種智能語音應用。芯片運行功耗小於300uA,待機功耗小於10uA。

根據知存科技的技術文檔,MemCore001/MemCore001P典型工作頻率為24MHz(工作時鍾)和2MHz(喚醒時鍾),MemCore001P在低功耗模式下,採用片內獨立的低功耗時鍾,可與其他芯片通過中斷協同交互,進一步降低整個系統的功耗。

MemCore001系列芯片尺寸

MemCore001/MemCore001P內置2MB深度學習網絡參數存儲空間,可同時存儲和運算多達32層的多個(相同或不同)深度學習網絡算法,支持DNN/RNN/LSTM/TDNN等多種網絡結構。

作為協處理器,MemCore001/MemCore001P可兼容基於Arm架構的Cortex-M4/M3/M33/M0等系列MCU以及基於RISC-V的MCU。

不過,芯片想要落地,還要把存內計算的硬件優勢轉化為落地優勢。王紹迪表示,產品能落地僅有一點優勢並不夠,能否落地還要看市場的需求。當然,想要盡快落地,要做到讓現在的商用算法在盡可能少做改變的同時盡快適配我們的芯片,這點非常重要的,這就需要和算法公司一起合作,在落地過程中不斷了解需求,讓軟件和硬件協同起來,都發揮最大作用。

他進一步指出,軟件平台可以讓開發者在算法遷移和調試的時候更加方便。不過存內計算的工作方式比較簡單,比如傳統架構需要幾百萬個周期才能完成的計算,存內計算一個周期就可以完成,所以存內計算的編譯器是粗顆粒度的,開發難度較低。

因此,知存科技與合作方開發了相應的系統解決方案,包含智能語音降噪和智能語音識別等算法,可直接集成在芯片中,供應用開發者方便調用。

與其它大部分AI芯片一樣,知存科技的MemCore001/MemCore001P在進行算法遷移的時候也需要重新訓練。這時候,如何才能吸引客戶使用存內計算的芯片?

王紹迪說:「如果我的芯片能夠帶來的提升非常明顯,或者原先不能落地的應用使用了我們的芯片之後可以落地,這樣才有人願意嘗試。這樣的場景很多,需要去探索,不過目前已經有意向客戶准備使用我們的產品。」

知存科技在存內計算的領先性從另一個角度也能說明,「早期研發的時候,由於缺乏晶圓工廠和EDA工具的支持,我們的開發工作很多就要從自動變成手動,但這同時讓知存科技建立起了存內計算芯片的設計方法學。」王紹迪表示。

這樣的領先讓知存科技有可能成為存內AI芯片的破局者,知存科技的目標是在三年內實現5000萬顆芯片的出貨目標。對此,王紹迪表示樂觀,他認為消費市場5000萬的出貨量並不多,如果選對了方向,一個產品的出貨量在幾年內就能達到上千萬。

5000萬的出貨意味着公司可以實現盈利,在這樣的目標下,硬件和軟件都需要不斷迭代。王紹迪透露,現在公司每三到四個月就會流片一次,一年會推出一款甚至兩款新產品。視覺芯片的樣片會在明年流片,預計後年會正式推出。

小結

作為AI發展的關鍵推動力,AI芯片能夠在多大程度上滿足AI算法的需求成為關鍵。要滿足AI算法的需求就需要解決AI芯片記憶體牆的核心挑戰,存內計算以其能夠同時存儲和計算的特性被視為解決記憶體牆挑戰的一種方法,但其用模擬計算滿足數字算法的需求,外圍電路設計、軟件設計、工藝帶來的誤差都是挑戰。

存內計算的公司之間顯然還不是競爭關系,但我們都期待存內計算AI芯片能夠出現代表性地應用,推動AI的快速落地和持續發展。