Tag: HBM顯存

韓國將HBM記憶體上升為國家戰略 三星等可享40%稅收減免

快科技1月26日消息,據韓國媒體報導,韓國將把高帶寬內存(HBM)技術指定為國家戰略技術,並向三星電子和SK海力士等開發該技術的企業提供稅收優惠。

報導稱,這一決定是2023年底在國會通過的,稅法修正案後的執行令草案的一部分。

最主要的變化就是,擴大了有資格享受研發稅收優惠的國家戰略技術范圍,與一般研發活動相比,企業對指定的國家戰略技術可以獲得更高的稅收減免。

中小企業可享受高達40%至50%的減免,而三星電子、SK海力士等中大型企業可享受高達30%至40%的減免。

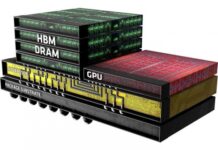

HBM全稱為High Bandwich Memory,即高帶寬內存,是一款的CPU/GPU內存晶片;其將很多個DDR晶片堆疊在一起後和GPU封裝在一起,實現大容量、高位寬的DDR組合陣列。

簡單來講,傳統的DDR內存晶片是一層的平房結構,HBM結構的內存就是現代化的摩天大樓,在占地面積不變的基礎上,向3維高度發展,從而可實現了更高的性能和帶寬。

隨著AI應用的越來越廣泛,HBM的相關應用也是越來越多,其需求也是水漲船高,目前HBM的平均售價至少是DRAM的三倍。

來源:快科技

第五代HBM3e記憶體來了 三大存儲巨頭集體向英偉達供貨:2024年第一季度完成驗證

快科技11月27日消息,據TrendForce集邦咨詢最新HBM市場研究顯示,為了更妥善且健全的供應鏈管理,英偉達正規劃加入更多的HBM供應商。

其中,三星的HBM3(24GB)預期於今年12月在NVIDIA完成驗證。之前英偉達的HBM由SK海力士獨家供應,如今三星、美光都將加入。這也意味著,三家存儲龍頭都將為英偉達供應HBM。

而HBM3e進度依據時間軸排列如下表所示:

美光已於今年7月底提供8hi(24GB)NVIDIA樣品、SK海力士已於今年8月中提供8hi(24GB)樣品,三星則於今年10月初提供8hi(24GB)樣品。預期2024年第一季完成HBM3e產品驗證。

HBM(High Bandwidth Memory)即高帶寬存儲器,屬於圖形DDR內存的一種,通過使用先進的封裝方法(如TSV矽通孔技術)垂直堆疊多個DRAM,與GPU通過中介層互聯封裝在一起。

HBM的優點在於打破了內存帶寬及功耗瓶頸。CPU處理的任務類型更多,且更具隨機性,對速率及延遲更為敏感,HBM特性更適合搭配GPU進行密集數據的處理運算。英偉達新一代AI晶片,均搭載HBM內存。

HBM產品問世至今,HBM技術已經發展至第四代,分別為HBM、HBM2、HBM2e、HBM3,第五代HBM3e已在路上。

四代HBM規格對比

至於下一代HBM新品HBM4(第六代),在堆棧的層數上除了現有的12hi (12層)外,也將再往16hi (16層)發展。

預計,HBM4 12hi將於2026年推出,而16hi產品則於2027年問世。

據悉,在HBM4中,將首次看到最底層的Logic die(又名Base die)將首次採用採用12nm製程晶圓,該部分將由晶圓代工廠提供,使得單顆HBM產品需要晶圓代工廠與存儲器廠合作。

來源:快科技

帶寬達1.2TB/S 三星交付HBM3E記憶體樣品:秒傳百部電影

快科技10月18日消息,根據韓國媒體今天的報導,三星已經確認將其第5帶HBM3E產品命名為“Shinebolt”。隨著三星加快對HBM3E的開發和營銷,其有望追上SK海力士在該領域的步伐。

HBM屬於垂直連接多個DRAM,與DRAM相比顯著提升數據處理速度的高附加值、高性能產品。由於其性能優勢,HBM通常被認為是人工智慧時代的DRAM內存。

HBM DRAM產品以HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)、HBM3E(第五代)的順序開發,其中HBM3E是HBM3的擴展版本。

據相關人士透露,三星已經開始向客戶提供Shinebolt樣品來進行質量測試,該樣品的規格為8層24GB。此外,三星還將很快完成12層36GB產品的開發。

與HBM3相比,Shinebolt的最大數據傳輸速度(帶寬)提升了約50%,可達1.228TB/。相當於在1秒鍾內傳輸了230部FHD高清電影(每部容量5GB)

HBM的關鍵在於每層之間的連接方式,三星從HBM生產之初就一直的採用是熱壓縮非導電薄膜(TC-NCF)工藝,而其老對手SK海力士則採用的是質量回流成型底部填充(MR-MUF)工藝。當然,這二者孰優孰劣還是要交給市場來評判。

由於已經在HBM的開發和生產速度上落後於SK海力士,三星也開始重新制定戰略來奪回市場定位。其中最主要的就是加速開發可能改變HBM規則的“混合連接”工藝。

來源:快科技

溫度直降100多度 HBM記憶體也要用上低溫焊了:產能大增

快科技8月19日消息,隨著AI市場的爆發,不僅CPU、GPU算力被帶動了,HBM內存也成為香餑餑,還有2.5D、3D封裝技術,但是它們的產能之前很受限制,除了成本高,焊接工藝復雜也是問題。

晶片焊接目前主要採用高溫焊,焊料主要是SAC(Sn-Ag-Cu)錫、銀、銅材質,熔點超過250℃,這個溫度的焊接技術對大部分晶片來說沒問題,但HBM內存使用了TSV矽通孔技術,這樣的高溫焊接就有可能導致變形。

為此MK Electronics公司開發了專門適合HBM內存的低溫焊技術,焊球由鉍(Bi)、錫(Sn)和銀(Ag)製成,熔化溫度低於150℃,比之前降低了100多度。

低溫焊不僅提高了生產效率,還提高了HBM等晶片的良率,因為高熱導致的產品缺陷及質量也控制住了,產能也可以保障。

三星、SK海力士等公司正在擴大HBM內存的生產,這種低溫焊技術很快也會得到大面積使用。

來源:快科技

高性能HBM顯存晶片:被韓國企業壟斷了

快科技4月19日訊,2015年,AMD和SK海力士合作,全球首發了HBM(High Bandwidth Memory)顯存,即高帶寬存儲,而且創新從2D進入2.5D堆疊。

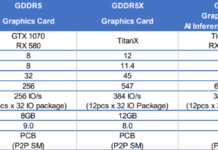

相較當時的GDDR5顯存,HBM的總線位寬提升了30倍,最終位寬提升3.5倍,電壓從1.5V降低到1.3V。

如今,HBM已經發展出HBM2、HBM2e以及HBM3,並更廣泛地應用在遊戲顯卡、專業顯卡、數據中心加速卡、AI推理顯卡等諸多領域。

來自TrendForce集邦咨詢18日發布的報告顯示,2022年三大原廠HBM市占率分別為SK海力士(SK hynix)50%、三星(Samsung)約40%、美光(Micron)約10%。

換言之,兩家韓企合計達到了90%,幾乎可以說壟斷了這一市場。

而且,SK海力士目前是唯一能量產HBM3顯存的廠商,三星、美光則要等到今年底或者明年初。因為韓企在HBM顯存方面的全面優勢,報告預計美光明年的份額會下滑到9%。

快科技了解到,單單NVIDIA一張A100加速卡,就需要配備80GB HBM顯存,未來的AI專用伺服器,單一計算集群的HBM顯存規模至少會提升到512GB甚至1TB。

來源:快科技

80GB都不夠了 NVIDIA H100計算卡要上120GB HBM2e顯存

你的顯卡顯存有多大?想沒想過顯存超過100GB是什麼概念?

NVIDIA上一代加速計算卡A100首發40GB HBM2顯存,

,其中PCIe5.0形態的還是HBM2e,SXM5形態的則是最新標準HBM3。

根據最新曝料,NVIDIA正在准備120GB HBM2e顯存版的H100計算卡,PCIe形態,顯存帶寬還是高達3TB/。

GH100核心採用台積電4nm工藝製造,集成800億個電晶體,核心面積814平方毫米,內部集成了多達18432個CUDA核心、576個Tensor核心、60MB二級緩存,分為144個SM單元,另有12個512-bit顯存控制器,總位寬6144-bit。

H100 SXM版本只開放15872個CUDA核心、528個Tensor核心,PCIe版本更是只有14952個CUDA核心、456個Tensor核心,功耗卻最高達700W。

曝料稱,新的H100 120GB PCIe將開啟16896個CUDA核心,距離滿血更近了一步。

另外,曝料中還提到了一款代號ADLCE的工程樣卡,顯然是RTX 40 Ada Lovelace的縮寫,應該對應RTX 4090,不過功耗限制在了350W。

來源:快科技

五年都沒確定標準 HBM3記憶體性能初定提升44%:帶寬665GB/s

現在的DDR記憶體及GDDR顯存性能雖然已經很不錯,但AMD 2015年在Fury系列顯卡上首次量產的HBM記憶體技術則是一次突破,TB級帶寬、功耗、面積等方面無一不是跨越式提升。

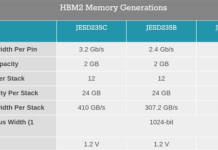

HBM已經成為高性能計算中的頂層標準,只有那些不計成本的產品才會用上HBM顯存,標準也發展到了HBM2e,2019年公布的,IO傳輸速率為3.6Gbps,搭配1024-bit位寬的話可以提供超過460GB/的超高帶寬。

然而問題也來了,那就是HBM3標準一直跳票,從五年前的2016年SK海力士、美光、三星等公司就討論過HBM3標準,可惜一直沒有定下標準,原定的2020年早就不可能了,這可能是最難產的記憶體標準了。

理論上HBM3的性能要比HBM2再翻一倍,可能是太難實現了,現在來看2022年甚至2023-2024年才有希望問世。

在HBM3量產之前,SK海力士最近公布了一個過渡性的標準,預計IO頻率提升到5.2Gbps以上,帶寬則提升到665GB/,比HBM2e提升大約44%。

SK海力士的初版HBM3還沒有問世時間。

來源:快科技

三星首發HBM-PIM存內計算技術 2倍性能、功耗降低70%

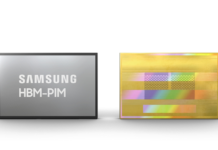

電子計算機多年來都是走諾伊曼架構體系,今天三星宣布了一項新的突破,面向AI人工智能市場首次推出了HBM-PIM技術,走的是非諾伊曼架構。

HBM記憶體技術並不新鮮了,最新的標準是HBM2,三星早在2018年就推出了HBM2記憶體,而這次的HBM-PIM則是在HBM芯片上集成了AI處理器的功能,是全球首個HBM存內計算技術。

PIM存內計算是近年來的熱門領域,與傳統諾伊曼體系面臨着越來越嚴重的存儲貸款瓶頸不同,PIM直接在存儲芯片上集成了計算功能,而不是CPU、記憶體數據分離,這樣就能極大地提高帶寬,在AI人工智能領域這個更重要。

得益於這一突破,三星首發的HBM-PIM技術實現了2倍的性能,同時功耗還降低了70%,還能兼容目前的HBM接口,便於客戶通過HBM-PIM來構建自己的AI加速器。

三星計劃今年上半年推出HBM-PIN芯片完成客戶驗證工作,何時量產、商用還沒信息。

作者:憲瑞來源:快科技

美光宣布下一代顯存HBMnext 2022年見

HBM顯存發展過程中,美光不是最快的,也不是性能最好的,但這次打了個頭陣,率先宣布了下一代技術規劃,暫定名HBMNext。

經過兩代的演進,HBM目前正在進入HBM2e階段,其中,三星也在積極推進中。

美光的HBM2e則直到今天才露出廬山真面目,完全符合JEDEC標準,提供兩種規格,一是四堆棧、單Die容量8Gb,二是八堆棧、單Die容量16Gb,對應單顆容量8GB、16GB,數據率3.2Gbps或更高,搭配1024-bit位寬的話就是410GB/的總帶寬。

如果四顆組合,可以獲得總容量64GB、總帶寬1.64TB/。

相比之下,SK海力士的HBM2e只有八堆棧16Gb一種大容量版本,而且理論上可以做到十二堆棧24Gb,而且數據率更高達3.6Gbps,四顆可以組成64GB、1.8TB/。

美光表示,HBM2e將在今年下半年上市。

至於HBMNext,美光表示將全程參與JEDEC的標準制定工作,預計2022年面世,但目前尚未確定任何具體技術細節。

作者:上方文Q來源:快科技

美光泄密 RTX 3090顯卡用上GDDR6X顯存 帶寬堪比HBM2

NVIDIA新一代顯卡越來越近了,8月31日就有可能公布重大消息,安培GPU核心的RTX 30系列最快下個月就能買到。

首發的第一波肯定是高端卡,除了RTX 3080、RTX 3080 Ti之外,還有個更高端的RTX 3090(一說是RTX 3080 Ti改名)顯卡,據悉是GA102-300核心,集成5248個CUDA核心,支持PCIe 4.0。

,隨後網友又從美光的資料中發現了RTX 3090顯卡的顯存秘密——它將用上更先進的GDDR6X顯存。

美光這個爆料顯示RTX 3090的GDDR6X顯存位寬384bit,頻率19Gbps到21Gbps,容量是12GB,帶寬可達912GB/到1006GB/。

簡單來說,RTX 3090顯卡的顯存這一次提升很大,相比RTX 20系列最高16Gbps的速率,21Gbps的GDDR6X可以讓RTX 3090輕松實現1TB/級別的帶寬,這可比HBM2顯存的帶寬都要高了,上代的計算卡Tesla V100使用HBM2也不過900GB/帶寬。

當然,跟最新的A100加速卡相比,後者使用5120bit位寬的HBM2顯存,帶寬高達1.6TB/,依然是王者級別的,遊戲卡望塵莫及。

不過美光的爆料讓RTX 30系列顯卡的顯存配置更加撲朔迷離了,,現在12GB GDDR6X倒是填補了一檔,不過用在RTX 3090這樣的高端卡上,12GB顯然太少,美光這個容量的說法還有待確認。

作者:憲瑞來源:快科技

AMD下代旗艦顯卡成謎 GDDR6?HBM?

近期關於AMD、NVIDIA各自下一代遊戲卡的傳聞越來越多,但都是什麼說法都有,有的甚至還互相衝突。

AMD這邊的新旗艦卡基於RNDA 2架構,核心代號是Big Navi,或者叫Navi 21,或者叫Sienna Cichild(一種魚類)。

新卡可能會命名為Radeon RX 6900系列,當然也不排除AMD再次改變命名規則,畢竟這幾年A卡名字變得實在是太頻繁了。

最新曝料稱,Big Navi顯卡將搭配2048-bit顯存位寬(2×8×128),這樣的配置顯然只能是HBM系列,而且是兩顆顯存(每一顆位寬1024-bit),容量可能是2×8GB或者2×16GB,當然後者需要最新的HBM2e,三星、SK海力士均已投入量產。

/* HBM Memory Channel Width */

#define UMC_V8_7_HBM_MEMORY_CHANNEL_WIDTH 128

/* number of umc channel instance with memory map register...

提升10倍記憶體帶寬AMD展示新一代X3D CPU封裝技術

2015年代號為Fiji的AMD Fury X顯卡發布,代表着HBM顯存第一次進入大眾視野,將傳統傳統的2D顯存引向立體空間。通過堆疊,單個DIE可以做到8GB容量,位寬也高達1024bit。相比之下傳統的DDR顯存單Die只有1GB容量,位寬只有32bit。

因此HBM顯存可以很輕易的做到32GB容量、4096bit帶寬,同時不需要太高的頻率就能達到傳統的GDDR5顯存所無法企及的恐怖帶寬。

2017年,隨着Zen構架的銳龍處理器問世,AMD也讓我們見識到了MCM(Multichip Module)技術。採用模塊化設計的銳龍處理器單個CCD含有8個核心,將2個CCD封裝在一起就能變成4核,32核的撕裂者2990WX擁有4個CCD。

MCM技術的出現使得多核擴展變得更加簡單高效,同時也避免了大核心帶來的良率問題,因此在成本上要遠遠優於競品。

而2019年的Zen 2構架則將MCM技術再一次升級為Chiplet。通過將CPU Die與I/O Die進行分離,CPU Die可以做的更小,擴展更多核心的時候也相應的變得更加容易,同時也進一步降低的了多核處理器的製造成本。按照AMD的說法,在某些情況下,Chiplet設計可以將處理器製造成本降低一半以上。

在今天早上的AMD財務分析大會上,AMD CEO 蘇姿豐又向大家展示了一種名為X3D的封裝技術,它是在原有的Chiplet技術上加入了HBM的2.5D堆疊封裝。雖然AMD沒有明說,但是意圖非常明顯,未來的高性能處理器極有可能會引入HBM記憶體,從而將記憶體帶寬提升10倍以上。

如果順利的話,我們在Zen 4構架上就能看到這種設計,新一代AMD處理器的性能相當令人期待!

作者:流雲來源:快科技

第三代HBM2E顯存公布 針腳帶寬增加33%至3.2Gbps、三星拿下首發

本周,固態存儲協會(JEDEC)發布第三版HBM2存儲標準JESD235C,將針腳帶寬提高到3.2Gbps,前兩版中依次是2Gbps、2.4Gbps,環比提升33%。

按照設計規范,單Die最大2GB、單堆棧12 Die(無標準高度限制),也就是24GB容量,匹配1024bit位寬,單堆棧理論最大帶寬410GB/s。對於支持四堆棧(4096bit)的圖形芯片來說,總帶寬高達1.64TB/s。

第三代HBM2的電壓和上一版一致,為1.2V,比第一代的1.35V有所下降。

簡單比較下,常見高端獨顯採用的256bit GDDR6,按照14Gbps的針腳帶寬計算,總帶寬448GB/s,也就是第三代HBM2一個堆棧的水平。考慮到HBM2更容易擴充總線寬度,GDDR6過猶不及,況且單堆棧最大容量就能達到24GB,四堆棧直逼100GB。

圖為HBM顯存示意

事實上,3.2Gbps的第三代HBM2早先已經由三星和SK海力士提出,並更名為HBM2E,這種說法也得到了JEDEC默認。

在JESD235C標準發布的同時,三星宣布,名為Flashbolt(前兩代名為Flarebolt和Aquabolt)的第三代HBM2(HBM2E)存儲芯片將在上半年量產,單顆最大容量16GB,由16Gb的單Die通過8層堆疊而成。

三星的第三代HBM2E甚至支持超頻,單針腳可加速到4.2Gbps,單堆棧最大帶寬從而升至538GB/s。

作者:萬南來源:快科技

三星率先開發出12層3D硅穿孔堆疊 HBM存儲芯片容量提至24GB

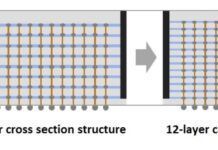

10月7日,三星電子宣布率先在業內開發出12層3D-TSV(硅穿孔)技術。

隨着集成電路規模的擴大,如何在盡可能小的面積內塞入更多晶體管成為挑戰,其中多芯片堆疊封裝被認為是希望之星。三星稱,他們得以將12片DRAM芯片通過60000個TSV孔連接,每一層的厚度僅有頭發絲的1/20。

總的封裝厚度為720μm,與當前8層堆疊的HBM2存儲芯片相同,體現了極大的技術進步。

這意味着,客戶不需要改動內部設計就可以獲得更大容量的芯片。同時,3D堆疊也有助於縮短數據傳輸的時間。

三星透露,基於12層3D TSV技術的HBM存儲芯片將很快量產,單片容量從目前的8GB來到24GB。

作者:萬南來源:快科技