Tag: Instinct MI300X

聯想:AMD MI300加速卡賣爆了

快科技3月28日消息,NVIDIA AI GPU加速卡雖然無論性能還是市場都遙遙領先,AMD也不甘示弱,硬是殺出了一條生路,得到了大量客戶的青睞。

聯想北美總裁Ryan McCurdy在接受采訪時表示,AMD MI300系列加速卡的需求是迄今為止最高的,聯想正在進行測試和負載驗證,一切都在有條不紊地推進。

雖然他沒有透露更具體的數字,但是可以看出,AMD MI300系列無疑得到了充分的認可,尤其是在NVIDIA近乎壟斷的情況下,市場更需要一家同樣給力的競爭廠商。

當然,聯想也不會就此冷落NVIDIA,而是會堅持與不同夥伴的合作。

McCurdy直言,無論是NVIDIA還是AMD,無論是Intel還是微軟,他們都會通力合作,不斷推出各自的新產品。

此前有調查顯示,大約50%的受訪者表示對AMD MI300X充滿信心,原因是相比NVIDIA H100系列不但性價比更高,而且供貨充足,不會因為缺貨而加價。

來源:快科技

AMD MI300X即將大量出貨:有望搶下7% AI市場

雖然NVIDIA目前仍是AI晶片市場的霸主,不過年中開始,挑戰者AMD的最強AI晶片MI300X也即將大批量出貨,可能將會搶下部分NVIDIA的市場,並再次影響從晶圓代工到伺服器的AI產品供應鏈。

根據日本瑞穗證券報告,在目前的AI晶片市場,NVIDIA的市占率高達95%,“遠比AMD和英特爾的份額相加還要高”。

NVIDIA在2023年第四季僅數據中心業務的營收就高達184億美元,較前一年同期增加了409%。

但隨著AMD的最強AI晶片MI300X的出貨,或將搶下NVIDIA的部分市場份額。

據業內人士透露,AMD MI300X晶片目前已小量出貨,微軟等正在測試。這款晶片下半年預計會有大量出貨,主要買家是微軟等有大型數據中心的公司,“5或6月開始,就會有一批拉貨潮”。

據悉,微軟、Meta、甲骨文、OpenAI等大廠都會采購這款晶片,美超威、華碩、技嘉、鴻佰科技、英業達、雲達等伺服器廠也在設計解決方案。

在去年的第三財季會議上,AMD CEO蘇姿豐表示,數據中心收入2024年可達20億美元,這代表MI300會是AMD史上最快營收達10億美元的產品。

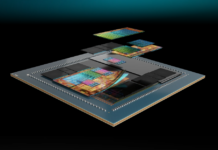

AMD反擊NVIDIA的武器,是利用更高容量的高帶寬內存(HBM)和先進封裝提高AI運算效率。

AI晶片挑戰在於,要在內存和處理器間搬動大量數據,因此AMD採用台積電的先進封裝技術,將原本放在晶片外的內存直接搬進晶片,讓大量數據直接在晶片內就能從內存搬到處理器計算。

在此前的發布會上,AMD CEO蘇姿豐就表示,只用一顆晶片,就能執行數據量高達40GB的AI模型,而這顆晶片最高可執行80GB 的AI模型。

根據官方公布的數據顯示,MI300X的HBM容量高達192GB,比NVIDIAH100 SXM晶片的80GB高了一倍多,多項算力測試性能也高於NVIDIAH100 SXM晶片。

不過,隨後NVIDIA也拿出數據來表示,輝達H100晶片性能比MI300X明顯更快,並公布測試細節,讓使用者自行比較兩顆晶片性能。

雙方之間競爭的火藥味明顯上升。

對於AMD來說,除了MI300X的產品優勢之外,它還有著另一大優勢,那就是客戶不希望AI晶片市場被NVIDIA獨占。

據業界人士觀察,“AI晶片問題不是產能不夠,是NVIDIA賣的很貴”。

微軟等大客戶不希望市場只有一家供應商很正常,但自研晶片又無法像專業的半導體公司,在性能上保持領先,自然希望有新的供應商出現,不僅性能能和NVIDIA匹敵,價格還更具優勢。

根據富國銀行此前的預測,AMD雖然在2023年的AI晶片的營收僅為4.61億美元,但是2024年將有望增長到21億美元,將有望拿到4.2%的市場份額。Intel也可能拿到將近2%的市場份額。

這將導致NVIDIA的市場份額可能將小幅下滑到94%。

不過,根據AMD CEO蘇姿豐在1月30日的電話會議上公布的數據顯示,AMD在2023年四季度的AI晶片營收已經超越此前預測的4億美元,同時2024年AMD的AI晶片營收預計也將達到35億美元,高於先前預測的20億美元。

如果AMD的預測數據准確的話,那麼其2024年在AI晶片市場的份額有望進一步提高到7%左右。

然而NVIDIA也不會坐等競爭對手壯大。

3月18日,NVIDIA即將召開GTC2024大會,屆時將會正式發布全新的AI晶片H200,將會把HMB內存從上一代的80GB提升至141GB,並且採用的是速率更快的HBM3E規格。

此外,NVIDIA今年還將提出更強的B100晶片,其性能將會達到H200的兩倍。AMD明年也會推出新一代的採用HBM3E內存的AI晶片MI350進行應對。

供應鏈方面,隨著NVIDIA和AMD對於HBM容量及規格的需求提升,HBM的供應也將持續供不應求。目前兩大HBM供應商——SK海力士和美光的今年的HBM產能都已經銷售一空。

與此同時,台積電的先進封裝產能也仍面臨供應緊張的局面,因為不僅AI晶片需要先進封裝產能,HBM晶片的製造也需要先進封裝產能。

對此,台積電在2023年啟動了其CoWoS先進封裝產能大擴產計劃。

近日業內傳出,台積電本月對台系設備廠再度追單,交機時間預計將在今年第四季,因此,今年年底台積電CoWoS月產能將有機會比其原定的倍增目標的3.5萬片進一步提高到4萬片以上。

台積電更是和SK海力士結盟,大力布局HBM。

業界人士預測,接下來AI晶片會越來越多元,從高階一路到中低階,配合從模型訓練到AI邊緣計算需求。

比如,上個月美國人工智慧初創公司Groq最新推出的面向雲端大模型的推理晶片引發了業內的廣泛關注,該晶片採用了全新的Tensor Streaming Architecture (TSA) 架構,以及擁有超高帶寬的SRAM,從而使得其對於大模型的推理速度提高了10倍以上,甚至超越了NVIDIA的GPU。這也使得一些客戶對於Groq的AI晶片產生的興趣。

近日,新創AI晶片公司Cerebras Systems近日推出了其第三代的晶圓級AI晶片WSE-3,具有125 FP16 PetaFLOPS的峰值性能,相比上一代的WSE-2提升了1倍,將用於訓練業內一些最大的人工智慧模型。

與此同時,Cerebras還推出了基於WSE-3的CS-3超級計算機,可用於訓練參數高達24萬億的人工智慧模型,這比相比基於WSE-2和其他現代人工智慧處理器的超級計算機有了重大飛躍。

另外,如果只是用來推理,X86和Arm處理器也有機會拿到一定的市場。

來源:快科技

AMD MI300X這次成了 大量NVIDIA用戶投奔而來

NVIDIA AI GPU風頭無兩,公司市值全球第三,黃仁勛甚至聲稱對手免費也無法擊敗自己,但事實上,AMD MI300系列這一代還是可圈可點的,也吸引了大量用戶。

TensorWave對82名高級工程師、AI專家進行的獨立調查顯示,大約50%的受訪者表示對AMD MI300X GPU充滿信心,原因是相比NVIDIA H100系列不但性價比更高,而且供貨充足,不會因為缺貨而加價。

事實上,TensorWave自己也采購了AMD MI300X。

AMD Instinct系列產品其實已經發展了很多代,但無論性能還是市場接受度都遠遜於對手。

,相比H100內存容量多2.4倍、帶寬高1.6倍、FP8、FP16浮點性能都高1.3倍,FlashAttention 2、Llama2(700億參數) 1v1對比測試領先20%,Bloom(1760億參數)、Llama2(700億參數) 8v8測試領先60%、40%。

AMD還打造了MI300A,首次在數據中心同時集成了CPU、GPU,但目前尚未鋪開。

AMD蘇姿豐此前預測,AMD AI晶片2024年的收入將達到35億美元,大大高於此前預計的20億美元。

當然,AMD在開發支持、生態建設方面還存在較大的差距,仍需努力追趕。

來源:快科技

AMD MI300X AI加速卡價格超10萬元 NVIDIA至少四倍之

快科技2月4日消息,AI/HPC應用對於加速卡的需求空前高漲,不但NVIDIA A/H系列賣到天價和脫銷,AMD Instinct系列也搶到了不少甜頭。

雖然他們從來不公布產品價格,部分是因為根據行情、客戶、規模等因素差異極大,但仍然可以發現蛛絲馬跡。

微軟是AMD MI300X加速卡的頭號客戶,有估計認為微軟購買的單價是1萬美元左右(約合人民幣7.2萬元),而其他客戶可能要1.5萬美元左右(約合人民幣10.8萬元)。

NVIDIA H100 80GB PCIe經常會賣到3-4萬美元乃至更貴,H100 80GB SXM樣式的必然更貴。

NVIDIA還有更高級、更先進的H200 141GB、H100NVL 188GB,但從內存容量上看它們更應該是AMD MI300X 192GB的競爭對手,價格更要上天了。

NVIDIA已經壟斷了AI加速卡超過80%的市場,AMD雖然無力追趕之,但依然能賺得盆滿缽滿。

AMD自己估計旗下數據中心GPU業務的年收入可超過35億美元,而第三方機構認為AMD太保守了,今年至少能入帳50億美元以上,明年更有望達到80億美元左右。

來源:快科技

AMD MI300X加速GPU買家首秀:八路並行 死磕NVIDIA就靠它了

快科技1月23日消息,AMD去年底正式發布了,首批向超算、數據中心等大客戶出貨,包括美國政府、微軟、Meta,現在一些小客戶也拿到了貨。

LaminiAI,一家新興的AI創業企業,一直與AMD關系非常好,就曬出了自己批量到貨的MI300X,將用來訓練自己的LLM大語言模型。

他們使用的是八路並行配置,單系統就有八塊這樣的加速器,從截圖里就可以看到八塊卡,只不過都處於空閒狀態,並未火力全開。

早在去年7月,美國能源部旗下的勞倫斯利弗莫爾國家實驗室(LLNA)就宣布,全新的“El Capitan”(酋長岩)超算已開始安裝MI300A加速器,將在2024年滿血上線,預計性能超過200億億次浮點計算每秒。

如今,小客戶也拿到了MI300加速器,顯然產能已經上來,可以批量供貨了,對AMD來說非常關鍵。

AMD此前曾預計,MI300系列加速器將成為公司歷史上最快達到1億美元收入的產品。

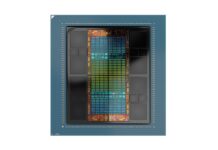

AMD MI300X集成八個5nm XCD加速計算模塊,共計304個計算單元,搭配四個6nm IOD模塊,集成256MB無限緩存,還有八顆共192GB HBM3內存,總計1530億個電晶體。

按照官方說法,MI300X的性能可以超過NVIDIA H100 80GB。

MI300A是全球首款面向AI、HPC的APU加速器,配置六個XCD模塊、228個計算單元,以及三個CCD哦快、24個Zen4 CPU核心,搭配128GB HBM3內存,總計1460億個電晶體。

來源:快科技

NVIDIA被傳遭微軟兩次砍單 AMD最強AI加速卡虎口奪食

據業內傳聞,繼第三季度被微軟砍掉20%的訂單之後,NVIDIA GPU AI加速卡被曝再次遭到某大型雲服務商的砍單,據說還是微軟,NVIDIA也不得不下調了2024年下半年在台積電的訂單量。

對於砍單原因,供應鏈的普遍看法是AMD新發布的Instinct MI300系列非常有競爭力,客戶也不希望將雞蛋都放在NVIDIA這一個籃子裡。

包括GPU加速器MI300X、CPU+GPU融合加速器MI300A,後者是獨家技術,性能都非常突出,部分指標已經遠遠超過NVIDIA競品,而且按照慣例價格更低。

AMD的發布會上,除了Google、亞馬遜兩大巨頭之外,微軟、甲骨文、Meta(Facebook)、戴爾、惠普、聯想、超威等都紛紛站台支持,相關產品也第一時間出爐。

AMD MI300X已經出貨,MI300A也投入量產,預計能滿足行業對於AI大模型訓練推理的需求。

NVIDIA目前在AI加速市場上握有90%的份額,但產品價格與成本越來越高,讓很多大企業也吃不消,都在尋求替代解決方案,AMD MI300系列無疑是目前的最佳選擇,除了ROCm開發生態相比CUDA還差太多,遷移是個麻煩。

AMD現在預計,2023年數據中心AI加速器市場規模可達450億美元,年復合增長率超過70%,2027年可超4000億美元,比此前預計的300億美元、50%、1500億美元大大增加。

在這個市場上,AMD即便只拿下10%的份額,也是每年幾百億美元的收入。

不過也有觀點認為,微軟連續砍單是在等待NVIDIA明年將要推出的下一代晶片B100,會升級3nm工藝、Blackwell架構,性能可達目前H200的兩倍以上。

來源:快科技

AMD MI300加速器官方、真機美圖:八路並行 堪稱藝術品

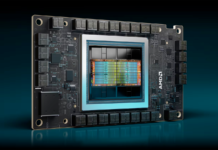

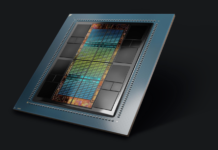

AMD正式發布了,包括純GPU設計的MI300X、CPU+GPU融合設計的MI300A,性能、能效都達到了全新高度,全面對標NVIDIA。

講了半天技術,這里換個角度,欣賞一下MI300系列的官方渲染圖,以及真機實物,包括加速器本身、合作客戶的伺服器系統。

MI300X官方渲染圖:

2.5D矽中介層、3D混合鍵合集一身的3.5D封裝,集成八個5nm工藝的XCD模塊,內置304個CU計算單元,又可分為1216個矩陣核心,同時還有四個6nm工藝的IOD模塊和256MB無限緩存,以及八顆共192GB HBM3高帶寬內存。

電晶體總量,1530億個。

內部結構側視圖:可以看到連通上下的TSV矽穿孔結構。

加速器本體,晶片就占了超過一半的面積。

MI300X平台,八路加速器並行。

來源:快科技

AMD MI300加速器深度揭秘:八路並行破億億次 全面超越NVIDIA

今年6月份,AMD在美國舊金山宣布了,包括全球首款APU加速器MI300A、新一代GPU加速器MI300X。

當時,AMD只公布了一部分技術細節,對於CPU/GPU核心數量、性能/功耗/能效等指標均未提及,也缺乏足夠多的應用案例。

現在,魔術師終於揭曉了他全部的秘密。

快科技現場報導:

12月7日凌晨,美國加州聖何塞,AMD Advancing AI大會上,AMD正式公布了Instinct MI300系列加速器的詳細規格與性能,以及眾多的應用部署案例,將AI人工智慧、HPC高性能計算提升到了新的層次。

AI人工智慧概念的誕生已經有將近70年歷史了,歷經長期演化,已經深入人們工作生活的各個角落,只是很多時候感知性並沒有那麼強,更多時候人們是通過一些節點性時間感受AI的威力。

早期像是IBM深藍超級計算機戰勝西洋棋大師卡斯帕羅夫,近期像是AlphaGo與李世石和柯潔的圍棋大戰,最近最火爆的當然是ChatGPT引發的大語言模型、生成式AI浪潮。

坦白說,大語言模型眼下似乎有些過熱,但從技術和前景的角度而言,AI絕對是未來,不管它以什麼形勢體現,這都是大勢所趨,也是一個龐大的市場,尤其是對算力的需求空前高漲。

一年前,AMD內部估計全球數據中心AI加速器市場在2023年的規模可達約300億美元,今後每年的復合增長率都能超過50%,到2027年將形成超過1500億美元的價值,不可限量。

如今看來,這個數據太保守了,AMD已經將2023年、2027年的數據中心AI加速器市場規模預期分別調高到400億美元、4500億美元,年復合增長率超過70%。

AMD作為擁有最全解決方案的廠商,可以從各個角度滿足AI尤其是生成式AI對於超強算力、廣泛應用的需求:

GPU方面有世界領先的EPYC處理器,GPU方面有不斷壯大的Instinct加速器,網絡方面則有Alveo、Pensando等技術,軟體方面還有ROCm開發平台,從而形成一個有機的、完整的解決方案。

AMD早期的計算加速器底層技術都來自和遊戲顯卡相同的RDNA架構,顯然缺乏針對性,於是誕生了專門針對計算的CDNA架構。

第一代產品Instinct MI100系列是AMD首個可為FP32/FP64 HPC負載提供加速的專用GPU,第二代產品Instinct MI200系列則快速進化,在眾多超算系統中占據了一些之地。

第三代的Instinct MI300系列基於CDNA3架構,分為數據中心APU、專用GPU兩條路線,重點提升了統一內存、AI性能、節點網絡等方面的表現,再加上先進封裝、更高能效,以滿足生成式AI的強勁需求。

來源:快科技

AMD官宣重磅發布會 事關AI的未來

AMD官方宣布,將於2023年12月7日2點,舉辦主題為“Advancing AI”的新品發布會。

AMD表示,屆時將會展示AMD與合作夥伴如何驅動AI的未來。

看起來,這次活動的主角應該是Instinct MI300系列加速器,此前已經多次亮相,並一開始初步部署,但很多規格一直保密未公開,是時候展示完全體了。

其中,MI300X是傳統風格的純GPU加速卡,擁有史無前例的530億個電晶體,配備多達192GB HBM3內存,已於第三季度出樣。

它寄託了AMD極大的期望,將與NVIDIA、Intel正面對抗爭奪AI市場,還有望成為AMD歷史上以最快速度達到1億美元銷售額的產品。

MI300X還有個衍生版本MI300A,同樣屬於重磅級產品,是全球首款面向HPC、AI的APU融合加速卡。

它集成24個Zen4 CPU核心和數量不明的CDNA3 GPU核心,總計1460億個電晶體,還有128GB HBM3,Socket獨立封裝,已經供貨客戶。

有趣的是,AMD遊戲營銷高級總監Sasa Marinhovic也高調預告了此次活動,看起來消費級的銳龍AI引擎也會有新動向,主打端側AI,與雲端的Instinct雙管齊下。

當然,這次活動不會有常規消費級產品的更新,那要等到明年初的CES 2024。

PS:這次大會,文Q會繼續在現場給大家帶來一手報導!

來源:快科技

AMD戰略「放棄」遊戲卡 MI300X AI加速卡最快速度賺到1億美元

如今無論是NVIDIA還是AMD,都不約而同地降低了遊戲顯卡的優先級,將更多精力投入AI加速計算卡。

無它,皆為利往。

AMD在發布第三季度財報後就明確表示,Instinct MI300X加速卡有望成為AMD歷史上以最快速度達到1億美元銷售額的產品。

NVIDIA目前在AI加速卡市場上處於近乎壟斷地位,畢竟硬體強大,軟體生態也好用,但受制於有限的產能、高昂的價格,不少客戶開始尋找替代方案,Intel、AMD都是可選項,尤其是AMD Instinct系列硬體越來越強大,開發平台也逐漸成熟起來。

MI300X是純GPU加速卡,擁有史無前例的額530億個電晶體,配備多達192GB HBM3內存,已於第三季度出樣,寄託了AMD極大的期望。

它還有個衍生版本MI300A,是全球首款面向HPC、AI的APU融合加速卡,集成24個Zen4 CPU核心和數量不明的CDNA3 GPU核心,總計1460億個電晶體,還有128GB HBM3,Socket獨立封裝,已經供貨客戶。

與NVIDIA類似的是,AMD也把GPU產能優先分配給了Instinct系列。

至於遊戲卡,RX 7900 XTX可能會是很長一段時間AMD的卡皇,或許有升級版RX 7950系列,但是下一代RX 8000系列將不會有旗艦卡。

AMD CEO蘇姿豐表示,數據中心GPU將在2023年第四季度給AMD帶來約4億美元的收入,2024年隨著大量產品鋪貨,收入將超過20億美元。

這得賣多少遊戲卡才能賺到啊!

來源:快科技

192GB顯存史無前例 AMD最強顯卡MI300X獲三星強援:HBM3管夠

快科技8月23日消息,NVIDIA不僅在遊戲卡市場占據最大份額,在今年火爆的AI顯卡市場上更是沒對手,H100顯卡利潤率都達到1000%水平,不過下半年AMD最強的AI顯卡MI300X就上市了,可與H100一戰。

MI300X擁有最多8個XCD核心,304組CU單元,8組HBM3核心,顯存容量提升到了192GB,相當於NVIDIA H100 80GB的足足2.4倍,同時HBM內存帶寬高達5.2TB/,Infinity Fabric總線帶寬也有896GB/,同樣遠超NVIDIA H100。

MI300X的192GB顯存不論性能還是容量都是史無前例的,尤其適合AI運算,單卡即可支持400億參數大模型。

MI300X比H100最有優勢的就192GB HBM3顯存了,不過供貨問題也是一大考驗,好在AMD這次准備充分,跟三星深度合作,後者提供了一攬子交鑰匙服務,HBM3顯存已經通過了AMD的認證測試。

三星還計劃將先進封裝的產能提升一倍,以便更好地滿足MI300X等產品對HBM3的需求,AMD理論上是不會出現缺貨了。

來源:快科技

AMD AI收入暴漲7倍 兩大殺器呼嘯而至:750W功耗

快科技8月1日消息,AMD公布了略好於預期的第二季度財報,帶動盤後交易股價上漲4%。

AMD CEO蘇姿豐在解讀財報時特別指出,AI相關的收入在當季暴漲了7倍,主要得益於不斷豐富的Instinct AI加速器產品線,不過未公布具體數值。

其中,MI300X已經出貨並應用,MI300A已經出樣給AI、HPC、雲服務客戶,將在第四季度如期發布。

,集成13個chiplet小晶片、1460億電晶體,5nm/6nm兩種工藝,包括24個Zen4 CPU核心、未公布數量的CDNA3 GPU核心、192GB HBM3高帶寬內存。

美國能源部國家核安全局(NNSA)勞倫斯利弗莫爾國家實驗室(LLNA)的全新超算“El Capitan”(酋長岩),,搭檔Zen4架構的霄龍9004處理器,將在明年滿血上線,預計性能超過200億億次浮點計算每秒。

,就是將MI300A CPU單元也換成CDNA3 GPU單元,HBM3高帶寬內存增加到192GB,電晶體數量達到1530億個,功耗可達750W。

來源:快科技